特征工程大揭秘:时间序列预测中的有效特征选择与构造

发布时间: 2024-11-21 18:41:45 阅读量: 52 订阅数: 38

系统蓝屏大揭秘:诊断与解决之道

# 1. 时间序列预测概述

## 理解时间序列预测

时间序列预测是数据科学中的一个关键领域,它专注于利用历史数据来预测未来的数值。这种方法在金融、气象、销售和需求预测等领域具有广泛的应用。时间序列分析的核心在于识别数据中的模式,并且依赖于这些模式来预测未来趋势。

## 预测模型的重要性

时间序列预测模型能够捕捉时间的依赖性,包括趋势、季节性、周期性和不规则成分。这些模型基于数学或统计方法,能够揭示数据背后复杂的动态过程,并且可以用于各种预测任务,如价格波动、需求量变化、客户行为模式等。

## 预测的复杂性

时间序列预测并非没有挑战。非平稳性、噪声以及异常值的存在都增加了预测的复杂性。此外,数据获取的延迟、数据的维度爆炸性增长以及数据质量问题都是在进行有效预测时必须要考虑的因素。这就突显了特征工程在提高预测准确性方面的关键作用。

```markdown

本文介绍了时间序列预测的基本概念和在实际中的应用。后续章节将深入探讨时间序列特征工程的基础知识,特征选择和构造的策略以及如何将这些策略与不同的预测模型结合起来,从而提升预测精度。

```

在下一章节中,我们将探索时间序列数据类型和特性,为进一步理解特征工程奠定基础。

# 2. 时间序列的特征工程基础

### 2.1 时间序列数据的类型和特性

#### 2.1.1 时间序列数据类型简介

时间序列数据是指按照时间顺序排列的一组数据点,用于分析随时间变化的趋势和模式。在IT和相关领域中,这类数据广泛应用于股票市场分析、网络流量监控、销售预测、设备状态监测等多个场景。时间序列数据可以分为以下几种基本类型:

- **连续时间序列**:这类数据通常是从连续的时间点采样得到,数据点之间没有时间间隔。例如,用传感器每隔一秒记录一次温度,得到的就是连续时间序列。

- **离散时间序列**:与连续时间序列不同,离散时间序列是按照特定时间间隔采样得到的数据序列。大多数金融数据,如日股票价格,就属于离散时间序列。

- **周期性时间序列**:周期性时间序列数据展示出一种规律性的重复模式,例如季节性销售数据,这种数据会在特定时间段内重复出现类似的变化模式。

- **非周期性时间序列**:这类时间序列数据没有明显的重复周期,它们的变化通常受到不规则因素的影响,如股票价格波动。

#### 2.1.2 时间序列数据的基本特性分析

时间序列数据的基本特性对后续的特征工程和模型选择有着重要的指导意义。下面分析几种常见的基本特性:

- **趋势性**:时间序列数据随时间变化呈现的上升或下降趋势。例如,随着公司产品知名度的提升,销售额随时间逐渐上升。

- **季节性**:某些数据在特定时间段内呈现出周期性的波动,这种现象称为季节性。例如,空调销售在夏季会有一个明显的高峰。

- **周期性**:与季节性不同,周期性是指时间序列中出现的不规则的、非固定频率的重复模式。

- **随机性**:数据中不可预测的部分,即噪声。在时间序列分析中,往往需要尽可能地减少随机性的影响,以提高预测准确性。

- **平稳性**:如果时间序列的统计特性(如均值、方差)不随时间变化,则认为该序列是平稳的。非平稳序列往往需要经过差分等转换后才能进行有效的分析。

### 2.2 特征工程在时间序列预测中的作用

#### 2.2.1 特征工程的定义和重要性

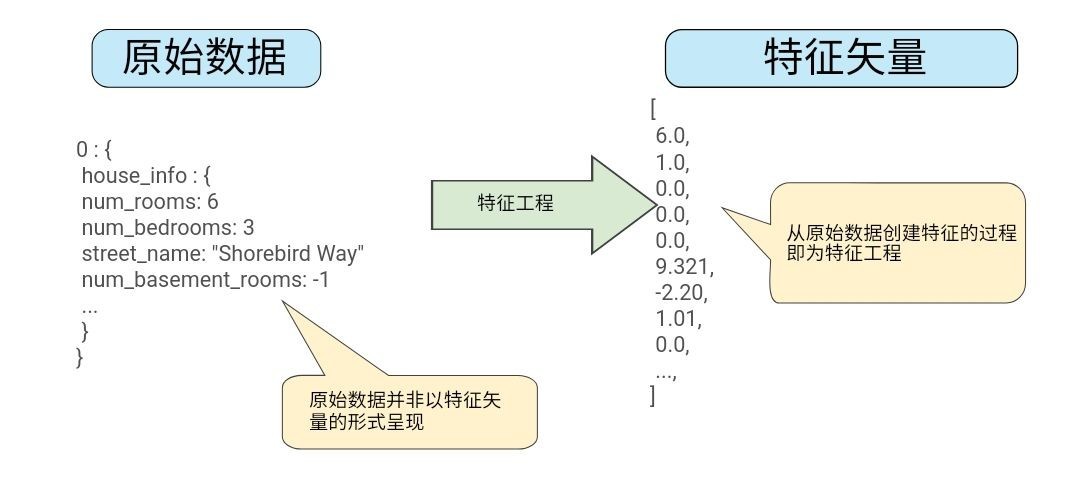

特征工程是数据科学中的一个核心步骤,涉及从原始数据中提取信息并构造出有助于机器学习模型训练的特征。在时间序列预测中,特征工程尤为重要,因为它可以增强模型的表达能力,提高预测性能。有效的特征可以揭示数据中的模式和关联,从而使预测模型能够更好地理解和拟合数据的潜在规律。

#### 2.2.2 特征工程与模型性能的关系

特征工程直接关系到预测模型的性能。高质量的特征可以显著提升模型的准确性,因为它们帮助模型捕捉到数据中的关键信息。此外,正确的特征选择和构造可以减少模型训练的时间和计算资源的消耗。相反,不恰当或冗余的特征可能会导致模型性能下降,甚至产生误导性的结论。

### 2.3 时间序列特征的分类

#### 2.3.1 基于时间的特征

基于时间的特征是直接从时间戳中提取的特征。它们通常包括:

- 时间索引:即时间戳,例如年、月、日、小时等。

- 时间段:将时间划分为不同的时间段,如工作日与周末、白天与夜晚。

- 时间差分:相邻两个数据点之间的时间差异。

#### 2.3.2 基于统计的特征

基于统计的特征是从时间序列数据本身计算得到的,它们描述了数据的统计特性。常见的基于统计的特征包括:

- 均值、中位数、众数:描述时间序列数据集中趋势的统计量。

- 方差、标准差:描述时间序列数据波动大小的统计量。

- 偏度和峰度:描述时间序列数据分布形态的统计量。

#### 2.3.3 基于频率的特征

基于频率的特征描述了数据的周期性和季节性特点,这类特征的提取通常涉及傅里叶变换等技术。它们包括:

- 周期性指标:检测和度量时间序列中周期性波动的指标。

- 季节性指数:量化时间序列数据中季节性变化的指数,例如季节性分解的时间序列方法(STL)。

在构建时间序列特征时,需要根据数据的具体特性和预测任务的具体需求灵活选择和构造特征。下一章节,我们将详细介绍时间序列特征选择的策略与方法,这些策略和方法是实现有效特征工程的关键。

# 3. 时间序列特征选择的策略与方法

时间序列特征选择是优化预测模型性能的关键步骤,其目的在于减少数据集中的特征数量,同时保留有助于模型学习的最重要信息。本章将深入探讨特征选择的策略与方法,并提供实践案例分析。

## 3.1 特征选择的基本流程

### 3.1.1 理解特征选择的目标和挑战

特征选择的目标是从大量特征中筛选出对预测模型最有用的子集。它旨在降低过拟合风险、提高模型泛化能力、减少训练时间,并提供对问题的更深入理解。然而,在时间序列数据中,特征选择面临独特的挑战,如时间依赖性和潜在的非线性关系。

### 3.1.2 特征选择的方法论框架

特征选择的方法可以从统计依赖性、模型表现和搜索策略三个维度来分类。从统计依赖性角度来看,可以分为filter方法、wrapper方法和embedded方法。在搜索策略上,可以采用贪婪算法、启发式算法等方法。最后,模型表现则是评价特征组合是否有效的重要标准。

## 3.2 常用的特征选择技术

### 3.2.1 Filter方法:相关系数和卡方检验

Filter方法通过特征与标签间的统计关系来选择特征,不需要训练模型。例如,皮尔逊相关系数可以衡量连续变量间的线性关系,而卡方检验则适用于分类数据,检验特征与目标之间的独立性。

```python

import pandas as pd

from scipy.stats import pearsonr

# 示例数据集

data = pd.DataFrame({

'Feature1': [1, 2, 3, 4, 5],

'Feature2': [2, 3, 4, 5, 6],

'Target': [10, 20, 30, 40, 50]

})

# 计算相关系数

correlation_matrix = data.corr()

print(correlation_matrix)

# 相关系数示例

feature1_target_corr, _ = pearsonr(data['Feature1'], data['Target'])

print(f"Feature1与Target的相关系数: {feature1_target_corr}")

# 卡方检验示例(适用于分类数据)

```

### 3.2.2 Wrapper方法:递归特征消除(RFE)

递归特征消除(RFE)是一种典型的wrapper方法,它通过递归减少特征集的大小来选择特征。RFE在每次迭代中训练一个模型,并选择具有最高权重或重要性的特征,然后移除最不重要的特征,重复此过程直到剩下所需数量的特征。

```python

from sklearn.feature_selection import RFE

from sklearn.ensemble import RandomForestClassifier

# 假设已经有一个训练好的模型和数据集

model = RandomForestClassifier()

rfe = RFE(estimator=model, n_features_to_select=2)

fit = rfe.fit(data.drop('Target', axis=1), data['Target'])

# 查看哪些特征被选中

selected_features = data.drop('Target', axis=1).co

```

0

0