【数据集划分艺术】:确保图像分类模型泛化的关键步骤

发布时间: 2024-11-21 21:56:01 阅读量: 38 订阅数: 27

猫狗图像分类数据集(1400)

# 1. 数据集划分的基本概念与重要性

在机器学习和数据科学领域中,数据集划分是构建和评估模型的一个重要环节。它涉及将可用数据分割为不同的子集,这些子集用于训练、验证和测试算法。合理的数据集划分不仅有助于模型的准确训练,而且是模型性能评估的关键因素之一。数据集划分能够确保模型不仅在训练数据上表现良好,还能在未见过的数据上做出准确预测,这体现了模型的泛化能力。划分过程看似简单,却是保证模型可信度和有效性的基础。本章将探讨数据集划分的基本概念,以及为何在构建任何机器学习模型时,它都占据着至关重要的位置。

# 2. 理解不同类型的数据集划分方法

数据集的划分是机器学习和深度学习领域中至关重要的步骤。不同的数据集划分方法可以满足不同的需求,并且对模型的训练和评估有着直接的影响。本章将深入探讨训练集、验证集和测试集的区别与作用,比较常见的数据集划分技术,并提供处理不平衡数据集的实践经验。

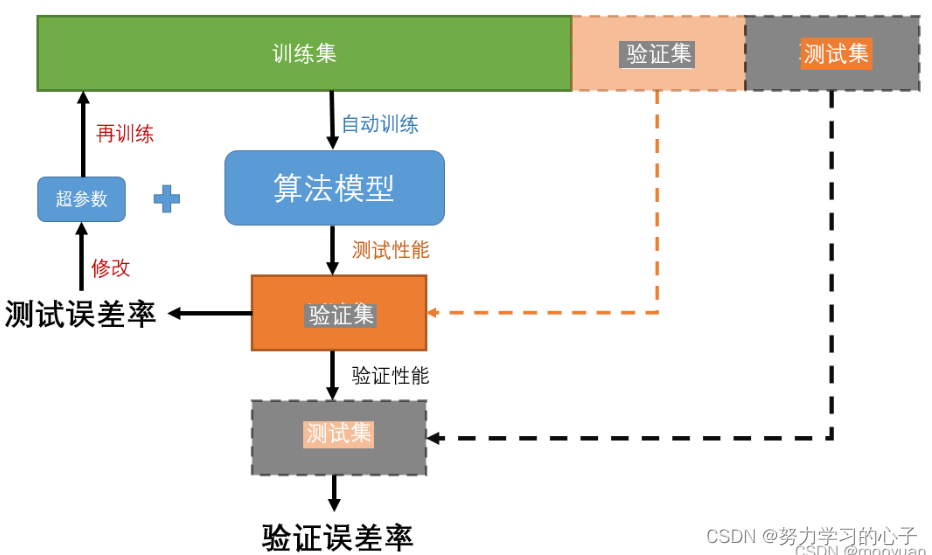

### 2.1 训练集、验证集和测试集的区别与作用

在机器学习项目中,通常会将原始数据集划分为训练集、验证集和测试集。这三者在模型的训练和评估过程中扮演着不同的角色。

#### 2.1.1 训练集的作用与选择策略

训练集是用于训练模型的数据集。模型会根据训练集中的数据学习到输入与输出之间的关系,即学习到一种从输入数据到期望输出的映射关系。选择训练集时通常会采用随机抽样的方法,以确保训练集能够代表整个数据集的分布。

##### 训练集的作用

- **学习关系映射**:训练集的作用是通过输入数据训练模型,使之学会如何根据输入预测输出。

- **过拟合的预防**:训练集可以帮助模型识别并学习数据中的通用规律,从而防止过拟合,即模型对训练数据过度学习而失去泛化能力。

##### 训练集的选择策略

选择训练集通常采用随机划分的方法,可以使用Python中的Scikit-learn库的`train_test_split`函数来划分数据集。

```python

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(

dataset.data, dataset.target, test_size=0.2, random_state=42

)

```

在上述代码中,`test_size=0.2`指定了测试集占原始数据集的20%,`random_state`用于确保每次划分结果的可重复性。

#### 2.1.2 验证集的定位与重要性

验证集主要用于模型的选择和超参数的调优。在模型的训练过程中,可能会对多个不同的模型或同一模型的不同参数配置进行比较。验证集用于评估这些模型或配置在未见过的数据上的表现,帮助选择最佳的模型或参数。

##### 验证集的定位

- **模型选择**:通过验证集评估不同模型的性能,选择最优模型。

- **超参数调优**:使用验证集来调整模型的超参数,获得最佳的模型性能。

##### 验证集的重要性

- **避免过拟合**:验证集可以帮助研究人员避免过拟合问题,确保模型能够泛化到新的数据上。

#### 2.1.3 测试集的独立性和代表性

测试集是模型最终评估的依据,它应该完全独立于训练集和验证集。测试集的存在是为了模拟模型部署后面对真实世界数据的表现。

##### 测试集的作用

- **评估泛化能力**:测试集用于评估模型对未见过的数据的处理能力,即模型的泛化能力。

- **性能报告**:模型的性能报告通常基于测试集的结果得出。

##### 测试集的重要性

- **公正的评估**:保持测试集与训练集和验证集的独立性是至关重要的,以保证评估结果的公正性和准确性。

### 2.2 比较常见的数据集划分技术

数据集划分技术根据数据的特性与需求,可以分为多种方法。本节将探讨随机划分、分层划分以及时间序列划分三种常见技术。

#### 2.2.1 随机划分方法及其优缺点

随机划分是最直接也是最常用的数据集划分方法。它将数据集按照一定的比例随机地分配到训练集、验证集和测试集中。

##### 随机划分的优点

- **简单易行**:随机划分的步骤简单,易于实现。

- **多样性保证**:随机划分通常能够保证训练集、验证集和测试集中数据的多样性。

##### 随机划分的缺点

- **可能不均匀**:在数据量较少的情况下,随机划分可能会导致某个集合中的数据分布与原始数据集存在偏差。

#### 2.2.2 分层划分方法的应用场景与效果

分层划分方法考虑了数据的标签分布,确保训练集、验证集和测试集中各类别的比例与原始数据集保持一致。

##### 分层划分的应用场景

- **类别不平衡的数据**:对于具有类别不平衡问题的数据集,分层划分可以保证每个集合中各类别的比例大致相同,从而获得更加公平的模型评估。

- **分类任务**:在多分类任务中,分层划分可以确保每个类别在各个集合中的比例一致。

##### 分层划分的效果

- **公平的模型评估**:分层划分有助于获得更加准确和可靠的模型性能评估。

#### 2.2.3 时间序列划分的特殊情况分析

对于时间序列数据,数据点之间具有时间上的依赖关系,因此不能使用传统的随机或分层划分方法。

##### 时间序列划分的重要性

- **保持时间顺序**:时间序列划分要保证训练集中的数据点早于验证集和测试集中的数据点,确保评估的真实性和有效性。

### 2.3 数据集划分的实践经验

在处理实际数据集时,经常会遇到不平衡的数据集和需要平衡划分策略对模型泛化影响的情况。本节将介绍如何处理不平衡数据集以及划分策略对模型泛化的影响。

#### 2.3.1 如何处理不平衡数据集

不平衡数据集指的是数据集中各个类别的数据量相差较大。这种情况下,如果简单地随机划分,可能会导致模型无法正确学习到少数类别的特征。

##### 处理不平衡数据集的方法

- **重采样**:可以通过对少数类进行过采样或对多数类进行欠采样来平衡各类别的数据量。

- **合成少数类过采样技术(SMOTE)**:SMOTE是一种生成式过采样方法,它通过合成新的、少数类的数据点来解决数据不平衡问题。

```python

from imblearn.over_sampling import SMOTE

# 假设X和y代表原始特征和标签

sm = SMOTE(random_state=42)

X_train_sm, y_train_sm = sm.fit_resample(X_train, y_train)

```

##### 重采样的参数说明

- `random_state`:用于保证实验的可重复性。

#### 2.3.2 划分策略对模型泛化的影响

划分策略会直接影响模型的泛化能力。选择一个合理的划分策略,可以帮助模型在未知数据上表现得更好。

##### 划分策略对模型泛化的影响

- **避免数据泄露**:确保验证集和测试集的独立性,避免模型在训练过程中接触到这部分数据,从而防止数据泄露的问题。

- **评估准确度**:划分策略要能够准确反映模型在新数据上的性能,以指导后续的模型改进工作。

### 2.3.3 实际案例分析

在实际的项目中,数据集划分需要根据项目的具体情况和需求进行调整。以下是一个图像分类任务的案例分析,以展示如何在实际应用中进行数据集划分。

#### 实际案例:图像数据集的划分步骤

假设有一个包含多种动物类别的图像数据集,我们需要建立一个分类模型来区分这些动物。图像数据集的划分需要考虑以下步骤:

1. **划分比例**:首先确定训练集、验证集和测试集的比例,例如70%、15%和15%。

2. **数据增强**:对训练集进行数据增强,以提高模型的泛化能力。

3. **随机划分**:对图像数据进行随机划分,确保每个集合中的图像类别多样性。

4. **验证和调整**:训练模型并使用验证集调整超参数,直至达到满意的性能。

#### 案例评估:模型泛化能力的分析

在模型训练完成后,需要对模型进行评估。评估模型的泛化能力通常包括以下步骤:

1. **在测试集上评估**:使用测试集来评估模型的最终性能。

2. **误差分析**:分析模型在哪些类别的图像上性能不佳,并进行相应的调整。

3. **交叉验证**:使用K折交叉验证来评估模型在不同划分下的平均性能,以进一步确保模型的稳定性和可靠性。

通过上述步骤,我们可以确保模型在未见过的数据上具有良好的泛化能力。

以上内容是第二章的详尽章节内容,根据给定的大纲要求,我们深入分析了数据集划分的不同方法,并提供了实践经验与案例分析,确保了内容的连贯性和深度。

# 3. 数据集划分的技术实践

在数据分析和机器学习模型训练过程中,数据集的划分是至关重要的一个环节。它不仅影响着模型的性能评估,还与模型的泛化能力密切相关。本章将深入探讨在技术实践中如何高效地进行数据集划分。

## 3.1 数据集划分的工具和库

### 3.1.1 使用Python中的Scikit-learn进行划分

Scikit-learn是Python中一个强大的机器学习库,它提供了多种数据集划分的工具。利用Scikit-learn库,我们可以轻松实现训练集、验证集和测试集的划分。下面是一段使用Scikit-learn进行数据集划分的代码示例:

```python

from sklearn.model_selection import train_test_split

# 假设X是特征数据,y是标签数据

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 进一步将X_train, y_train划分出验证集

X_train, X_val, y_train, y_val = train_test_split(X_train, y_train, test_size=0.2, random_state=42)

```

在这段代码中,`train_test_split`函数被用来将数据集划分为训练集和测试集。参数`test_size`定义了测试集的比例,`random_state`保证了划分的可重复性。我们可以通过两次调用`train_test_split`来进一步划分出验证集。值得注意的是,这种划分方法是随机的,因此每次运行可能会得到不同的结果。

### 3.1.2 分析其他数据处理库的优势

除了Scikit-learn之外,还有其他一些库也提供了数据集划分的功能。例如,Pandas是一个广泛使用的数据处理库,它允许用户根据数据的特性手动划分数据集。Pandas的`sample`函数可以用于随机抽取数据,如下所示:

```python

import pandas as pd

# 假设df是一个Pandas DataFrame,包含了所有数据

train = df.sample(frac=0.6, random_state=42) # 随机抽取60%数据作为训练集

test = df.drop(train.index) # 剩余部分作为测试集

# 如果需要验证集,可以再次使用sample函数

val = train.sample(frac=0.5, random_state=42)

train = train.drop(val.index)

```

Pandas方法的优势在于灵活性

0

0