【图像分类中的损失函数】:选择最适合自己项目的那一个

发布时间: 2024-11-21 21:59:49 阅读量: 25 订阅数: 37

ConvNeXt V2实战:使用ConvNeXt V2实现图像分类任务(一)

# 1. 损失函数在图像分类中的作用

损失函数是机器学习,尤其是深度学习中的核心概念之一,它衡量的是预测结果与真实值之间的差异。在图像分类任务中,损失函数的目标是减少分类错误,提高模型的预测准确率。

## 1.1 损失函数的角色与重要性

在图像分类问题中,损失函数作为评估模型性能的关键指标,直接影响模型训练的方向和效果。它通过提供一个可优化的目标来调整模型参数,以便更好地拟合数据。

## 1.2 损失函数与模型学习过程

模型学习过程就是不断优化损失函数的过程,通过梯度下降等优化算法,逐步调整参数,使得损失函数值最小化。在图像分类任务中,这帮助模型区分不同的图像特征,提高分类的准确性。

## 1.3 损失函数的多样性与适用性

根据不同的任务需求和数据特性,存在多种类型的损失函数。例如,对于概率分布的预测任务,交叉熵损失函数是常用的选择;对于回归任务,均方误差损失函数可能更为合适。了解不同损失函数的适用场景,有助于提高图像分类模型的性能。

# 2. 基础损失函数的理论与实践

## 2.1 交叉熵损失函数

### 2.1.1 交叉熵的基本概念

交叉熵损失函数是一种广泛应用于分类问题中的损失函数,尤其是在处理概率分布时。它可以衡量两个概率分布之间的差异。在机器学习中,交叉熵损失函数通常用来衡量模型预测的概率分布与实际标签的概率分布之间的差异。

数学上,对于两个概率分布P和Q,它们的交叉熵定义为:

\[ H(P, Q) = -\sum_{x} P(x) \log Q(x) \]

在这个公式中,P表示真实的概率分布,Q表示模型的预测概率分布。交叉熵越小,表示两个分布之间的差异越小。

### 2.1.2 交叉熵在图像分类中的应用

在图像分类任务中,交叉熵损失函数经常用于多类分类问题。例如,对于一个具有1000个类别的图像分类问题,模型会输出一个长度为1000的向量,向量中的每一个元素代表了图像属于对应类别的概率。

使用交叉熵损失函数,我们可以计算预测概率分布与实际标签概率分布之间的差距,并使用梯度下降等优化算法来最小化这个损失,从而调整模型参数,提高分类准确性。

在实践中,交叉熵损失函数通常与Softmax函数结合使用。Softmax函数能将模型的原始输出(logits)转化为有效的概率分布,然后使用交叉熵损失函数来衡量预测分布与真实分布之间的差异。

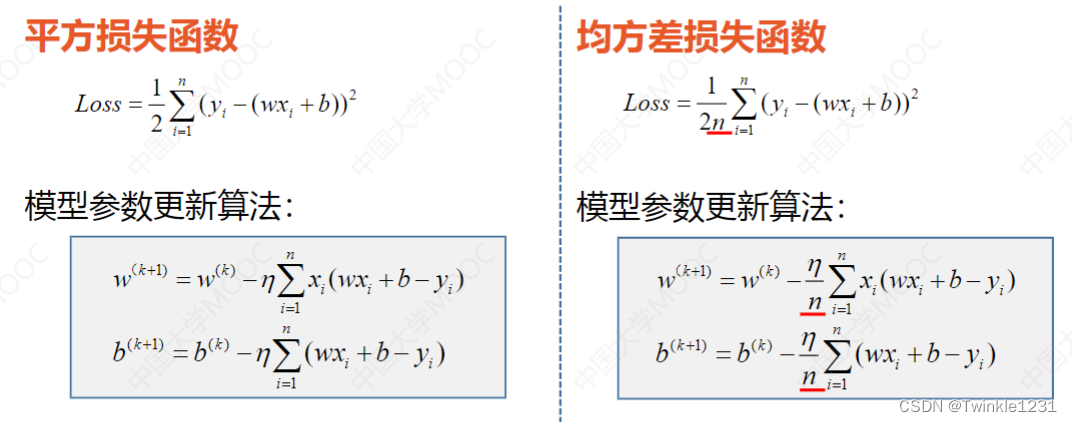

## 2.2 均方误差损失函数

### 2.2.1 均方误差的定义和数学原理

均方误差(MSE)损失函数是衡量预测值和真实值之间差异的一种方式,特别是在回归任务中广泛应用。均方误差损失函数的数学定义为:

\[ MSE = \frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2 \]

这里,\(y_i\) 表示真实值,\(\hat{y}_i\) 表示预测值,n是数据点的总数。均方误差损失函数简单直观,通过计算预测值和真实值差的平方和的平均值,来评估模型的性能。

### 2.2.2 均方误差在图像分类中的应用案例

尽管均方误差通常用于回归任务,但在图像分类问题中,我们可以使用均方误差作为损失函数的一个辅助指标。例如,在半监督学习场景中,可以将已标记的样本的分类损失和未标记样本的预测输出与真实值之间的均方误差结合起来,形成一个综合损失函数。

此外,均方误差也被用于衡量图像生成模型的生成图像与真实图像之间的差异。比如在生成对抗网络(GAN)中,生成器生成的图像质量可以通过与真实图像之间的均方误差来评价。

## 2.3 指数损失函数

### 2.3.1 指数损失的理论基础

指数损失函数通常用于支持向量机(SVM)等二分类问题。它的数学公式如下:

\[ L(y, f(x)) = \exp(-y f(x)) \]

这里,\(y\) 是真实的标签(+1 或 -1),\(f(x)\) 是模型对输入数据 \(x\) 的预测输出。指数损失函数的特点是对错误分类的惩罚非常严厉,随着 \(y f(x)\) 的值偏离0,损失会迅速增大。

### 2.3.2 指数损失函数的图像分类实例

在图像分类任务中,指数损失函数可以用于训练一个二分类SVM模型。对于多类分类问题,通过一对多(One-vs-All)或一对一(One-vs-One)策略将多分类问题转化为多个二分类问题,然后在每一个二分类子问题中应用指数损失函数。

指数损失函数的一个优势是它对异常值非常鲁棒,但它也存在一些缺点,比如在某些情况下可能会导致过度拟合。为了缓解这个问题,实际应用中可能会结合正则化项来提高模型的泛化能力。

以上内容对基础损失函数在图像分类任务中的应用进行了详细讨论。在下一章节,我们将探讨一些更高级的损失函数,并分析它们在图像分类任务中的使用情况。

# 3. 高级损失函数的探索与应用

随着深度学习在图像分类任务中的日益精进,高级损失函数的探索与应用成为了提升模型性能的关键环节。高级损失函数通常包含更复杂的数学结构,用于解决基础损失函数难以处理的特定问题,如类别不平衡、样本间关系的复杂表达以及高维空间的结构保持等。

## 3.1 对比损失和三元组损失

### 3.1.1 对比损失的原理与实现

对比损失(Contrastive Loss)主要用于度量样本间的相似性,常用于学习样本表示,如在Siamese网络中进行特征学习。对比损失函数的目标是使得相同类别的样本对距离尽可能小,而不同类别的样本对距离尽可能大。

其公式可以表示为:

\[ L = \frac{1}{2N} \sum_{i=1}^{N} (1 - y_i) \cdot D^2(x_i^+, x_i^-) + y_i \cdot \max(0, m - D(x_i^+, x_i^-))^2 \]

其中,\( x_i^+ \) 和 \( x_i^- \) 分别表示属于同一类和不同类的样本对,\( y_i \) 是指示样本对是否属于同一类的二元变量,\( D \) 表示样本对之间的距离度量(如欧氏距离),\( m \) 是一个边界值。

实现对比损失的关键在于选择合适的距离度量函数 \( D \),以及确定边界值 \( m \)。通常,\( D \) 可以是欧氏距离或余弦相似度等。

下面是一个使用PyTorch实现的对比损失函数示例代码:

```python

import torch

import torch.nn.functional as F

def contrastive_loss(output1, output2, label, margin=1.0):

euclidean_distance = F.pairwise_distance(output1, output2)

loss_contrastive = torch.mean((1-label) * torch.pow(euclidean_distance, 2) +

(label) * torch.pow(torch.clamp(margin - euclidean_distance, min=0.0), 2))

return loss_contrastive

```

### 3.1.2 三元组损失的应用场景和优势

三元组损失(Triplet Loss)与对比损失类似,但它同时考虑三个样本:一个锚点样本、一个正样本和一个负样本。三元组损失的目标是使锚点样本与正样本的距离小于锚点样本与负样本的距离加上一个边界值。

其公式可以表示为:

\[ L = \sum_{i=1}^{N} \left[ \left\| f(a_i) - f(p_i) \right\|^2_2 - \left\| f(a_i) - f(n_i) \right\|^2_2 + \alpha \right]_+ \]

其中,\( f \) 表示网络的特征提取函数,\( a_i \) 是锚点样本,\( p_i \) 是与 \( a_i \) 同类的正样本,\( n_i \) 是与 \( a_i \) 不同类的负样本,\( \alpha \) 是一个边界值。

三元组损失在学习判别性特征表示方面非常有效,广泛应用于人脸识别和图像检索等领域。下面是一个使用PyTorch实现的三元组损失函数示例代码:

```python

def triplet_loss(anchor, positive, negative, alpha):

# 计算各样本的特征表示

pos_dist = torch.norm(anchor - positive, 2, 1)

neg_dist = torch.norm(anchor - negative, 2, 1)

# 计算损失函数

basic_loss = pos_dist - neg_dist + alpha

loss =

```

0

0