聚类算法揭秘:k-means与其它算法的比较分析

发布时间: 2025-01-04 20:58:20 阅读量: 11 订阅数: 15

# 摘要

聚类算法是数据分析和机器学习中的一种重要技术,用于将相似的数据点分组。本文首先介绍了聚类算法的基本概念和分类,并深入探讨了k-means算法的理论基础与实践应用。通过分析k-means算法的实现步骤、优化策略及高级实践中的参数调优和应用实例,本文进一步对比分析了k-means与其他聚类算法如层次聚类、密度聚类和高斯混合模型聚类的差异。最后,文章评估了聚类算法的性能,并探讨了聚类算法的选择策略及未来发展趋势,特别是在大数据和人工智能领域的应用潜力。

# 关键字

聚类算法;k-means;参数调优;性能评估;人工智能;大数据

参考资源链接:[ARM处理器的LDMIA指令详解与应用](https://wenku.csdn.net/doc/4ycobhtu82?spm=1055.2635.3001.10343)

# 1. 聚类算法的基本概念和分类

聚类算法是数据挖掘和机器学习中的一个重要分支,它能够使我们无需依赖于数据的预标签,自动将数据划分为多个类别或簇。聚类的目标是使得簇内的样本尽可能相似,而簇间的样本则尽可能不同。聚类算法的分类多样,常见的是划分方法、层次方法、密度方法和基于模型的方法。

在划分方法中,算法尝试将数据集分成预定数量的k个簇,使得每个数据点属于其中一个簇,并且簇内的点与簇内的其他点相比更相似。层次方法通过构建一个层次的嵌套簇树来对数据进行聚类。密度方法则基于密度的概念来发现任意形状的簇,将高密度区域划分为簇,将低密度区域作为簇之间的边界。

了解这些基本概念和分类是进一步深入研究和应用聚类算法的基础。在后续章节中,我们将深入探讨k-means算法,这是一种广泛使用的划分方法聚类算法,它不仅具有易于理解和实现的优点,而且在很多应用场景中都能高效地工作。我们将通过理论和实践相结合的方式,探讨其原理、实现步骤以及优化和问题处理方法。

# 2. k-means算法的理论基础与实践

## 2.1 k-means算法的理论原理

### 2.1.1 聚类问题的数学描述

聚类算法旨在将数据集中的样本划分为若干个互不相交的子集,即簇(Cluster)。每个簇内部的样本相似度较高,而不同簇的样本相似度较低。数学上,聚类问题可以通过优化目标函数来实现。

假设我们有一个数据集 \(D = \{x_1, x_2, ..., x_n\}\),其中 \(x_i\) 代表一个 \(d\) 维的样本点。目标函数通常定义为簇内误差平方和(Within-cluster Sum of Square, WSS):

\[ WSS = \sum_{j=1}^{k}\sum_{x_i \in C_j} ||x_i - \mu_j||^2 \]

这里的 \(k\) 表示簇的数量,\(C_j\) 是第 \(j\) 个簇,而 \(\mu_j\) 是第 \(j\) 个簇的中心(即簇内所有点的均值)。我们的目标是寻找一个划分,使得 \(WSS\) 达到最小化。

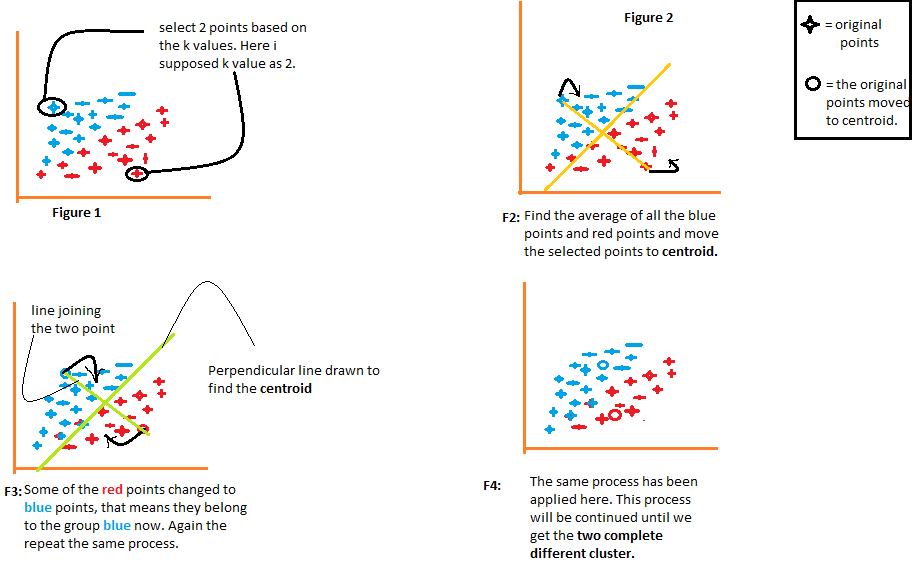

### 2.1.2 k-means算法的初始化与迭代

k-means算法的核心思想是迭代地优化上述目标函数。它从一个初始划分开始,然后不断迭代,直到满足某个终止条件。算法的每一步涉及两个主要操作:

1. **分配步骤**(Assignment Step):每个样本被分配给最近的簇中心。

2. **更新步骤**(Update Step):计算每个簇的新中心。

迭代过程中,算法不断更新簇中心的位置,直至达到收敛。

## 2.2 k-means算法的实现步骤

### 2.2.1 算法的输入输出定义

**输入**:包含 \(n\) 个样本的数据集 \(D\),以及希望的簇数 \(k\)。

**输出**:一个划分,将数据集 \(D\) 中的样本分配到 \(k\) 个簇中。

### 2.2.2 算法流程的伪代码解析

下面是一个简化的 k-means 算法的伪代码描述:

```

输入: 数据集 D, 簇数 k

输出: 簇划分结果

1. 随机初始化 k 个簇中心 μ1, μ2, ..., μk

2. do

3. for 每个数据点 xi in 数据集 D do

4. 将 xi 分配给最近的簇中心

5. end for

6. for 每个簇中心 μj do

7. 更新簇中心 μj 为簇内所有点的均值

8. end for

9. until 簇中心不再变化

10. 返回最终的簇划分结果

```

## 2.3 k-means算法的优化和问题处理

### 2.3.1 初始化方法的改进

初始化簇中心是 k-means 算法的关键步骤之一,传统的随机初始化方法可能容易陷入局部最优解。为了解决这个问题,可以采用如下改进方法:

- **k-means++**:选择第一个簇中心后,后续的簇中心选择概率与样本点到最近簇中心的距离成正比,以此保证初始化的多样性。

- **主成分分析(PCA)降维**:在高维数据上,先通过PCA提取主要成分,然后在降维后的数据上进行k-means初始化,可以有效提高收敛速度和质量。

### 2.3.2 算法的加速和收敛性提升

k-means 算法的加速和收敛性提升可以通过多种技术实现:

- **空簇的处理**:如果一个簇在迭代过程中没有样本点,则可以选择最近的簇进行合并,并重新初始化空簇中心。

- **收敛条件的调整**:通常,算法会在簇中心的变化量小于某个阈值或者迭代次数达到预设的最大值时停止。调整这些条件可以影响算法的运行时间和结果。

下面是一个基于Python的k-means算法的简单实现代码块:

```python

from sklearn.cluster import KMeans

import numpy as np

# 假设有一个数据集X

X = np.array([[1, 2], [1, 4], [1, 0],

[10, 2], [10, 4], [10, 0]])

# 设置簇数为3

kmeans = KMeans(n_clusters=3, random_state=0).fit(X)

print(kmeans.labels_) # 输出每个样本所属簇的标签

print(kmeans.cluster_centers_) # 输出每个簇的中心点坐标

```

在上述代码中,我们使用了scikit-learn库来简化算法实现。`KMeans`类是k-means算法的实现,我们设置了簇数为3,并初始化随机种子为0以保证结果的可复现性。`fit`方法用于计算并应用模型进行聚类,最终输出每个样本所属的簇标签和簇中心位置。

# 3. k-means算法的高级实践

## 3.1 k-means算法的参数调优

### 3.1.1 簇数k的选择策略

确定簇数k是k-means算法中一个关键的挑战。选择一个合适的k值对于算法的性能至关重要。不正确的k值可能导致过拟合或欠拟合。常用的簇数选择方法有以下几种:

- **肘部法则(Elbow Method)**:通过计算每个k值的SSE(误差平方和),然后画出SSE随着k值变化的曲线图。理想的k值是在曲线开始变平的“肘部”点。以下是一个使用Python的SSE计算示例:

```python

from sklearn.cluster import KMeans

import numpy as np

import matplotlib.pyplot as plt

# 假设data是一个已经标准化的二维数组

sse = []

K = range(1, 10)

for k in K:

km = KMeans(n_clusters=k)

km.fit(data)

sse.append(km.inertia_)

# 绘制SSE曲线图

plt.plot(K, sse)

plt.xlabel('Number of cluster')

plt.ylabel('SSE')

plt.show()

```

- **轮廓系数法(Silhouette Coefficient)**:轮廓系数结合了聚类的凝聚度和分离度。轮廓系数的取值范围是[-1,1],接近1表示样本离它自己的簇比离其他簇更近。计算轮廓系数的示例代码如下:

```python

from sklearn.metrics import silhouette_score

silhouette_coefficients = []

for k in K:

km = KMeans(n_clusters=k)

km.fit(data)

score = silhouette_score(data, km.labels_)

silhouette_coefficients.append(score)

plt.plot(K, silhouette_coefficients)

plt.xlabel('Number of cluster')

plt.y

```

0

0