随机梯度下降法在凸优化中的应用:斯坦福教材技巧解读

发布时间: 2024-12-27 13:03:45 阅读量: 11 订阅数: 13

examples_ABC_gradientdescent_梯度下降法_凸优化_

# 摘要

随机梯度下降法(SGD)是一种广泛应用于机器学习和深度学习领域的优化算法,尤其适合大规模凸优化问题。本文首先介绍了凸优化的基本概念和随机梯度下降法的理论基础,深入探讨了其收敛性以及参数选择对优化性能的影响。接着,文章讨论了在实际应用中实现SGD的有效技巧,包括参数初始化、学习率调整、正则化方法及防止过拟合的策略。随后,通过多个凸优化问题实例,本文展示了SGD在不同应用场景中的应用,例如线性回归、逻辑回归、支持向量机和深度学习。最后,本文比较了批量梯度下降与SGD,并探讨了SGD在神经网络优化中的角色,同时分析了其局限性,并对凸优化与SGD的未来发展方向进行了展望。

# 关键字

凸优化;随机梯度下降法;参数初始化;正则化;过拟合;神经网络优化

参考资源链接:[斯坦福大学经典教材:凸优化Convex Optimization](https://wenku.csdn.net/doc/52yvtdmayv?spm=1055.2635.3001.10343)

# 1. 凸优化基础与随机梯度下降法简介

## 1.1 凸优化的基本概念

凸优化是研究如何最小化凸函数的数学领域,它在优化理论与应用中扮演着核心角色。在机器学习、信号处理、统计学等领域中,凸优化问题因其独特性质(如全局最优解的唯一性)而被广泛使用。

## 1.2 随机梯度下降法(SGD)简述

随机梯度下降法是一种迭代优化算法,它被广泛用于求解包括机器学习在内的凸优化问题。与其他优化方法相比,SGD最大的优势在于其计算效率与可扩展性,尤其是在处理大规模数据集时。SGD通过在每次迭代中仅使用一个样本来近似梯度,极大地提高了算法的运行速度。

## 1.3 随机梯度下降法的应用

SGD被应用于各种机器学习和深度学习模型中,如线性回归、神经网络训练等,它不仅减少了计算量,还帮助模型在实际数据中实现了更好的泛化能力。正确理解和应用SGD对于实现高效且有效的模型训练至关重要。

在后续章节中,我们将深入探讨随机梯度下降法的理论基础、实现技巧,以及凸优化问题在实际中的应用场景。

# 2. ```

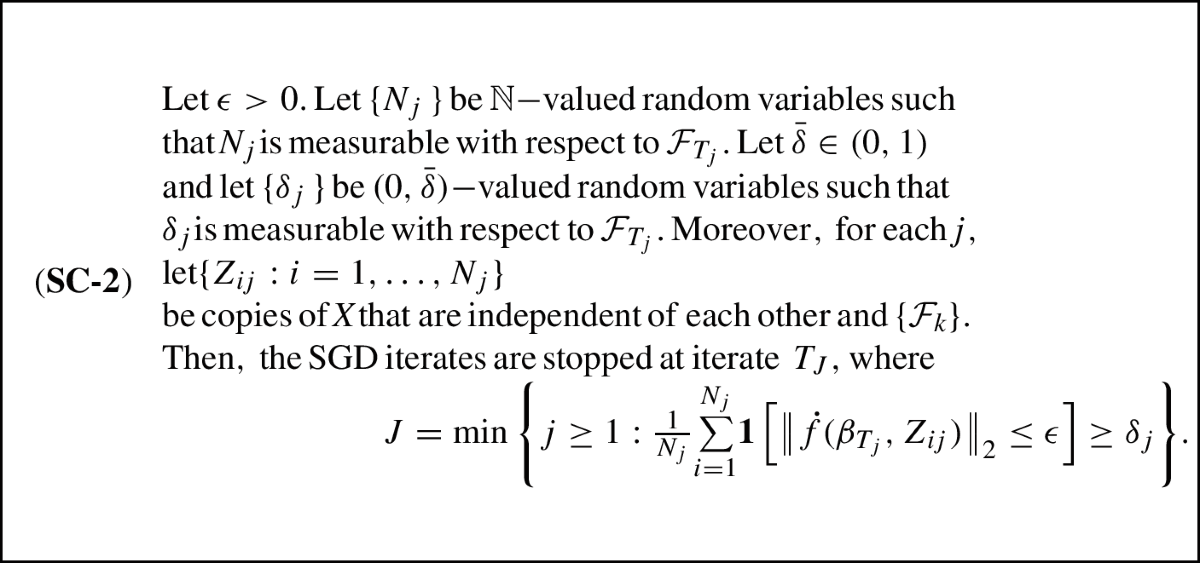

# 第二章:随机梯度下降法的理论基础

随机梯度下降法(Stochastic Gradient Descent, SGD)是一种广泛应用于机器学习中优化问题的算法,尤其在大规模数据集上表现卓越。理解其理论基础对于深入掌握和应用这一技术至关重要。本章首先介绍凸优化问题的定义和性质,然后深入探讨随机梯度下降法的原理,并对收敛性进行分析。

## 2.1 凸优化问题的定义和性质

在凸优化问题中,目标函数和约束(如果有的话)均为凸函数,这样就形成了一个凸集。一个凸集中的任意两点间的线段,其上的所有点同样属于这个集合。这一属性是凸优化强大的理论支撑之一。

### 2.1.1 凸函数与凸集的概念

凸函数是一个定义在凸集上的实值函数,其任意两点间的连线上的点的函数值都不超过这两点函数值连线。数学上,对于函数f: R^n -> R,若对于所有的x, y属于其定义域,以及所有的θ属于[0,1],都有:

f(θx + (1-θ)y) ≤ θf(x) + (1-θ)f(y)

那么f是凸函数。如果等号仅在x=y时成立,则称为严格凸函数。

### 2.1.2 凸优化问题的标准形式

一个标准的凸优化问题可以表达为:

minimize f(x)

subject to g_i(x) ≤ 0, i = 1, ..., m

h_j(x) = 0, j = 1, ..., p

这里x是问题的变量,f是目标函数(必须是凸函数),g_i是不等式约束,h_j是等式约束。所有这些函数都必须在它们的定义域内是凸的。

## 2.2 随机梯度下降法的原理

### 2.2.1 梯度下降法的基本原理

梯度下降法是一种求解无约束优化问题的迭代方法,它通过在负梯度方向上逐步更新解来逼近问题的最小值。给定一个可微的函数f(x),其梯度是f在x点的最快上升方向,因此在负梯度方向上进行搜索可以找到函数下降最快的方向。迭代公式可以写为:

x_{k+1} = x_k - α_k * ∇f(x_k)

其中,x_k是第k次迭代后的解,α_k是第k次迭代的学习率,∇f(x_k)是目标函数在x_k处的梯度。

### 2.2.2 随机梯度下降法的特点和优势

随机梯度下降法是梯度下降法的一种变体,与传统的梯度下降法相比,其在每次迭代中使用一个样本或一个小批量的样本的梯度来更新参数,而不是计算整个数据集上的平均梯度。这种方法在处理大规模数据时具有极大的优势,因为每次迭代只涉及到一个或一小部分样本,从而减少了计算量,加快了算法的迭代速度。

## 2.3 随机梯度下降法的收敛性分析

### 2.3.1 收敛性定理的理解

随机梯度下降法的收敛性分析是理解其性能的关键。一个重要的定理是SGD的收敛性定理,它指出了在一定条件下,SGD能够以概率1收敛到函数的最小值。如果目标函数具有Lipschitz连续的梯度,那么SGD的收敛速度可以通过步长序列来控制。

### 2.3.2 收敛速度与参数选择的关系

SGD的收敛速度很大程度上取决于学习率的选择。通常情况下,学习率应该随着迭代次数的增加而递减。一个常用的学习率衰减策略是:α_k = α_0 / (1 + k)^\gamma,其中α_0是初始学习率,γ是衰减指数(通常取值在[0.5, 1]之间)。另一个关键因素是选择合适的小批量样本大小(batch size),它直接影响着SGD的稳定性和收敛速度。

```

# 3. 随机梯度下降法的实现技巧

随机梯度下降法(Stochastic Gradient Descent, SGD)是优化问题中一种重要的迭代算法,尤其在处理大规模数据集时表现出色。为了更有效地应用SGD并获得更优的性能,实现技巧至关重要。本章节将深入探讨几个关键的实现技巧,包括参数初始化和学习率选择,正则化与优化算法改进,以及避免局部最小值和过拟合的策略。

## 3.1 参数初始化和学习率选择

### 3.1.1 参数初始化方法

初始化参数是神经网络训练过程中的第一步,合适的初始化策略能够加速模型的收敛。初始化方法主要分为以下几类:

- **零初始化**:将所有权重初始化为零。这种方式简单易行,但在实际操作中会导致梯度消失的问题,因为同一层的所有神经元将计算出相同的梯度。

- **随机初始化**:如Xavier初始化和He初始化,通过从特定分布(如均匀分布或高斯分布)中随机取值来设置权重。它们考虑到了输入和输出的维度,以保持信号在前向传播时的方差不变。

- **基于数据的初始化**:如PCA初始化,利用数据的统计特性来进行初始化,有助于捕捉数据的本质结构。

选择合适的初始化策略对模型训练的性能有显著的影响。例如,对于深度神经网络,Xavier和He初始化能显著提升模型的训练效率。

### 3.1.2 学习率衰减策略

学习率是SGD中最关键的超参数之一,它决定了在参数空间中每次迭代步长的大小。学习率过大可能会导致模型在最优点附近震荡不收敛,而过小则会导致训练过程极其缓慢。因此,选择合适的学习率及其调整策略至关重要。常用的学习率衰减策略有:

- **固定衰减策略**:如`0.96^epoch`,学习率按固定比例在每个epoch后衰减。

- **步长衰减策略**:在达到特定迭代次数后,学习率按一定步长减小。

- **性能调度策略**:当验证集上的

0

0