【Python文件读取实战指南】:深入剖析Python文件读取的奥秘,提升开发效率

发布时间: 2024-06-22 07:36:32 阅读量: 76 订阅数: 43

# 1. Python文件读取的基础**

**1.1 文件操作的基本概念**

文件操作是计算机科学中一项基本任务,涉及对计算机文件系统的读取、写入和修改。在Python中,文件操作通过内置的`open()`函数进行,它返回一个文件对象,用于对文件进行各种操作。文件对象具有多种属性和方法,允许开发者读取、写入、定位和关闭文件。

**1.2 文件读取的常用方法**

Python提供了多种方法来读取文件内容。最基本的方法是使用`read()`方法,它返回整个文件内容作为字符串。对于较大的文件,可以使用`readline()`方法逐行读取文件,或者使用`readlines()`方法将文件内容读入列表中。这些方法都接受可选参数,允许开发者指定读取的字节数或行数,从而实现更精细的控制。

# 2. Python文件读取的进阶技巧

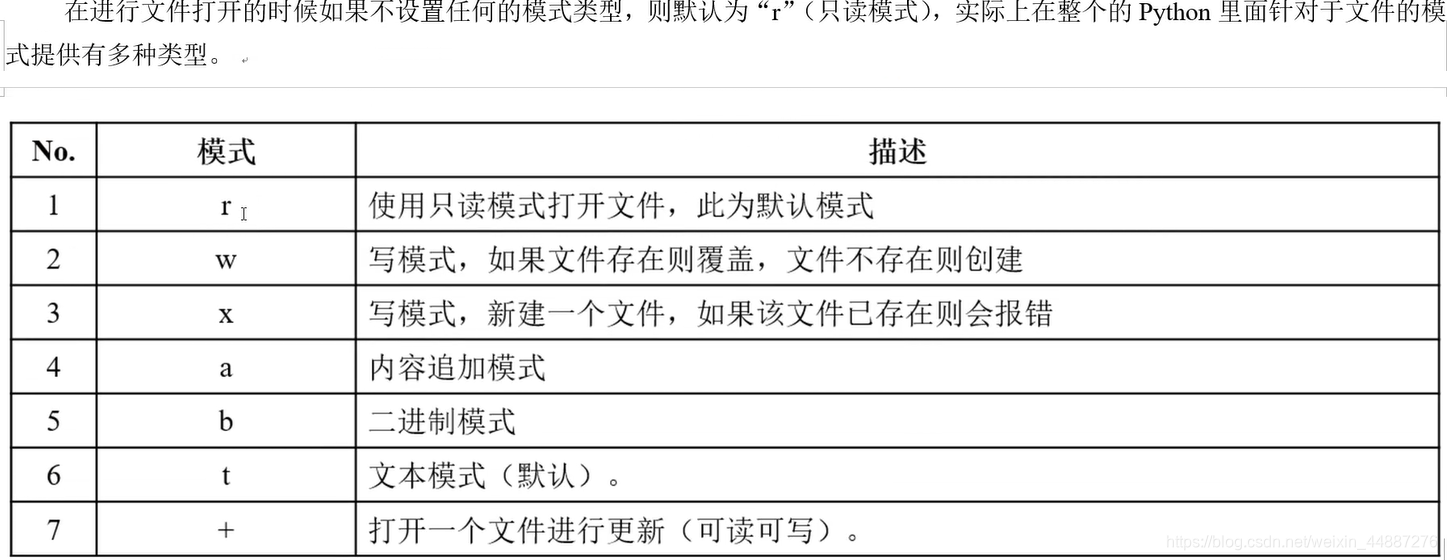

### 2.1 文件读取模式详解

文件读取模式决定了文件打开时的行为,影响着读取操作的效率和安全性。Python提供了多种文件读取模式,满足不同的需求。

#### 2.1.1 读写模式

`'r'`:只读模式,打开一个已存在的文件进行读取。如果文件不存在,会抛出`FileNotFoundError`异常。

#### 2.1.2 追加模式

`'a'`:追加模式,打开一个已存在的文件进行追加写入。如果文件不存在,会创建一个新文件。

#### 2.1.3 二进制模式

`'b'`:二进制模式,以二进制格式打开文件。适用于处理二进制数据,如图像、视频等。

### 2.2 文件读取优化策略

为了提升文件读取效率,可以采用以下优化策略:

#### 2.2.1 使用缓冲区优化读取速度

缓冲区是内存中的一块区域,用于临时存储数据。在读取文件时,可以将数据先读入缓冲区,再从缓冲区中逐行读取。这种方式可以减少对磁盘的访问次数,从而提高读取速度。

```python

with open('file.txt', 'r') as f:

buffer = f.read()

for line in buffer.splitlines():

# 处理每一行

```

#### 2.2.2 利用迭代器实现逐行读取

Python文件对象提供了`__iter__`方法,可以将其转换为一个迭代器。通过迭代器逐行读取文件,可以避免一次性加载整个文件到内存中,节约内存空间。

```python

with open('file.txt', 'r') as f:

for line in f:

# 处理每一行

```

#### 2.2.3 异常处理与错误恢复

在文件读取过程中,可能会遇到各种异常情况,如文件不存在、文件损坏等。为了保证程序的健壮性,需要进行异常处理和错误恢复。

```python

try:

with open('file.txt', 'r') as f:

# 读取文件

except FileNotFoundError:

print('文件不存在')

except Exception as e:

print('其他错误:', e)

```

# 3. Python文件读取的实践应用

### 3.1 日志文件的读取与分析

#### 3.1.1 日志文件格式简介

日志文件是记录系统运行信息的重要文件,通常包含时间戳、日志级别、日志消息等信息。常见的日志文件格式有:

- **文本格式:**以纯文本形式存储日志信息,易于读取和分析。

- **JSON格式:**以JSON格式存储日志信息,结构化程度高,便于机器解析。

- **XML格式:**以XML格式存储日志信息,结构化程度高,但解析难度较大。

#### 3.1.2 使用正则表达式解析日志文件

正则表达式是一种强大的文本处理工具,可以用来匹配和提取日志文件中的特定信息。以下是一个使用正则表达式解析日志文件的示例:

```python

import re

# 匹配日志文件中的时间戳、日志级别和日志消息

pattern = r"^(?P<timestamp>[\d\-\:\s]+) (?P<level>[A-Z]+) (?P<message>.+)$"

with open("logfile.txt", "r") as f:

for line in f:

match = re.match(pattern, line)

if match:

timestamp = match.group("timestamp")

level = match.group("level")

message = match.group("message")

# 对日志信息进行分析和处理

```

### 3.2 数据文件的读取与处理

#### 3.2.1 数据文件格式选择

数据文件格式的选择取决于数据的类型和处理需求。常见的数据文件格式有:

- **CSV格式:**以逗号分隔值存储数据,易于读取和处理。

- **JSON格式:**以JSON格式存储数据,结构化程度高,便于机器解析。

- **XML格式:**以XML格式存储数据,结构化程度高,但解析难度较大。

- **Parquet格式:**一种列式存储格式,压缩率高,查询速度快。

#### 3.2.2 使用Pandas库读取和处理数据文件

Pandas是一个强大的数据分析库,可以方便地读取和处理各种格式的数据文件。以下是一个使用Pandas读取CSV文件并进行数据处理的示例:

```python

import pandas as pd

# 读取CSV文件

df = pd.read_csv("data.csv")

# 对数据进行清洗和处理

df.dropna(inplace=True) # 删除缺失值

df["column_name"] = df["column_name"].astype(int) # 将特定列转换为整数类型

# 对数据进行分析和可视化

print(df.describe()) # 显示数据统计信息

df.plot(x="column_name", y="column_name") # 绘制散点图

```

### 3.3 配置文件的读取与修改

#### 3.3.1 配置文件格式详解

配置文件是存储应用程序配置信息的文本文件。常见的配置文件格式有:

- **INI格式:**以键值对的形式存储配置信息,易于读取和修改。

- **JSON格式:**以JSON格式存储配置信息,结构化程度高,便于机器解析。

- **XML格式:**以XML格式存储配置信息,结构化程度高,但解析难度较大。

#### 3.3.2 使用ConfigParser库操作配置文件

ConfigParser是一个标准库,可以方便地读取和修改INI格式的配置文件。以下是一个使用ConfigParser操作配置文件的示例:

```python

import configparser

# 读取配置文件

config = configparser.ConfigParser()

config.read("config.ini")

# 获取配置信息

value = config.get("section_name", "option_name")

# 修改配置信息

config.set("section_name", "option_name", "new_value")

# 保存修改

with open("config.ini", "w") as f:

config.write(f)

```

# 4. Python文件读取的拓展应用

### 4.1 文件读取与网络编程

#### 4.1.1 从远程服务器读取文件

**代码块:**

```python

import urllib.request

# 从远程服务器下载文件

url = 'https://www.example.com/file.txt'

with urllib.request.urlopen(url) as response:

data = response.read()

print(data.decode('utf-8'))

```

**逻辑分析:**

* `urllib.request.urlopen()` 函数用于打开远程服务器上的文件。

* `response` 对象表示服务器的响应,其中包含文件内容。

* `read()` 方法读取文件内容并返回字节数据。

* `decode()` 方法将字节数据解码为文本。

**参数说明:**

* `url`:远程服务器上的文件 URL。

#### 4.1.2 使用文件传输协议(FTP)下载文件

**代码块:**

```python

import ftplib

# 使用 FTP 下载文件

ftp = ftplib.FTP('ftp.example.com')

ftp.login('username', 'password')

ftp.cwd('/public/files')

with open('local_file.txt', 'wb') as f:

ftp.retrbinary('remote_file.txt', f.write)

ftp.quit()

```

**逻辑分析:**

* `ftplib.FTP()` 函数用于连接到 FTP 服务器。

* `login()` 方法用于登录到服务器。

* `cwd()` 方法用于切换到服务器上的指定目录。

* `open()` 函数用于打开本地文件用于写入。

* `retrbinary()` 方法用于从服务器下载文件并写入到本地文件。

* `quit()` 方法用于退出 FTP 连接。

**参数说明:**

* `ftp`:FTP 服务器连接对象。

* `username`:FTP 服务器用户名。

* `password`:FTP 服务器密码。

* `remote_file`:服务器上的文件路径。

* `local_file`:本地文件路径。

### 4.2 文件读取与数据库交互

#### 4.2.1 使用SQLAlchemy读取数据库文件

**代码块:**

```python

from sqlalchemy import create_engine

# 使用 SQLAlchemy 读取数据库文件

engine = create_engine('sqlite:///database.db')

connection = engine.connect()

result = connection.execute('SELECT * FROM table_name')

for row in result:

print(row)

```

**逻辑分析:**

* `create_engine()` 函数用于创建数据库引擎对象。

* `connect()` 方法用于连接到数据库。

* `execute()` 方法用于执行 SQL 查询。

* `fetchall()` 方法用于获取查询结果。

**参数说明:**

* `engine`:数据库引擎对象。

* `connection`:数据库连接对象。

* `query`:要执行的 SQL 查询。

#### 4.2.2 将文件数据导入数据库

**代码块:**

```python

import pandas as pd

# 将文件数据导入数据库

data = pd.read_csv('data.csv')

data.to_sql('table_name', engine, if_exists='append')

```

**逻辑分析:**

* `pd.read_csv()` 函数用于读取 CSV 文件。

* `to_sql()` 方法用于将数据帧导入到数据库。

* `if_exists` 参数指定如果表已存在,则追加数据。

**参数说明:**

* `data`:要导入的数据帧。

* `table_name`:要导入到的数据库表名。

* `engine`:数据库引擎对象。

* `if_exists`:指定如果表已存在,则如何处理。

### 4.3 文件读取与机器学习

#### 4.3.1 从文件中读取训练数据

**代码块:**

```python

import numpy as np

# 从文件中读取训练数据

data = np.loadtxt('data.txt', delimiter=',')

```

**逻辑分析:**

* `np.loadtxt()` 函数用于从文件中读取数据并将其转换为 NumPy 数组。

* `delimiter` 参数指定分隔符,用于将数据分隔成列。

**参数说明:**

* `filename`:要读取的文件名。

* `delimiter`:分隔符。

#### 4.3.2 使用Scikit-learn库处理文件数据

**代码块:**

```python

from sklearn.model_selection import train_test_split

# 使用 Scikit-learn 库处理文件数据

data = pd.read_csv('data.csv')

X = data.drop('label', axis=1)

y = data['label']

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

```

**逻辑分析:**

* `pd.read_csv()` 函数用于读取 CSV 文件。

* `drop()` 方法用于删除指定列。

* `train_test_split()` 函数用于将数据分成训练集和测试集。

**参数说明:**

* `data`:要处理的数据帧。

* `test_size`:测试集大小,以浮点数表示。

# 5. Python文件读取的性能优化

### 5.1 文件读取性能瓶颈分析

#### 5.1.1 I/O操作的耗时因素

文件读取的性能瓶颈主要在于I/O操作的耗时,主要包括以下几个因素:

- **磁盘寻址时间:**磁盘寻址时间是指磁盘磁头移动到指定扇区所需的时间。机械硬盘的寻址时间通常在几毫秒到几十毫秒之间,而固态硬盘的寻址时间则可以忽略不计。

- **数据传输时间:**数据传输时间是指将数据从磁盘读取到内存所需的时间。数据传输速度取决于磁盘的读写速度和内存的带宽。

- **系统调用开销:**系统调用是指程序向操作系统请求服务的过程,例如打开文件、读取数据和关闭文件。系统调用会带来一定的开销,尤其是当频繁进行I/O操作时。

#### 5.1.2 内存管理与性能影响

内存管理也会影响文件读取性能。当程序读取文件时,数据会先被加载到内存中。如果内存空间不足,系统会将部分数据交换到虚拟内存中,这会显著降低读取速度。

### 5.2 文件读取性能优化策略

针对上述性能瓶颈,可以采用以下策略进行优化:

#### 5.2.1 使用多线程或多进程提高读取速度

多线程或多进程可以并行读取文件,从而提高读取速度。例如,可以使用`multiprocessing`库创建多个进程,每个进程负责读取文件的一部分。

```python

import multiprocessing

def read_file(filename, start, end):

with open(filename, 'r') as f:

f.seek(start)

data = f.read(end - start)

return data

if __name__ == '__main__':

filename = 'large_file.txt'

file_size = os.path.getsize(filename)

num_processes = 4

chunk_size = file_size // num_processes

processes = []

for i in range(num_processes):

start = i * chunk_size

end = (i + 1) * chunk_size

p = multiprocessing.Process(target=read_file, args=(filename, start, end))

processes.append(p)

for p in processes:

p.start()

for p in processes:

p.join()

# 合并读取结果

with open('output.txt', 'w') as f:

for data in processes:

f.write(data)

```

#### 5.2.2 采用缓存机制减少重复读取

缓存机制可以将经常访问的数据存储在内存中,从而减少重复读取文件的次数。例如,可以使用`lru_cache`装饰器对文件读取函数进行缓存。

```python

from functools import lru_cache

@lru_cache(maxsize=100)

def read_file(filename):

with open(filename, 'r') as f:

data = f.read()

return data

```

#### 5.2.3 优化文件格式和存储结构

优化文件格式和存储结构可以减少文件读取的开销。例如,使用压缩文件格式可以减少文件大小,从而加快读取速度。此外,还可以使用分块存储结构,将文件划分为多个块,从而减少寻址时间。

# 6. Python文件读取的未来趋势**

**6.1 云端文件读取技术**

随着云计算的普及,云端文件读取技术也逐渐成为未来趋势。云端文件存储服务,如Amazon S3、Microsoft Azure Blob Storage和Google Cloud Storage,提供了高可用性、可扩展性和低成本的存储解决方案。通过使用云端文件读取技术,应用程序可以从云端直接读取文件,而无需将文件下载到本地。这可以大大提高文件读取效率,特别是对于大型文件或需要频繁访问的文件。

**6.2 大数据文件读取与处理**

随着数据量的不断增长,大数据文件读取与处理成为一个越来越重要的挑战。传统的文件读取方法在处理大数据文件时往往效率低下。为了解决这一问题,出现了专门针对大数据文件读取与处理的工具和技术,如Apache Hadoop和Apache Spark。这些工具提供了分布式文件系统和并行处理框架,可以高效地处理海量数据文件。

**6.3 人工智能辅助文件读取**

人工智能技术也在不断推动文件读取领域的创新。人工智能算法,如自然语言处理(NLP)和计算机视觉(CV),可以帮助自动提取和解析文件中的信息。例如,NLP算法可以识别和提取文件中的关键信息,而CV算法可以识别和提取图像文件中的文本和对象。这些技术可以大大提高文件读取的准确性和效率,特别是对于非结构化或半结构化的文件。

**示例代码:**

```python

import boto3

# 使用 Amazon S3 读取文件

s3 = boto3.client('s3')

bucket_name = 'my-bucket'

file_name = 'my-file.txt'

response = s3.get_object(Bucket=bucket_name, Key=file_name)

file_content = response['Body'].read().decode('utf-8')

# 使用 Apache Hadoop 读取文件

import pyspark

sc = pyspark.SparkContext()

rdd = sc.textFile('hdfs://my-cluster/path/to/file.txt')

```

**表格:**

| 云端文件存储服务 | 特点 |

|---|---|

| Amazon S3 | 高可用性、可扩展性、低成本 |

| Microsoft Azure Blob Storage | 高性能、低延迟 |

| Google Cloud Storage | 高吞吐量、低成本 |

**流程图:**

```mermaid

graph LR

subgraph 云端文件读取

s3 --> file content

azure --> file content

gcs --> file content

end

subgraph 大数据文件读取

hadoop --> file content

spark --> file content

end

subgraph 人工智能辅助文件读取

nlp --> file content

cv --> file content

end

```

0

0