算法分析的艺术:5个步骤系统提升算法效率

发布时间: 2024-12-24 17:47:22 阅读量: 6 订阅数: 7

算法艺术与信息学竞赛

# 摘要

随着计算需求的日益增长,算法效率成为衡量软件性能的关键指标。本文首先强调了算法效率的重要性,进而深入分析了算法的时间复杂度和空间复杂度,探讨了如何理解和比较不同算法的时间和空间要求。接着,本文阐述了算法优化的基础理论与实践技巧,以及数据结构在优化中的重要性。在高级算法优化技术方面,文中探讨了循环优化、递归改写、分治策略、动态规划、贪心算法和图算法的优化。特别地,本文还介绍了并行计算、缓存优化、内存管理以及机器学习在算法优化中的应用。整体而言,本文旨在为读者提供一套全面的算法优化知识体系,以提高算法性能并适应更复杂的应用场景。

# 关键字

算法效率;时间复杂度;空间复杂度;数据结构;并行计算;内存管理

参考资源链接:[算法设计与分析(第2版)课后习题答案解析](https://wenku.csdn.net/doc/4ff9g7jc3z?spm=1055.2635.3001.10343)

# 1. 算法效率的重要性

在当今的IT行业中,算法效率是衡量软件性能的一个关键因素。高效的算法不仅能够提升用户体验,还能降低资源消耗和维护成本。随着数据量的不断扩大,一个设计良好的算法可能意味着业务处理速度的飞跃和成本的显著降低。因此,深入理解算法效率的重要性并不断追求优化,对于IT专业人士来说是必不可少的技能。在接下来的章节中,我们将探讨时间复杂度和空间复杂度的概念,分析算法效率,并提供一些实用的优化技巧。

# 2. 算法时间复杂度分析

## 2.1 时间复杂度的基本概念

### 2.1.1 大O表示法

大O表示法是分析算法时间复杂度的数学工具,它描述了算法运行时间随输入数据规模增长的增长趋势。在大O表示法中,我们通常关注最坏情况下的运行时间。大O表示法不提供具体的执行时间,而是提供一个上限估计,这是一种“上界”概念。

例如,考虑一个简单的循环,它遍历一个包含n个元素的数组,并对每个元素执行常数时间操作:

```c

for (int i = 0; i < n; i++) {

// 常数时间操作

}

```

这个循环的时间复杂度为O(n),因为循环的执行次数直接与数组的大小n成线性关系。大O表示法省略了常数和低阶项,因为它主要关注的是随着输入规模增加,算法性能如何变化。

### 2.1.2 常见算法的时间复杂度

常见的时间复杂度可以分为以下几类:

- 常数时间:O(1),不随输入数据的规模变化而变化。

- 对数时间:O(log n),例如二分查找。

- 线性时间:O(n),如简单遍历。

- 线性对数时间:O(n log n),常见于高效排序算法,如归并排序。

- 平方时间:O(n^2),如简单排序算法(冒泡排序、选择排序)。

- 指数时间:O(2^n),如简单的递归实现的斐波那契数列。

- 阶乘时间:O(n!),如旅行商问题的穷举解。

## 2.2 理解不同类型的算法时间

### 2.2.1 最佳、平均和最坏情况分析

最佳情况分析考虑了算法执行时间最短的情况,这有助于理解算法在最优情况下的性能表现。

平均情况分析涉及算法在所有可能的输入下运行时间的平均值。通常这个分析比较复杂,因为需要对所有输入数据的分布做出假设。

最坏情况分析提供了一个性能保证,确定了算法性能的上限。对于许多应用而言,最坏情况分析非常关键,因为它确保了算法在最糟糕的情况下仍然可靠。

### 2.2.2 时间复杂度的比较和选择

在选择算法时,我们应该考虑其时间复杂度,但也需要考虑实现复杂度、内存使用等因素。例如,一个具有O(n log n)时间复杂度的排序算法可能比一个具有O(n^2)时间复杂度的算法更快,尤其是在数据集较大时。然而,如果数据集规模很小,O(n^2)算法的实现可能更简单且常数因子较小,这时可能更合适。

## 2.3 空间复杂度分析

### 2.3.1 空间复杂度的定义

空间复杂度衡量的是算法在运行过程中临时占用存储空间的大小。它与时间复杂度类似,通常关注额外空间的需求,即不包括输入数据本身所占空间。空间复杂度通常以大O表示法表示,如O(1)、O(n)、O(n^2)。

### 2.3.2 空间效率与时间效率的权衡

在算法设计中,通常需要在空间效率和时间效率之间做出权衡。例如,使用空间换时间的策略,通过引入额外的数据结构来加快算法的速度。一个好的算法设计要根据具体的应用场景和资源限制来平衡这两个方面。

举一个空间换时间的例子,哈希表存储技术可以大大加快查找操作的速度,但引入了额外的空间需求。对于哈希表来说,理想情况下其查找操作的时间复杂度为O(1),但需要额外的空间来存储哈希表结构。

# 3. 算法优化基础

## 3.1 算法优化的理论基础

### 3.1.1 算法优化的原则和方法

算法优化是一项需要细致考虑和周密计划的工作,它遵循几个基本原则。首先,优化工作应以问题的需求为导向,确保优化后的算法能够满足性能指标,同时不牺牲算法的正确性和稳定性。其次,优化过程中应权衡算法的时间复杂度与空间复杂度,以达到最佳的性能表现。

在方法上,算法优化通常包括以下几个步骤:

1. **分析算法**:理解算法的逻辑和工作原理,确定算法的性能瓶颈。

2. **选择合适的指标**:根据实际应用场景确定优化的目标指标,如运行时间、内存占用等。

3. **实施优化**:修改算法逻辑、数据结构选择,或者调整算法参数,以实现性能提升。

4. **评估优化结果**:通过实际测试验证优化效果,确保优化没有引入新的问题。

### 3.1.2 算法优化的常见误区

在优化过程中,需要避免一些常见的误区:

- **过早优化**:在未进行性能分析之前就进行优化,可能会导致资源浪费和错误的优化方向。

- **忽略算法的整体效率**:单纯降低某个操作的开销而忽视了算法的整体效率,可能会造成整体性能的降低。

- **不计成本的优化**:一些优化手段可能需要复杂的实现和高昂的维护成本,应当在优化收益与成本之间找到平衡点。

## 3.2 数据结构在算法优化中的作用

### 3.2.1 常用数据结构及其性能

算法优化中,数据结构的选择至关重要。不同的数据结构具有不同的时间和空间复杂度特性,适合解决不同类型的问题。例如:

- **数组**:时间复杂度为O(1)的随机访问,但在插入和删除操作时可能需要移动大量元素。

- **链表**:插入和删除操作的时间复杂度为O(1),但随机访问的时间复杂度为O(n)。

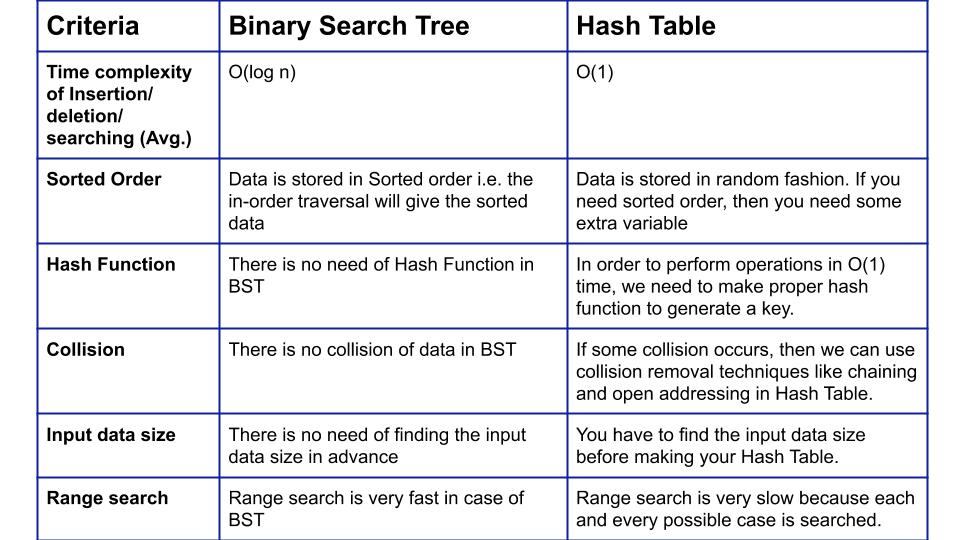

- **哈希表**:平均情况下,查找、插入和删除操作的时间复杂度为O(1)。

- **二叉搜索树(BST)**:在平衡的情况下,查找、插入和删除操作的时间复杂度为O(log n)。

- **堆(Heap)**:支持快速查找和删除最大或最小元素,时间复杂度为O(log n)。

### 3.2.2 如何根据问题选择合适的数据结构

选择合适的数据结构需要依据算法解决的问题类型。例如:

- **动态集合问题**:使用BST可以保证高效的查找、插入和删除操作。

- **优先级队列问题**:堆结构是解决此类问题的理想选择。

- **查找问题**:哈希表提供了快速的查找能力。

- **顺序访问问题**:数组或链表可能更合适,视具体需求而定。

## 3.3 算法优化的实践技巧

### 3.3.1 常见算法优化技术

实践中,常见的算法优化技术包括:

- **避免不必要的计算**:移除或简化算法中的冗余操作。

- **减少循环迭代次数**:通过算法逻辑优化减少循环体内的迭代次数。

- **局部性原理**:优化数据访问模式,尽量减少缓存失效。

- **代码重构**:简化算法逻辑,提高代码的可读性和可维护性。

### 3.3.2 实例分析:优化过程详解

以一个简单的排序算法优化为例,考虑对插入排序的优化。原始插入排序的平均和最坏时间复杂度均为O(n^2),在数据规模较大时效率较低。通过引入二分查找改进插入位置的确定过程,可以减少比较的次数,从而降低时间复杂度至O(n log n),这是一个典型的用空间换取时间的优化实例。

```python

def binary_search(arr, val, start, end):

"""二分查找插入位置"""

while start < end:

mid = (start + end) // 2

if arr[mid] < val:

start = mid + 1

else:

end = mid

return start

def insertion_sort(arr):

"""改进的插入排序"""

for i in range(1, len(arr)):

key = arr[i]

j = binary_search(arr, key, 0, i)

arr = arr[:j] + [key] + arr[j:i] + arr[i+1:]

return arr

# 示例代码逻辑分析:

# binary_search函数使用二分查找确定了插入的位置,优化了插入操作。

# insertion_sort函数在找到插入位置后,通过列表切片实现了元素的移动,减少了循环中的操作。

```

在优化过程中,我们通过引入额外的空间(二分查找过程中创建的栈空间)来换取时间效率的提升,这是算法优化中一个常见的权衡策略。通过这种方式,我们不仅提升了算法的效率,也优化了代码的可读性和可维护性。

# 4. 深入探索算法优化技术

## 4.1 循环优化和递归改写

### 4.1.1 循环展开与合并

循环是程序中常用的一种结构,特别是当算法需要重复执行某些计算时。循环优化是提高算法性能的重要手段之一。循环展开是一种常见的优化技术,旨在减少循环的控制开销和增加指令级并行度。通过减少循环迭代次数和循环控制指令的开销,可以提升程序的执行效率。

在循环展开的过程中,开发者可以将多个连续的迭代合并为一个迭代,并减少循环结束时的条件检查次数。例如,一个简单的for循环:

```c

for (int i = 0; i < n; i++) {

a[i] = b[i] + c[i];

}

```

可以展开成如下形式:

```c

for (int i = 0; i < n - 4; i += 4) {

a[i] = b[i] + c[i];

a[i + 1] = b[i + 1] + c[i + 1];

a[i + 2] = b[i + 2] + c[i + 2];

a[i + 3] = b[i + 3] + c[i + 3];

}

```

在上面的代码中,每次循环迭代处理四个元素,而不是一个。这意味着循环的迭代次数减少了,减少了循环控制指令的开销。当然,开发者需要确保展开的循环保持等价于原始循环的功能。

**代码逻辑分析**:

- **初始化**: 通过设置循环的起始值为0,保证循环从数组的第一个元素开始。

- **条件判断**: 通过判断`i < n - 4`,确保循环能够在完成所有必要的操作后终止,且考虑了优化后的迭代步长。

- **迭代步长**: 通过设置步长为4,每次循环处理四个元素,减少了循环迭代次数。

- **操作执行**: 在循环体内,执行数组元素的加法操作,这部分逻辑未因循环展开而改变。

### 4.1.2 递归算法的迭代化

递归算法在实现复杂数据结构和搜索算法时十分有用,但是递归通常伴随着较大的开销,包括函数调用栈的消耗以及递归的重复计算。递归改写为迭代算法是优化性能的另一个关键点,它可以减少函数调用的开销,并通过循环来模拟递归的过程。

考虑经典的斐波那契数列计算:

```c

int fibonacci(int n) {

if (n <= 1) {

return n;

}

return fibonacci(n - 1) + fibonacci(n - 2);

}

```

递归实现斐波那契数列计算的效率并不高,因为大量的重复计算发生在`fibonacci(n - 1)`和`fibonacci(n - 2)`。改写为迭代形式后:

```c

int fibonacci(int n) {

if (n <= 1) {

return n;

}

int a = 0, b = 1, c = 0;

for (int i = 2; i <= n; i++) {

c = a + b;

a = b;

b = c;

}

return c;

}

```

在迭代版本中,我们通过循环来避免重复计算,仅使用几个变量来保存必要的值,并通过简单的加法操作来计算斐波那契数列。这种方法避免了递归的大量调用栈消耗,并且显著提升了性能。

**代码逻辑分析**:

- **初始条件**: 在迭代开始前,我们初始化了三个变量`a`、`b`和`c`,分别对应斐波那契数列中的`fib(n-2)`、`fib(n-1)`和`fib(n)`。

- **迭代过程**: 在循环中,每次迭代计算`fib(n)`的值,并更新`a`和`b`的值,使得它们分别保存`fib(n-1)`和`fib(n)`。

- **退出条件**: 循环继续执行直到计算出`fib(n)`的值。

通过这种优化手段,我们可以将原本耗时的递归算法改写为高效的迭代算法,提升程序的性能。

# 5. 高级算法优化方法

## 5.1 并行计算与算法优化

### 5.1.1 并行计算基础

在现代计算领域,单个处理器的速度已经逐渐达到物理极限。多核处理器和分布式计算环境的出现,使得并行计算成为了提升计算性能的关键。并行计算通过在多个处理器或计算节点上同时执行计算任务,达到缩短程序运行时间的目的。然而,并行化并不总是简单的代码转换问题,它需要对算法结构进行深刻的理解和重新设计。

并行计算的核心概念包括任务分解(Divide)、任务分配(Conquer)、和任务合并(Combine)。任务分解是指将算法分解成可以独立或并行执行的小任务。任务分配是指将这些小任务分配给不同的处理器或计算节点。任务合并则是将这些并行执行的结果汇总,得到最终结果。并行计算模式主要有数据并行和任务并行,数据并行强调同一数据集上的操作并行化,而任务并行强调不同任务或数据集上的操作并行化。

### 5.1.2 并行算法设计与优化

并行算法设计需要考虑如何将工作负载有效分配到多个处理器上,并确保负载均衡。一个好的并行算法能够在处理器之间均匀分配计算任务,避免出现“瓶颈”现象。实现并行算法通常需要使用特定的编程模型,例如共享内存模型或消息传递模型。这些模型提供了不同的机制来实现任务的并行化和数据的共享。

在设计并行算法时,我们需要考虑通信开销、同步开销以及计算开销。通信开销指的是在处理器或节点间传递数据的开销;同步开销是指并行任务之间需要协调一致操作而产生的开销;计算开销则是并行执行任务本身所需要的时间。算法优化就是要最小化通信和同步开销,同时保持较高的计算效率。

下面是一个简单的并行计算示例,使用Python的多线程来并行执行任务:

```python

import threading

import queue

def worker(num, task_queue):

while not task_queue.empty():

task = task_queue.get()

print(f"Worker {num} is working on task {task}")

task_queue.task_done()

if __name__ == "__main__":

task_queue = queue.Queue()

num_tasks = 10

num_workers = 4

# Generate tasks

for i in range(num_tasks):

task_queue.put(i)

# Start workers

threads = []

for i in range(num_workers):

t = threading.Thread(target=worker, args=(i, task_queue))

t.start()

threads.append(t)

# Wait for all tasks to be processed

task_queue.join()

# Wait for all threads to complete

for t in threads:

t.join()

```

这个例子展示了如何创建多个工作线程,并将任务队列中的任务分配给这些线程。每个线程从队列中取出一个任务并执行,完成后标记任务完成,主程序等待所有任务完成后才继续执行。并行算法设计时,要注意任务分解和分配策略,以及避免竞争条件等同步问题。

并行计算的目标是通过合适的并行算法设计,减少执行时间,提升整体性能。但在实践中,这需要精细的算法分析和优化,以及对硬件资源的深入了解。

## 5.2 缓存优化与内存管理

### 5.2.1 缓存局部性原理

缓存优化是算法优化中的一个关键方面,尤其是在处理大规模数据集时。缓存局部性原理是理解缓存优化的基础,主要包括时间局部性和空间局部性。

时间局部性指的是,如果一个数据项被访问,那么在近期它很可能再次被访问。空间局部性是指如果一个数据项被访问,那么与它相邻的数据项很可能很快也会被访问。现代计算机系统的缓存设计就是利用了这两个原理来加快数据的读取速度。

缓存优化的关键在于算法设计时考虑数据的访问模式。例如,避免不必要的全局变量访问,尽量使用局部变量,以及优化数据结构的布局,使得数据访问时能够尽可能地利用缓存。

### 5.2.2 优化算法中的内存访问模式

在算法优化中,内存访问模式对性能有着显著的影响。顺序访问内存比随机访问要快得多,因为顺序访问符合缓存的预取机制,可以减少缓存未命中的情况。

在编程实践中,可以使用循环展开、循环分块(Blocking)以及数据重排等技术来优化内存访问模式。循环展开是将循环体内的语句复制多份,减少循环的开销;循环分块是将大型数据集合分割成多个小型数据块,然后对每个小块进行操作,这可以减少缓存未命中的可能性;数据重排则是改变数据的存储方式,使得内存访问更加连续。

例如,考虑下面这个简单的二维矩阵乘法的例子:

```python

def matrix_multiply(A, B):

result = [[0 for _ in range(len(B[0]))] for _ in range(len(A))]

for i in range(len(A)):

for j in range(len(B[0])):

for k in range(len(B)):

result[i][j] += A[i][k] * B[k][j]

return result

```

这个函数的内存访问模式是连续的,符合缓存局部性原理,能够比较有效地利用现代CPU缓存。

缓存优化和内存管理是一个复杂的主题,涉及具体硬件细节和算法特性。理解这些原理,并将它们应用到算法设计中,可以显著提升算法的性能。

## 5.3 机器学习在算法优化中的应用

### 5.3.1 机器学习方法概述

机器学习是一个涉及广泛的领域,其在算法优化中的应用越来越受到重视。机器学习方法可以从数据中学习模式,并基于这些模式做出预测或决策。在算法优化中,机器学习可以用于预测算法的性能,指导算法的设计和优化。

机器学习方法可以分为监督学习、非监督学习和强化学习等类别。监督学习中,模型通过大量的输入-输出对进行训练,学会预测输出;非监督学习中,模型尝试发现数据中的结构,而无需特定的输出标签;强化学习则通过与环境的交互来学习如何在特定任务上取得最大的奖励。

### 5.3.2 应用机器学习优化算法效率的案例分析

机器学习可以用于算法的自适应优化。例如,通过机器学习模型预测算法运行时间,可以动态调整算法的参数来实现优化。在图算法中,机器学习可以帮助预测哪些节点应该优先处理,从而加快算法的收敛速度。

下面是一个简单的例子,使用机器学习来预测算法运行时间,并根据预测结果进行优化:

```python

import numpy as np

from sklearn.ensemble import RandomForestRegressor

# 假设这里有一组数据,包含了不同参数设置下的算法运行时间

data = np.array([

[100, 200, 10], # 输入参数和对应的运行时间

[150, 250, 15],

[200, 300, 20],

# ... 其他数据

])

inputs = data[:, :-1]

outputs = data[:, -1]

# 使用随机森林回归器作为机器学习模型

model = RandomForestRegressor()

model.fit(inputs, outputs)

# 预测给定参数设置下的运行时间

predicted_time = model.predict([[120, 220]])

# 如果预测时间较长,可以选择更优的参数设置

if predicted_time > threshold:

optimize_parameters()

```

在这个例子中,我们首先准备了一组输入参数和对应运行时间的数据,然后使用随机森林回归器来训练模型,最后模型被用来预测给定参数下的运行时间。如果预测的时间超过某个阈值,则可能需要优化算法参数。

机器学习在算法优化中的应用仍处于探索阶段,但它已经显示出了巨大的潜力。随着机器学习技术的不断进步,我们可以预期在算法优化领域中将会有更多的创新应用出现。

# 6. 算法优化案例分析与实践

在前面的章节中,我们深入了解了算法优化的理论和基础技术,如时间复杂度和空间复杂度分析,数据结构在优化中的作用,以及循环优化、分治策略和动态规划等高级技术。在本章中,我们将通过具体的案例,探讨如何将这些理论和技巧应用于实际问题的解决中,并实践优化过程。

## 6.1 优化案例:字符串匹配算法

字符串匹配是编程中常见的问题,许多算法和应用程序都需要高效地处理字符串。本节将探讨传统的字符串匹配算法——KMP算法,并对其进行优化。

### 6.1.1 KMP算法原理

KMP(Knuth-Morris-Pratt)算法是一种改进的字符串搜索算法,主要通过构建部分匹配表来避免不必要的字符比较。

```python

def kmp_table(pattern):

table = [0] * len(pattern)

j = 0

for i in range(1, len(pattern)):

while j > 0 and pattern[i] != pattern[j]:

j = table[j - 1]

if pattern[i] == pattern[j]:

j += 1

table[i] = j

return table

def kmp_search(text, pattern):

table = kmp_table(pattern)

j = 0

for i in range(len(text)):

while j > 0 and text[i] != pattern[j]:

j = table[j - 1]

if text[i] == pattern[j]:

j += 1

if j == len(pattern):

return i - j + 1 # Pattern found

if j == len(pattern) and pattern[j] == text[i]:

return i - j + 1 # Pattern found

return -1 # Pattern not found

```

### 6.1.2 KMP算法优化

KMP算法的优化可以从构建部分匹配表的过程入手,减少表的构建时间。

#### 实践技巧:避免重复计算

为了避免在构建部分匹配表时的重复计算,可以采用一种更加高效的表构建方法:

```python

def optimized_kmp_table(pattern):

table = [0] * len(pattern)

for i in range(1, len(pattern)):

j = table[i-1]

while j > 0 and pattern[i] != pattern[j]:

j = table[j-1]

if pattern[i] == pattern[j]:

j += 1

table[i] = j

return table

```

优化后的部分匹配表构建方法减少了不必要的回溯,使得KMP算法在进行字符串匹配时更加高效。

## 6.2 优化案例:排序算法的改进

排序算法是算法优化中不可或缺的一部分。在不同的应用场景中,排序算法的优化可能涉及不同的技术。

### 6.2.1 归并排序优化

归并排序是一种典型的分治算法,其主要开销在于合并两个有序序列的过程。在对归并排序进行优化时,可以考虑减少不必要的数据复制。

#### 实践技巧:原地归并排序

为了提高归并排序的效率,可以尝试实现原地归并排序,减少额外空间的使用。

```python

def merge_in_place(arr, temp_arr, left, mid, right):

i, j = left, mid + 1

while i <= mid and j <= right:

if arr[i] <= arr[j]:

temp_arr[i] = arr[i]

i += 1

else:

temp_arr[j] = arr[j]

j += 1

# Copy the remaining elements

temp_arr[left:right+1] = arr[left:right+1]

for k in range(left, right + 1):

arr[k] = temp_arr[k]

def inplace_merge_sort(arr):

temp_arr = arr[:]

merge_sort_rec(arr, temp_arr, 0, len(arr) - 1)

return arr

def merge_sort_rec(arr, temp_arr, left, right):

if left < right:

mid = (left + right) // 2

merge_sort_rec(arr, temp_arr, left, mid)

merge_sort_rec(arr, temp_arr, mid + 1, right)

merge_in_place(arr, temp_arr, left, mid, right)

```

原地归并排序减少了内存使用,并且在某些情况下,由于减少了内存分配和释放的操作,还能带来性能上的提升。

## 6.3 优化案例:图算法加速

图算法在处理网络、地图和社交网络等数据时非常有用。在优化图算法时,我们可以考虑采用不同的数据结构来减少算法的时间复杂度。

### 6.3.1 广度优先搜索(BFS)优化

广度优先搜索是一种常见的图遍历算法。优化BFS通常涉及到更有效的队列数据结构的选择。

#### 实践技巧:使用双端队列

在处理BFS时,使用双端队列(deque)可以优化搜索过程,特别是在有向无环图(DAG)中寻找所有源点到其他点的最短路径问题上。

```python

from collections import deque

def bfs_shortest_path(graph, start):

visited = set()

queue = deque([start])

while queue:

vertex = queue.popleft()

if vertex not in visited:

visited.add(vertex)

queue.extend([n for n in graph[vertex] if n not in visited])

return visited

```

使用双端队列而非标准队列可以让我们在BFS中更快地处理节点,因为它允许我们在队列的两端进行添加和移除操作。

通过上述案例的分析与实践,我们展示了如何将理论知识应用到具体的问题优化中,并通过实践技巧解决实际问题。在算法优化的道路上,不断地将理论与实践相结合,是每个IT从业者不断成长和进步的关键所在。在下一章,我们将进一步探讨更多高级的优化方法及其实际应用。

0

0