YOLOv8跨平台部署全攻略

发布时间: 2024-12-12 02:36:15 阅读量: 20 订阅数: 20

YOLOv10跨平台部署与性能优化:深入分析与实践指南

# 1. YOLOv8模型概述与跨平台部署需求

## 1.1 YOLOv8模型概述

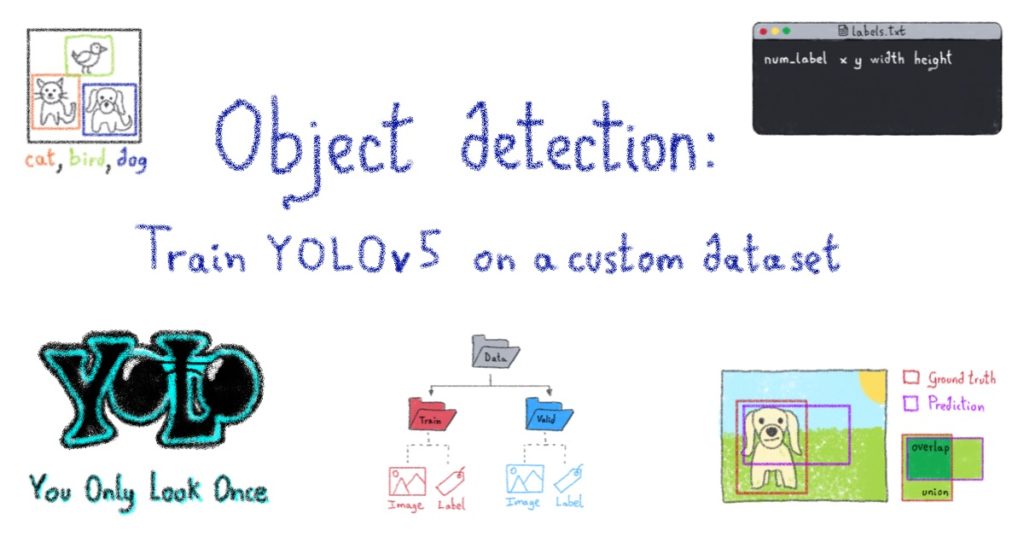

YOLOv8(You Only Look Once version 8)是一个在计算机视觉领域内广泛使用的实时目标检测系统。自2015年首次发布以来,YOLO系列模型因其出色的检测速度和准确性成为了很多视觉应用的首选。YOLOv8延续了YOLO家族的风格,强调速度与准确性的平衡,并在最新的版本中引入了多项改进,以适应日益复杂的视觉任务。

## 1.2 跨平台部署需求

跨平台部署需求是指将模型部署到不同的操作系统和硬件平台的能力,这对于各种场景中的应用至关重要。需求的多样性要求模型不仅要在性能上达到基准,同时也要保持良好的兼容性和优化性能。跨平台部署通常面临以下挑战:

- **异构硬件支持**:包括CPU、GPU、FPGA等多种硬件平台的兼容性。

- **操作系统多样性**:从桌面操作系统到嵌入式系统,包括Linux、Windows、macOS等。

- **部署便捷性**:简化部署流程,确保在不同环境下快速启动和运行模型。

- **模型优化**:针对特定平台的优化,以提升性能和降低资源消耗。

跨平台部署需求的满足不仅能够扩展模型的应用范围,还能够使模型更加灵活和通用,为用户提供更好的体验。因此,理解并处理好这些需求是使YOLOv8在各行业领域成功应用的关键步骤。

# 2. 环境准备与依赖安装

### 2.1 选择操作系统和硬件平台

在深入YOLOv8模型的跨平台部署之前,环境准备是至关重要的一步。选择合适的操作系统和硬件平台对于确保部署成功和运行效率至关重要。

#### 2.1.1 操作系统的兼容性分析

选择一个支持YOLOv8所需依赖库和框架的操作系统是首要任务。对于YOLOv8而言,它被广泛地支持在Linux操作系统上,特别是基于Debian和Red Hat的发行版。例如,Ubuntu作为Linux界中应用最广泛的发行版,它在维护生态和社区支持方面做得很好,使得它成为部署YOLOv8的首选。

#### 2.1.2 硬件加速选项与配置

对于深度学习模型,特别是视觉识别模型来说,GPU加速是提升性能的关键。NVIDIA的CUDA技术允许YOLOv8利用GPU强大的计算能力进行加速。在选择硬件平台时,确保你的GPU兼容CUDA,并安装了对应的驱动和CUDA toolkit。此外,一些优化选项,如NVIDIA TensorRT,可以进一步提升推理性能。

### 2.2 安装依赖软件和开发工具

YOLOv8模型的部署不仅需要合适的操作系统和硬件平台,还需要依赖软件和开发工具的正确安装。

#### 2.2.1 安装Python和深度学习框架

Python是YOLOv8模型的主要开发语言,因此需要安装一个兼容的Python版本。一般而言,YOLOv8兼容Python 3.6及以上版本。同时,YOLOv8依赖深度学习框架,如PyTorch或TensorFlow。对于最新的YOLOv8版本,推荐使用PyTorch,它与YOLOv8结合得更为紧密,安装和使用起来也更简单。使用以下命令可以安装PyTorch:

```bash

pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cpu

```

#### 2.2.2 编译器和依赖库的配置

YOLOv8模型的编译需要一个有效的编译环境,C++编译器如GCC或Clang是必须的。另外,YOLOv8依赖于一些其他的库,如OpenCV、libtorch等。例如,OpenCV库可以使用以下命令安装:

```bash

sudo apt-get install libopencv-dev

```

确保所有依赖都正确安装,并且版本兼容YOLOv8的编译要求,是顺利进行下一步的关键。

### 2.3 构建YOLOv8运行环境

在环境准备就绪之后,构建YOLOv8运行环境包括源代码的下载、编译以及环境变量的设置与验证。

#### 2.3.1 下载和编译YOLOv8源代码

YOLOv8的源代码可以通过其GitHub仓库获取。使用Git进行克隆:

```bash

git clone https://github.com/ultralytics/yolov8.git

cd yolov8

```

编译源代码通常需要CMake和Makefile文件。YOLOv8提供了一个详细的编译指南来指导用户如何编译不同版本的YOLOv8。使用以下命令可以开始编译过程:

```bash

mkdir build && cd build

cmake ..

make

```

#### 2.3.2 环境变量的设置与验证

为了能够在任何位置调用YOLOv8的可执行文件,需要将YOLOv8的安装路径添加到环境变量PATH中。可以通过以下命令添加路径:

```bash

export PATH=/path/to/yolov8/build:$PATH

```

添加完毕后,可以使用YOLOv8的帮助命令`yolov8 -h`来验证YOLOv8是否已正确安装,并且环境变量是否设置成功。

在本章节中,我们讨论了YOLOv8跨平台部署前的准备工作,包括选择操作系统和硬件平台,安装依赖软件和开发工具,以及构建YOLOv8的运行环境。这些准备工作为后续的编译和部署提供了坚实的基础。下章我们将继续深入探讨YOLOv8的编译和部署细节,包括交叉编译和在不同平台上的部署流程。

# 3. YOLOv8的编译与部署

## 3.1 交叉编译YOLOv8模型

### 3.1.1 针对不同平台的编译选项

在进行YOLOv8模型的交叉编译时,开发者面临着针对不同硬件平台的选择。选择合适的编译选项是优化模型部署过程的关键步骤。例如,在为ARM架构的嵌入式设备编译时,我们可能会使用像GCC或者Clang这样的交叉编译器。

编译选项应根据目标硬件的功能和性能特性来定制,比如是否有可用的GPU加速、支持的浮点运算精度等。以YOLOv8为例,不同的硬件平台可能需要不同的优化级别,比如使用 `-O2` 或 `-O3` 优化标志进行编译以提高速度,或者使用 `-Os` 来优化代码大小。

针对不同的平台,YOLOv8的编译选项可能如下:

- 对于高性能计算平台,使用 `-mavx -mfma -mavx2` 以利用Intel CPU的高级向量扩展功能。

- 对于ARM平台,可能使用 `-march=armv8-a` 或更高版本,以确保充分利用ARMv8架构的特性。

```bash

# 示例命令,针对ARM架构使用Clang编译器进行编译

clang++ -mfpu=neon -march=armv8-a -O3 -o yolov8_model yolov8.cpp

```

### 3.1.2 优化模型的压缩与加速

模型压缩和加速是交叉编译过程中的关键步骤。YOLOv8作为一个复杂的深度学习模型,其原始大小和复杂度可能不适合在计算资源有限的设备上运行。因此,开发者需要应用各种模型优化技术来减小模型大小并加快推理速度。

模型压缩技术如剪枝、量化和知识蒸馏是常用的方法。这些技术可以有效减少模型的计算需求,同时尽可能保留模型的精度。

量化技术涉及将浮点权重和激活值转换为低精度表示(如int8),这样做可以减少模型大小并加速计算。但需要注意的是,量化可能会降低模型精度,因此在实际应用中,需要在精度和性能之间做出平衡。

```python

# Python代码示例,使用量化技术

# 需要使用深度学习框架提供的API进行模型量化

quantized_model = torch.quantization.quantize_dynamic(model, {torch.nn.Linear}, dtype=torch.qint8)

```

在代码块中,我们展示了如何使用PyTorch框架提供的API对模型进行动态量化。`quantize_dynamic` 函数将模型中的线性层权重转换为int8数据类型,从而减少模型的大小和提高计算效率。

## 3.2 部署YOLOv8到目标设备

### 3.2.1 将模型移植到嵌入式设备

YOLOv8模型的部署到嵌入式设备需要考虑设备的计算能力和内存限制。为了在嵌入式设备上

0

0