R语言gbm包的参数调优:避免过拟合与欠拟合

发布时间: 2024-11-01 21:54:49 阅读量: 46 订阅数: 42

简单的基于 Kotlin 和 JavaFX 实现的推箱子小游戏示例代码

# 1. R语言gbm包的简介

R语言作为数据科学领域的重要工具,提供了诸多强大的统计和机器学习包,其中`gbm`(Gradient Boosting Machine)包是处理复杂数据关系的佼佼者。`gbm`包通过梯度提升算法,实现了对分类和回归问题的有效建模。本章旨在为读者简要介绍`gbm`包的基础知识,为后续章节的深入讨论打下基础。

`gbm`包的核心优势在于它能够处理大量特征且存在缺失值的情况,同时模型的预测精度往往优于许多其他算法。在金融、生物信息学、医学研究等多个领域,`gbm`模型已成为不可或缺的分析工具。

接下来的章节将详细探讨`gbm`模型的理论基础、构建方法、参数调优策略、高级调优技巧、实战应用以及未来发展方向。通过本系列的介绍,读者将能够掌握`gbm`包的实际使用,并有效应用于各自的研究和工作中。

# 2. ```

# 第二章:gbm包的理论基础和模型构建

## 2.1 gbm模型的基本原理

### 2.1.1 gbm的数学模型和工作机制

Gradient Boosting Machine (GBM) 是一种集成学习算法,通过组合多个弱学习器来构建一个强学习器。在gbm模型中,这些弱学习器通常是回归树。gbm的工作机制如下:

- **初始化模型**:首先,一个初始模型被建立,通常是弱分类器,比如只有一个节点的树(常数模型)。

- **迭代过程**:通过以下步骤进行迭代构建模型:

- 对于每一个迭代步骤,构建一个树模型来拟合当前的伪残差(pseudo-residuals)。伪残差是当前模型预测与实际值之间的差值。

- 更新模型以包含新的树,通过减去学习率(shrinkage parameter,通常很小)和新树的预测。

- 重复以上步骤,直到达到预定的迭代次数,或者模型的改进不再显著。

在每一步中,新加入的树模型专注于之前的模型未能很好预测的那些部分,这种自适应的方法通过增加模型复杂度来改善模型性能。

### 2.1.2 gbm的优势和应用场景

GBM模型作为机器学习领域中的一种强大算法,在各种实际问题中表现出卓越的性能。以下是gbm的几个主要优势:

- **预测准确性高**:由于它的集成学习方法,能够通过多个树模型的组合提高预测准确性。

- **处理不同类型数据的能力**:可以应用于分类问题也可以应用于回归问题。

- **可定制性**:通过调整树的数量、深度和学习率等参数,用户可以定制模型以适应特定的问题。

- **对异常值的鲁棒性**:相比于其他算法,gbm在数据含有异常值时表现更为稳健。

应用领域包括但不限于:

- **金融**:用于信用评分,股票价格预测等。

- **生物信息学**:用于基因分类,疾病预测等。

- **在线广告**:用于点击率预测等。

- **推荐系统**:用于个性化推荐等。

## 2.2 gbm包的基本使用方法

### 2.2.1 gbm包的安装和加载

在R中使用gbm包,首先需要安装并加载该包。通过以下命令即可完成安装和加载:

```R

install.packages("gbm")

library(gbm)

```

在安装之前,确保你已经安装了R语言以及相应的开发工具。gbm包是基于R编程语言的,因此用户在使用前需要熟悉R的基本操作。

### 2.2.2 基本的gbm模型构建和参数设置

构建一个基本的gbm模型通常涉及以下参数:

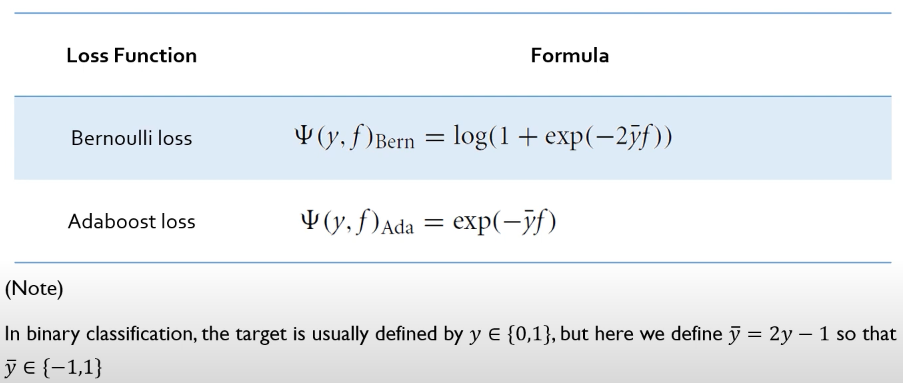

- **分布**:指定目标变量的分布类型,如"gaussian"用于回归问题,"bernoulli"用于二分类问题。

- **数据集**:包含特征和目标变量的数据框(data.frame)。

- **n.trees**:构建的树的总数。

- **interaction.depth**:树的最大深度。

- **n.minobsinnode**:树的每个叶节点的最小权重。

- **shrinkage**:学习率,通常设置为0.001至0.1之间。

- **train.fraction**:训练数据的比例。

- **cv.folds**:交叉验证的折数,通过交叉验证来评估模型。

示例代码如下:

```R

gbm_model <- gbm(

formula = y ~ .,

data = train_data,

distribution = "bernoulli",

n.trees = 500,

interaction.depth = 4,

n.minobsinnode = 10,

shrinkage = 0.01,

train.fraction = 0.8,

cv.folds = 5

)

```

在以上模型构建过程中,特征重要性可以在模型完成后用`summary()`函数进行评估:

```R

summary(gbm_model)

```

通过查看输出,我们可以了解每个特征在模型中的贡献度。特征的排列越靠前,说明它在预测过程中越重要。

接下来的章节将继续详细探讨gbm包的参数调优策略,以及如何避免过拟合和欠拟合,提高模型的泛化能力。

```

# 3. gbm包的参数调优策略

## 3.1 过拟合和欠拟合的识别

### 3.1.1 过拟合和欠拟合的表现

在机器学习模型中,过拟合(overfitting)和欠拟合(underfitting)是模型训练中常遇到的问题。过拟合是模型过于复杂,以至于它不仅学习了数据中的规律,还学习了数据中的噪声和异常值,导致在训练集上表现很好,但在新数据上的泛化能力差。欠拟合则是模型过于简单,未能捕捉数据的特征和规律,导致模型在训练集和新数据上都表现不佳。

在使用gbm包进行模型训练时,过拟合的表现可能是当训练误差持续下降,而验证集上的误差开始上升或不显著下降时。欠拟合的表现则可能是训练误差和验证集误差都较高,且模型的提升不明显。

### 3.1.2 避免过拟合和欠拟合的理论方法

为了避免过拟合和欠拟合,可以采用如下几种理论方法:

1. **正则化(Regularization)**:通过在模型的损失函数中加入罚项,限制模型复杂度,防止过拟合。

2. **交叉验证(Cross-Validation)**:通过将数据划分为多个训练和验证集,可以更准确地评估模型泛化能力。

3. **特征选择和降维(Feature Selection and Dimensionality Reduction)**:减少模型复杂度,避免学习噪声。

4. **增加训练数据(Data Augmentation)**:提供更多数据可以使模型有更宽泛的学习空间,降低过拟合风险。

5. **提前停止(Early Stopping)**:在验证误差开始增加时停止训练,防止模型过度拟合。

## 3.2 gbm包的参数调优实践

### 3.2.1 参数调优的步骤和方法

调优gbm模型的参数主要遵循以下步骤:

1. **参数理解**:首先理解每个参数对模型的影响,如树的深度(`interaction.depth`)、学习率(`shrinkage`)、迭代次数(`n.trees`)等。

2. **粗调(Coarse Tuning)**:在较大的参数空间内进行粗略的搜索,确定参数的影响趋势和大概范围。

3. **细调(Fine Tuning)**:在粗调确定的最优参数附近进行更精细的搜索,以找到最佳的参数值。

4. **交叉验证**:使用交叉验证来准确评估不同参数组合下的模型性能。

5. **自动化工具**:使用自动化工具(如`caret`包、`mlr`包)进行网格搜索或随机搜索。

### 3.2.2 常用的参数调优工具和方法

为了有效地进行参数调优,可以使用以下工具和方法:

1. **网格搜索(Grid Search)**:定义一个参数网格,然后尝试每一种参数组合,并记录性能最好的参数组合。

2. **随机搜索(Random Search)**:在参数空间中随机抽取参数组合,可以更快地找到近似最优解。

3. **贝叶斯优化(Bayesian Optimization)**:使用贝叶斯方法来估计哪个参数组合可能最优,并逐步缩小搜索范围。

### 代码示例:使用`caret`包进行gbm参数调优

0

0