R语言gbm包实战:处理大规模数据集的策略

发布时间: 2024-11-01 21:33:28 阅读量: 17 订阅数: 27

# 1. gbm包在R语言中的基础应用

在当今的数据科学领域,R语言因其强大的统计分析功能和丰富的数据分析包而备受青睐。其中,gbm包(Generalized Boosted Regression Modeling)是一个在R中实现梯度提升模型的重要工具,它可以有效地处理回归和分类问题。本章将介绍gbm包的基础使用方法,包括其安装、数据准备、模型建立和预测等关键步骤。

首先,我们将探讨如何在R环境中安装和加载gbm包,并进行基础的使用示例。接着,深入理解gbm包中包含的主要参数及其对模型性能的影响,比如树的数量、学习率、交互深度等。通过代码展示如何利用gbm包来解决实际问题,例如进行股票价格预测、客户流失预测等。

```r

# 安装和加载gbm包

install.packages("gbm")

library(gbm)

# 基础模型训练示例

fit <- gbm(y ~ x1 + x2, data = mydata, n.trees = 500, interaction.depth = 3, n.minobsinnode = 10, shrinkage = 0.01)

# 预测

predictions <- predict(fit, newdata = newdata, n.trees = 500)

```

在本章的结尾,我们将总结gbm包在R中的操作流程和最佳实践,为后续章节中对大规模数据集的处理和算法优化奠定基础。

# 2. 理解大规模数据集处理的理论基础

### 2.1 大数据的定义和挑战

#### 2.1.1 大数据的V特性(体积、速度、多样性)

大数据时代为数据科学带来了前所未有的机遇和挑战。其核心在于数据的体量(Volume)、产生的速率(Velocity)、以及种类的多样性(Variety),即所谓的3V特性。体积涉及到从TB到PB的海量数据规模,速度关注的是数据的实时性,以及数据流的快速处理,而多样性则涵盖了结构化和非结构化数据。

要处理这样的数据,需要有应对大数据的存储、处理技术和算法。例如,Hadoop和Spark等分布式计算框架允许对极大规模的数据集进行高效存储和分析。此外,数据的快速流入要求系统能够实时处理数据并提供实时决策支持。

#### 2.1.2 大规模数据集处理的常见问题

在大规模数据集处理中,常见的问题包括但不限于数据冗余、数据不一致性、数据安全和隐私问题。这些挑战需要通过合理的设计数据架构、选择合适的处理技术和实施严格的安全策略来解决。

此外,大规模数据处理还面临着技术挑战,比如如何保证数据处理的实时性和准确性,如何优化算法以处理非结构化数据,以及如何提高数据处理的效率和可扩展性。

### 2.2 gbm算法的理论背景

#### 2.2.1 梯度提升的原理

梯度提升(Gradient Boosting)是一种强大的机器学习算法,用于解决包括回归和分类问题在内的各种任务。梯度提升的原理是通过迭代地添加弱学习器来构建一个强学习器,每一个新的弱学习器的训练都基于之前所有弱学习器的预测误差。

具体来说,在梯度提升过程中,算法通过最小化损失函数来逐步改进模型的预测效果。每一步中,算法都会计算损失函数关于模型预测的负梯度,并添加一个新模型(通常是一个决策树)来拟合这些负梯度,即残差。

#### 2.2.2 gbm算法的数学框架

gbm(Gradient Boosting Machine)算法是梯度提升方法的一种实现,它将梯度提升的原理运用到决策树模型上。gbm算法的数学框架可以视为一个优化问题,目标是最小化损失函数L(y, F(x)),其中y是目标变量,F(x)是预测函数。

给定一组训练数据{ (x_i, y_i) | i = 1, ..., n },其中x_i表示特征向量,y_i表示目标值。我们希望找到一个预测函数F(x),使得损失函数的期望最小:

min_F ∑ L(y_i, F(x_i)) + Ω(F)

其中,Ω(F)是一个表示模型复杂度的正则化项,用于防止过拟合,如决策树的叶节点数量。

### 2.3 R语言中处理大规模数据集的策略

#### 2.3.1 数据预处理和清洗技术

在R语言中,数据预处理和清洗是数据科学项目中最为关键的步骤之一。这通常涉及去除重复记录、处理缺失值、识别和处理异常值,以及对数据进行转换和标准化。R语言提供了诸如`dplyr`、`data.table`、`tidyr`等强大的数据处理包,使得这些操作变得简单高效。

例如,`dplyr`包中的`mutate()`函数可以用来创建或变换列,`filter()`函数用于选择数据集中的特定行,而`summarise()`函数可以用来对数据进行汇总计算。`data.table`包提供了快速且内存高效的替代方案,特别适合处理非常大的数据集。

#### 2.3.2 内存管理与数据压缩方法

R语言在处理大型数据集时经常遇到内存不足的问题。为了有效地管理内存,可以使用一些策略如读取数据的子集、使用R的磁盘基数据框架`ff`包,或者对数据进行压缩以减少内存占用。

数据压缩方法包括数据类型转换,例如,将数字型变量的精确浮点数转换为整数型;应用因子编码减少内存使用;以及使用专门的压缩算法。在R中,可以使用`haven`、`readr`等包来读取和处理特定格式的数据文件,如`haven`支持读取SPSS、SAS和Stata文件,而`readr`则能快速读取CSV文件。此外,对于数据集的磁盘存储,可以利用`fst`包的高压缩率特性。

在接下来的章节中,我们将详细介绍gbm算法在大规模数据集上的实践操作,包括数据预处理、模型训练调优以及评估与解释。

# 3. gbm包在大规模数据集上的实践操作

随着数据集规模的不断扩大,传统的数据处理方法和算法往往难以应对,特别是在面对复杂模型时。本章重点介绍如何在大规模数据集上应用`gbm`包进行实践操作。我们将深入探讨数据预处理、特征工程、模型训练、调优、评估与结果解释等关键步骤。

## 3.1 数据预处理与特征工程

在数据分析和机器学习项目中,数据预处理和特征工程占据了至关重要的位置。对于大规模数据集,这一步骤尤为关键,因为它直接关系到后续模型的训练效率和预测准确性。

### 3.1.1 缺失值处理和异常值检测

在处理大规模数据时,经常会遇到数据缺失和异常值的问题。这会影响模型的训练,因此必须采取适当的处理措施。

**代码块展示与分析**:

```r

# 加载gbm包

library(gbm)

# 假设有一个大型数据框df

# 检测并处理缺失值

df <- as.data.frame(faithful)

df$eruptions[is.na(df$eruptions)] <- median(df$eruptions, na.rm = TRUE)

# 异常值检测与处理

# 使用3*IQR规则识别异常值

for (i in 1:ncol(df)) {

Q1 <- quantile(df[[i]], 0.25)

Q3 <- quantile(df[[i]], 0.75)

IQR <- Q3 - Q1

df[[i]] <- ifelse(df[[i]] < (Q1 - 3 * IQR) | df[[i]] > (Q3 + 3 * IQR), NA, df[[i]])

}

# 处理异常值

df <- na.omit(df)

```

在这段代码中,首先用中位数填充了缺失值,避免了因删除含有缺失值的行而导致的数据损失。接着,对每一列数据应用了3倍四分位距(IQR)规则来识别异常值。如果数据点超过了这个范围,它会被视为异常并替换为`NA`。最后,删除了含有`NA`的行,得到一个“干净”的数据集以用于后续分析。

### 3.1.2 特征选择和特征构建方法

良好的特征对于建立强大的模型至关重要。特征选择和构建是特征工程中的关键部分,它能帮助模型聚焦于最重要的信息,从而提高模型性能。

**代码块展示与分析**:

```r

# 使用gbm进行特征选择

set.seed(123)

gbm.model <- gbm(Survived ~ ., data = titanic, n.trees = 100, distribution = "bernoulli")

best.iter <- gbm.perf(gbm.model, method = "OOB")

# 提取重要特征

importance <- summary(gbm.model, n.trees = best.iter, las = 2, cBars = 15)

# 绘制特征重要性图

barplot(importance$importance, las = 2, col = "lightblue",

main = "Variable Importance in Titanic Dataset")

```

以上代码演示了如何利用`gbm`包选择重要特征。首先,使用`gbm`拟合模型,并确定最佳的迭代次数。接着,提取并可视化特征的重要性。通过这样的分析,我们可以挑选出对预测生存状态最重要的变量。

## 3.2 使用gbm进行模型训练和调优

在数据预处理之后,接下来是模型训练和调优的阶段。这一阶段对于模型性能的影响至关重要。

### 3.2.1 模型训练的基本流程

模型训练流程应包括数据的准备、模型参数的设定、模型的训练以及初步性能评估。

**代码块展示与分析**:

```r

# 以“titanic”数据集为例

# 拟合一个基本的生存预测模型

titanic$Survived <- factor(titanic$Survived)

set.seed(123)

gbm.model <- gbm(Survived ~ ., data = titanic[,-ncol(titanic)],

distribution = "bernoulli",

n.trees = 1000,

shrinkage = 0.01,

interaction.depth = 3,

n.minobsinnode = 10,

cv.folds = 5)

# 模型性能评估

cv.error <- cv.gbm(gbm.model, method = "bernoulli",

data = titanic[,-ncol(titanic)],

n.trees = 1000,

interaction.depth = 3,

n.minobsinnode = 10,

shrinkage = 0.01,

cv.folds = 5,

verbose = FALSE)

print(cv.error)

```

在这段代码中,我们设置了`gbm`模型的参数,例如树的深度(`interaction.depth`)、学习速率(`shrinkage`)、节点的最小观测数(`n.minobsinnode`)等,并进行交叉验证来评估模型性能。

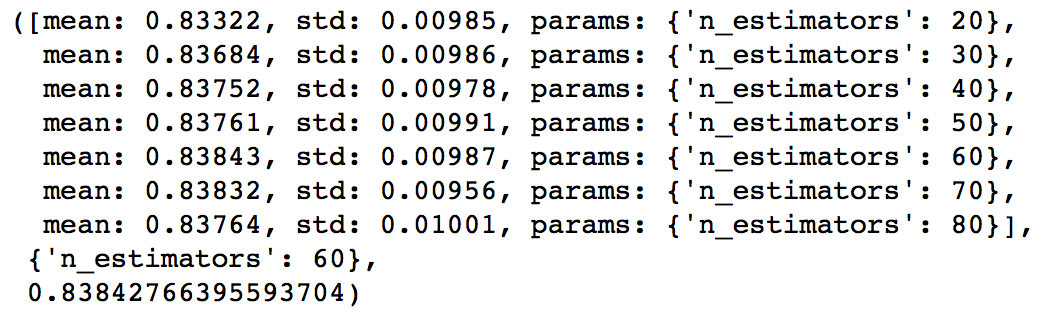

### 3.2.2 超参数调整与模型优化

超参数调整是模型优化的重要环节。合理的超参数可以大幅提高模型性能。

**mermaid流程图展示与分析**:

```mermaid

graph LR

A[开始] --> B[定义超参数范围]

B --> C[使用交叉验证评估模型]

C --> D{选择最佳参数}

D --> |是| E[重新训练模型]

D --> |否| F[修改超参数范围]

E --> G[模型验证与测试]

F --> C

G --> H[完成模型优化]

```

这个流程图说明了超参数调整的迭代过程。从定义超参数范围开始,通过交叉验证评估模型性能。如果找到了最佳参数,模型将被重新训练并进行验

0

0