PyTorch模型评估:如何选择最佳AI模型

发布时间: 2024-11-22 01:52:36 阅读量: 23 订阅数: 31

# 1. 模型评估的重要性

模型评估是机器学习与深度学习中的一个核心环节,其重要性不容忽视。在对一个模型进行训练后,如何有效地评价它的性能和泛化能力,直接决定了这个模型在实际应用中的可靠性和可行性。准确的模型评估不仅能够帮助我们识别模型中的问题和偏差,还可以指导我们进行进一步的模型优化和调参工作。因此,了解并掌握模型评估的理论和实践,对于数据科学家和机器学习工程师来说,是提升模型质量,实现业务目标的关键步骤。接下来的章节将深入探讨模型评估的基础理论、关键指标、以及在PyTorch等深度学习框架中的实际应用。

# 2. 评估指标的理论基础

## 2.1 分类问题的评价指标

### 2.1.1 准确率(Accuracy)

在分类问题中,准确率是最直观也是最容易理解的评价指标。它表示的是模型正确预测的样本数占总样本数的比例。尽管准确率在样本分布均匀的情况下是一个有效的评估指标,但在正负样本比例失衡的情况下,准确率可能会产生误导。

准确率的计算公式为:

```

Accuracy = (True Positives + True Negatives) / Total Samples

```

其中,`True Positives`(真正例)表示被模型正确预测为正类的样本数,`True Negatives`(真负例)表示被模型正确预测为负类的样本数,而`Total Samples`是所有样本的总数。

### 2.1.2 精确率(Precision)、召回率(Recall)与F1分数

精确率和召回率是两个互补的度量,它们共同构成了一个更全面的评价体系,特别适用于正负样本比例不均衡的情况。

精确率(Precision)是指被模型预测为正类的样本中,实际为正类的比例,计算公式如下:

```

Precision = True Positives / (True Positives + False Positives)

```

召回率(Recall),也称为真正例率(True Positive Rate, TPR),是指实际为正类的样本中,被模型正确预测为正类的比例,计算公式如下:

```

Recall = True Positives / (True Positives + False Negatives)

```

F1分数是精确率和召回率的调和平均值,是它们的综合评价指标,计算公式为:

```

F1 Score = 2 * (Precision * Recall) / (Precision + Recall)

```

### 2.1.3 混淆矩阵(Confusion Matrix)

混淆矩阵(Confusion Matrix)是一种更为细致的评价方法,它是一个表格,用于可视化模型的性能。在二分类问题中,混淆矩阵有四个部分:真正例(True Positives, TP)、假正例(False Positives, FP)、真负例(True Negatives, TN)和假负例(False Negatives, FN)。

混淆矩阵的结构如下:

| 预测\实际 | 正类 | 负类 |

|-----------|------|------|

| 正类 | TP | FP |

| 负类 | FN | TN |

通过对混淆矩阵的分析,可以更清楚地了解模型在分类上的表现,比如哪些类别容易被错误分类。

### 2.2 回归问题的评价指标

#### 2.2.1 均方误差(MSE)和均方根误差(RMSE)

均方误差(Mean Squared Error, MSE)和均方根误差(Root Mean Squared Error, RMSE)是回归问题中最常用的评价指标之一。MSE是对模型预测误差的平方的平均值,而RMSE是MSE的平方根。

MSE的计算公式为:

```

MSE = (1/N) * Σ(y_i - ŷ_i)²

```

其中,N是样本数量,y_i是真实值,ŷ_i是预测值。

RMSE是MSE的平方根,计算公式为:

```

RMSE = sqrt(MSE)

```

#### 2.2.2 R平方(R²)分数

R平方(R²)分数,也称为决定系数,是衡量回归模型拟合程度的一个指标。R²的值介于0和1之间,值越接近1,说明模型解释的变异越多。

R²分数的计算公式为:

```

R² = 1 - (SS_res / SS_tot)

```

其中,SS_res是残差平方和,SS_tot是总平方和。

#### 2.2.3 平均绝对误差(MAE)

平均绝对误差(Mean Absolute Error, MAE)是预测值与真实值之间差的绝对值的平均值。MAE对异常值的敏感度比MSE和RMSE要低,因为它取的是绝对值而不是平方。

MAE的计算公式为:

```

MAE = (1/N) * Σ|y_i - ŷ_i|

```

### 2.3 深度学习特有的评估方法

#### 2.3.1 概率评分

在深度学习中,模型输出的是概率值,而非简单的分类标签。概率评分关注于模型输出的概率分布是否与真实的分布一致。例如,交叉熵损失(Cross-Entropy Loss)是深度学习中评估概率输出的一种常用方法。

#### 2.3.2 蒙特卡罗交叉验证

蒙特卡罗交叉验证(Monte Carlo Cross-Validation)通过重复随机抽样构建训练集和测试集,来评估模型的稳定性。这种方法能够减少因数据集划分不同而导致的模型性能评估波动。

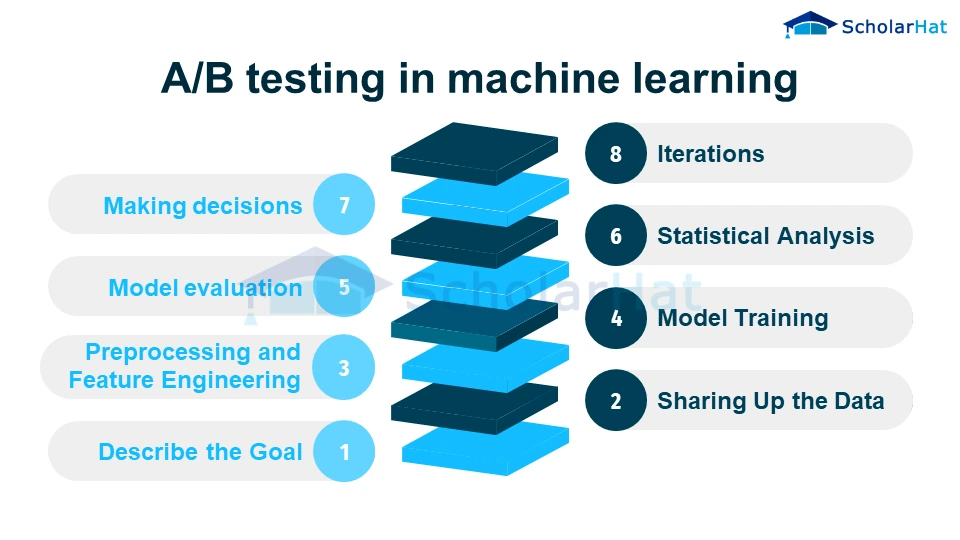

#### 2.3.3 A/B测试

A/B测试是评估模型在实际环境中表现的实验方法。通过将用户随机分为两组(A组和B组),分别给予不同的模型版本,来比较两种模型的表现差异。

### 2.4 本章小结

本章深入探讨了机器学习中评估模型性能的指标。从分类问题的准确率、精确率、召回率、F1分数和混淆矩阵,到回归问题的MSE、RMSE、R²分数和MAE,再到深度学习特有的概率评分、蒙特卡罗交叉验证和A/B测试,每一部分都详细解释了它们的定义、计算方法和应用场景。这些评估指标是模型优化过程中的重要参考,有助于我们深入了解模型的优劣,为后续的模型选择、调整和优化提供依据。

# 3. PyTorch中的模型评估实践

在前一章中,我们探讨了机器学习评估指标的理论基础,包括分类和回归问题的评价指标,以及深度学习特有的评估方法。本章将深入实践中,具体介绍在PyTorch框架下如何执行模型评估的实际操作步骤,包括数据处理、评估流程、结果分析以及优化策略。

## 3.1 数据集划分和批处理

在开始模型评估之前,正确处理数据集是一个必要的步骤。这一子章节将指导我们如何划分数据集,并实现批处理和数据加载,确保评估过程中数据的可用性和准确性。

### 3.1.1 划分训练集、验证集和测试集

数据集的划分对于机器学习模型的训练和评估至关重要。通常情况下,我们会将数据集划分为训练集、验证集和测试集三个部分。

```python

import torch

from sklearn.model_selection import train_test_split

# 假设data是包含输入特征和标签的张量

X = torch.tensor(...) # 输入特征张量

y = torch.tensor(...) # 标签张量

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 划分训练集和验证集

X_train, X_val, y_train, y_val = train_test_split(X_train, y_train, test_size=0.25, random_state=42)

```

### 3.1.2 实现批处理和数据加载

批处理(Batching)是训练深度学习模型时的常用技巧,它可以有效控制内存消耗,提高训练效率。

```python

from torch.utils.data import DataLoader, TensorDataset

# 将数据封装到TensorDataset中,以便于加载

train_data = TensorDataset(X_train, y_train)

val_data = TensorDataset(X_val, y_val)

test_data = TensorDataset(X_test, y_test)

# 定义批大小并创建DataLoader

batch_size = 64

train_loade

```

0

0