PyTorch混合精度训练:减少内存与加速模型训练的6种方法

发布时间: 2024-11-22 02:15:51 阅读量: 42 订阅数: 31

量化加速-基于Pytorch+TVM进行低精度+混合精度的量化感知训练-附项目源码-优质项目实战.zip

# 1. PyTorch混合精度训练概述

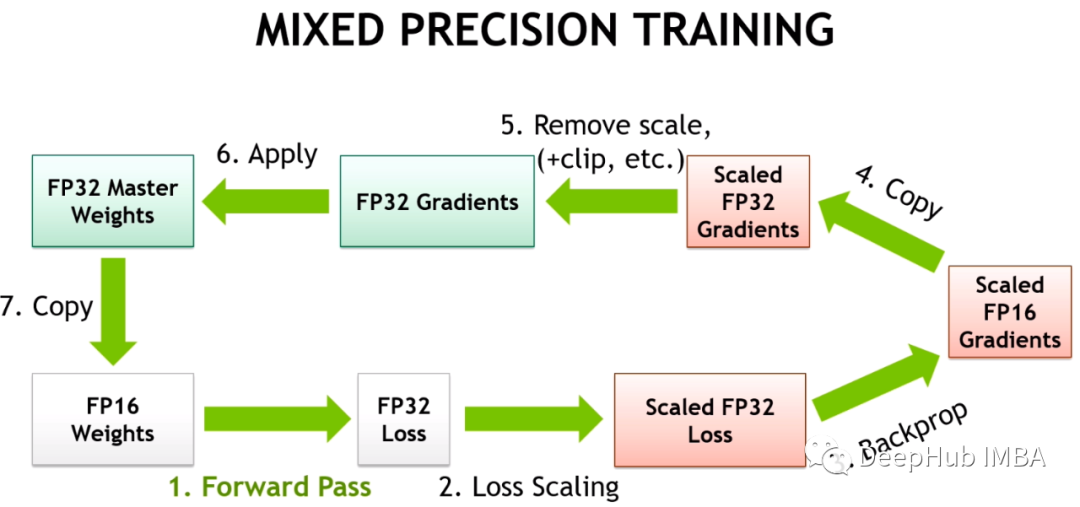

在深度学习模型的训练过程中,精度是指数值计算的准确度,影响模型的性能和训练速度。传统的训练方法多采用单精度浮点数(FP32),而随着硬件和算法的进步,混合精度训练作为一种新兴技术,已经成为优化深度学习训练过程的重要手段。在本章节中,我们将探讨混合精度训练的基本概念,以及它在PyTorch框架下的实现。

混合精度训练涉及到将模型的一部分数值精度从FP32降低到半精度浮点数(FP16),这在保持模型性能的同时能够显著减少内存占用,加快计算速度,并减少能耗。这一过程需要在保证数值稳定性的前提下进行,因此需要对训练过程中的数值范围进行合理的管理。

本章节将为读者提供对混合精度训练的初步认识,并为接下来深入探讨混合精度训练的理论基础、实践操作、优化策略和案例分析等章节内容打下基础。

# 2. 混合精度训练的基础理论

## 2.1 深度学习中的数值精度

### 2.1.1 单精度与双精度浮点数

在计算机中,浮点数是用于表示实数的一种数据类型,允许进行数学运算。浮点数的表示方式在深度学习训练过程中至关重要,因为它决定了模型的数值计算精度和模型参数所占用的内存大小。单精度浮点数(float32)使用32位(4个字节)来存储数值,而双精度浮点数(float64)则使用64位(8个字节)。

在PyTorch等深度学习框架中,默认的数据类型是float32,它足够应对绝大多数场景的数值精度需求。然而,随着深度学习模型变得越来越复杂,其参数量和计算量也在指数级增长。这导致对内存和计算资源的需求也随之激增,为了缓解这一问题,研究者们开始探索使用较低精度的数据类型。

### 2.1.2 混合精度训练的科学依据

混合精度训练(Mixed Precision Training)是一种策略,它结合了单精度(float32)和半精度(float16)浮点数来执行神经网络的训练。浮点数的精度不同,表示的数值范围和精度也不一样,float16能提供的数值范围比float32小,但是因为其占用的空间小,所以可以减少模型的内存占用,并提高计算效率。

混合精度训练的科学依据在于,虽然神经网络的大部分操作可以有效地在低精度下执行,但是某些操作(如归一化、权重更新)仍然需要较高的精度以避免数值不稳定。混合精度训练通过在float16和float32之间切换,平衡了精度和性能之间的关系。

## 2.2 混合精度训练的优势

### 2.2.1 内存使用的优化

使用混合精度训练的一个明显优势是内存使用量的大幅减少。由于float16占用的内存仅为float32的一半,这意味着在保持相同模型大小的情况下,可以将训练过程中的内存占用减少到接近50%。对于拥有大量参数的深度神经网络来说,这一优化显得尤为重要,因为它们往往受限于GPU的可用内存。

减少内存使用不仅意味着可以训练更大的模型,还可能使得单个GPU能够承担原本需要多GPU分布式训练才能完成的任务。这不仅简化了训练过程,还有助于减少硬件资源的开销。

### 2.2.2 训练速度的提升

混合精度训练的另一个优势是训练速度的显著提升。这一提升来自于两个主要方面:一是内存使用减少导致的更快的内存访问速度,二是许多现代GPU专门优化了对float16数据类型的计算性能,例如NVIDIA的Tensor Core技术,这使得float16的计算速度可以比float32更快。

通过减少模型的内存占用,GPU可以执行更多的操作而无需等待内存交换,这在数据传输受限的场合尤为重要。同时,利用特定硬件加速的float16计算能力,可以在训练过程中实现更高的吞吐量,从而缩短模型的训练时间。

## 2.3 混合精度训练的挑战

### 2.3.1 硬件支持要求

混合精度训练虽然有诸多好处,但它的实现依赖于硬件的特定支持。目前,许多现代GPU如NVIDIA的V100、A100以及AMD的Radeon Instinct系列等都支持float16计算,并对float16数据类型有优化。但是,并非所有的硬件平台都提供这样的支持,特别是在一些入门级或旧设备上可能不具备浮点数混合精度的能力。

开发者在采用混合精度训练前,必须确认所使用的硬件环境是否满足条件。如果硬件不支持float16的优化计算,则可能无法获得混合精度带来的性能增益,甚至有可能影响训练的稳定性。

### 2.3.2 算法稳定性和数值问题

尽管混合精度训练可以带来性能上的提升,但它也引入了新的数值稳定性问题。当使用float16时,可能会因为数值范围过小导致的数值溢出或下溢问题,这会影响到训练过程中的梯度更新,甚至可能造成模型训练失败。

为了应对这些数值问题,混合精度训练算法通常会结合使用一个动态的缩放因子(比如通过loss scaling技术),用来放大loss值以防止在反向传播过程中发生数值溢出。这种缩放技术在实践中被证明是有效的,但也需要开发者仔细调整以保证训练过程的稳定性和收敛性。

# 3. PyTorch中的混合精度训练实践

## 3.1 PyTorch的自动混合精度API

在深度学习的发展历程中,硬件的限制与算法的创新一直在相互作用。为了提高模型训练的效率和速度,混合精度训练(Mixed-Precision Training, MPT)成为了优化训练过程的重要手段。PyTorch作为深度学习领域广泛使用的框架之一,提供了强大的自动混合精度API,让研究者和开发者能够轻松实现混合精度训练。

### 3.1.1 使用`torch.cuda.amp`模块

`torch.cuda.amp`是PyTorch提供的自动混合精度训练模块。它利用自动微分和Tensor核心(如果硬件支持)来加速模型训练。该模块的核心是一个叫做GradScaler的类,它用于处理混合精度训练中的梯度缩放问题。以下是使用`torch.cuda.amp`模块的基本步骤:

```python

import torch

from torch.cuda.amp import autocast, GradScaler

# 定义模型和优化器

model = ...

optimizer = ...

# 初始化GradScaler

scaler = GradScaler()

for input, target in data:

optimizer.zero_grad(set_to_none=True)

# 模型前向传播

with autocast():

output = model(input)

loss = loss_function(output, target)

# 反向传播和优化

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

```

在这个过程中,`autocast`上下文管理器会自动将计算包装在适当精度的Tensor核心操作中,而`GradScaler`负责梯度的放大和缩小。

### 3.1.2 模型和优化器的混合精度封装

在实现自动混合精度训练时,将模型和优化器封装在一起可以简化操作。通过`autocast`上下文管理器,可以透明地在模型的正向传播中应用混合精度计算。对于优化器,使用`scale_loss`函数来确保损失函数是按照混合精度进行反向传播。

```python

for input, target in data:

optimizer.zero_grad(set_to_none=True)

with autocast():

output = model(input)

loss = loss_function(output, target)

# 使用scale_loss确保使用正确的精度进行梯度更新

scaled_loss = scaler.scale(loss)

scaled_loss.backward()

scaler.step(optimizer)

scaler.update()

```

## 3.2 实现自定义混合精度训练

虽然PyTorch提供了方便的自动混合精度API,但在某些特定情况下,开发者可能需要手动实现混合精度训练。通过更深入地理解GradScaler的工作机制,可以自定义梯度缩放和更新过程。

### 3.2.1 手动实现GradScaler和Loss Scaling

手动实现混合精度训练要求开发者精确控制梯度缩放和更新。以下是手动实现GradScaler的一个例子:

```python

import

```

0

0