PyTorch混合精度训练高级指南:动态损失缩放与性能优化

发布时间: 2024-12-12 06:59:53 阅读量: 11 订阅数: 13

使用PyTorch实现的源代码项目:解锁VIP资源的高级应用与实战指南.pdf

# 1. 混合精度训练和PyTorch概述

在现代深度学习的发展中,混合精度训练已成为加速模型训练并减少资源消耗的关键技术。随着GPU计算能力的大幅提升,越来越多的研究和应用开始采用混合精度训练来优化性能。而PyTorch作为当前最流行的深度学习框架之一,提供了强大的工具和接口以支持这一技术。

## 1.1 PyTorch和混合精度训练的关系

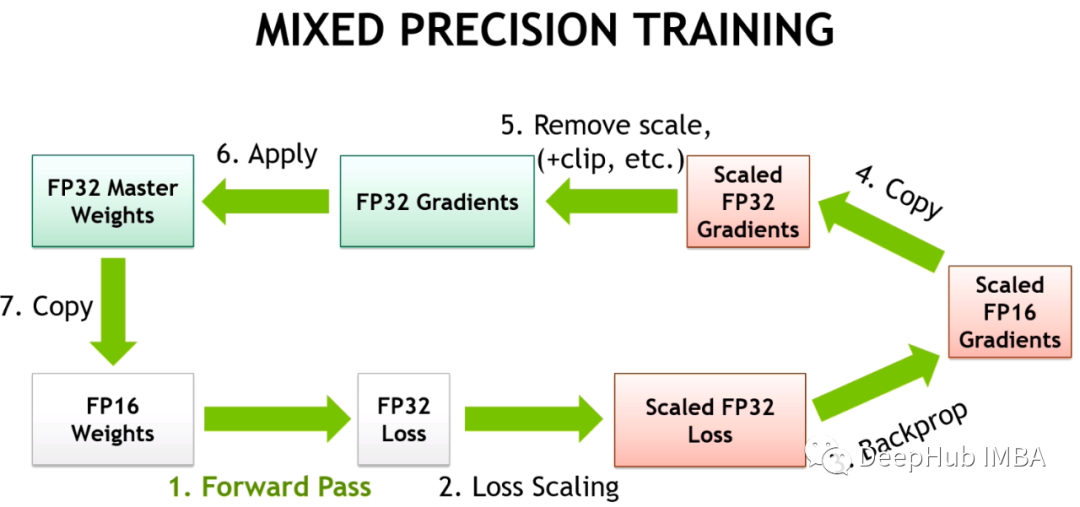

PyTorch的灵活性和动态计算图特性让它在研究和工业界都获得了广泛的应用。混合精度训练的实现依赖于PyTorch中的数值计算精度调整工具。混合精度训练通过使用16位浮点数(如FP16)代替32位浮点数(如FP32)进行模型参数更新和计算,能够显著减少内存占用并加快训练速度,这一点对大规模模型尤其重要。

## 1.2 混合精度训练的必要性和优势

在某些情况下,完全使用FP32进行训练会面临内存限制和计算效率低下等问题。混合精度训练正好可以克服这些缺陷。它不仅提高了训练效率,还降低了对硬件的要求,使得在相同的资源条件下能够实现更大的模型训练。这在优化GPU利用率和减少训练时间方面表现出显著优势,特别是对于如BERT、GPT等大型预训练模型的训练场景。

接下来,我们将深入探讨PyTorch中混合精度训练的具体实现,以及如何有效地应用这一技术。

# 2. PyTorch中的混合精度训练基础

## 2.1 浮点数表示和精度概念

### 2.1.1 单精度和双精度的区别

在计算机科学中,浮点数表示是一种用于存储实数的方法,它使得机器能够处理非整数的数。在深度学习和PyTorch的混合精度训练中,浮点数的表示尤为重要,因为它直接影响到模型训练的精度和速度。

单精度浮点数(FP32)是一种常见的数据类型,占用4个字节的存储空间,能提供约7位十进制的精度。双精度浮点数(FP64)则需要8个字节,提供约16位十进制的精度。在深度学习中,FP64提供了比FP32更高的精度,但同样也需要更多的计算资源。

FP32在大多数机器学习和深度学习算法中已经被认为是一个良好的精度平衡点。然而,混合精度训练通过使用FP16(半精度)浮点数,可以在保持模型精度的同时减少内存使用和加速计算。

### 2.1.2 混合精度训练的优势

混合精度训练结合了FP32和FP16(或更小的位数,如Tensor Core加速的FP16)的优点,用以提高模型训练速度和效率,同时减少内存消耗。FP16是一种较小的浮点格式,占用的空间比FP32少,因而能够更快地在GPU上处理,它在现代的NVIDIA GPU架构(如Volta, Turing, Ampere等)上通过Tensor Cores得到了硬件加速支持。

使用混合精度训练的几个优势包括:

1. **减少显存消耗**:使用FP16可以将模型和激活的显存占用减少到一半,这允许更大的batch size或更复杂的模型在有限的GPU资源下训练。

2. **加快计算速度**:FP16通常能提高模型训练的吞吐量,因为每个操作需要更少的计算时间和能量。

3. **提升训练效率**:在某些情况下,结合动态损失缩放,混合精度训练可以加速收敛速度,使得训练过程更有效。

## 2.2 PyTorch中的自动混合精度(AMP)

### 2.2.1 AMP的工作原理

自动混合精度(AMP)是一种技术,它允许混合使用不同精度的数据类型来提高训练速度和效率。在PyTorch中,AMP使用上下文管理器和装饰器来自动识别并运行能够以较低精度执行的算子,从而减少内存占用并加速模型的训练。

AMP主要工作原理是利用两种类型的运算:FP16和FP32。FP16运算速度快,内存占用小,但可能会在数值上丢失精度;而FP32运算慢,占用内存大,但精度高。AMP利用了FP16的高速运算,同时监控数值稳定性,一旦检测到可能丢失太多精度的情况,就会自动切换回FP32运算以保证数值精度。

### 2.2.2 在PyTorch中启用AMP

在PyTorch中启用AMP十分直接,可以通过一个简单的上下文管理器`torch.cuda.amp`来实现。这个管理器将监控计算,并在需要时自动地使用FP32来执行操作。

以下是一个简单的示例,展示如何在PyTorch中启用AMP:

```python

import torch

from torch.cuda.amp import autocast, GradScaler

# 假设我们有一个模型和数据

model = ... # 初始化你的模型

optimizer = ... # 初始化你的优化器

data = ... # 加载你的数据

target = ... # 加载你的目标值

# 初始化GradScaler用于自动缩放梯度

scaler = GradScaler()

# 训练循环

for iter in range(num_iterations):

optimizer.zero_grad()

# 正向传播:使用autocast自动选择合适的精度

with autocast():

output = model(data)

loss = loss_function(output, target)

# 反向传播:首先缩放loss

scaler.scale(loss).backward()

# 更新权重:然后缩放梯度并执行优化步骤

scaler.step(optimizer)

scaler.update()

```

在这个示例中,`autocast()`上下文管理器将自动决定哪些操作在FP16下运行,而`GradScaler`用于处理可能的梯度爆炸问题。

## 2.3 动态损失缩放技术

### 2.3.1 损失缩放的作用和重要性

动态损失缩放是混合精度训练中的一个重要技术,它可以帮助避免在训练过程中发生数值下溢(梯度消失)问题,特别是在使用FP16数据类型时。由于FP16的表示范围比FP32窄,数值下溢的问题更加常见。

在训练深度神经网络时,模型的目标函数(损失函数)通常会随着迭代次数的增加而减小。当损失值变得太小的时候,它可能会落入FP16的数值下限之外,导致梯度更新变得不准确或完全丢失(称为梯度消失问题)。动态损失缩放通过放大损失函数的值来应对这一问题,保证在FP16中梯度仍然保持有效的数值范围。

### 2.3.2 实现动态损失缩放的方法

实现动态损失缩放的一种常见方法是在训练循环中动态地调整损失值。在PyTorch中,可以通过使用`GradScaler`类来实现这一点,该类能够根据梯度的大小自动调整损失函数的比例。下面展示了一个具体的例子:

```python

scaler = GradScaler(init_scale=65536.0, growth_factor=2.0, backoff_factor=0.5, growth_interval=2000)

```

这里,`GradScaler`初始化参数的意义如下:

- `init_scale` 是初始的缩放因子。

- `growth_factor

0

0