揭秘混合精度训练:提升PyTorch深度学习效率的关键原理及应用

发布时间: 2024-12-12 06:38:16 阅读量: 17 订阅数: 13

PyTorch深度学习入门手册:PyTorch深度学习常用函数库解析及其应用指南

# 1. 混合精度训练概述

在当今的数据科学领域,深度学习模型的训练是一个计算密集型的过程。随着模型变得更加复杂,对计算资源的需求也随之增加,这促使研究人员和工程师寻找提升计算效率的方法。混合精度训练是一种在训练过程中同时使用两种不同浮点精度(如FP16和FP32)的技术,旨在加速训练过程并降低内存消耗,同时尽可能保持模型的精度。本章将对混合精度训练做一个基本介绍,为接下来的章节内容打下基础。我们将概述混合精度训练的动机、核心概念以及它如何帮助优化深度学习工作流程。

# 2. 混合精度训练的理论基础

在了解了混合精度训练的广阔应用场景之后,我们有必要深入其理论基础。混合精度训练技术的原理涉及到计算机科学、机器学习和硬件架构等多个领域。本章将分小节介绍与混合精度训练相关的理论知识,包括精度和浮点数表示、混合精度训练的原理以及它的优势。

## 2.1 精度和浮点数表示

了解浮点数表示是理解混合精度训练的关键。在计算机中,浮点数是用于表示实数的一种方式,而精度指的是计算结果的正确性或精确度。

### 2.1.1 单精度和双精度的区别

单精度浮点数(FP32)和双精度浮点数(FP64)是深度学习中常见的两种浮点数表示方法。FP32使用32位(4字节)来存储浮点数,而FP64使用64位(8字节)。具体来说,FP32和FP64在以下方面存在差异:

- **表示范围**:FP64能够表示的数值范围比FP32广,因为它有更宽的指数范围。

- **精度**:FP64相比FP32拥有更高的小数精度,能够减少四舍五入的误差。

这种差异使得在深度学习中,训练大模型时往往倾向于使用FP64以避免数值不稳定性,但FP64的计算开销远大于FP32。

### 2.1.2 浮点数的计算机表示

计算机使用IEEE标准来表示浮点数。一个标准的32位浮点数由三部分构成:符号位(1位)、指数位(8位)和尾数位(23位)。同样的,64位浮点数由符号位(1位)、指数位(11位)和尾数位(52位)组成。

具体浮点数的值计算公式为:

\[ (-1)^{符号位} \times 1.尾数位 \times 2^{(指数位 - 127)} \]

对于64位浮点数,计算公式是:

\[ (-1)^{符号位} \times 1.尾数位 \times 2^{(指数位 - 1023)} \]

这说明了在表示相同数值时,由于指数位和尾数位的差异,FP32的精度天然地低于FP64。为了在保持计算性能的同时,尽可能地减少精度损失,混合精度训练应运而生。

## 2.2 混合精度训练的原理

混合精度训练基于一种观察:在深度学习模型的训练过程中,并非所有操作都需要高精度(如FP64)来保证模型性能。许多操作使用较低精度(如FP16)也不会对最终模型的性能产生显著的负面影响。

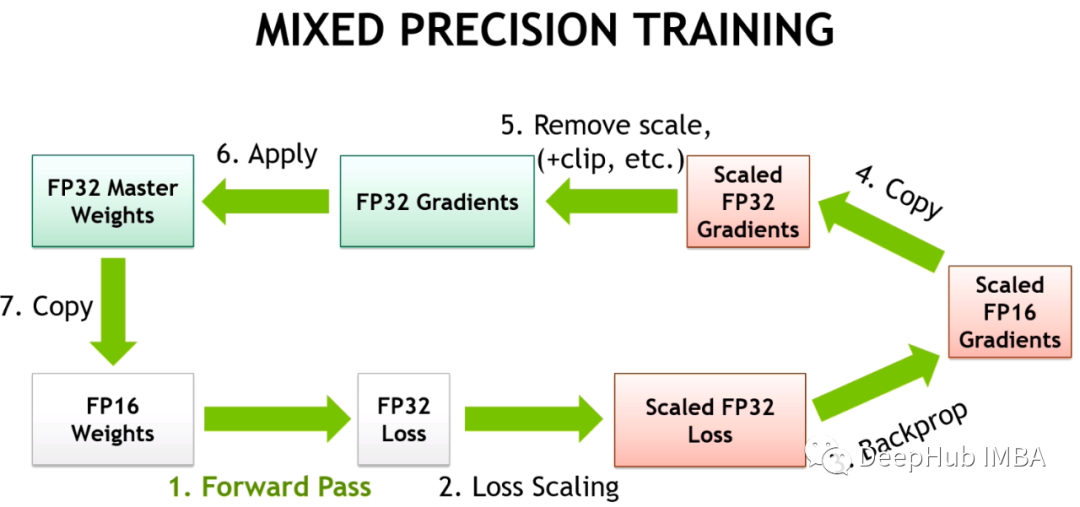

### 2.2.1 FP16与FP32的结合策略

混合精度训练的核心策略是将FP16与FP32结合起来使用。FP16的使用能够显著减少内存占用和提高计算效率,但是直接使用FP16可能会导致数值下溢和上溢问题。

一个常见的结合策略是:

1. 使用FP16进行前向传播和反向传播中的部分操作。

2. 在进行权重更新之前将FP16数据转换为FP32以避免数值稳定性问题。

3. 保存FP32的模型权重,以确保训练的稳定性和准确性。

这种策略能够有效利用FP16带来的性能提升,同时避免使用纯FP16训练时可能出现的问题。

### 2.2.2 梯度缩放与损失缩放技术

在混合精度训练中,梯度缩放和损失缩放是两种重要的技术。梯度缩放技术通过增加损失函数来避免梯度消失的问题,而损失缩放是通过将损失乘以一个缩放因子来防止梯度在FP16中的下溢。

这些技术的核心在于找到一个平衡点,使得数值在FP16的表示范围内尽可能准确,同时在反向传播时减少数值不稳定和溢出的风险。下面是具体的操作示例:

```python

# 假设我们有一个损失函数loss,其类型为FP16

loss = loss * scaling_factor # 使用损失缩放

```

其中,`scaling_factor`是一个超参数,通常设置为2的幂次方以减少计算复杂度。

## 2.3 混合精度训练的优势

混合精度训练不仅能够加速模型训练,还能够在保证模型性能的前提下减少内存消耗。

### 2.3.1 计算效率的提升

使用FP16相较于FP32,可以使得模型训练速度提升一倍以上。因为FP16的存储空间更小,能够一次加载更多数据到GPU中,减少了内存带宽的压力。同时,由于现代GPU如NVIDIA的Volta架构专为FP16设计了大量优化,因此能够提供更高的算力。

### 2.3.2 内存消耗的降低

混合精度训练显著减少了内存的需求,对于大规模模型来说,这一点尤为重要。通过减少内存使用,可以允许更大的批量大小进行训练,这样能够加速收敛并提升模型的泛化能力。

通过这些原理和策略,混合精度训练在保留了模型训练精度的同时,实现了计算性能和内存效率的双重提升。混合精度训练在许多实际应用中已经成为提高效率和减少成本的重要手段。下一章,我们将介绍混合精度训练在PyTorch框架中的具体实现。

# 3. 混合精度训练在PyTorch中的实现

混合精度训练是一种在深度学习训练过程中同时使用不同精度数值来加快训练速度和减少内存使用的技术。本章节将深入探讨如何在PyTorch深度学习框架中实现混合精度训练。

## 3.1 PyTorch的自动混合精度模块

PyTorch提供了一个自动混合精度(Automatic Mixed Precision, AMP)模块,允许开发者通过简单的API调用来启用混合精度训练。这个模块是实现混合精度训练的基础。

### 3.1.1 AMP的启用和配置

要启用AMP,我们需要导入`torch.cuda.amp`模块,并在训练循环中使用`GradScaler`来管理缩放。下面是一个简单的例子:

```python

import torch

from torch.cuda.amp import autocast, GradScaler

# 初始化模型和优化器

model = ...

optimizer = ...

# 初始化GradScaler

scaler = GradScaler()

for input, target in data:

optimizer.zero_grad()

# 自动混合精度上下文管理器

with autocast():

output = model(input)

loss = criterion(output, target)

# 使用scaler进行缩放梯度和执行优化步骤

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

```

在上述代码中,`autocast()`上下文管理器确保模型的前向传播使用FP16,而`scaler.scale()`用于缩放损失,以防止在低精度下可能出现的数值不稳定性。

### 3.1.2 动态损失缩放的原理和实践

动态损失缩放(Dynamic Loss Scaling)是一种用于提高训练稳定性的技术。它通过在每一步将损失乘以一个缩放因子来实现。这个因子通常远大于1,确保在反向传播之前损失保持一个较高的数值级别,从而避免梯度下溢。

```python

# 损失缩放因子通常初始化为2的幂次,例如2^16

initial_scale = 2**16

# 在训练循环中,根据需要更新缩放因子

# 使用scaler来自动管理缩放因子

scaler.scale(loss).backward()

scaler.unscale_(optimizer)

```

在实践中,如果检测到梯度下溢,`GradScaler`会降低损失缩放因子;如果检测到梯度上溢,则提高缩放因子。这个动态调整过程帮助在混合精度训练中维持稳定的梯度流动。

## 3.2 混合精度训练的代码实践

要实施混合精度训练,需要对现有的训练代码进行适度修改。本节将探讨如何修改基础模型以及采用哪些批量处理和梯度累积策略来适应混合精度。

### 3.2.1 基础模型的修改

在PyTorch中,大部分操作默认已经支持自动混合精度。如果需要对模型进行手动修改,主要集中在自定义操作上。例如,如果自定义了某些层或操作,需要确保它们在FP16上也可以正常工作。

```python

# 示例:自定义层

class CustomLayer(torch.autograd.Function):

@staticmethod

def forward(ctx, input):

# 确保输入是FP16类型

assert input.dtype == torch.float16, "Expected input to be FP16"

# 实现前向传播

output = ...

return output

@staticmethod

def backward(ctx, grad_output):

# 实现反向传播

input_grad = ...

return input_grad

# 模型中使用自定义层

class MyModel(nn.Module):

def forward(self, x):

x = CustomLayer.apply(x)

return x

```

在此代码中,`CustomLayer`的前向和反向传播方法都需要确保以FP16格式处理输入和输出。

### 3.2.2 批量处理和梯度累积策略

使用混合精度训练时,可能需要调整批量大小以保持数值稳定性。此外,梯度累积是另一种常用技术,用于处理无法在单个迭代中完整容纳的数据集。

```python

batch_size = 64

accumulation_steps = 2

for input, target in data:

input = input[:batch_size]

target = target[:batch_size]

optimizer.zero_grad()

output = model(input)

loss = criterion(output, target)

loss = loss / accumulation_steps

# 每经过accumulation_steps次迭代,执行一次反向传播

loss.backward()

if (it + 1) % accumulation_steps == 0:

optimizer.step()

```

以上代码中,我们首先调整批量大小来适应混合精度训练,并通过累积梯度的方式确保模型得到正确的更新。这在处理大批次数据时尤其有用。

## 3.3 混合精度训练的调试技巧

混合精度训练虽然能提高训练效率,但同时也带来了调试的复杂性。以下部分介绍了错误诊断和性能监控的技巧。

### 3.3.1 错误诊断和解决方案

混合精度训练可能导致一些难以捉摸的错误,特别是数值下溢或上溢。在使用AMP时,可能需要处理`NaN`或`Inf`值。

```python

try:

# 训练代码

except RuntimeError as e:

if 'out of memory' in str(e):

print('CUDA out of memory')

torch.cuda.empty_cache()

elif 'invalid argument' in str(e):

# 处理数值问题

pass

else:

raise

```

在此代码段中,我们尝试捕获并处理潜在的运行时错误,如内存溢出或无效参数错误。对于数值问题,我们可能会选择忽略或采取其他措施。

### 3.3.2 性能监控和分析工具

PyTorch提供了一些工具来监控和分析训练性能。比如使用`torch.cuda.synchronize()`来同步CUDA操作,以确保正确测量时间。

```python

from torch.cuda import Event, time

event_start = Event(enable_timing=True)

event_end = Event(enable_timing=True)

# 开始测量时间

event_start.record()

# 执行操作

output = model(input)

# 结束测量时间

event_end.record()

torch.cuda.synchronize()

print('Time elapsed: ', event_start.elapsed_time(event_end), 'ms')

```

在这段代码中,我们使用`Event`类来记录和计算操作执行的时间。此外,PyTorch还提供了`torch.autograd.profiler`模块,可以用于分析模型中各层的执行时间,从而找出性能瓶颈。

通过本章节的介绍,我们深入理解了如何在PyTorch中实现混合精度训练。下一章将通过具体应用案例来展示混合精度训练在不同任务中的有效性。

# 4. 混合精度训练的应用案例分析

在深度学习领域,混合精度训练的应用已经十分广泛,它不仅提升了训练效率,也降低了资源的消耗,同时仍然保持了模型的性能。在本章中,我们将深入探讨混合精度训练在不同领域的应用案例,包括计算机视觉、自然语言处理,以及跨领域的强化学习和多任务学习。

## 在计算机视觉任务中的应用

计算机视觉是深度学习应用最为广泛的领域之一,混合精度训练在该领域中同样发挥了巨大的作用。

### 图像分类模型的案例

在图像分类任务中,模型需要处理海量的图片数据,并从中识别出相应的类别。以ResNet50模型为例,通过引入混合精度训练,可以在不牺牲太多精度的情况下显著加速模型的训练速度。

**代码实现片段:**

```python

import torch

from torchvision.models import resnet50

from torch.cuda.amp import autocast

# 加载预训练模型

model = resnet50(pretrained=True)

model.train()

# 模型转换为AMP支持模式

model = model.cuda().half() # 将模型权重转换为FP16

# 损失函数

criterion = torch.nn.CrossEntropyLoss().cuda().half()

# 优化器

optimizer = torch.optim.Adam(model.parameters(), lr=1e-3)

# AMP自动混合精度上下文管理器

for data, target in dataloader:

optimizer.zero_grad()

with autocast():

output = model(data)

loss = criterion(output, target)

# 反向传播

optimizer.backward(loss)

# 更新权重

optimizer.step()

```

**参数说明和逻辑分析:**

在上述代码片段中,首先导入了必要的模块,然后加载并训练了一个ResNet50模型。通过`model.cuda().half()`,模型的权重和输入数据都被转换为FP16格式以进行混合精度训练。在`autocast`上下文管理器中,模型的前向传播是用FP16执行的,而损失函数仍然计算在FP32上,从而保证了梯度计算的精度。此外,优化器和损失函数都放置在GPU上,并使用`.half()`方法设置为FP16精度。

### 目标检测与分割模型的案例

除了图像分类之外,目标检测和分割也是计算机视觉中不可或缺的两个重要任务。以YOLOv3和U-Net模型为例,混合精度训练不仅有助于提高这些模型的训练速度,还能够在一定程度上减少内存消耗。

## 在自然语言处理任务中的应用

自然语言处理(NLP)领域也受益于混合精度训练。下面我们将深入探讨这一领域中的应用案例。

### NLP模型的优化策略

以BERT模型为代表的Transformer架构在NLP中取得了巨大的成功。但这些模型的训练时间和资源消耗非常巨大。通过采用混合精度训练技术,BERT的训练时间可以大大缩短。

**代码实现片段:**

```python

from transformers import BertForSequenceClassification

from transformers import BertTokenizer

from torch.cuda.amp import GradScaler

# 加载预训练模型和分词器

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

# 准备数据

inputs = tokenizer("Hello, my dog is cute", return_tensors="pt")

outputs = model(**inputs)

# 初始化GradScaler

scaler = GradScaler()

# 模型转换为AMP支持模式

model = model.cuda().half()

for epoch in range(num_epochs):

for batch in dataloader:

inputs = {k: v.to(device).half() for k, v in batch.items()}

outputs = model(**inputs)

# 损失计算

loss = outputs.loss

# 梯度缩放、反向传播和优化器步骤

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

# 清零梯度

optimizer.zero_grad()

```

**参数说明和逻辑分析:**

在这段代码中,我们首先导入了`BertForSequenceClassification`模型和`BertTokenizer`。接着,我们准备了一些输入数据,并开始训练循环。模型被转换为FP16模式并放置在GPU上。通过`GradScaler`进行梯度的缩放,这有助于稳定FP16训练中的梯度更新。通过这种方式,BERT模型能够以更快的速度进行训练,而不会失去太多的准确性。

### BERT等预训练模型的案例

混合精度训练不仅加速了BERT模型的微调过程,而且在训练整个预训练模型时也带来了显著的速度提升。通过混合精度训练,研究者们可以在较短的时间内完成大规模模型的训练。

## 跨领域的混合精度实践

混合精度训练技术不仅在特定领域有应用,它还被广泛应用于跨领域的深度学习任务。

### 强化学习模型的案例

在强化学习中,混合精度训练同样可以缩短训练时间,提高效率。以深度Q网络(DQN)为例,在训练过程中使用混合精度可以显著提高学习速度。

### 多任务学习和元学习的案例

多任务学习和元学习是深度学习的前沿方向,混合精度训练使得这些复杂模型的训练变得可行。

## 本章小结

混合精度训练已经广泛应用于计算机视觉和自然语言处理等深度学习领域。它通过优化计算资源的使用,既提高了训练效率,又保持了模型的性能。在本章中,我们详细探讨了混合精度训练在不同领域的应用案例,并通过实际代码片段展示了它的具体实现方法。在下一章,我们将深入分析混合精度训练的优化与扩展,探索它在深度学习领域的未来发展方向。

# 5. 混合精度训练的优化与扩展

混合精度训练不仅仅是一种技术手段,它还涉及到优化与扩展的问题。在本章节中,我们将深入探讨如何对混合精度训练进行进阶优化,以及这种训练方式如何在深度学习框架中得到更广泛的支持。此外,我们还将展望其未来的发展方向。

## 5.1 进阶优化技术

优化混合精度训练是一个不断演进的过程。它包括算法级别的改进和硬件级别的支持,两者相辅相成。下面将详细讨论混合精度训练的两种进阶优化技术。

### 5.1.1 算子级别的混合精度优化

在深度学习中,算子(Operator)是构成模型的基础运算单元。进行算子级别的混合精度优化意味着我们需要针对特定的算子,优化其执行效率和精度保持。这种优化通常要求深入理解各种算子在不同精度下的计算特性,并找到一种平衡计算效率和数值精度的方法。

在实践上,这可能包括:

- 为特定的算子设计优化的FP16版本,它们在保证精度的同时提高了运行速度。

- 评估不同算子的精度损失,决定是否需要在特定的上下文中使用FP32,或者通过损失缩放来维持训练的稳定性。

例如,对于矩阵乘法和卷积这类计算密集型的算子,由于它们通常可以很好地适应低精度运算,因此可以优先考虑在FP16下实现。而对于涉及归一化或激活函数等关键步骤的操作,则需要更加小心,确保在精度下降和数值稳定性之间找到平衡点。

### 5.1.2 自定义自动混合精度策略

虽然现代深度学习框架如PyTorch和TensorFlow已经提供了自动混合精度(AMP)支持,但许多情况下这些通用策略可能无法完全满足特定模型或应用场景的需求。为了实现更加高效的混合精度训练,开发者需要有能力自定义AMP策略。

自定义AMP策略通常包括:

- 开发者可以自定义哪些层使用FP16运算,哪些层仍然使用FP32。

- 实现精细的梯度缩放逻辑,以防止在训练过程中出现数值爆炸或消失的问题。

- 调整和优化批处理大小、学习率等超参数,以最大化模型性能。

代码示例:

```python

from transformers import BertModel, BertTokenizer, AdamW

from torch.cuda.amp import autocast

model = BertModel.from_pretrained('bert-base-uncased')

optimizer = AdamW(model.parameters(), lr=1e-5)

# 自定义AMP的上下文管理器

with autocast():

# 前向传播,模型将在FP16精度下运行

outputs = model(input_ids, attention_mask=attention_mask)

loss = outputs.loss

# 反向传播,梯度将在AMP下自动缩放

optimizer.backward(loss)

# 优化器步骤,参数更新

optimizer.step()

```

上述代码块中,我们使用了`autocast`上下文管理器来自动管理混合精度训练中的精度缩放。开发者可以根据模型和任务的不同需要,对这一过程进行调整和优化。

## 5.2 混合精度训练的未来发展

随着硬件性能的提升和深度学习框架的不断优化,混合精度训练的未来充满了无限可能。在这一部分中,我们将探讨硬件和软件两个方面的未来支持。

### 5.2.1 新硬件对混合精度的支持

现代GPU和TPU等硬件已经为混合精度计算提供了良好的支持,新的硬件架构正在不断地改进,以进一步提高混合精度训练的效率。

- GPU厂商如NVIDIA不断推出支持更高级别混合精度(例如FP8)的硬件,同时也在提升AI优化的性能。

- Google的TPU在最新的版本中也加入了对混合精度计算的优化,旨在提升模型训练速度。

这些硬件的发展对混合精度训练来说是一个巨大的利好消息,开发者们可以期待在未来的硬件平台上实现更高效的训练。

### 5.2.2 混合精度训练的深度学习框架支持

深度学习框架如PyTorch和TensorFlow也在不断地更新和改进,以更好地支持混合精度训练。这一支持不仅仅局限于加入新的API,还包括了对训练过程中各种异常情况的处理、更好的调试工具以及对硬件特性的更好集成。

例如,PyTorch通过其`torch.cuda.amp`模块提供了一套完整的API,用以管理混合精度训练中的精度转换。在新版的PyTorch中,开发者们还可以期待看到更多的调试工具和性能提升的特性。

此外,框架级别的支持还意味着对自定义层和复杂模型的混合精度训练提供了更好的工具和接口,从而降低了开发者对混合精度训练的门槛。

## 结语

混合精度训练已经成为提高深度学习模型训练效率的关键技术之一。通过在本章节中介绍的进阶优化技术和未来发展方向,我们可以预见,混合精度训练将在未来的研究和应用中扮演更加重要的角色。随着硬件和软件的不断进步,混合精度训练将在深度学习领域开启新的篇章。

# 6. 混合精度训练的挑战与展望

在混合精度训练领域,随着技术的不断进步与应用的广泛扩展,行业不断面临新的挑战,并且展现出了诸多令人期待的发展趋势。本章节将重点探讨当前混合精度训练面临的挑战,并展望未来的发展方向。

## 6.1 面临的挑战

混合精度训练的广泛部署和优化不仅仅是一项技术上的挑战,同时也伴随着实际应用中必须解决的问题。

### 6.1.1 模型准确性的权衡

在混合精度训练中,一个显著的挑战是如何在计算效率和模型准确性之间找到平衡点。虽然使用FP16可以显著提升计算速度和降低内存占用,但过低的表示精度可能导致数值不稳定性,从而影响最终模型的性能。这种权衡在深度学习模型中尤为显著,特别是对于那些对精度要求极高的任务。

### 6.1.2 不同硬件平台的适配问题

不同的硬件平台对混合精度训练的支持程度不尽相同。现有的硬件平台有的对FP16计算优化较好,有的则支持FP64或其他数值格式。此外,硬件之间的算力差距,以及软件框架在不同硬件上的优化情况,也进一步加剧了适配问题的复杂性。因此,开发通用的混合精度训练策略,能够支持各种硬件平台,成为了一个重大挑战。

## 6.2 未来发展趋势

混合精度训练技术仍在不断发展,未来可能会迎来一系列的技术革新和行业趋势。

### 6.2.1 混合精度训练技术的革新

随着硬件技术的进步,包括NVIDIA、AMD和Intel等芯片制造商正在开发新的硬件平台来更好地支持混合精度训练。例如,GPU中的Tensor Core以及专门为混合精度设计的AI处理器,都为混合精度训练提供了新的可能。未来的软件框架和工具也将进一步优化,以实现更高效的混合精度训练。

### 6.2.2 工业界和学术界的动向

工业界和学术界对于混合精度训练的关注和投入持续增加。在工业界,主要关注如何将混合精度训练技术应用于实际的产品和服务中,以提升深度学习模型的部署效率。在学术界,研究者们正致力于解决混合精度训练在新领域的适用性问题,以及开发更加精细化的算法来优化混合精度训练过程。同时,开源社区的活跃参与者们也在不断地贡献代码,推动混合精度训练技术的快速迭代和演进。

混合精度训练作为深度学习领域的关键技术之一,其优化和应用的复杂性要求我们不断创新和适应。无论是面临挑战还是展望未来,混合精度训练都将成为推动深度学习技术发展的关键力量。

0

0