混合精度训练硬件环境配置:PyTorch实现高效并行计算的要点

发布时间: 2024-12-12 07:07:45 阅读量: 11 订阅数: 13

实现SAR回波的BAQ压缩功能

# 1. 混合精度训练概述

混合精度训练是深度学习领域的一项重要技术,它通过在训练过程中同时使用单精度(32位浮点数)和半精度(16位浮点数)来加速模型训练并减少内存使用。该方法对硬件配置的要求较高,合理选择硬件设备及配置是混合精度训练成功实施的关键。

本章将为读者介绍混合精度训练的基本概念、优势及其与传统单精度训练的区别。接下来,我们会深入探讨混合精度训练在不同硬件上的实现方式及其对算法性能的具体影响。为了更全面地理解混合精度训练,本章还将分析其在实际应用中可能遇到的挑战,并为读者提供一些解决策略。

# 2. 硬件环境配置

### 2.1 CPU与GPU选择标准

混合精度训练要求计算资源高效、稳定,CPU和GPU的选择至关重要。本节将深入解析选择标准。

#### 2.1.1 CPU的性能参数解析

CPU(中央处理单元)作为系统的计算核心,其性能直接影响到整个系统的计算能力。选择CPU时,应关注以下主要性能参数:

- 核心数(Cores):多核心可以并行处理多线程任务,提升处理速度。对于训练大型模型来说,多核心可以显著缩短训练时间。

- 线程数(Threads):线程数的多少也反映了CPU处理多任务的能力。多线程技术(如Intel的超线程技术)可以在一定程度上提升CPU性能。

- 时钟频率(Clock Speed):以GHz为单位,时钟频率越高,CPU的单线程处理能力越强。

- 缓存大小(Cache Size):大容量缓存能够提高数据访问速度,减少CPU访问内存的次数,提高整体性能。

- 内存带宽(Memory Bandwidth):高内存带宽有助于快速交换数据,这对于数据密集型任务尤其重要。

- 兼容性和扩展性:CPU应兼容当前的主板,并支持未来的升级路径。

在选择CPU时,应根据模型训练的具体需求,综合考虑以上因素,选取满足计算需求同时具备高性价比的处理器。

#### 2.1.2 GPU的性能参数解析

GPU(图形处理单元)在混合精度训练中占据核心地位,其性能参数包括:

- CUDA核心数(CUDA Cores):更多CUDA核心可以并行处理数据,加速深度学习训练。

- GPU时钟频率(Base / Boost Clock):基频是GPU的标准工作频率,加速频率(或称为boost频率)是GPU在负载下能够达到的最高频率。

- 显存容量和带宽(Memory Capacity / Bandwidth):大显存能够容纳更大的模型和批量数据,高带宽意味着更快的数据传输速度。

- TDP(Thermal Design Power):表示GPU在满负载运行时的热设计功耗,影响电源和散热系统的选择。

- 架构和制程技术:新一代GPU架构和更小的制程技术能带来性能提升与能耗降低。

选择GPU时,应重点考虑模型训练的并行计算需求和显存容量,以确保训练过程顺畅且高效。

### 2.2 内存和存储解决方案

数据处理和模型训练对内存和存储有较高要求,合理的配置可以显著提高性能。

#### 2.2.1 高速缓存的配置与优化

高速缓存(Cache)对于提升系统性能至关重要,尤其是在处理大量数据时。配置和优化高速缓存包括以下策略:

- 选择具有较大缓存容量的CPU和主板,以及配置高速内存条,确保能够满足数据密集型计算的需求。

- 通过调整系统BIOS设置,优化缓存策略,例如设置缓存模式为“Write Back”以提高写入性能。

- 在操作系统级别调整虚拟内存设置,优化内存管理和分页文件的使用。

#### 2.2.2 存储设备的选择与配置

存储设备的速度和容量对模型训练有显著影响。选择和配置存储设备的考虑因素包括:

- 使用SSD(固态硬盘)代替HDD(机械硬盘),以获得更快的读写速度和更低的延迟。

- 采用RAID(独立磁盘冗余阵列)技术提升数据冗余和读写速度。

- 对于极大规模数据集,考虑使用分布式存储解决方案,如Ceph或GlusterFS。

合理的存储解决方案能够提高数据加载效率,降低训练时间。

### 2.3 网络拓扑与互连

高效的数据传输是多GPU系统训练任务的关键,网络拓扑和互连技术的选择至关重要。

#### 2.3.1 多GPU系统中的网络拓扑

多GPU系统可以通过不同的网络拓扑结构来实现。常见的多GPU网络拓扑包括:

- Peer-to-Peer(P2P)互连:每个GPU可以直接与其它GPU通信,适用于小规模GPU集群。

- 使用NVIDIA NVLink:这是一种高速互连技术,能够提供比PCIe总线更高的带宽。

- InfiniBand:这是一种用于高速数据传输的技术,适用于大规模高性能计算环境。

选择合适的网络拓扑可以显著提升数据在GPU之间传输的效率,从而加速训练进程。

#### 2.3.2 高带宽互连技术的选择

在多GPU系统中,高带宽互连技术的选择至关重要。主要的技术包括:

- PCIe Gen 3或Gen 4:PCIe总线提供GPU与CPU之间的高速连接。选择最新一代的PCIe可以提供更高的带宽。

- NVLink:提供更高的传输速率,适用于需要在多个GPU间大量数据交换的场景。

- InfiniBand:提供极高的传输带宽和低延迟,尤其适合大规模并行处理。

互连技术的选择取决于训练任务的规模和对性能的要求。在有限预算内,建议选择能够平衡成本和性能的方案。

### 结语

在硬件环境配置章节中,我们详细探讨了混合精度训练所需的硬件选择标准、内存和存储解决方案以及网络拓扑和互连技术的选择。理解这些参数和配置选项对于构建一个高效的深度学习训练平台至关重要。接下来的章节将深入到混合精度训练在PyTorch框架中的应用实践,进一步阐释如何在实际操作中优化性能。

# 3. PyTorch中的混合精度训练实践

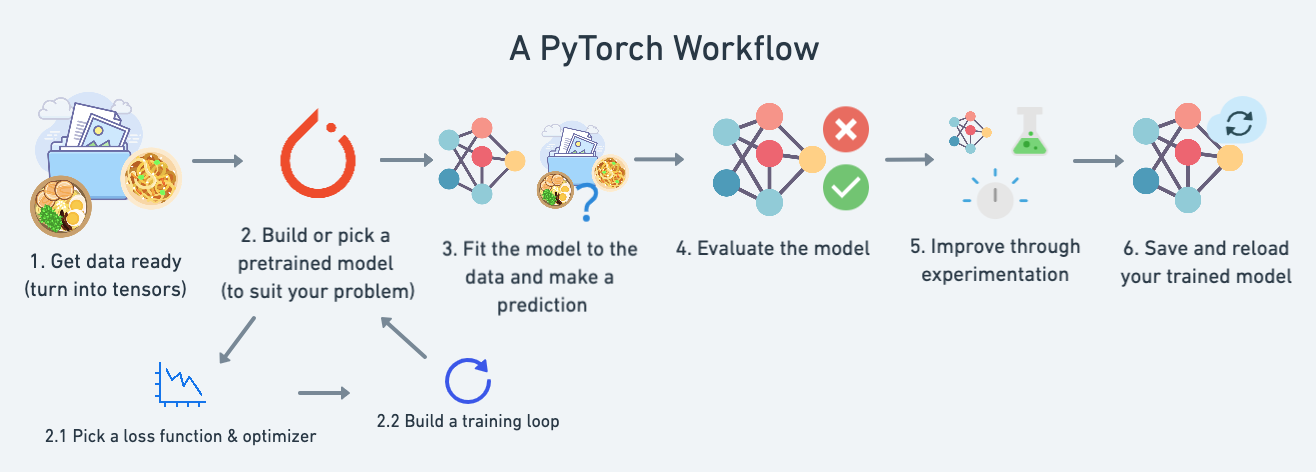

## 3.1 PyTorch基础和自动混合精度API

### 3.1.1 PyTorch核心组件介绍

PyTorch是一个开源的机器学习库,广泛应用于计算机视觉、自然语言处理等领域。它的核心组件包括Tensor、Variable、autograd、nn.Module等。Tensor是一种类似于NumPy的多维数组,但可以在GPU上运行。Variable是对Tensor的封装,提供了自动微分的能力。autograd是一个动态计算图的引擎,它可以帮助用户自动计算梯度。nn.Module是构建神经网络模型的基类,用户可以通过继承并实现特定的功能来构建自己的模型。

### 3.1.2 自动混合精度的启用与配置

自动混合精度(AMP)是一种在深度学习训练过程中自动使用半精度浮点数(FP16)的技术,以减少内存使用和提高计算效率。在PyTorch中,可以通过torch.cud

0

0