PyTorch RNN实现:循环神经网络的精进之路

发布时间: 2024-11-22 02:01:59 阅读量: 20 订阅数: 31

Pytorch 实现RNN分类.zip

# 1. 循环神经网络基础与PyTorch入门

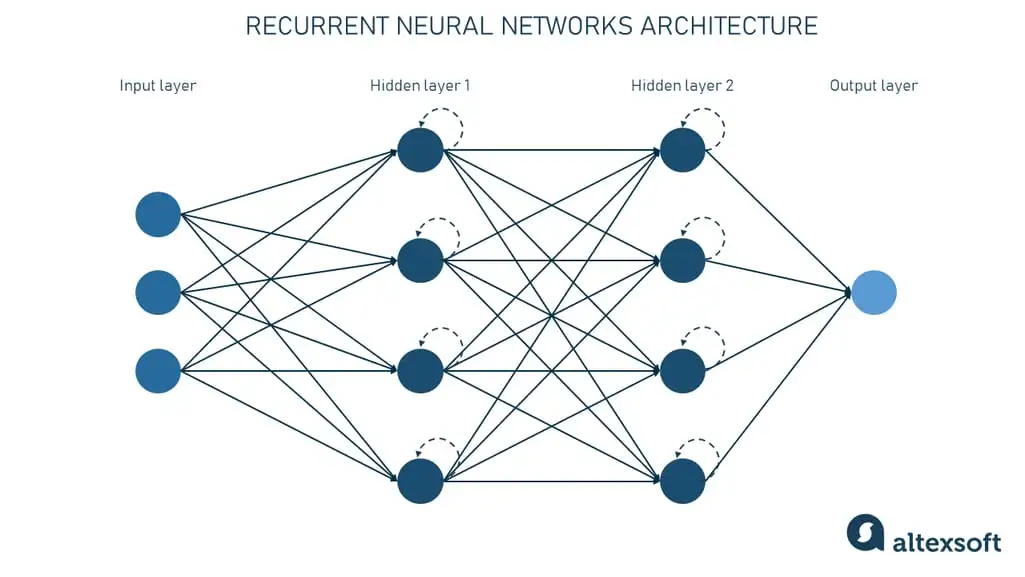

## 1.1 循环神经网络简介

循环神经网络(RNN)是一种专门处理序列数据的神经网络。它利用自身的记忆单元来捕捉数据之间的时序关联性,使其特别适用于时间序列预测、自然语言处理等任务。RNN的核心思想在于它的隐藏状态(hidden state)可以传递信息,从而处理不同长度的序列数据。

## 1.2 PyTorch入门

PyTorch是一个开源机器学习库,广泛用于计算机视觉和自然语言处理等领域。它以动态计算图著称,具有较高的灵活性和易用性。对于初学者来说,PyTorch提供了一个直观的API,通过`torch`和`torch.nn`模块,我们可以快速实现复杂的神经网络模型。

## 1.3 PyTorch安装和环境配置

首先,我们需要在计算机上安装PyTorch。可以通过访问官方网站获取相应的安装指令。推荐使用`conda`进行安装,因为它可以方便地管理依赖环境。安装命令如下:

```bash

conda install pytorch torchvision torchaudio -c pytorch

```

安装完成后,可以使用简单的代码测试PyTorch是否安装成功:

```python

import torch

print(torch.__version__)

```

本章的目的是引导读者快速理解RNN的基本概念,并开始使用PyTorch这一强大的工具。在后续章节中,我们将深入探索RNN的内部结构、变体以及实战项目。

# 2. PyTorch中的RNN组件与工作原理

## 2.1 RNN层的结构和功能

### 2.1.1 PyTorch中的RNN层概述

循环神经网络(Recurrent Neural Network,RNN)是一类专门处理序列数据的神经网络。PyTorch通过其深度学习框架提供了完整的RNN组件,允许研究者和开发者设计和训练此类模型。PyTorch中的RNN层可以处理不定长度的输入序列,并输出序列的每个时间步的隐藏状态,这些隐藏状态可以用于时间步的决策或者作为后续任务的输入。

在PyTorch中,`torch.nn.RNN`类是构建RNN层的基础,它包含了RNN层的基本参数,如隐藏单元数量(`num_layers`)、隐藏层的大小(`hidden_size`)、非线性激活函数(`nonlinearity`)等。RNN层的构建需要指定输入特征的维度(通常在序列的每个时间步长上的特征数量)和隐藏层的维度(即隐藏状态的维度)。

以下是创建一个具有128个隐藏单元的单层RNN的基本代码示例:

```python

import torch.nn as nn

# 创建一个简单的RNN层

rnn_layer = nn.RNN(input_size=10, hidden_size=128, batch_first=True)

```

在上述代码中,`input_size=10`表示输入序列每个时间步包含10个特征,`hidden_size=128`意味着隐藏状态的大小是128维的。参数`batch_first=True`表示输入张量的第一个维度是批次大小(batch size),而序列长度是第二个维度。

### 2.1.2 RNN层的内部工作机制

RNN层内部工作机制基于时间步长的迭代处理。在每个时间步,RNN计算当前输入与前一时间步隐藏状态的函数映射,从而产生新的隐藏状态。这个过程可以数学上表达为:

```

h_t = f(W * h_{t-1} + U * x_t + b)

```

其中`h_t`是当前时间步的隐藏状态,`x_t`是当前时间步的输入,`h_{t-1}`是前一个时间步的隐藏状态,`W`和`U`是权重矩阵,`b`是偏置向量,`f`是激活函数。这里`*`表示矩阵乘法,`+`表示向量加法。

PyTorch实现的RNN层根据时间步长顺序处理序列数据。在每一时间步,它把输入数据和上一时间步的隐藏状态作为输入,并计算新的隐藏状态。隐藏状态通常被传递到下一个时间步使用,而在最后一个时间步,输出可以被用来做预测或者作为后续任务的输入。

### 代码逻辑解读与参数说明

- `input_size`:指定了输入向量的维度,这必须与实际输入数据中的每个时间步的特征数量一致。

- `hidden_size`:定义了隐藏状态向量的维度,控制了RNN层能够学习到的信息复杂度。

- `batch_first`:确定了输入张量的形状。当`batch_first=True`时,输入张量的形状为`(batch_size, seq_len, input_size)`;当`batch_first=False`时,输入张量的形状为`(seq_len, batch_size, input_size)`。

## 2.2 RNN变体详解

### 2.2.1 LSTM与GRU的原理和特点

PyTorch提供了多种RNN变体,包括长短时记忆网络(Long Short-Term Memory,LSTM)和门控循环单元(Gated Recurrent Unit,GRU),这两种变体都是为了解决传统RNN在长期依赖问题上的困难而设计的。

#### LSTM

LSTM通过引入三个门控机制(遗忘门、输入门和输出门)来解决长期依赖问题。每个门控机制都由一个Sigmoid神经网络层和一个逐点乘法操作组成。

- 遗忘门决定了在当前时间步需要保留或遗忘之前隐藏状态的哪些信息。

- 输入门控制了新输入信息有多少可以加入到隐藏状态中。

- 输出门决定了在当前时间步要输出多少隐藏状态信息。

LSTM的数学公式表示如下:

```

f_t = σ(W_f * [h_{t-1}, x_t] + b_f)

i_t = σ(W_i * [h_{t-1}, x_t] + b_i)

o_t = σ(W_o * [h_{t-1}, x_t] + b_o)

c̃_t = tanh(W_c * [h_{t-1}, x_t] + b_c)

c_t = f_t * c_{t-1} + i_t * c̃_t

h_t = o_t * tanh(c_t)

```

其中`f_t`表示遗忘门的输出,`i_t`表示输入门的输出,`o_t`表示输出门的输出,`c̃_t`是候选隐藏状态,`c_t`是更新后的记忆细胞状态,`h_t`是当前时间步的隐藏状态。`W_f`, `W_i`, `W_o`, `W_c`是对应门控机制的权重矩阵,`b_f`, `b_i`, `b_o`, `b_c`是相应的偏置向量。

#### GRU

GRU简化了LSTM的门控结构,通过两个门控(重置门和更新门)来平衡旧信息和新信息。重置门决定了多少过去的信息需要被遗忘,而更新门决定了保留多少过去的状态。

GRU的数学公式如下:

```

r_t = σ(W_r * [h_{t-1}, x_t])

z_t = σ(W_z * [h_{t-1}, x_t])

h̃_t = tanh(W * [r_t * h_{t-1}, x_t])

h_t = (1 - z_t) * h_{t-1} + z_t * h̃_t

```

其中`r_t`是重置门的输出,`z_t`是更新门的输出,`h̃_t`是候选隐藏状态,`h_t`是更新后的隐藏状态。`W_r`, `W_z`和`W`是权重矩阵,`σ`和`tanh`是相应的激活函数。

### 2.2.2 在PyTorch中实现LSTM和GRU

PyTorch中实现LSTM和GRU的代码结构与实现标准RNN类似,只不过需要使用`torch.nn.LSTM`和`torch.nn.GRU`类。

以下是LSTM和GRU层实现的代码示例:

```python

# LSTM层的创建和应用

lstm_layer = nn.LSTM(input_size=10, hidden_size=128, batch_first=True)

# GRU层的创建和应用

gru_layer = nn.GRU(input_size=10, hidden_size=128, batch_first=True)

```

在实际应用中,无论是使用LSTM还是GRU,都需要将序列数据输入到相应层中进行训练和预测。由于LSTM和GRU包含了门控机制,它们在处理长序列时通常会比传统的RNN表现出更好的性能。

### 代码逻辑解读与参数说明

- `input_size`:与标准RNN相同,表示输入向量的维度。

- `hidden_size`:定义了隐藏状态向量的大小,对模型性能有直接影响。

- `batch_first`:决定输入张量的第一个维度是批次大小还是序列长度。

## 2.3 RNN在序列数据上的应用

### 2.3.1 序列数据处理技巧

处理序列数据时,有几种技巧可以提高模型的性能和效率。以下是几个重要的序列数据处理技巧:

1. **标准化和归一化数据**:在训练模型之前,对数据进行标准化或归一化处理,使其具有0均值和单位方差,这有助于加快模型的收敛速度。

2. **填充和截断序列**:为了使输入序列的长度一致,需要对较短的序列进行填充,对较长的序列进行截断。在PyTorch中,可以使用`torch.nn.utils.rnn.pad_sequence`和`torch.nn.utils.rnn.pack_padded_sequence`等工具来处理变长序列。

3. **批处理**:使用`DataLoader`和`CollateFunction`来对数据进行批处理,可以有效提高计算效率并减少内存消耗。

### 2.3.2 RNN模型的训练和评估

RNN模型的训练过程涉及多个步骤,包括定义模型、准备数据、设置损失函数、选择优化器、训练网络、评估模型性能等。

以下是一个简化的训练和评估过程的代码框架:

```python

# 定义模型

model = nn.RNN(input_size, hidden_size, batch_first=True)

# 设置损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

```

0

0