PyTorch CNN实现:深度解析与实践技巧

发布时间: 2024-11-22 01:58:02 阅读量: 4 订阅数: 7

# 1. PyTorch CNN基础概念与原理

在本章中,我们将探讨卷积神经网络(CNN)在深度学习中的核心作用,以及它们是如何通过PyTorch这一强大的深度学习框架来实现的。首先,我们会深入了解CNN的基本组成部分及其背后的数学原理,为后续章节中模型构建和训练打下坚实的理论基础。

## 1.1 CNN的基本工作原理

CNN通过模拟人眼处理视觉信息的方式,自动并有效地从图片中提取重要特征。它主要依靠卷积层、池化层和全连接层三个基本组件来完成这一任务。卷积层负责提取局部特征,池化层则减少数据的空间尺寸,减少计算量和防止过拟合。最后,全连接层整合特征用于分类或其他任务。

## 1.2 卷积操作和卷积核

卷积操作是CNN的核心。一个卷积核(也称为滤波器)在输入数据上滑动,计算其与数据的点积,产生一个二维数组,即特征图。通过使用不同的卷积核,CNN能够检测图像中的各种特征,例如边缘、角点等。

接下来的章节,我们将深入学习如何在PyTorch中构建CNN模型,以及训练、优化和评估这些模型。通过实例代码,我们还将展示如何在具体项目中应用这些概念。

# 2. PyTorch CNN模型构建与训练

### 2.1 构建PyTorch CNN模型

构建PyTorch卷积神经网络(CNN)模型是深度学习任务中的一项基本工作。CNN广泛应用于图像识别、分类等视觉任务中,其核心在于自动和有效地提取空间层级特征。

#### 2.1.1 理解卷积层

卷积层是CNN的基础,负责从输入数据中提取特征。卷积操作通过一个称为卷积核(或滤波器)的可训练参数矩阵与输入图像进行元素相乘和累加的操作来实现。

```python

import torch

import torch.nn as nn

import torch.nn.functional as F

class ConvLayer(nn.Module):

def __init__(self):

super(ConvLayer, self).__init__()

self.conv = nn.Conv2d(in_channels=3, out_channels=32, kernel_size=3, stride=1, padding=1)

def forward(self, x):

return F.relu(self.conv(x))

# 实例化模型,并定义一个输入数据进行前向传播演示

input_image = torch.randn(1, 3, 32, 32) # 假设输入图片是3通道的32x32大小

model = ConvLayer()

output = model(input_image)

```

在上述代码中,`ConvLayer`类定义了一个简单的卷积层,其中`in_channels`和`out_channels`定义了输入和输出通道的数量,`kernel_size`定义了卷积核的大小,`stride`和`padding`定义了卷积操作的步长和填充方式。

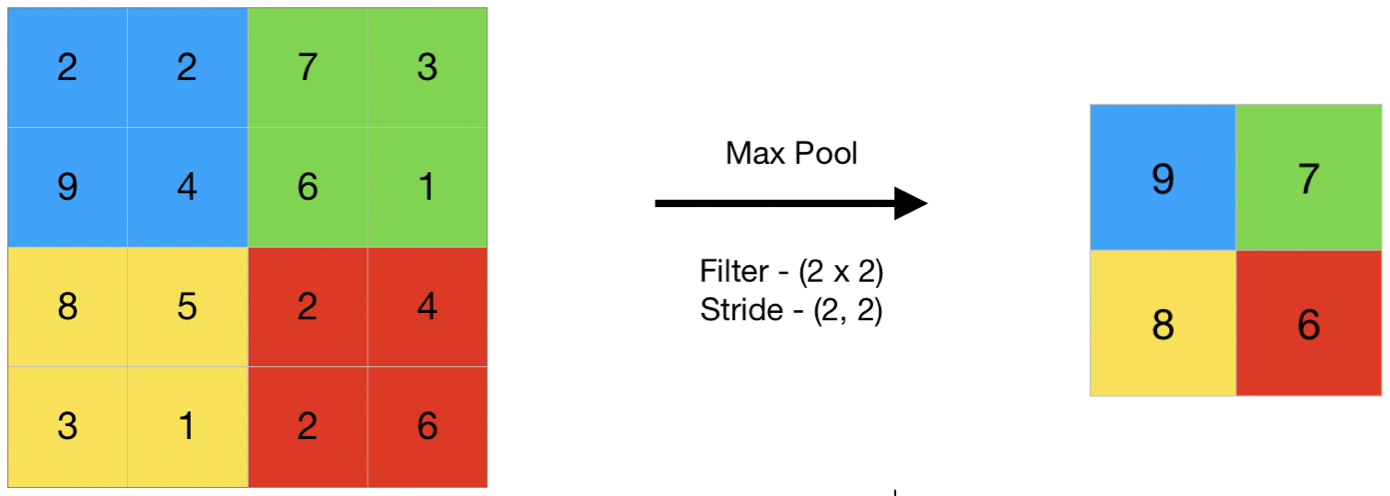

#### 2.1.2 理解池化层

池化层通常跟在卷积层之后,用于减少特征图的空间尺寸,降低计算量和控制过拟合。

```python

class PoolingLayer(nn.Module):

def __init__(self):

super(PoolingLayer, self).__init__()

self.pool = nn.MaxPool2d(kernel_size=2, stride=2)

def forward(self, x):

return self.pool(x)

# 定义一个输入数据进行前向传播演示

model_pooling = PoolingLayer()

output_pooling = model_pooling(output)

```

在上述代码中,`PoolingLayer`类定义了一个最大池化层,`kernel_size`和`stride`定义了池化操作的窗口大小和步长。

#### 2.1.3 全连接层与输出层

全连接层(Fully Connected layers, FC)通常位于卷积神经网络的末端,负责将提取的特征映射到样本标记空间。

```python

class FullyConnectedLayer(nn.Module):

def __init__(self, input_features, num_classes):

super(FullyConnectedLayer, self).__init__()

self.fc = nn.Linear(input_features, num_classes)

def forward(self, x):

return self.fc(x.view(x.size(0), -1))

# 假设最后一个卷积层输出的特征图为64个通道,每个特征图大小为4x4,共需要分类的类别是10

num_classes = 10

input_features = 64 * 4 * 4

model_fc = FullyConnectedLayer(input_features, num_classes)

output_fc = model_fc(output_pooling)

```

在上述代码中,`FullyConnectedLayer`类定义了一个全连接层,`input_features`是输入特征的数量,`num_classes`是分类的类别数量。通过`view`方法将多维的特征图数据转换成一维的向量,以便全连接层可以处理。

### 2.2 训练过程中的正则化与优化

CNN模型训练是一个迭代的过程,需要采取措施防止过拟合,如权重衰减(L2正则化),和提高模型泛化能力的技术,比如Dropout。同时,选择合适的优化器和调整学习率策略对模型训练也至关重要。

#### 2.2.1 权重衰减与Dropout

权重衰减通过在损失函数中添加L2正则项来抑制模型复杂度,而Dropout通过随机丢弃网络中的一部分神经元来减少模型对特定训练样本的依赖。

```python

class RegularizedModel(nn.Module):

def __init__(self):

super(RegularizedModel, self).__init__()

self.conv = nn.Conv2d(in_channels=3, out_channels=32, kernel_size=3, stride=1, padding=1)

self.fc = nn.Linear(input_features, num_classes)

self.pool = nn.MaxPool2d(kernel_size=2, stride=2)

self.dropout = nn.Dropout(0.5) # Dropout比率设为50%

def forward(self, x):

x = self.pool(F.relu(self.conv(x)))

x = self.dropout(x) # 在池化层之后应用Dropout

x = x.view(x.size(0), -1)

x = self.fc(x)

return x

```

在此示例中,`RegularizedModel`类结合了前面介绍的卷积层、池化层和全连接层,并在池化层后添加了Dropout层。

#### 2.2.2 选择合适的优化器

优化器负责调整网络参数以最小化损失函数。PyTorch提供了多种优化器,例如SGD、Adam、RMSprop等。

```python

model = RegularizedModel()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001) # 使用Adam优化器,并设置学习率为0.001

```

在此处,我们初始化了一个`RegularizedModel`模型,并使用`torch.optim.Adam`作为优化器。

#### 2.2.3 学习率调度策略

学习率调度器可以动态调整学习率,例如在训练过程中逐步降低学习率。

```python

scheduler = torch.optim.lr_scheduler.StepLR(optimizer, step_size=30, gamma=0.1)

# 每30个epoch,学习率下降为原来的1/10

```

学习率调度器`StepLR`在指定的`step_size`后,将学习率乘以`gamma`参数。这里每隔30个训练周期,学习率就会下降到原来的1/10。

### 2.3 模型评估与验证技巧

模型评估与验证是模型开发的关键环节,交叉验证是一种常用的模型验证技巧,可以减少评估误差。同时,计算模型性能指标(如准确率、精确率、召回率)对于理解模型性能至关重要。

#### 2.3.1 交叉验证与过拟合预防

交叉验证是通过将数据集分成多个子集,并将这些子集作为训练集和验证集,以减少模型对特定训练数据集的依赖。

```python

from sklearn.model_selection import cross_val_score

from sklearn.datasets import make_classification

from sklearn.linear_model import LogisticRegression

X, y = make_classification(n_samples=100, n_features=4, n_informative=2, n_redundant=0, random_state=1)

model = LogisticRegression()

scores = cross_val_score(model, X, y, cv=5) # 5折交叉验证

print(f"Accuracy scores: {scores}")

```

在这个例子中,我们使用了sklearn库中的`cross_val_score`函数进行了5折交叉验证,并打印了每次验证的准确率。

#### 2.3.2 模型性能指标计算

性能指标能够提供模型性能的多维度信息,其中精确率、召回率和F1分数是分类问题中常用的指标。

```python

from sklearn.metrics import precision_score, recall_score, f1_score

# 假设我们已经获得了预测值和真实标签

y_pred = model.predict(X)

precision = precision_score(y, y_pred)

recall = recall_score(y, y_pred)

f1 = f1_score(y, y_pred)

print(f"Precision: {precision}\nRecall: {recall}\nF1 Score: {f1}")

```

在这个代码段中,我们使用sklearn中的`precision_score`、`recall_score`和`f1_score`函数计算了模型的精确率、召回率和F1分数。

#### 2.3.3 深度学习中的可视化技术

可视化技术可以帮助我们直观地理解模型的表现和预测结果,例如通过绘制混淆矩阵来评估分类模型。

```python

from sklearn.metrics import confusion_matrix

import seaborn as sns

import matplotlib.pyplot as plt

# 绘制混淆矩阵

cm = confusion_matrix(y, y_pred)

sns.heatmap(cm, annot=True, fmt='d', cmap='Blues')

plt.xlabel('Predicted')

plt.ylabel('True')

plt.show()

```

在上述代码中,我们使用了`confusion_matrix`函数来创建混淆矩阵,并使用seaborn和matplotlib来绘制它。

在本章节中,我们详细介绍了PyTorch CNN模型构建的基本步骤,包括卷积层、池化层和全连接层的设计与实现。同时,我们也探讨了训练过程中正则化技术和优化器的选择,以及模型评估与验证的技巧。这些知识构成了PyTorch CNN模型开发的基础,是构建有效和高效的深度学习模型不可或缺的部分。接下来的章节将深入介绍CNN在数据处理、增强以及更高级应用和部署方面的知识。

# 3. PyTorch CNN数据处理与增强

## 3.1 数据加载与预处理

### 3.1.1 Dataset与DataLoader的使用

在PyTorch中,数据加载和预处理是通过 Dataset 和 DataLoader 类来完成的。Dataset 类负责存储数据样本和提供数据索引,而 DataLoader 类则提供了一个可迭代的接口用于批量加载数据,并可以支持多线程加载。这一节将深入探讨如何使用这两个类来实现高效且符合 CNN 数据需求

0

0