PyTorch超参数调优:专家的5步调优指南

发布时间: 2024-11-22 02:18:46 阅读量: 32 订阅数: 31

PyTorch环境配置指南:基于Anaconda平台的技术步骤

# 1. PyTorch超参数调优基础概念

## 1.1 什么是超参数?

在深度学习中,超参数是模型训练前需要设定的参数,它们控制学习过程并影响模型的性能。与模型参数(如权重和偏置)不同,超参数不会在训练过程中自动更新,而是需要我们根据经验或者通过调优来确定它们的最优值。

## 1.2 为什么要进行超参数调优?

超参数的选择直接影响模型的学习效率和最终的性能。在没有经过优化的默认值下训练模型可能会导致以下问题:

- **过拟合**:模型在训练数据上表现良好,但在未见数据上性能差。

- **欠拟合**:模型无法捕捉训练数据中的特征和模式。

- **训练效率低下**:需要大量的迭代次数才能收敛至一个可接受的性能。

## 1.3 超参数调优的基本步骤

超参数调优通常涉及以下步骤:

1. **定义搜索空间**:明确哪些超参数需要调整,以及它们的取值范围。

2. **选择搜索策略**:基于计算资源和时间约束选择合适的搜索方法。

3. **执行搜索**:运行训练程序,根据性能反馈调整超参数。

4. **评估与验证**:通过交叉验证或在独立测试集上评估超参数组合的性能。

通过以上步骤,我们可以系统地找到能够提高模型性能的超参数配置,进而优化模型训练过程和结果。

# 2. 理论与实践相结合的调优策略

## 理解超参数对模型的影响

超参数在深度学习中扮演着至关重要的角色,它们控制着学习过程和模型的结构。正确理解这些超参数如何影响模型的性能,对于设计有效的学习算法至关重要。

### 学习率和批次大小的重要性

学习率控制着权重更新的速度,是优化算法中最重要的超参数之一。如果学习率太高,训练可能会不稳定;如果太低,训练过程则会非常缓慢,甚至可能导致模型陷入局部最优解。

**代码实践:调整学习率**

下面是一个如何在PyTorch中调整学习率的示例代码:

```python

import torch

from torch import nn, optim

# 定义模型

model = nn.Sequential(nn.Linear(10, 1))

criterion = nn.MSELoss()

optimizer = optim.SGD(model.parameters(), lr=0.1)

# 定义训练函数

def train(model, criterion, optimizer, num_epochs=10):

for epoch in range(num_epochs):

for inputs, targets in data_loader:

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, targets)

loss.backward()

optimizer.step()

print(f'Epoch {epoch+1}, Loss: {loss.item()}')

# 调整学习率

for param_group in optimizer.param_groups:

param_group['lr'] *= 0.9 # 每个epoch学习率下降10%

train(model, criterion, optimizer)

```

在上述代码中,我们首先定义了一个简单的线性模型、损失函数和优化器,并设置了初始学习率。在训练过程中,我们通过衰减学习率来调整其值。

### 正则化参数对泛化能力的作用

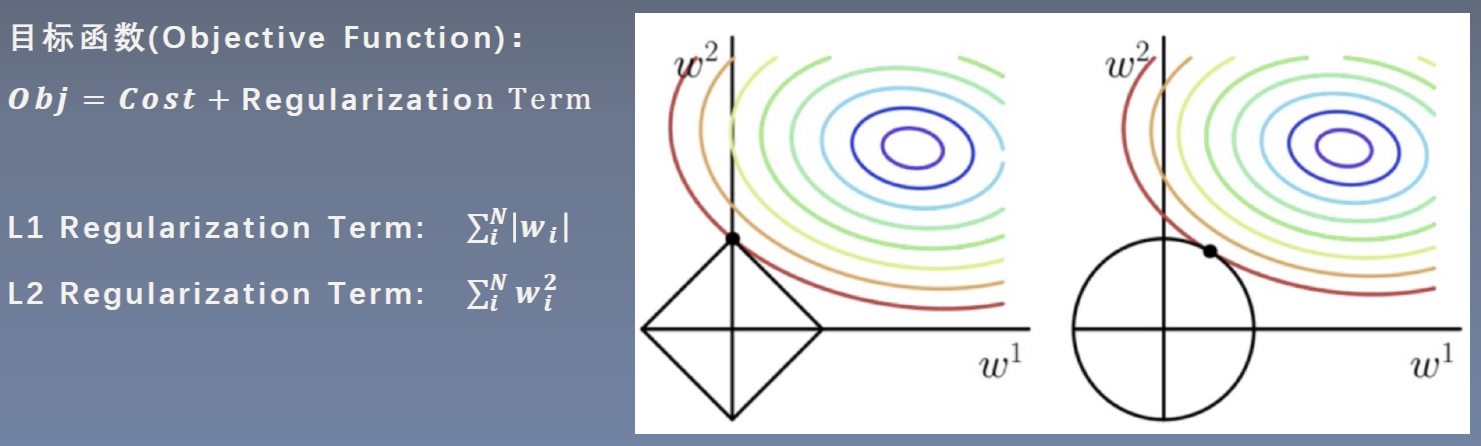

正则化技术如L1和L2范数罚项被用来防止过拟合,通过限制模型的复杂度来提高模型的泛化能力。在优化过程中加入正则化项,可以促使模型在训练数据上保持较小的权重值,从而避免过度依赖训练数据的特性。

## 调优方法的理论基础

### 网格搜索(Grid Search)

网格搜索是一种穷举搜索方法,它通过遍历给定的超参数的所有可能值的组合来寻找最佳组合。虽然简单易行,但网格搜索的计算成本随着超参数空间的增长而指数级增加。

**代码实践:使用网格搜索调整超参数**

```python

from sklearn.model_selection import GridSearchCV

from sklearn.svm import SVC

parameters = {'kernel':('linear', 'rbf'), 'C':[1, 10]}

svc = SVC()

clf = GridSearchCV(svc, parameters)

clf.fit(X_train, y_train)

print("Best parameters set found on development set:")

print(clf.best_params_)

```

在上面的示例中,我们使用了`GridSearchCV`来寻找支持向量机分类器的最优超参数。

### 随机搜索(Random Search)

与网格搜索不同,随机搜索在指定的超参数空间中随机选取一定数量的点进行搜索。随机搜索通常能更快地收敛到最佳的超参数组合,并且在高维空间中比网格搜索更高效。

**代码实践:使用随机搜索调整超参数**

```python

from sklearn.model_selection import RandomizedSearchCV

from scipy.stats import expon, reciprocal

param_distributions = {

'kernel': ['linear', 'rbf'],

'C': reciprocal(0.1, 10),

'gamma': expon(scale=1.0)

}

clf = RandomizedSearchCV(svc, param_distributions, n_iter=10)

clf.fit(X_train, y_train)

print("Best parameters found on development set:")

print(clf.best_params_)

```

在该示例中,我们使用`RandomizedSearchCV`来搜索SVM的超参数,可以看到它允许我们在指定的分布中进行随机采样。

### 贝叶斯优化(Bayesian Optimization)

贝叶斯优化是一种基于贝叶斯概率原理的全局优化算法,它在迭代过程中构建了一个概率模型,并使用这个模型来指导搜索最佳的超参数组合。它特别适合于优化成本高昂、评估次数受限的函数。

**代码实践:使用贝叶斯优化调整超参数**

```python

from skopt import BayesSearchCV

from skopt.space import Real, Categorical, Integer

search_space = {

'kernel': Categorical(['linear', 'rbf']),

'C': Real(0.1, 10.0),

'gamma': Real(0.01, 10.0, prior='log-uniform')

}

clf = BayesSearchCV(SVC(), search_space, n_iter=32)

clf.fit(X_train, y_train)

print("Best parameters found on development set:")

print(clf.best_params_)

```

在这个例子中,我们使用了`BayesSearchCV`来调整SVM的超参数,并指定了搜索空间和迭代次数。贝叶斯优化通常需要较少的迭代次数就能找到较好的超参数。

## 实战:手动调整超参数

手动调整超参数是一个迭代的过程,需要不断评估模型的表

0

0