Keras注意力机制:构建理解复杂数据的强大模型

发布时间: 2024-11-22 05:02:44 阅读量: 15 订阅数: 30

# 1. 注意力机制在深度学习中的作用

## 1.1 理解深度学习中的注意力

深度学习通过模仿人脑的信息处理机制,已经取得了巨大的成功。然而,传统深度学习模型在处理长序列数据时常常遇到挑战,如长距离依赖问题和计算资源消耗。注意力机制的提出为解决这些问题提供了一种创新的方法。通过模仿人类的注意力集中过程,这种机制允许模型在处理信息时,更加聚焦于相关数据,从而提高学习效率和准确性。

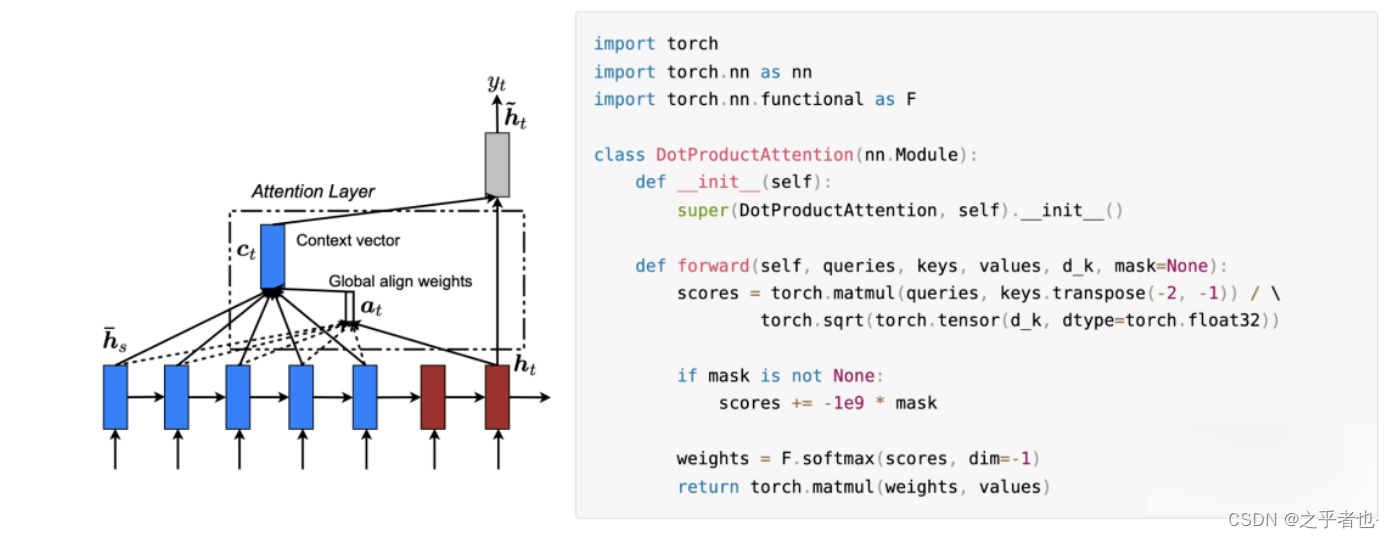

## 1.2 注意力机制的工作原理

注意力机制的核心思想是为序列模型增加一个“看”或者“选择”数据的能力。在处理输入数据时,模型会计算每个元素的重要性权重,从而生成一个加权的表示。例如,在自然语言处理任务中,对于一句话中的每一个词,模型会赋予它不同的权重,反映它在句子中的重要程度。

## 1.3 注意力机制的应用

注意力机制已经被广泛地应用于各类深度学习任务中,例如机器翻译、语音识别、图像描述等。通过引入注意力机制,模型可以更加有效地捕捉到关键信息,提高模型的性能和泛化能力。随着研究的深入,注意力机制在深度学习领域将发挥越来越重要的作用。

# 2. Keras基础和深度学习入门

### 2.1 Keras框架简介

#### 2.1.1 Keras的特点和优势

Keras是一个开源的深度学习库,最初由François Chollet在2015年发布。它以其简洁性、易用性、模块化和灵活性而闻名。Keras的一个重要设计原则是用户友好性,它能够以最小的延时运行实验。Keras具有以下显著特点和优势:

- 易于上手:Keras专注于快速实验,可以将想法迅速转化为结果。

- 模块化和可插拔:模型被定义为模块的序列或图形,可以轻松地进行实验和实验性架构。

- 极小化用户负担:Keras提供了清晰和一致的API,同时将用户的常见用例所需的全部复杂性隐藏起来。

- 与TensorFlow、CNTK或Theano无缝协作:Keras模型可以通过后端引擎进行无缝切换和扩展。

#### 2.1.2 Keras的安装与配置

在开始之前,确保你已经安装了Python。由于Keras是构建在TensorFlow之上的高级API,所以如果你还没有安装TensorFlow,可以通过以下命令安装:

```bash

pip install tensorflow

```

一旦TensorFlow安装完成,你可以直接安装Keras:

```bash

pip install keras

```

或者,如果你使用的是较新版本的pip,你可以使用以下命令:

```bash

pip install --upgrade pip

pip install keras --no-deps # 使用 --no-deps 以避免同时安装 TensorFlow 的依赖项

```

安装完成后,你可以通过以下Python代码验证Keras是否安装成功:

```python

import keras

print(keras.__version__)

```

### 2.2 深度学习基础理论

#### 2.2.1 神经网络的基本概念

深度学习是机器学习的一个分支,它通过模拟人脑神经网络的方式来进行学习。神经网络的基本概念包括:

- **神经元(Neuron)**:受生物学神经元启发的计算单元,它接收输入,进行加权求和,并应用一个非线性激活函数。

- **权重(Weights)**:连接神经元的线性部分,表示输入对输出的影响程度。

- **激活函数(Activation Function)**:一个非线性函数,如ReLU或Sigmoid,用于引入非线性,使网络能够学习复杂的映射。

- **层(Layer)**:由许多神经元组成,可以是输入层、隐藏层或输出层。

- **前向传播(Forward Propagation)**:信号通过网络从输入层传递到输出层的过程。

- **损失函数(Loss Function)**:衡量模型预测值与真实值差异的函数,如均方误差(MSE)。

#### 2.2.2 反向传播算法和梯度下降

深度学习中一个核心的问题是训练模型,使其参数能够最小化损失函数。反向传播算法是一种高效计算神经网络参数梯度的方法,而梯度下降则是一个优化算法,用于根据这些梯度更新参数。

反向传播算法涉及以下步骤:

1. **前向传播**:输入数据穿过网络,计算输出。

2. **计算损失**:损失函数计算预测输出与真实输出之间的差异。

3. **反向传播误差**:损失函数关于网络参数的梯度被计算出来,并向网络的更深层次传递。

4. **更新参数**:基于梯度下降法则,网络参数被更新以减少损失。

梯度下降的不同变种包括批量梯度下降、随机梯度下降(SGD)和小批量梯度下降。

#### 2.2.3 激活函数和优化器的选择

激活函数在神经网络中扮演着引入非线性的关键角色。常见的激活函数包括:

- **ReLU**:修正线性单元,通过\(f(x) = \max(0, x)\)提供简单且有效的非线性。

- **Sigmoid**:常用于输出层,将输出限制在0和1之间。

- **Tanh**:双曲正切激活函数,将输出限制在-1到1之间。

优化器是另一种在训练过程中调整网络权重的算法。一些流行的优化器包括:

- **SGD**:随机梯度下降。

- **Adam**:自适应矩估计算法,结合了RMSProp和SGD的优点。

- **RMSProp**:由Hinton提出,用于解决AdaGrad优化算法在训练神经网络时学习率变慢的问题。

### 2.3 Keras的基本组件和操作

#### 2.3.1 Keras中的模型构建

在Keras中构建模型是一个简单的过程。有两种主要的模型构建方式:序贯模型(Sequential)和函数式API(Functional API)。序贯模型是最简单的模型,适合简单的堆叠层。而函数式API提供了更多的灵活性,适合复杂模型的构建。

使用序贯模型构建一个简单的神经网络:

```python

from keras.models import Sequential

from keras.layers import Dense

# 创建一个序贯模型

model = Sequential()

# 添加层

model.add(Dense(64, activation='relu', input_shape=(input_size,)))

model.add(Dense(10, activation='softmax'))

# 编译模型

model.compile(loss='categorical_crossentropy',

optimizer='adam',

metrics=['accuracy'])

# 模型摘要

model.summary()

```

#### 2.3.2 图层类型及其应用

Keras提供了多种类型的层,每种层都用于不同的目的。例如:

- **Dense**:常规的全连接层。

- **Conv2D**:用于二维数据的卷积层,常用于图像处理。

- **MaxPooling2D**:在图像中应用最大池化,减少参数数量,防止过拟合。

- **LSTM**:长短期记忆层,适合处理序列数据。

使用卷积层构建一个简单的图像分类网络:

```python

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = Sequential([

Conv2D(32, (3, 3), activation='relu', input_shape=(image_height, image_width, channels)),

MaxPooling2D((2, 2)),

Conv2D(64, (3, 3), activation='relu'),

MaxPooling2D((2, 2)),

Flatten(),

Dense(64, activation='relu'),

Dense(num_classes, activation='softmax')

])

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

```

#### 2.3.3 数据预处理和增强方法

数据预处理是深度学习中的一个关键步骤。它可以包括标准化、归一化和缩放等。数据增强则是通过对原始数据应用变换来生成新的训练样本,增加模型的泛化能力。

使用Keras进行数据预处理的一个例子:

```python

from keras.preprocessing.image import ImageDataGenerator

# 创建一个ImageDataGenerator实例

datagen = ImageDataGenerator(

rescale=1./255, # 标准化

rotation_range=20, # 随机旋转角度范围

width_shift_range=0.2, # 随机水平位移范围

height_shift_range=0.2,

shear_range=0.2,

zoom_range=0.2,

horizontal_flip=True,

fill_mode='nearest'

)

# 训练模型时,使用datagen.flow_from_directory来增强训练数据

train_generator = datagen.flow_from_directory(

train_data_dir,

target_size=(img_width, img_height),

batch_size=batch_size,

class_mode='binary')

```

在本章节中,我们介绍了Keras的基础知识和深度学习的入门理论。通过一步步的介绍和示例代码,我们希望读者能够对Keras框架有一个基本的了解,并对深度学习的核心概念有一个清晰的认识。随着本章内容的学习,读者应该能够搭建基本的神经网络模型,并开始进行数据预处理和模型训练的工作。接下来,我们将在第三章中深入探讨注意力机制的理论和实践。

# 3. 注意力机制的理论和实践

## 3.1 注意力机制的数学原理

### 3.1.1 从软注意力到硬注意力

注意力机制在深度学习中可以大致分为软注意力(Soft Attention)和硬注意力(Hard Attention)。硬注意力是一种非确定性的机制,它在每一步都选择一个最有可能的输入并进行关注,类似于人类在转移注意力时的决策过程。硬注意力在实现时往往涉及到随机采样,这使得模型训练变得复杂,因为涉及到随机梯度的估计。

相比之下,软注意力则是确定性的,它为每个输入分配一个权重(或概率),权重表示输入信息的重要性。通过这种方式,软注意力机制能够为每个输入位置生成一个平滑的权重分布,易于计算和梯度传播。

在实际应用中,软注意力因其容易实现和训练的特性而被广泛采用。但需要注意的是,硬注意力虽然复杂,却能够捕捉到更为复杂的数据结构和模式,因为它的决策过程更加接近人类的注意力机制。

### 3.1.2 注意力权重的计算方法

注意力权重的计算是注意力机制的核心。在Keras中,注意力层可以通过内置的`Attention`层实现。计算注意力权重主要有以下几个步骤:

1. **状态表示**:首先,需要定义模型的状态表示,

0

0