Keras超参数调优:网格搜索与随机搜索的实战应用

发布时间: 2024-11-22 04:43:07 阅读量: 3 订阅数: 9

# 1. Keras超参数调优概述

在深度学习模型开发的过程中,模型的性能往往取决于超参数的设定。Keras超参数调优作为一种优化手段,旨在通过系统地寻找超参数的最优组合来提升模型的准确性和效率。本章节将概述Keras超参数调优的重要性,以及它在模型构建和训练过程中的应用范围。我们会先讨论超参数的定义及其在Keras中的作用,为接下来深入探讨各种调优策略和技巧打下基础。

# 2. 理解Keras中的超参数

在构建深度学习模型时,超参数的选择对于模型的性能有着决定性的影响。本章节将深入探讨Keras中的超参数,包括模型架构、训练过程以及正则化与初始化策略等关键因素。

## 2.1 Keras模型架构的超参数

### 2.1.1 神经网络层数与类型

构建深度学习模型时,首先需要决定的是网络的层数与类型。这一决策将直接影响模型的能力和复杂度。

#### 层数选择

层数选择通常基于问题的复杂性和数据的性质。对于更复杂的问题,可能需要更深的网络结构来捕捉数据中的抽象特征。浅层网络可能足以处理简单任务,例如线性可分问题。

**代码示例:**

```python

from keras.models import Sequential

from keras.layers import Dense

# 创建一个具有两个隐藏层的 Sequential 模型

model = Sequential()

model.add(Dense(units=64, activation='relu', input_shape=(input_size,)))

model.add(Dense(units=64, activation='relu'))

model.add(Dense(units=output_size, activation='softmax'))

```

在上述代码中,`units` 参数定义了每一层神经元的数量,而 `activation` 参数指定了激活函数。选择合适的层数和每层的神经元数量是模型架构优化的关键。

#### 层类型选择

常见的层类型包括全连接层(Dense)、卷积层(Conv2D)、循环层(LSTM)等。选择合适的层类型依赖于数据的维度和特征的类型。

**代码示例:**

```python

from keras.layers import Conv2D, MaxPooling2D

# 添加卷积层和池化层

model.add(Conv2D(filters=32, kernel_size=(3, 3), activation='relu', input_shape=input_shape))

model.add(MaxPooling2D(pool_size=(2, 2)))

```

在这段代码中,`filters` 参数定义了卷积核的数量,`kernel_size` 参数指定了卷积核的大小。层类型的选择需要根据数据的维度和任务的特点进行权衡。

### 2.1.2 激活函数的选择

激活函数为神经网络引入非线性,对于网络的学习能力至关重要。常见的激活函数包括ReLU、Sigmoid、Tanh等。

**表格:激活函数对比**

| 激活函数 | 优点 | 缺点 | 适用场景 |

| --- | --- | --- | --- |

| ReLU | 计算简单,缓解梯度消失问题 | 输出不是零中心 | 隐藏层通用 |

| Sigmoid | 曾广泛使用 | 梯度消失,输出非零中心 | 不推荐用于隐藏层 |

| Tanh | 输出零中心 | 梯度消失 | 隐藏层 |

| Leaky ReLU | 改进ReLU的负值梯度 | 可能增加模型复杂度 | 隐藏层 |

选择合适的激活函数对于优化网络的性能至关重要,每种激活函数都有其适用的场景和优缺点。在实际应用中,通常推荐在隐藏层使用ReLU激活函数。

## 2.2 Keras训练过程的超参数

### 2.2.1 学习率与优化器

学习率决定了在梯度下降过程中参数更新的步长。过高或过低的学习率都会影响模型的收敛性。

**代码示例:**

```python

from keras.optimizers import Adam

# 设置优化器

optimizer = Adam(learning_rate=0.001)

model.compile(loss='categorical_crossentropy', optimizer=optimizer)

```

在这个示例中,我们使用了Adam优化器,这是一个常用的选择,它结合了RMSprop和Momentum两种优化算法的优点。

### 2.2.2 批量大小与迭代次数

批量大小(batch size)和迭代次数(epochs)是训练过程中非常重要的超参数。批量大小决定了每次训练过程中使用的样本数量,而迭代次数定义了模型完整地遍历整个训练集的次数。

**逻辑分析:**

- 较小的批量大小可以使模型更好地泛化,但可能需要更多的训练时间。

- 较大的批量大小可以加速训练,但可能导致模型无法收敛到最优解。

## 2.3 Keras正则化与初始化策略

### 2.3.1 权重正则化与Dropout技术

为了防止过拟合,引入权重正则化(如L1、L2正则化)和Dropout技术是常见的实践。

**代码示例:**

```python

from keras.layers import Dropout

# 添加Dropout层以减少过拟合

model.add(Dropout(rate=0.5))

```

在这个示例中,`rate` 参数定义了被丢弃的节点比例。Dropout通过随机关闭一部分神经元来防止网络对训练数据的过度拟合。

### 2.3.2 参数初始化方法

初始化方法影响到模型的收敛速度和最终的性能。常见的初始化方法包括随机初始化、Xavier初始化和He初始化等。

**代码示例:**

```python

from keras.initializers import HeNormal

# 使用He正态分布初始化权重

model.add(Dense(units=64, activation='relu', kernel_initializer=HeNormal()))

```

在这个例子中,我们使用了He初始化方法。它特别适用于使用ReLU激活函数的网络,可以加速模型的收敛速度。

在深度学习模型的构建和训练过程中,超参数的调整与优化是一个复杂且具有挑战性的任务。理解上述关键超参数的原理和效果,对于构建高效能的神经网络模型至关重要。在后续的章节中,我们将探讨如何通过各种技术手段进行超参数的搜索和调优。

# 3. 网格搜索(Grid Search)实战

## 3.1 网格搜索的理论基础

### 3.1.1 网格搜索的工作原理

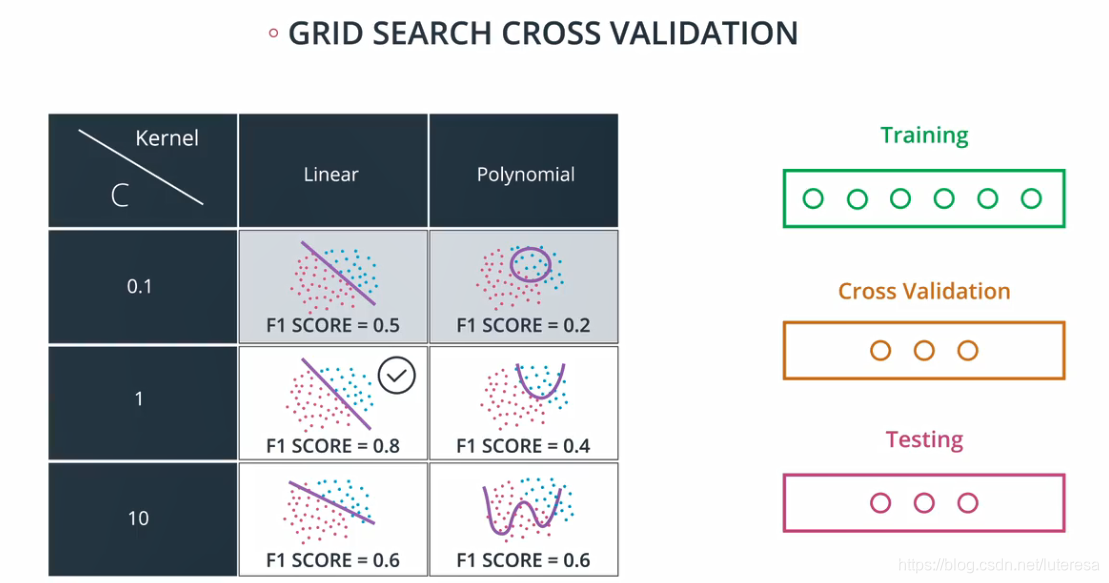

网格搜索(Grid Search)是一种系统性的参数优化方法,它通过穷举的方式,遍历指定范围内的所有参数组合,并对每一种组合进行模型训练和验证,以找到最佳的超参数集合。其工作原理可概括为以下几个步骤:

1. **参数范围设定**:确定需要优化的超参数及其候选值范围。

2. **构建参数网格**:构建一个参数矩阵,每一列代表一个超参数,每一行代表一个超参数组合。

3. **模型训练与验证**:对每一组参数组合,训练一个模型并使用验证集对模型的性能进行评估。

4. **性能评估与选择**:比较所有模型的性能,选出性能最好的参数组合。

网格搜索不依赖于梯度信息,它是一种无信息的搜索方法,适用于参数空间较小,参数之间相互独立的情况。

### 3.1.2 网格搜索的优缺点分析

网格搜索的优点在于简单直观,易于实现,不需要额外的算法知识,可以覆盖所有可能的参数组合,找到全局最优解。但是它也有明显的缺点,主要包括:

- **计算资源消耗巨大**:当参数范围增大时,需要评估的参数组合数量呈指数级增长,这对计算资源的要求非常高。

- **时间消耗长**:对于复杂的模型和大量的数据集,网格搜索需要训练和验证大量模型,耗时很长。

- **不适应高维参数空间**:高维参数空间的网格搜索是不现实的,因为需要的计算资源和时间都是天文数字。

## 3.2 实施网格搜索的步骤

### 3.2.1 使用Keras Tuner进行网格搜索

Keras Tuner是一个用于超参数优化的库,它支持不同的搜索算法,包括网格搜索。使用Keras Tuner进行网格搜索可以遵循以下步骤:

1. **安装Keras Tuner库**:

```bash

pip install keras-tuner

```

2. **定义超参数范围**:使用`kt`模块定义需要搜索的超参数。

```python

import keras_tuner as kt

def build_model(hp):

model = keras.Sequential()

model.add(keras.layers.Flatten(input_shape=(28, 28)))

# Tune the number of units in the first Dense layer

# Choose an optimal value between 32-512

hp_units = hp.Int('units', min_value=32, max_value=512, step=32)

model.add(keras.layers.Dense(units=hp_units, activation='relu'))

model.add(keras.layers.Dense(10, activation='softmax'))

# Tune the learning rate for the optimizer

# Choose an optimal value from 0.01, 0.001, or 0.0001

hp_learning_rate = hp.Choice('learning_rate', values=[1e-2, 1e-3, 1e-4])

model.compile(optimizer=keras.optimizers.Adam(learning_rate=hp_learning_rate),

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

return model

```

3. **创建超参数 tuner 对象**:选择搜索算法并创建tuner对象。

```python

tuner = kt.RandomSearch(

build_model,

```

0

0