PyTorch模型的混合精度训练:速度与精度平衡的艺术

发布时间: 2024-12-11 18:00:33 阅读量: 15 订阅数: 16

matlab尺度变换代码-pytorch-auto-drive:基于PyTorch1.6并具有混合精度训练的细分模型(ERFNet,ENet,

# 1. 混合精度训练概述

在深度学习领域,模型训练对计算资源的要求越来越高,其中一个重要因素是数值精度。本章将介绍混合精度训练的概念、理论背景及其在现代AI训练中的重要性。

混合精度训练是指在深度学习模型训练过程中同时使用不同精度的数值计算,以平衡模型性能和资源消耗。传统的训练方法通常使用单精度浮点数(32-bit float),但这种方法可能会导致大量的计算资源浪费。通过引入半精度浮点数(16-bit float),混合精度训练能够提高GPU的内存利用率和计算效率,从而缩短训练时间并减少能耗。

在本章中,我们将探讨混合精度训练的基本概念,以及它如何通过利用现代GPU的特定功能来优化AI模型训练过程。随后的章节将详细分析混合精度训练的理论细节、实际操作技巧、应用案例以及高级技术的未来趋势。

# 2. PyTorch中的混合精度训练理论

## 2.1 深度学习中的数值精度

### 2.1.1 浮点数表示和精度损失

在深度学习中,浮点数用于表示各种数值,包括权重、激活值、梯度等。浮点数的标准定义包括三部分:符号位、指数位和尾数位。符号位用来表示正负,指数位用来表示数值范围,尾数位用来表示数值精度。

由于深度学习模型的参数众多,浮点数的精度至关重要。在数值运算过程中,浮点数可能因为位数限制而发生精度损失。精度损失可能来源于以下几个方面:

- 数值溢出:当数值超出浮点数能表示的范围时,会发生溢出,导致无法准确表示。

- 数值下溢:当数值过小,小到尾数位无法有效表示时,数值会下溢至零。

- 截断误差:在数值运算过程中,小数点后截断导致的精度损失。

- 近似运算:例如激活函数、归一化等在数值上引入的近似误差。

由于这些原因,模型在训练和推理过程中可能会受到影响,产生不精确的结果。

### 2.1.2 混合精度训练的数学原理

混合精度训练是一种通过使用不同精度(例如float16和float32)的数值来训练神经网络的方法。其核心思想是使用低精度(float16)来减少内存占用和加速计算,同时使用高精度(float32)来维持数值稳定性。

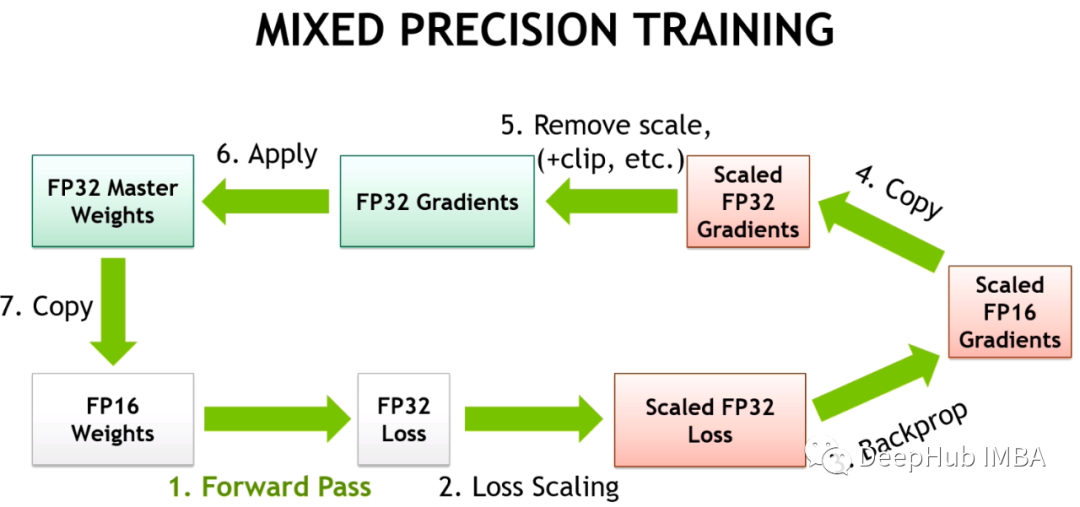

具体来说,混合精度训练的过程涉及以下几个关键点:

- **模型权重和激活值的存储**:使用float16可以减少内存占用和提高计算速度。

- **前向传播**:数据和模型的参数以float16形式进行计算。

- **损失函数和后向传播**:由于可能存在的数值精度损失,损失函数和梯度计算仍然在float32中执行以保证精度。

- **优化器步骤**:最终的模型更新是在float16中执行的,这是因为优化器步骤涉及到的数值通常不会太小。

在这个过程中,混合精度训练使用了一个称为**损失缩放**的技术来防止梯度消失。损失缩放是将损失值缩放一个大的因子,这通常在前向传播前或计算损失时进行。缩放后的损失反向传播,并在梯度更新前进行梯度裁剪,以防止梯度过大,影响模型训练。

## 2.2 混合精度训练的优势与挑战

### 2.2.1 提升模型训练速度

混合精度训练利用了现代GPU的高级计算能力,比如NVIDIA的Tensor Core,这些硬件加速器可以对float16类型的数值进行加速计算。这意味着,在相同的硬件资源下,使用混合精度训练可以显著提高训练速度,缩短模型训练周期。

一般来说,相比于单精度(float32),使用float16可以获得2倍左右的训练速度提升。在实际应用中,这种加速效果甚至可以达到4倍以上,尤其是在涉及到大规模模型和数据集时更为显著。

### 2.2.2 精度与速度的权衡分析

虽然混合精度训练可以提高训练速度,但是必须要注意精度与速度之间的权衡。在某些情况下,使用float16可能会因为精度损失导致模型性能下降。这通常发生在激活函数或权重更新时,如果数值过小或过大,则可能会导致数值计算不稳定。

为了应对这个问题,混合精度训练通常结合损失缩放技术,来确保在训练过程中梯度不会因为float16的限制而下溢。此外,混合精度训练通常需要仔细调整损失缩放的大小,以及在必要时使用float32来执行关键的数值运算步骤,以保证模型的性能不受影响。

### 2.2.3 潜在风险和应对策略

混合精度训练的一个潜在风险是梯度消失或爆炸。由于float16相比于float32有更窄的数值范围,因此在不恰当的训练设置下可能会导致梯度的消失或爆炸。

为应对这一风险,可以采取以下策略:

- **梯度裁剪**:对梯度进行裁剪,保证梯度值在一个合理的范围内,防止梯度爆炸。

- **渐进式混合精度**:在训练的初始阶段使用float32,随着训练的进行逐渐切换到float16,让模型先稳定在float32,再过渡到float16。

- **调整学习率**:因为混合精度训练的速度较快,可能需要相应地调整学习率,以避免训练过程中的震荡。

以上这些策略能够帮助开发者有效地平衡精度与速度,在保证模型性能的同时提升训练效率。

# 3. PyTorch混合精度训练实践

在深度学习领域,模型训练通常需要大量的计算资源,尤其是在处理复杂的数据集和神经网络时。随着硬件技术的发展,GPU成为了深度学习训练的主要加速器。然而,GPU的计算能力和内存资源是有限的,尤其是在训练大型模型时。混合精度训练(Mixed Precision Training)是一种有效的优化策略,可以显著提高训练速度,同时减少对内存的需求。

## 3.1 PyTorch混合精度API使用指南

### 3.1.1 自动混合精度(AMP)功能介绍

PyTorch 1.6版本引入了自动混合精度(AMP),允许开发者以更少的代码变更来实现混合精度训练。AMP 自动管理数据类型转换,将模型权重和部分中间张量(tensors)从float32转换为float16,以利用GPU的加速性能。

要启用AMP,只需在训练循环之前添加以下两行代码:

```python

from torch.cuda.amp import autocast

from torch.cuda.amp import GradScaler

# 初始化GradScaler

scaler = GradScaler()

# 在训练循环中

for input, target in data:

optimizer.zero_grad()

with autocast(): # 开启自动混合精度模式

output = model(input)

loss = loss_fn(output, target)

# 计算loss的梯度,同时保持在float32中

scaler.scale(loss).backward()

# 使用scaler来更新权重

scaler.step(optimizer)

scaler.update()

```

在这段代码中,`autocast` 上下文管理器负责将代码块内的操作自动转换为混合精度,而`GradScaler`则负责梯度缩放,以防止在反向传播时由于float16的限制导致的数值溢出问题。

### 3.1.2 手动混合精度的实现步骤

虽然AMP简化了混合精度训练的实现,但在某些情况下,开发者可能需要更细粒度的控制。手动混合精度包括几个关键步骤:数据类型转换、操作符覆盖、以及梯度缩放。

首先,定义模型时,部分参数和操作需要被指定为float16:

```python

model = MyModel().cuda().half() # 将模型权重转换为float16

model.train()

```

0

0