PyTorch模型的梯度累积:处理大规模数据的革命性技巧

发布时间: 2024-12-11 17:18:15 阅读量: 12 订阅数: 12

PyTorch中的梯度累积:提升小批量训练效率

# 1. 梯度累积概念和原理

梯度累积是深度学习训练中的一种技术,它允许我们通过增加单个批次的迭代次数来处理超出单个GPU内存限制的数据。这种方法在大规模数据集上尤其有用,可以有效提升模型性能而不需要购买更大的内存设备。

## 1.1 梯度累积的基本原理

在标准的梯度下降中,一次迭代涉及整个数据集的前向传播和反向传播。然而,在内存限制的情况下,数据需要被划分为更小的批次进行迭代。通过梯度累积,我们可以将这些小批次的梯度暂存起来,并在一定次数的迭代后进行一次大的权重更新,以保持整体的训练效果。

## 1.2 梯度累积的动机和优势

使用梯度累积,训练过程可以更加灵活,允许在有限的资源下训练更大的模型,或使用更大的批量大小以提高训练的效率和效果。同时,这种方法也可以辅助优化超参数,比如学习率和批量大小,进而可能提升模型的最终性能。

# 2. PyTorch模型梯度累积的实现

## 2.1 PyTorch基础知识回顾

### 2.1.1 PyTorch核心组件概览

PyTorch是当前最流行的深度学习框架之一,它提供了一套直观的API,使得深度学习模型的构建和训练更加高效。PyTorch核心组件主要包括:

- **张量(Tensor)**: 是PyTorch中的基础数据结构,与NumPy的ndarray类似,但可以在GPU上运行。

- **自动微分(Autograd)**: 自动计算梯度的引擎,它支持所有操作都是可微的。

- **神经网络模块(nn.Module)**: 包含了构建神经网络所需的所有操作。

- **优化器(Optim)**: 用于更新网络权重的一系列算法。

PyTorch的灵活性和动态计算图的特性使得它在研究和生产中都非常受欢迎。它允许研究人员快速尝试新想法,并且为生产提供了清晰的代码结构。

### 2.1.2 自动微分和反向传播机制

自动微分是深度学习框架的核心,它使得计算梯度变得简单和自动化。PyTorch使用动态计算图(也称为定义-运行模式)来实现自动微分。

- **定义阶段**: 在这个阶段,用户定义一个由操作组成的网络,这些操作会创建一个计算图。

- **运行阶段**: 用户执行这个图,PyTorch在执行时会记录操作和梯度。

当调用`.backward()`方法时,PyTorch会使用链式法则自动计算图中每个张量的梯度。这个过程就是反向传播,它是训练深度学习模型的基础。

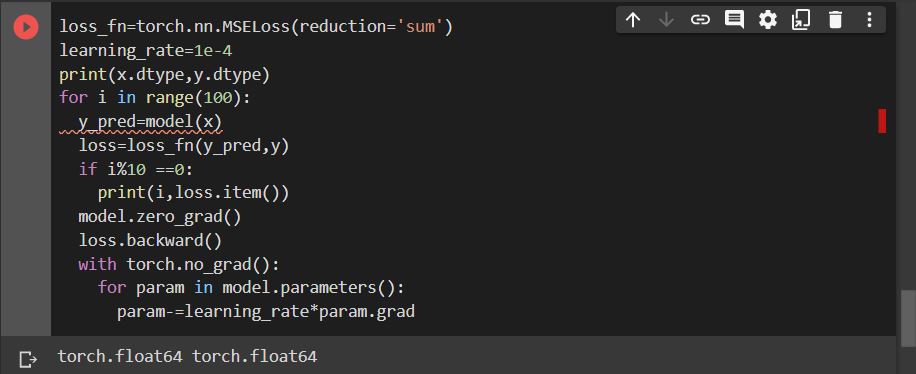

## 2.2 梯度累积的基本步骤

### 2.2.1 单次迭代的梯度计算

在梯度累积的上下文中,单次迭代意味着模型一次前向和一次反向传播。每次迭代后,会计算当前批次的梯度。

```python

for data, target in dataset:

optimizer.zero_grad() # 清空梯度

output = model(data) # 前向传播

loss = criterion(output, target) # 计算损失

loss.backward() # 反向传播计算梯度

optimizer.step() # 更新模型权重

```

在上述代码中,`optimizer.zero_grad()`是必要的,因为在PyTorch中优化器的梯度会累加,如果不清空,则每次调用`.backward()`时梯度会累加。

### 2.2.2 累积梯度的更新策略

梯度累积的实现是通过在一个更大的批次上分几次迭代来完成。下面是一个简单的梯度累积更新策略示例:

```python

accumulation_steps = 4

for epoch in range(num_epochs):

for i, (data, target) in enumerate(train_loader):

optimizer.zero_grad()

outputs = model(data)

loss = criterion(outputs, target)

# 累积梯度

(loss / accumulation_steps).backward()

if (i + 1) % accumulation_steps == 0:

optimizer.step()

```

在这个例子中,我们把一个批次分成了四个小批次,在四个小批次之后,我们执行一次`.step()`来更新权重。这实际上模拟了一个更大的批次大小,但并没有真的增加内存使用。

## 2.3 实战:编写梯度累积代码

### 2.3.1 数据加载和预处理

数据加载和预处理是深度学习中的重要步骤。在这里,我们假设已经有了一个数据集,其已经被加载到`torch.utils.data.DataLoader`中。

```python

from torchvision import transforms

from torch.utils.data import DataLoader

from torchvision.datasets import ImageFolder

# 数据预处理

data_transforms = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

train_dataset = ImageFolder(root='data/train', transform=data_transforms)

train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True, num_workers=4)

```

在这个例子中,我们加载了一个图像数据集,并应用了一系列预处理步骤,包括调整图像大小、转换为张量和标准化。

### 2.3.2 模型训练循环与梯度累积实现

结合前面的理论知识,接下来我们将实现一个具体的模型训练循环,使用梯度累积技术。

```python

import torch

from torch import nn

from torch.nn import functional as F

# 假设我们有一个定义好的模型

model = ... # 模型实例化

# 指定损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters())

# 设置累积梯度的步骤数

accumulation_steps = 4

model.train() # 设置模型为训练模式

for epoch in range(num_epochs):

for i, (data, target) in enumerate(train_loader):

optimize

```

0

0