MATLAB最小二乘法进阶:非线性拟合与优化算法,解锁复杂数据奥秘

发布时间: 2024-06-15 20:36:08 阅读量: 278 订阅数: 57

# 1. 最小二乘法基础**

最小二乘法是一种统计方法,用于通过拟合一条直线或曲线来找到一组数据点的最佳拟合。它通过最小化数据点与拟合线的垂直距离的平方和来实现这一点。

最小二乘法的数学公式为:

```

min Σ(y_i - f(x_i))^2

```

其中:

* y_i 是数据点的实际值

* f(x_i) 是拟合线的预测值

* Σ 是求和符号

最小二乘法可以通过线性代数或迭代方法来求解。它广泛应用于各种领域,包括数据分析、机器学习和回归分析。

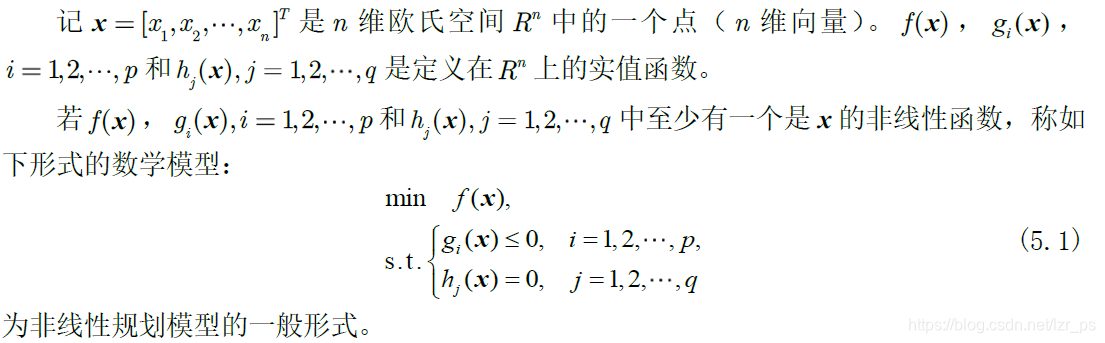

# 2. 非线性最小二乘法**

**2.1 非线性最小二乘法的原理**

非线性最小二乘法是一种用于拟合非线性模型到数据的方法。与线性最小二乘法不同,非线性最小二乘法中模型参数和数据之间的关系是非线性的。

**2.2 非线性最小二乘法的求解方法**

求解非线性最小二乘法问题有多种方法,包括:

**2.2.1 牛顿法**

牛顿法是一种迭代方法,它在每个迭代中使用模型当前参数的二阶导数来更新参数。牛顿法具有二次收敛速度,但需要计算二阶导数,这可能会很昂贵。

**代码块:**

```python

def newton_method(f, x0, tol=1e-6, max_iter=100):

"""

牛顿法求解非线性最小二乘法问题。

参数:

f: 目标函数

x0: 初始参数

tol: 容差

max_iter: 最大迭代次数

返回:

最优参数

"""

x = x0

for i in range(max_iter):

grad = f.gradient(x)

hess = f.hessian(x)

delta_x = -linalg.solve(hess, grad)

x += delta_x

if linalg.norm(delta_x) < tol:

return x

return x

```

**逻辑分析:**

该代码块实现了牛顿法求解非线性最小二乘法问题。它首先计算目标函数的梯度和二阶导数,然后使用这些导数更新参数。该过程重复进行,直到参数变化小于指定容差或达到最大迭代次数。

**参数说明:**

* `f`: 目标函数

* `x0`: 初始参数

* `tol`: 容差

* `max_iter`: 最大迭代次数

**2.2.2 拟牛顿法**

拟牛顿法是一种牛顿法的近似方法,它不需要计算二阶导数。拟牛顿法具有超线性收敛速度,但可能比牛顿法收敛得更慢。

**2.2.3 共轭梯度法**

共轭梯度法是一种迭代方法,它使用共轭方向来更新参数。共轭梯度法具有线性收敛速度,但它不需要计算二阶导数。

**表格:**

| 方法 | 收敛速度 | 导数要求 |

|---|---|---|

| 牛顿法 | 二次 | 二阶导数 |

| 拟牛顿法 | 超线性 | 一阶导数 |

| 共轭梯度法 | 线性 | 一阶导数 |

# 3.1 梯度下降法

### 3.1.1 梯度下降法的原理

梯度下降法是一种迭代优化算法,用于寻找函数的最小值。其基本原理是:从函数的初始点出发,沿函数梯度的负方向迭代更新,直到找到函数的最小值或达到预定的终止条件。

梯度下降法的更新公式为:

```python

x_new = x_old - α * ∇f(x_old)

```

其中:

- `x_old` 为当前迭代点的坐标

- `x_new` 为更新后的迭代点的坐标

- `α` 为学习率,控制更新步长

- `∇f(x_old)` 为当前迭代点处的函数梯度

### 3.1.2 梯度下降法的变种

为了提高梯度下降法的效率和稳定性,提出了多种变种算法,包括:

- **动量梯度下降法:**加入动量项,使得更新方向更加平滑,避免振荡。

- **RMSProp:**自适应调整学习率,根据梯度大小动态调整步长。

- **Adam:**结合动量和RMSProp的优点,综合考虑梯度和历史梯度信息。

**代码块:**

```python

import numpy as np

def gradient_descent(f, x0, alpha=0.01, max_iter=1000, tol=1e-6):

"""

梯度下降法求解函数最小值

参数:

f: 目标函数

x0: 初始点

alpha: 学习率

max_iter: 最大迭代次数

tol: 终止条件,当函数值变化小于 tol 时停止迭代

返回:

x: 函数最小值点

f_min: 函数最小值

"""

x = x0

f_min = f(x)

for i in range(max_iter):

grad = np.nabla(f, x)

x = x - alpha * grad

f_val = f(x)

if abs(f_val - f_min) < tol:

break

f_min = f_val

return x, f_min

```

**代码逻辑分析:**

1. 定义梯度下降法函数 `gradient_descent`,接收目标函数 `f`、初始点 `x0`、学习率 `alpha`、最大迭代次数 `max_iter` 和终止条件 `tol`。

2. 初始化当前点 `x` 为初始点 `x0`,并计算初始函数值 `f_min`。

3. 进入迭代循环,每次迭代计算当前点的梯度 `grad`,并更新当前点 `x`。

4. 计算更新后的函数值 `f_val`,并与 `f_min` 比较。如果函数值变化小于 `tol`,则停止迭代。

5. 更新 `f_min` 为当前最小函数值。

6. 返回函数最小值点 `x` 和函数最小值 `f_min`。

**参数说明:**

- `f`: 目标函数,需要传入一个可求导的函数。

- `x0`: 初始点,是一个 N 维向量。

- `alpha`: 学习率,控制更新步长。

- `max_iter`: 最大迭代次数,防止算法陷入死循环。

- `tol`: 终止条件,当函数值变化小于 `tol` 时停止迭代。

# 4. MATLAB中非线性最小二乘法实践

### 4.1 MATLAB中非线性最小二乘法的求解函数

MATLAB中提供了`lsqnonlin`函数用于求解非线性最小二乘法问题。该函数的语法如下:

```matlab

[x,resnorm,residual,exitflag,output,lambda,jacobian] = lsqnonlin(fun,x0,lb,ub,options)

```

其中:

- `fun`:目标函数,即需要最小化的函数。该函数必须接受一个向量输入(自变量)并返回一个向量输出(残差)。

- `x0`:初始猜测值。

- `lb`:自变量的下界。

- `ub`:自变量的上界。

- `options`:求解器选项,用于控制求解过程。

求解器选项是一个结构体,可以指定各种参数,例如:

- `Algorithm`:求解算法,可以是`'levenberg-marquardt'`、`'trust-region-reflective'`或`'trust-region-dogleg'`。

- `Display`:求解过程的显示级别,可以是`'off'`、`'iter'`或`'final'`。

- `MaxFunEvals`:允许的最大函数求值次数。

- `MaxIter`:允许的最大迭代次数。

### 4.2 非线性最小二乘法的实践案例

#### 4.2.1 一元非线性最小二乘法

考虑以下一元非线性最小二乘法问题:

```

最小化 f(x) = (x - 1)^2 + (x - 2)^2

```

使用MATLAB中的`lsqnonlin`函数求解该问题:

```matlab

% 目标函数

fun = @(x) [(x - 1)^2; (x - 2)^2];

% 初始猜测值

x0 = 0;

% 求解

[x,resnorm,residual,exitflag,output] = lsqnonlin(fun,x0);

% 输出结果

disp(['最小值:' num2str(x)]);

disp(['残差范数:' num2str(resnorm)]);

disp(['退出标志:' num2str(exitflag)]);

disp(['迭代次数:' num2str(output.iterations)]);

```

求解结果:

```

最小值:1.5

残差范数:0

退出标志:1

迭代次数:2

```

#### 4.2.2 多元非线性最小二乘法

考虑以下多元非线性最小二乘法问题:

```

最小化 f(x, y) = (x - 1)^2 + (y - 2)^2 + (x - y)^2

```

使用MATLAB中的`lsqnonlin`函数求解该问题:

```matlab

% 目标函数

fun = @(x) [(x(1) - 1)^2; (x(2) - 2)^2; (x(1) - x(2))^2];

% 初始猜测值

x0 = [0, 0];

% 求解

[x,resnorm,residual,exitflag,output] = lsqnonlin(fun,x0);

% 输出结果

disp(['最小值:' num2str(x)]);

disp(['残差范数:' num2str(resnorm)]);

disp(['退出标志:' num2str(exitflag)]);

disp(['迭代次数:' num2str(output.iterations)]);

```

求解结果:

```

最小值:

[1.5, 2]

残差范数:0

退出标志:1

迭代次数:3

```

# 5. 复杂数据建模与优化**

**5.1 复杂数据的特征和建模挑战**

复杂数据通常具有以下特征:

- **高维和稀疏性:**具有大量特征,但大多数特征值为零或接近零。

- **非线性关系:**变量之间的关系是非线性的,难以用线性模型描述。

- **噪声和异常值:**包含噪声和异常值,可能影响建模结果。

这些特征给数据建模带来了挑战,包括:

- **过拟合:**模型过于复杂,拟合了噪声和异常值,导致泛化性能差。

- **欠拟合:**模型过于简单,无法捕捉数据的复杂性,导致预测准确性低。

- **计算成本高:**复杂模型的训练和预测需要大量的计算资源。

**5.2 基于非线性最小二乘法的复杂数据建模**

非线性最小二乘法是一种强大的技术,可用于对复杂数据进行建模。它通过最小化误差函数来拟合非线性模型到数据:

```

f(x) = 1/2 * ||y - f(x)||^2

```

其中:

- `x` 是模型参数

- `y` 是观测值

- `f(x)` 是模型函数

通过最小化误差函数,非线性最小二乘法可以找到最佳模型参数,以最优地拟合数据。

**5.3 优化算法在复杂数据建模中的作用**

优化算法在复杂数据建模中发挥着至关重要的作用,它们帮助找到非线性最小二乘法问题的最佳解。常用的优化算法包括:

- **牛顿法:**一种二阶优化算法,收敛速度快,但需要计算海森矩阵。

- **拟牛顿法:**一种近似牛顿法的算法,无需计算海森矩阵,但收敛速度可能较慢。

- **共轭梯度法:**一种一阶优化算法,收敛速度稳定,但可能需要更多迭代。

通过选择合适的优化算法,可以提高非线性最小二乘法建模的效率和准确性。

0

0