ResNet50模型在图像分类中的应用:案例研究和最佳实践,引领图像分类新时代

发布时间: 2024-07-03 17:27:15 阅读量: 115 订阅数: 76

一个使用Androidstudio开发的校园通知APP

# 1. ResNet50模型概述

ResNet50模型是计算机视觉领域中一个强大的卷积神经网络(CNN),因其在图像分类任务中的卓越表现而闻名。它由微软研究院的何凯明等人于2015年提出,以其残差连接结构而著称,该结构允许网络在更深的层数上训练,而不会出现梯度消失或爆炸问题。

ResNet50模型包含50个卷积层,其架构由多个残差块组成。每个残差块都包含一个跳过连接,该连接将输入直接传递到输出,从而允许梯度在训练过程中直接流过网络。这种结构使ResNet50模型能够学习更复杂的特征表示,从而提高了其分类精度。

# 2. ResNet50模型的理论基础

### 2.1 卷积神经网络(CNN)的原理

**2.1.1 卷积操作**

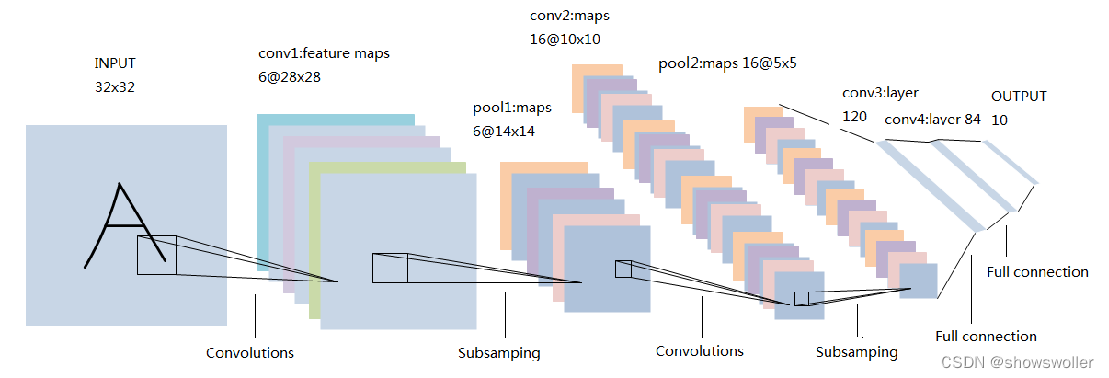

卷积神经网络(CNN)是一种深度学习模型,它使用卷积操作来提取图像中的特征。卷积操作涉及将一个称为卷积核的小矩阵与输入图像的子区域进行逐元素相乘,然后将结果求和。卷积核在图像上滑动,生成一个称为特征图的新图像。特征图中的每个像素值表示卷积核在该位置检测到的特定特征的强度。

**代码块:**

```python

import numpy as np

# 定义卷积核

kernel = np.array([[1, 0, -1],

[0, 1, 0],

[-1, 0, 1]])

# 定义输入图像

image = np.array([[1, 2, 3],

[4, 5, 6],

[7, 8, 9]])

# 执行卷积操作

feature_map = np.convolve(image, kernel, mode='valid')

print(feature_map)

```

**逻辑分析:**

该代码演示了卷积操作。卷积核是一个 3x3 的矩阵,用于检测图像中的边缘特征。卷积操作将卷积核与图像的每个 3x3 子区域进行逐元素相乘,然后将结果求和。得到的特征图是一个 1x1 的矩阵,其中包含图像中边缘特征的强度。

**2.1.2 池化操作**

池化操作是一种降采样技术,用于减少特征图的大小。池化操作涉及将特征图划分为小块,然后对每个块应用最大值或平均值函数。这有助于减少特征图中的冗余信息,同时保留重要的特征。

**代码块:**

```python

import numpy as np

# 定义特征图

feature_map = np.array([[1, 2, 3],

[4, 5, 6],

[7, 8, 9]])

# 执行最大值池化操作

max_pool = np.max_pool(feature_map, pool_size=(2, 2), strides=(2, 2))

print(max_pool)

```

**逻辑分析:**

该代码演示了最大值池化操作。池化大小为 2x2,步长也为 2x2。这意味着特征图被划分为 2x2 的块,并且对每个块应用最大值函数。得到的池化特征图大小为 1x1,其中包含特征图中最大值的强度。

### 2.2 ResNet模型的架构

**2.2.1 残差块的设计**

ResNet模型的核心是残差块。残差块是一种跳跃连接,它允许梯度在训练过程中直接从输入层流向输出层。这有助于缓解梯度消失问题,并提高模型的训练稳定性。

**代码块:**

```python

import tensorflow as tf

# 定义残差块

class ResidualBlock(tf.keras.layers.Layer):

def __init__(self, filters, strides=1):

super(ResidualBlock, self).__init__()

self.filters = filters

self.strides = strides

# 定义残差块的层

self.conv1 = tf.keras.layers.Conv2D(filters, (3, 3), strides=strides, padding='same')

self.bn1 = tf.keras.layers.BatchNormalization()

self.relu1 = tf.keras.layers.ReLU()

self.conv2 = tf.keras.layers.Conv2D(filters, (3, 3), strides=1, padding='same')

self.bn2 = tf.keras.layers.BatchNormalization()

def call(self, inputs):

# 残差路径

x = self.conv1(inputs)

x = self.bn1(x)

x = self.relu1(x)

x = self.conv2(x)

x = self.bn2(x)

# 跳跃连接

if self.strides == 1:

return x + inputs

else:

# 对于步长不为 1 的情况,需要使用 1x1 卷积来匹配输入和输出的维度

shortcut = tf.keras.layers.Conv2D(self.filters, (1, 1), strides=self.strides, padding='same')(inputs)

return x + shortcut

```

**逻辑分析:**

该代码定义了一个残差块。残差块包含两个卷积层,每个卷积层后面跟着一个批量归一化层和一个 ReLU 激活函数。残差块还包含一个

0

0