ResNet50模型在金融科技中的应用:赋能金融风险管理和预测,助力金融行业更稳健

发布时间: 2024-07-03 17:54:47 阅读量: 59 订阅数: 75

基于ResNet50的模型结构:ResNet50-ImageNet-CNTK

# 1. 金融科技概述**

金融科技(FinTech)是指利用技术创新来提供金融服务。它融合了金融和技术的优势,为金融行业带来了革命性的变革。金融科技应用广泛,包括移动支付、数字银行、理财管理、保险科技等领域。

金融科技的发展得益于以下因素:

* **技术进步:**云计算、大数据、人工智能等技术的发展为金融科技提供了强大的技术支持。

* **监管环境:**政府对金融科技的监管逐渐完善,为其发展提供了规范和保障。

* **用户需求:**随着移动互联网的普及,用户对便捷、个性化金融服务的需求不断增长。

# 2. ResNet50模型的理论基础

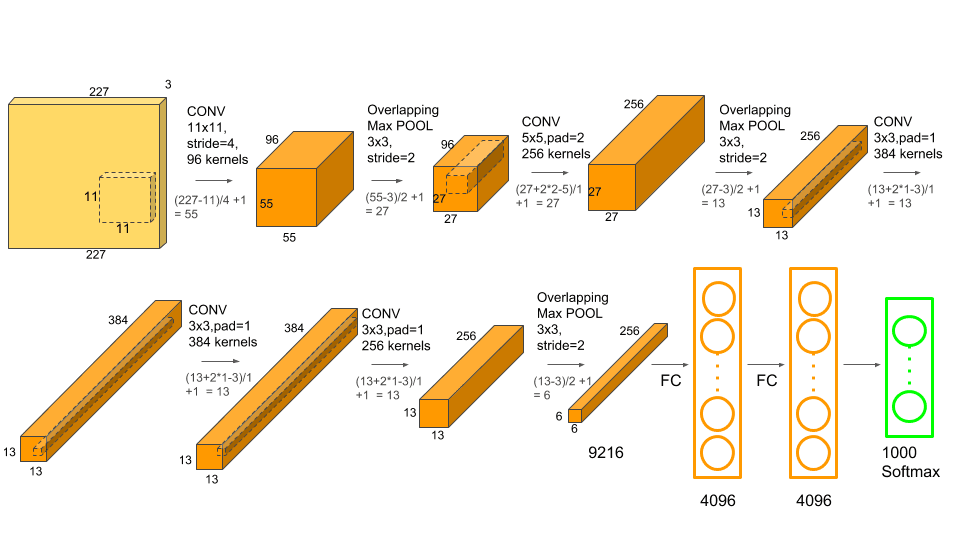

### 2.1 卷积神经网络(CNN)的基本原理

卷积神经网络(CNN)是一种深度学习模型,特别适用于处理图像数据。其基本原理基于卷积运算和池化操作。

**2.1.1 卷积操作**

卷积操作是CNN的核心操作。它通过一个称为卷积核(或滤波器)的权重矩阵与输入数据进行卷积计算,生成特征图。卷积核在输入数据上滑动,逐个元素相乘并求和,得到一个新的值。这个值代表了输入数据中特定模式或特征的强度。

**代码块:**

```python

import numpy as np

# 定义卷积核

kernel = np.array([[1, 0, -1],

[0, 1, 0],

[-1, 0, 1]])

# 定义输入数据

input_data = np.array([[1, 2, 3],

[4, 5, 6],

[7, 8, 9]])

# 执行卷积操作

output_feature_map = np.convolve(input_data, kernel, mode='valid')

# 打印输出特征图

print(output_feature_map)

```

**逻辑分析:**

此代码演示了卷积操作。卷积核是一个3x3的矩阵,它在输入数据上滑动,逐个元素相乘并求和。输出特征图是一个2x2的矩阵,其中每个元素表示输入数据中特定模式或特征的强度。

**2.1.2 池化操作**

池化操作是CNN中另一种重要的操作。它通过将相邻元素分组并取最大值或平均值来减少特征图的大小。池化操作可以减少计算量,同时保留重要特征。

**代码块:**

```python

import numpy as np

# 定义输入特征图

input_feature_map = np.array([[1, 2, 3],

[4, 5, 6],

[7, 8, 9]])

# 执行最大池化操作

max_pool_output = np.max_pool_2d(input_feature_map, pool_size=(2, 2), strides=(2, 2))

# 打印最大池化输出

print(max_pool_output)

```

**逻辑分析:**

此代码演示了最大池化操作。池化大小为2x2,步长也为2x2。这意味着卷积核在输入特征图上以2x2的步长滑动,并取每个2x2区域中的最大值。输出特征图是一个1x1的矩阵,其中每个元素表示输入特征图中特定区域的最大值。

### 2.2 ResNet50模型的结构和特点

ResNet50模型是一种深度残差网络,由微软研究院在2015年提出。它在ImageNet图像分类竞赛中取得了突破性的成绩,成为当时最先进的图像分类模型之一。

**2.2.1 残差块**

残差块是ResNet50模型的核心组成部分。它通过将输入数据与跳过连接(shortcut connection)相加,来解决深度神经网络中梯度消失和退化问题。

**代码块:**

```python

import tensorflow as tf

# 定义残差块

class ResidualBlock(tf.keras.Model):

def __init__(self, filters):

super(ResidualBlock, self).__init__()

self.conv1 = tf.keras.layers.Conv2D(filters, (3, 3), padding='same')

self.bn1 = tf.keras.layers.BatchNormalization()

self.relu1 = tf.keras.layers.ReLU()

self.conv2 = tf.keras.layers.Conv2D(filters, (3, 3), padding='same')

self.bn2 = tf.keras.layers.BatchNormalization()

def call(self, inputs):

x = self.conv1(inputs)

x = self.bn1(x)

x = self.relu1(x)

x = self.conv2(x)

x = self.bn2(x)

return inputs + x

```

**逻辑分析:**

此代码定义了一个残差块。残差块包含两个卷积层,每个卷积层后面跟着一个批归一化层和一个ReLU激活函数。跳过连接将输入数据直接与残差块的输出相加。

**2.2.2 跨层连接**

跨层连接是ResNet50模型的另一个重要特征。它允许不同层之间的特征直接相连,从而改善了梯度流和模型的训练稳定性。

**代码块:**

```python

import tensorflow as tf

# 定义ResNet50模型

class ResNet50(tf.keras.Model):

def __init__(self):

super(ResNet50, self).__init__()

self.conv1 = tf.keras.layers.Conv2D(64, (7, 7), strides=(2, 2), padding='same')

self.bn1 = tf.keras.layers.BatchNormalization()

self.relu1 = tf.keras.layers.ReLU()

self.max_pool1 = tf.keras.layers.MaxPooling2D((3, 3), strides=(2, 2), padding='same')

# 定义残差块组

```

0

0