【R语言文本挖掘与预测】:从数据清洗到模型构建的完整流程

发布时间: 2024-11-04 07:58:40 阅读量: 30 订阅数: 46

基于微信小程序的社区门诊管理系统php.zip

# 1. R语言在文本挖掘中的应用概述

随着大数据时代的到来,文本数据的挖掘成为了数据科学领域中一个非常重要的分支。文本挖掘,也称文本数据挖掘,是通过分析、处理和挖掘大量的文本数据,以发现数据之间隐藏的有价值信息的过程。R语言作为一种强大的数据分析工具,尤其在统计分析和图形表示上有其独特的优势,使其在文本挖掘领域中扮演了重要的角色。

本章首先会对文本挖掘的概念和重要性进行概述,然后重点介绍R语言在文本挖掘领域的应用。我们会探讨R语言中与文本挖掘相关的包、函数,以及如何利用R语言来构建一个基础的文本挖掘流程,为读者接下来更深入的学习文本数据的清洗、特征提取、模型构建等关键内容打下坚实的基础。

在后续章节中,我们将详细介绍如何使用R语言对文本数据进行清洗、预处理、特征提取,并构建预测模型,以及通过实践案例分析来进一步掌握R语言在文本挖掘中的应用。

通过本章的学习,读者将获得以下能力:

- 理解文本挖掘的基本概念和应用场景。

- 熟悉R语言在文本挖掘领域的优势和应用范围。

- 掌握使用R语言进行文本挖掘的基本流程和方法。

# 2. 文本数据的清洗与预处理

在处理文本数据时,预处理是一个至关重要的步骤。高质量的预处理工作能够有效提升后续分析的准确性和效率。本章将介绍如何使用R语言对文本数据进行清洗和预处理,涵盖从文本导入、初步分析到清洗技术、分词标注、词干提取与词形还原,以及停用词和高频词处理等多个方面。

## 2.1 文本数据的导入与初步探索

### 2.1.1 使用R语言导入文本数据

在R语言中,导入文本数据通常使用`readLines`函数,它可以读取文本文件中的每一行。为了处理大型文本文件,使用`read.table`或`read.csv`函数,并设置`sep="\n"`参数,可以按行将文本分割为数据框(data frame)。

```r

# 假设有一个名为textfile.txt的文本文件

text_data <- readLines("textfile.txt", warn = FALSE)

```

一旦文本数据被读取到R中,接下来就是对数据进行初步探索。通过函数`str`可以查看数据的基本结构,通过`summary`可以查看文本数据的统计摘要。

### 2.1.2 文本数据的初步分析

在文本数据的初步分析阶段,我们通常关注的是文本的基本统计特性,比如长度分布、词汇丰富度等。这可以帮助我们了解数据集的特点,并为后续的预处理工作提供依据。

```r

# 计算文本长度

text_lengths <- nchar(text_data)

# 统计文本长度的直方图

hist(text_lengths, breaks = 50, col = "lightblue", main = "Text Length Distribution", xlab = "Length of text", ylab = "Frequency")

# 查看词汇丰富度

word_counts <- unlist(strsplit(text_data, "\\s+"))

unique_words <- length(unique(word_counts))

cat("Unique words in the text dataset:", unique_words, "\n")

```

这些初步分析为我们提供了数据的基本视图,这将有助于我们决定如何进一步清洗和预处理文本数据。

## 2.2 文本数据的清洗技术

### 2.2.1 清除噪音和无关数据

文本数据经常含有无关的噪音信息,如HTML标签、标点符号、非英文字符等。R语言提供了多种方法来清除这些不需要的噪音和数据。

```r

# 移除HTML标签

library(XML)

text_data <- gsub("<.*?>", "", text_data)

# 移除标点符号

text_data <- gsub("[[:punct:]]", "", text_data)

# 移除非英文字符

text_data <- iconv(text_data, "UTF-8", "ASCII", sub="")

```

### 2.2.2 正则表达式在文本清洗中的应用

正则表达式是一种强大的文本处理工具,可以用来识别复杂的文本模式。R语言的`gsub`函数和`grepl`函数经常用来执行正则表达式的查找和替换操作。

```r

# 使用正则表达式替换特定模式的字符串

text_data <- gsub("\\bhello\\b", "hi", text_data)

# 检查字符串是否包含特定模式

contains_hello <- grepl("\\bhello\\b", text_data)

cat("Contains 'hello':", sum(contains_hello), "\n")

```

## 2.3 文本数据的预处理方法

### 2.3.1 分词与标注

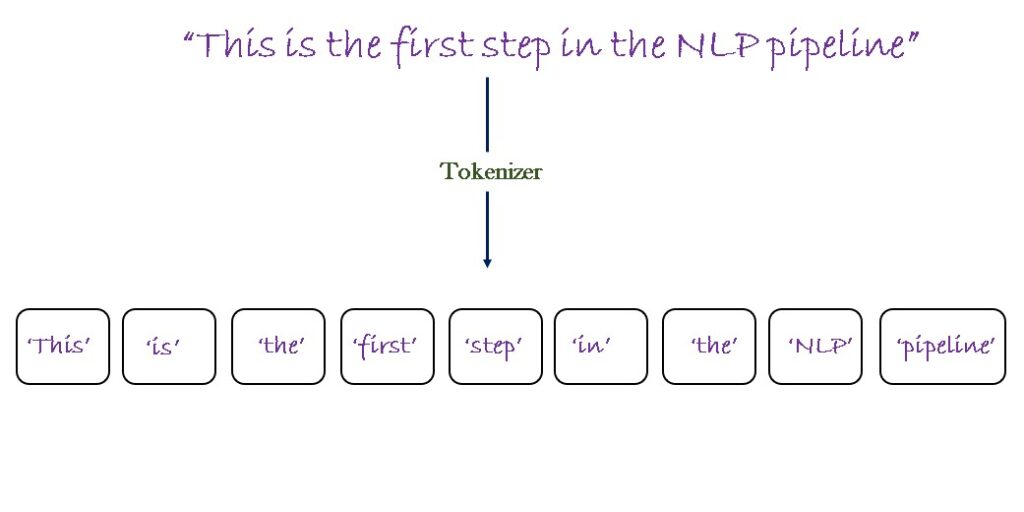

分词是将文本数据分割为单独的词或标记的过程。在R中,可以使用`RWeka`包中的`WekaTokenizer`进行分词。标注则是标记每个词的词性,例如名词、动词等。

```r

# 安装并加载RWeka包

install.packages("RWeka")

library(RWeka)

# 创建分词器实例

tokenizer <- WekaTokenizer("weka.tokenizers.TokensRegex -R")

tokenized_text <- tokenize(tokenizer, text_data)

# 标注词性

tagger <- MaxentTagger("models/english-left3words-distsim.tagger")

tagged_text <- tag(tagger, tokenized_text)

```

### 2.3.2 词干提取与词形还原

词干提取(stemming)是将词汇还原为其词根形式的过程。词形还原(lemmatization)则是将词汇还原为词典中的原形。

```r

# 安装并加载openNLP包

install.packages("openNLP")

library(openNLP)

# 加载词干提取器和词形还原器模型

stem_model <- MaxentStemmer()

lemma_model <- MaxentLemmatizer()

# 应用词干提取和词形还原

stemmed_text <- sapply(tagged_text, function(x) paste(stem_model$stem(x), collapse=" "))

lemmatized_text <- sapply(tagged_text, function(x) paste(lemma_model$lemmatize(x), collapse=" "))

```

### 2.3.3 停用词和高频词处理

停用词是指那些在文本中频繁出现但不携带实际意义的词,如“the”,“is”,“and”。高频词处理涉及识别并处理这些词。

```r

# 加载停用词列表

data("stop_words", package = "tidytext")

# 去除停用词

filtered_text <- lapply(tagged_text, function(x) setdiff(x, stop_words$word))

# 识别高频词

word_freq <- table(unlist(filtered_text))

top_words <- sort(word_freq, decreasing = TRUE)[1:10]

cat("Top 10 most frequent words:", names(top_words), "\n")

```

预处理是文本数据挖掘的关键步骤。通过适当的方法可以提升后续分析的质量,包括模型的构建和结果的准确性。在第三章中,我们将深入探讨特征提取与转换的技术,这是预处理步骤的扩展和深化。

# 3. 文本数据的特征提取与转换

在处理完文本数据的清洗和预处理之后,接下来的步骤是特征提取与

0

0