【R语言数据分析与预测】:手把手教你用数据包和预测函数

发布时间: 2024-11-04 07:04:43 阅读量: 56 订阅数: 28

R语言机器学习实战教程:从基础到进阶,手把手教你构建预测模型

# 1. R语言数据分析基础

在当今数据驱动的世界里,R语言凭借其强大的统计分析能力和灵活的编程环境,在数据分析领域占据着举足轻重的地位。本章将带您入门R语言,介绍如何使用R进行基础的数据分析工作。我们将从R语言的基本概念入手,帮助读者理解R的安装、环境配置,以及如何在R环境中执行基本的命令。此外,本章还将介绍一些基础的函数和数据对象,为您在后续章节中学习更高级的数据分析技术打下坚实的基础。

## 1.1 R语言简介

R是一种用于统计分析、图形表示和报告的编程语言和软件环境。它由Ross Ihaka和Robert Gentleman于1993年开发,并以R语言的首字母命名,现在由R开发核心团队维护。R语言尤其受到数据分析师和统计学家的喜爱,因为它不仅有着丰富的包和库支持,还具有强大的图形能力。

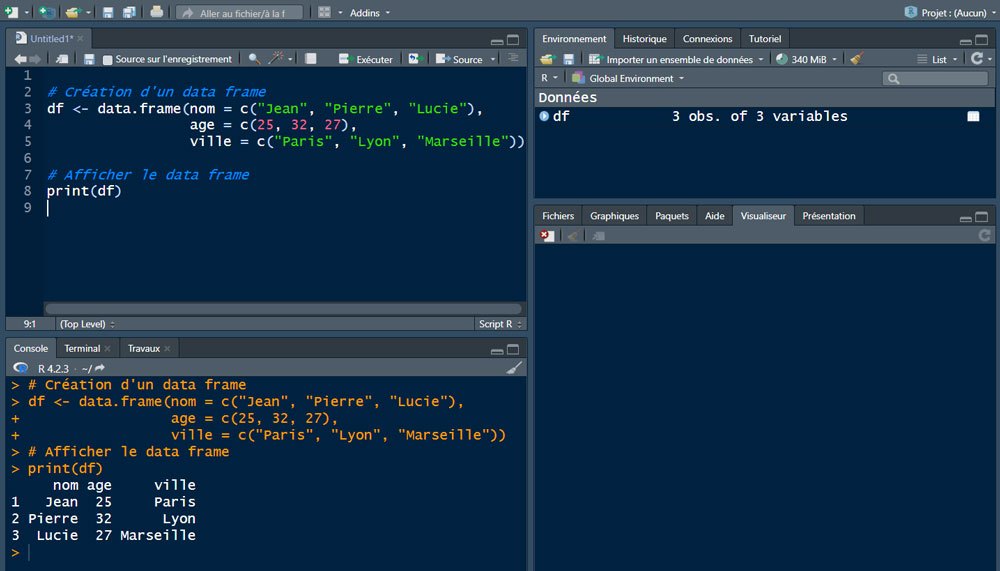

## 1.2 R语言环境安装与配置

在使用R语言之前,首先需要在计算机上安装R环境。可以通过R官方网站下载R语言的安装程序,根据操作系统选择相应的版本。安装完成后,建议安装RStudio——一个流行的R语言集成开发环境(IDE),它提供了代码编辑、运行、调试以及图形显示等功能,极大地方便了R语言的使用。

## 1.3 R语言基础语法

R的基本语法包括变量赋值、数据结构的创建、函数调用等。例如,创建一个向量、一个矩阵、一个数据框(data frame)可以使用`c()`, `matrix()`, `data.frame()`函数。而基本的统计函数如`mean()`, `sum()`, `var()`等用于执行数据分析的常规操作。通过简单地输入命令,我们可以快速得到数据分析的结果。下面是一些示例代码:

```r

# 向量创建

vector <- c(1, 2, 3, 4, 5)

# 矩阵创建

matrix <- matrix(c(1, 2, 3, 4), nrow = 2, ncol = 2)

# 数据框创建

data_frame <- data.frame(Name = c("Alice", "Bob", "Charlie"),

Score = c(90, 85, 95))

# 计算向量的均值

mean(vector)

```

在R语言中,学习如何有效地组织数据、调用函数以及创建图表是进行数据分析的重要基础。接下来的章节将深入介绍R中的数据结构和相关操作。

# 2. 数据清洗与预处理技术

在进行数据分析之前,数据清洗与预处理是至关重要的步骤,它直接影响到分析结果的质量与可靠性。本章节将深入探讨R语言在数据清洗与预处理中的各种技术和方法。

## 2.1 R语言中的数据结构

### 2.1.1 向量、矩阵和数组

在R语言中,数据结构是进行数据分析的基础。其中,向量是最基本的数据结构,可以存储数值、字符或逻辑值。矩阵是一个二维的数值数据结构,而数组是多维的类似结构。

```r

# 创建向量

vector_example <- c(1, 2, 3, 4)

# 创建矩阵

matrix_example <- matrix(1:6, nrow = 2, ncol = 3)

# 创建数组

array_example <- array(1:12, dim = c(2, 3, 2))

```

向量的创建非常简单,只需用`c()`函数将数据组合起来即可。矩阵的创建使用`matrix()`函数,需要指定行数、列数以及数据填充的顺序。数组则进一步扩展到多维,使用`array()`函数,并指定维度。

### 2.1.2 数据框和列表的理解与操作

数据框(data frame)是R中最常用的数据结构之一,它可以存储不同类型的数据,并且每列可以有不同类型的值。列表(list)则更加灵活,可以包含不同类型的对象,包括数据框。

```r

# 创建数据框

data_frame_example <- data.frame(

id = 1:4,

name = c("Alice", "Bob", "Charlie", "David"),

score = c(90, 80, 70, 60)

)

# 创建列表

list_example <- list(

vector = vector_example,

matrix = matrix_example,

data_frame = data_frame_example

)

```

数据框的创建使用`data.frame()`函数,可以将多个向量组合成一个数据框。列表的创建则使用`list()`函数,可以将不同类型的对象组合成一个列表。

## 2.2 数据清洗方法

### 2.2.1 缺失值处理

处理缺失值是数据清洗中常见的一个步骤。在R语言中,可以使用诸如`na.omit()`, `is.na()`, 和`complete.cases()`等函数来检测和处理缺失值。

```r

# 创建一个包含缺失值的数据框

data_frame_with_na <- data_frame_example

data_frame_with_na[1, 3] <- NA

# 查找并处理缺失值

na.omit(data_frame_with_na) # 删除缺失值

data_frame_with_na[is.na(data_frame_with_na)] <- 0 # 将NA替换为0

```

### 2.2.2 异常值检测与处理

异常值可能会对分析结果造成误导。在R语言中,可以通过统计方法(如箱线图)来识别异常值,并决定是删除、替换还是保留这些值。

```r

# 异常值检测

boxplot(data_frame_with_na$score, main = "Boxplot of Scores")

# 异常值处理示例

data_frame_with_na[data_frame_with_na$score > median(data_frame_with_na$score) + 1.5*IQR(data_frame_with_na$score), "score"] <- median(data_frame_with_na$score)

```

### 2.2.3 数据转换与规范化

数据转换可以包括数据标准化、归一化等操作,以便将数据转换为更符合模型需求的格式。在R语言中,`scale()`函数可以实现数据的标准化处理。

```r

# 数据标准化

data_frame_with_na标准化 <- as.data.frame(scale(data_frame_with_na[, -2]))

# 归一化

normalize <- function(x) {

return((x - min(x)) / (max(x) - min(x)))

}

data_frame_with_na归一化 <- as.data.frame(apply(data_frame_with_na[, -2], 2, normalize))

```

## 2.3 数据探索性分析

### 2.3.1 描述性统计分析

描述性统计分析是理解数据集中趋势、离散程度等特征的基础。在R中,可以使用`summary()`, `mean()`, `median()`, `sd()`等函数进行描述性统计分析。

```r

# 描述性统计分析

summary(data_frame_with_na标准化)

mean(data_frame_with_na标准化$score)

median(data_frame_with_na标准化$score)

sd(data_frame_with_na标准化$score)

```

### 2.3.2 数据可视化基础

数据可视化是探索性分析的关键环节,可以快速发现数据中的趋势和模式。R语言提供了多种可视化工具,如基础图形和`ggplot2`包。

```r

# 基础图形包绘制直方图

hist(data_frame_with_na标准化$score, main = "Histogram of Scores", xlab = "Standardized Scores")

# ggplot2绘制箱线图

library(ggplot2)

ggplot(data_frame_with_na标准化, aes(x = "", y = score)) +

geom_boxplot(fill = "steelblue") +

xlab("") + ylab("Standardized Scores")

```

### 2.3.3 进一步的数据探索性分析

除了基础的统计和可视化之外,更深入的数据探索可以借助于关联规则挖掘、主成分分析(PCA)、聚类分析等高级方法,这些都是发现数据潜在结构的重要手段。在本章节的后续部分,我们将进一步探讨如何运用这些技术进行数据探索。

```r

# 进行主成分分析(PCA)

pca_result <- prcomp(data_frame_with_na标准化, center = TRUE, scale. = TRUE)

summary(pca_result)

```

在这一部分中,我们仅仅触及了数据探索的皮毛。在接下来的章节中,我们将进一步深入探索数据结构和数据分布,以更好地准备我们的数据进行后续的高级分析和建模。

# 3. R语言中的统计分析

## 3.1 基础统计分析方法

### 3.1.1 均值、方差和标准差

在数据分析中,均值、方差和标准差是最基础也是最重要的统计量,它们能够帮助我们了解数据集的整体趋势和分散程度。均值是所有数据值的总和除以数据个数,它为我们提供了数据集的中心位置。在R语言中,计算均值可以使用`mean()`函数。

```r

# 假设有一个向量data

data <- c(1, 2, 3, 4, 5)

# 计算均值

mean_value <- mean(data)

print(mean_value)

```

方差描述了数据点与均值的偏差平方的平均值,它是衡量数据分散程度的一个重要指标。在R中,我们可以使用`var()`函数来计算方差。

```r

# 假设data向量如上

variance_value <- var(data)

print(variance_value)

```

标准差是方差的平方根,它具有相同的单位,因此更易于解释。`sd()`函数在R中用于计算标准差。

```r

# 假设data向量如上

standard_deviation <- sd(data)

print(standard_deviation)

```

### 3.1.2 相关性分析

在统计学中,相关性分析是用来研究两个或多个变量之间相关程度的方法。在R语言中,我们可以使用`cor()`函数来计算两个变量之间的相关系数。相关系数的值介于-1到1之间,-1表示完全负相关,1表示完全正相关,0表示没有线性相关。

```r

# 假设有两个向量x和y

x <- c(1, 2, 3, 4, 5)

y <- c(5, 4, 2, 3, 1)

# 计算相关系数

correlation <- cor(x, y)

print(correlation)

```

### 3.2 假设检验

#### 3.2.1 t检验和卡方检验

t检验用于比较两组数据的均值是否存在显著差异,而卡方检验常用于观察数据与期望数据之间的一致性。在R中,可以使用`t.test()`和`chisq.test()`函数进行这两种检验。

```r

# t检验示例

t_test_result <- t.test(x, y)

print(t_test_result)

# 卡方检验示例

# 假设有一个频数表frequency_table

frequency_table <- matrix(c(10, 20, 15, 25), nrow = 2)

rownames(frequency_table) <- c("Actual", "Expected")

colnames(frequency_table) <- c("Group1", "Group2")

chisq_test_result <- chisq.test(frequency_table)

print(chisq_test_result)

```

#### 3.2.2 方差分析(ANOVA)

方差分析(ANOVA)是一种统计方法,用于检验三个或更多个组别间均值是否存在显著差异。在R中,可以使用`aov()`函数来进行方差分析。

```r

# 假设有一个数据框df,包含分组变量group和响应变量response

df <- data.frame(

group = factor(c(rep("A", 30), rep("B", 30), rep("C", 30))),

response = c(rnorm(30, mean = 0), rnorm(30, mean = 1), rnorm(30, mean = 2))

)

anova_result <- aov(response ~ group, data = df)

summary(anova_result)

```

### 3.3 回归分析

#### 3.3.1 线性回归模型

线性回归是建立一个变量(因变量)和一组变量(自变量)之间线性关系的模型。在R中,可以使用`lm()`函数来拟合线性回归模型。

```r

# 假设有一个数据框data,包含自变量x和因变量y

data <- data.frame(

x = 1:100,

y = 2 * 1:100 + rnorm(100, sd = 10)

)

# 拟合线性模型

lm_model <- lm(y ~ x, data = data)

summary(lm_model)

```

#### 3.3.2 逻辑回归模型

逻辑回归是处理分类问题的一种方法,它适用于因变量是二元的情况。在R中,我们可以使用`glm()`函数并指定`family = binomial`来拟合逻辑回归模型。

```r

# 假设有一个数据框binary_data,包含因变量binary_response和一些自变量

binary_data <- data.frame(

binary_response = factor(sample(0:1, 100, replace = TRUE)),

x1 = runif(100),

x2 = runif(100)

)

# 拟合逻辑回归模型

logit_model <- glm(binary_response ~ x1 + x2, data = binary_data, family = binomial)

summary(logit_model)

```

通过本章节的介绍,我们已经掌握了R语言进行基础统计分析的核心方法,包括均值、方差、标准差的计算、相关性分析、假设检验以及回归分析。这些方法在数据分析的各个阶段都至关重要,为我们进一步探索数据提供了坚实的理论基础和工具支持。接下来的章节我们将深入探讨数据预测技术和数据可视化高级技巧,使数据分析能力更上一层楼。

# 4. R语言的数据预测技术

## 4.1 时间序列分析

时间序列分析是预测未来事件的一种强大工具,尤其在经济、金融、气象等领域有着广泛的应用。在本章节中,我们将重点讨论两个基础的时间序列分析方法:移动平均和指数平滑,以及更高级的ARIMA模型。

### 4.1.1 移动平均和指数平滑

移动平均和指数平滑是预测时间序列数据时常用的方法,它们通过考虑过去的数据点来预测未来的值。

- **移动平均**是一种平均化的技术,它计算一定时间段内的数据点的平均值。这种方法适用于周期性或趋势性数据,可以减少随机波动的影响。

- **指数平滑**是对移动平均的改进,它给予更近的数据点更高的权重,从而使得预测值更加接近最近的数据点。

下面是一个使用R语言实现简单移动平均和加权移动平均的示例代码:

```r

# 简单移动平均

simple_moving_average <- function(data, n) {

sapply(1:(length(data)-n+1), function(i) {

mean(data[i:(i+n-1)])

})

}

# 加权移动平均

weighted_moving_average <- function(data, weights) {

n <- length(weights)

sapply(1:(length(data)-n+1), function(i) {

sum(data[i:(i+n-1)] * weights) / sum(weights)

})

}

# 示例数据

ts_data <- c(1.2, 1.5, 1.7, 1.6, 1.8, 2.1, 2.3, 2.5, 2.6, 2.7)

# 计算移动平均

sma <- simple_moving_average(ts_data, 3)

wma <- weighted_moving_average(ts_data, c(0.1, 0.3, 0.6))

# 输出结果

print(sma)

print(wma)

```

在此代码中,我们定义了两个函数`simple_moving_average`和`weighted_moving_average`。第一个函数计算简单移动平均,第二个函数则计算加权移动平均。示例数据`ts_data`用于演示如何使用这些函数。

### 4.1.2 ARIMA模型

自回归积分滑动平均(ARIMA)模型是一种用于分析和预测时间序列数据的复杂模型。ARIMA模型整合了自回归(AR)、差分(I)、移动平均(MA)的概念。

- **自回归部分**是指当前值与前n个值之间的线性关系。

- **差分**是数据稳定化的一种方法,它通过对连续数据进行减法操作来移除趋势。

- **移动平均部分**则描述了当前值与前m个预测误差之间的关系。

在R中,可以使用`forecast`包中的`auto.arima`函数来自动选择最佳的ARIMA模型参数并进行预测。以下是ARIMA模型应用于时间序列数据的示例代码:

```r

library(forecast)

# ARIMA模型示例

arima_model <- auto.arima(ts_data)

# 模型摘要

summary(arima_model)

# 使用模型进行预测

forecasted_values <- forecast(arima_model, h = 5)

# 绘制预测结果

plot(forecasted_values)

```

在此代码块中,我们首先加载了`forecast`包,然后使用`auto.arima`函数自动拟合了一个ARIMA模型,并使用该模型对未来的5个数据点进行了预测。最后,我们使用`plot`函数绘制了预测结果。

## 4.2 机器学习预测方法

机器学习在数据分析和预测中占据了重要位置,R语言通过多种包提供了丰富的机器学习算法支持。本小节我们将重点讨论决策树、随机森林、支持向量机(SVM)和神经网络等常用的预测方法。

### 4.2.1 决策树和随机森林

决策树是一种将特征空间划分为若干个规则区域的预测模型。随机森林是由多个决策树组成的一种集成学习方法,它通过构建多棵决策树并进行投票来提升预测的准确性和稳定性。

在R中,`rpart`包可用于建立决策树模型,而`randomForest`包则是实现随机森林算法的首选工具。下面的示例代码将展示如何建立决策树和随机森林模型:

```r

library(rpart)

library(randomForest)

# 决策树模型

tree_model <- rpart(y ~ ., data = training_data)

# 随机森林模型

rf_model <- randomForest(y ~ ., data = training_data, ntree = 500)

# 决策树模型预测

tree_predictions <- predict(tree_model, newdata = test_data, type = 'class')

# 随机森林模型预测

rf_predictions <- predict(rf_model, newdata = test_data, type = 'response')

# 模型性能评估

confusionMatrix(tree_predictions, test_data$y)

confusionMatrix(rf_predictions, test_data$y)

```

在此代码块中,我们使用`rpart`函数创建了决策树模型,并使用`randomForest`函数创建了随机森林模型。在对测试数据进行预测后,我们使用`confusionMatrix`函数来评估两个模型的性能。

### 4.2.2 支持向量机(SVM)

支持向量机(SVM)是一种高效的监督学习方法,广泛用于分类和回归任务。SVM通过寻找最优的决策边界,实现对数据的分类。

在R中,可以使用`e1071`包中的`svm`函数来训练SVM模型。下面的代码展示了如何使用SVM进行分类:

```r

library(e1071)

# SVM模型

svm_model <- svm(y ~ ., data = training_data, kernel = "radial")

# SVM模型预测

svm_predictions <- predict(svm_model, newdata = test_data)

# 模型性能评估

confusionMatrix(svm_predictions, test_data$y)

```

在这段代码中,我们创建了一个使用径向基函数(radial kernel)的SVM模型,并对其进行了预测。之后,我们对模型的预测结果进行了性能评估。

### 4.2.3 神经网络

神经网络是一种模仿人脑神经元结构和功能的计算模型,它由大量互相连接的节点(神经元)构成,可以用于解决分类和回归问题。

在R中,`nnet`包提供了构建简单的单层和多层神经网络的功能。下面的代码展示了如何使用`nnet`包构建和应用神经网络模型:

```r

library(nnet)

# 神经网络模型

nn_model <- nnet(y ~ ., data = training_data, size = 10) # size 指定隐藏层神经元的数量

# 神经网络模型预测

nn_predictions <- predict(nn_model, newdata = test_data, type = 'class')

# 模型性能评估

confusionMatrix(nn_predictions, test_data$y)

```

在这段代码中,我们使用`nnet`函数建立了一个具有10个隐藏层神经元的神经网络模型,并对测试数据进行了分类预测。最后,我们对预测结果进行了性能评估。

## 4.3 预测模型的评估与选择

在构建了多个预测模型后,重要的是要对它们进行比较,以确定哪个模型的预测结果最为准确和可靠。在本小节中,我们将探讨模型误差的评估指标和超参数调整与模型选择的方法。

### 4.3.1 模型误差的评估指标

模型误差评估指标是评价预测模型性能的关键。常用的指标包括均方误差(MSE)、均方根误差(RMSE)、平均绝对误差(MAE)和决定系数(R²)等。

以下是几个评估指标的计算方法和R语言实现:

```r

# 均方误差 (MSE)

mse <- mean((predicted_values - actual_values)^2)

# 均方根误差 (RMSE)

rmse <- sqrt(mse)

# 平均绝对误差 (MAE)

mae <- mean(abs(predicted_values - actual_values))

# 决定系数 (R²)

ss_res <- sum((predicted_values - actual_values)^2)

ss_tot <- sum((actual_values - mean(actual_values))^2)

r_squared <- 1 - (ss_res / ss_tot)

```

在这些代码段中,我们使用了R的基本函数来计算MSE、RMSE、MAE和R²。

### 4.3.2 超参数调整与模型选择

模型的超参数对其性能有着决定性的影响。因此,在实际应用中需要对超参数进行调整,以获得最优的模型性能。

对于神经网络,可以通过改变隐藏层神经元的数量来调整模型性能。而对于随机森林,可以调整树的数量`ntree`和每个节点分割所需的最小样本数等参数。

在R中,可以使用`caret`包和`train`函数来系统地调整模型参数。通过交叉验证等方法,`caret`帮助我们选择最佳的超参数组合。下面是一个`caret`包使用示例:

```r

library(caret)

# 设置训练控制参数

train_control <- trainControl(method = "cv", number = 10)

# 使用训练控制参数和数据集训练随机森林模型,并进行参数选择

rf_grid <- expand.grid(.mtry=c(2, 5, 10)) # 随机森林参数

rf_model <- train(y ~ ., data = training_data, method = "rf",

trControl = train_control, tuneGrid = rf_grid)

# 模型性能评估

print(rf_model)

```

在此代码块中,我们定义了10折交叉验证的训练控制参数,并使用`train`函数在不同的`mtry`参数值上训练随机森林模型。通过比较不同参数组合的性能,我们可以选择最佳的超参数组合。

通过上述方法和步骤,我们不仅能够构建出有效的预测模型,还能通过合理的评估和参数调整,确保模型在实际应用中的准确性和可靠性。

# 5. R语言中的数据可视化高级技巧

在现代数据分析中,数据可视化是不可或缺的一环。它帮助我们更好地理解数据,展现分析结果,并与他人沟通复杂概念。R语言提供了丰富的可视化工具,其中ggplot2包是当前最流行的绘图系统之一。本章节将介绍ggplot2的基础使用,并探讨如何进行可视化图表的高级定制。

## 5.1 高级图形绘制包介绍

### 5.1.1 ggplot2包的基础使用

ggplot2是基于Leland Wilkinson的《The Grammar of Graphics》所构建的一个R包,它提供了一套完整的绘图语法。ggplot2允许用户通过简单而直观的方式创建复杂的图形。

```r

# 安装ggplot2包

install.packages("ggplot2")

# 加载ggplot2包

library(ggplot2)

# 使用ggplot2绘制基本图形

ggplot(data = diamonds, aes(x = carat, y = price)) +

geom_point() +

labs(title = "散点图示例", x = "克拉", y = "价格")

```

在上述代码中,`ggplot`函数定义了数据源和美学映射(aes),`geom_point`定义了我们想要绘制的图形类型。`labs`函数用于添加图表的标题和轴标签。

ggplot2通过分层的概念,使得用户可以轻松地叠加不同的图层(如点、线、面等),并且可以独立地控制每个图层的属性。

### 5.1.2 其他图形绘制包概览

除了ggplot2,R语言还提供了许多其他绘图包,它们各自有独特的特点和优势。例如,lattice包适合创建多变量的条件图形,而plotly包则能创建交互式的图形,让观众可以与之交互。

```r

# 安装并加载plotly包

install.packages("plotly")

library(plotly)

# 使用plotly绘制交互式散点图

plot_ly(diamonds, x = ~carat, y = ~price, type = "scatter", mode = "markers")

```

上述代码使用plotly包创建了一个交互式散点图,观众可以通过鼠标悬停、缩放等操作来探索数据。

## 5.2 可视化图表的高级定制

### 5.2.1 自定义图形元素

在ggplot2中,我们可以自定义几乎所有的图形元素,包括颜色、形状、字体、图例等。这为我们提供了极大的灵活性来设计符合特定需求的图表。

```r

# 自定义ggplot2图形元素

ggplot(diamonds, aes(x = cut, fill = cut)) +

geom_bar() +

scale_fill_manual(values = c("red", "blue", "green", "yellow", "purple")) +

theme_minimal() +

theme(axis.text.x = element_text(angle = 45, vjust = 1, hjust = 1)) +

labs(title = "自定义颜色和主题的条形图")

```

在此代码中,我们通过`scale_fill_manual`函数自定义了条形图的颜色,并且使用`theme`函数来调整x轴标签的显示方式,以及应用了简洁的主题。

### 5.2.2 多变量图形和交互式图形

随着数据集维度的增加,我们常常需要展示多变量之间的关系。ggplot2通过添加不同的图层来展示多变量图形,而plotly则能够创建支持缩放、拖拽等功能的交互式图表。

```r

# 创建一个交互式散点图

p <- ggplot(diamonds, aes(x = carat, y = price, color = cut)) +

geom_point(alpha = 0.5) +

scale_color_brewer(palette = "Set1")

# 使用ggplotly将ggplot2图形转换为交互式图形

ggplotly(p)

```

`ggplotly`函数是plotly包中的一部分,它能够将ggplot2图形转换为交互式版本,增强数据展示的灵活性和用户体验。

### 5.2.3 高级定制的实际应用案例

下面是一个实际案例,展示如何使用ggplot2和plotly来定制一个高级可视化图表。假设我们正在分析一家零售商的销售数据,我们希望创建一个散点图,展示销售额与广告支出之间的关系,并允许用户通过交互式控件来探索不同产品的销售数据。

```r

# 加载数据

retail_data <- read.csv("path_to_retail_data.csv")

# 使用ggplot2绘制散点图

p <- ggplot(retail_data, aes(x = Advertising, y = Sales, color = Product)) +

geom_point() +

labs(title = "销售额与广告支出的关系", x = "广告支出", y = "销售额")

# 使用ggplotly转换为交互式图形

ggplotly(p)

```

在这个案例中,我们首先用ggplot2创建了一个散点图,并通过颜色映射区分了不同产品。然后,我们使用`ggplotly`将这个静态图表转换为一个动态的、可交互的图表。这样的展示方式对于商业决策者来说非常有用,因为它可以揭示隐藏在数据中的模式和趋势,让他们能够做出基于数据的决策。

通过这些步骤,我们可以看到,R语言不仅提供了强大的统计分析工具,还提供了丰富的数据可视化选项,这对于任何数据分析师来说都是一个宝贵的资产。

# 6. R语言项目实践案例分析

在数据分析的世界里,理论知识的应用始终是核心。R语言作为分析工具,不仅需要掌握其语法和操作方法,还需要通过实践来巩固学习成果。本章节将通过一个完整的数据分析项目案例,带领读者深入了解R语言在实际工作中的应用流程。

## 6.1 完整数据分析项目流程

### 6.1.1 项目规划与数据获取

任何项目的开始,首先是规划阶段。这包括确定分析目标、项目时间表、资源分配以及所需数据的获取方式。

在确定了分析目标后,如何获取数据是下一步的关键。数据可能来自公开数据库、内部系统、在线API、爬虫或者直接通过问卷调查收集。

以公开数据库为例,R语言提供了多种方式获取数据。比如使用`readr`包读取CSV文件,或者使用`httr`包直接访问在线API。

```r

# 使用readr包读取本地CSV文件

library(readr)

data <- read_csv("path/to/your/csvfile.csv")

# 使用httr包访问在线API获取数据

library(httr)

response <- GET("***")

data <- content(response, type = "text")

```

### 6.1.2 数据处理与初步分析

在数据到手后,接下来要进行的是数据清洗和预处理。R语言中的`dplyr`和`tidyr`包是数据处理的利器,可用于筛选、转换、汇总等操作。

```r

library(dplyr)

library(tidyr)

# 数据筛选

filtered_data <- data %>% filter(column1 > value)

# 数据转换

transformed_data <- filtered_data %>% mutate(new_column = column1 + column2)

# 数据汇总

summarized_data <- transformed_data %>% group_by(group_column) %>%

summarize(mean_value = mean(column))

```

初步分析阶段,常用描述性统计方法,如均值、中位数、标准差等,来概括数据集的特征。`summary`函数和`describe`函数能快速提供这些信息。

```r

# 描述性统计

summary(data$column)

# 使用psych包的describe函数

library(psych)

describe(data)

```

## 6.2 预测模型案例

### 6.2.1 案例背景介绍

假设我们正在处理一个电信公司的数据集,目标是根据客户的特征和行为数据预测客户是否会流失(Churn)。数据集包含了客户的基本信息、服务使用情况、账单信息等多个维度的数据。

### 6.2.2 数据探索与模型构建

数据探索阶段,我们利用之前章节介绍的方法,对数据进行可视化分析,探索变量之间的关系。

```r

library(ggplot2)

# 可视化分析

ggplot(data, aes(x=service_usage, y=customer_spendings)) +

geom_point() +

labs(title="Customer Spendings vs Service Usage")

```

在确定了数据集的特征后,选择合适的预测模型变得至关重要。常见的分类算法有决策树、随机森林、逻辑回归等。我们选择随机森林作为示例。

```r

library(randomForest)

# 使用随机森林构建模型

set.seed(123) # 设置随机种子

rf_model <- randomForest(as.factor(churn) ~ ., data = training_data, ntree = 500)

# 查看模型的性能

print(rf_model)

```

### 6.2.3 模型评估与优化

在模型构建完毕后,需要对其进行评估。常用的评估指标有准确度、召回率、F1分数等。同时,还需要通过交叉验证等技术对模型进行调优。

```r

# 使用交叉验证评估模型

set.seed(123)

cv_results <- crossValidation(rf_model, data=training_data, y = training_data$churn,

cv.fold=5, performance.title="Accuracy")

# 查看交叉验证结果

print(cv_results)

```

## 6.3 项目总结与展望

### 6.3.1 关键发现与学习点

通过本项目,我们发现客户的服务使用情况与是否流失之间有显著相关性。同时,通过学习和应用R语言中的数据清洗、可视化和预测模型构建技术,我们能够更好地理解数据,并将其转化为有价值的洞察。

### 6.3.2 项目中的挑战与解决方案

项目过程中面临的主要挑战是数据的不平衡性,即流失客户和非流失客户在数量上的差距。为了解决这一问题,我们采用了过采样和欠采样的方法来平衡数据集,从而提高模型的泛化能力。

R语言项目实践案例分析不仅是对前面章节所学知识的综合应用,也是实际数据工作中遇到的典型问题的解决方案展示。通过本章内容,读者可以更清晰地看到R语言在数据分析和预测中的强大功能及其应用。

0

0