【HDFS文件完整性检查】:预防数据损坏,回收站之外的保护措施

发布时间: 2024-10-29 21:22:21 阅读量: 38 订阅数: 36

分布式文件系统hdfs.docx

# 1. HDFS文件系统概述

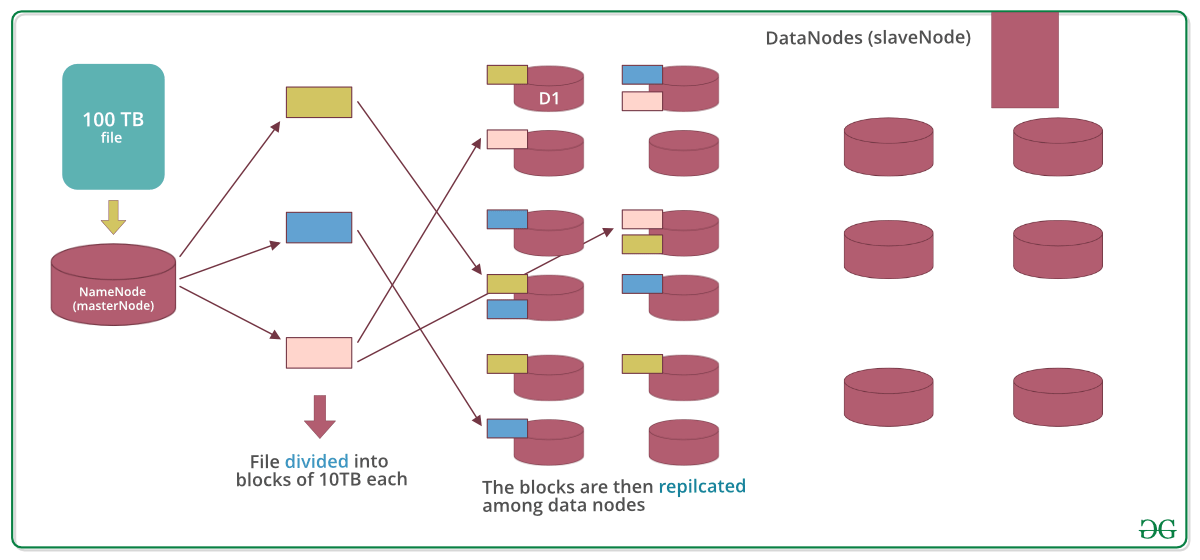

Hadoop分布式文件系统(HDFS)是Hadoop项目的核心组件,专为处理大数据设计,具有高容错性、高吞吐量等显著特点。它被广泛应用于分布式存储的场景中,能有效地存储大规模数据集,并支持多种计算模型。HDFS采用主从(Master/Slave)架构,将数据分布在不同的服务器上,通过冗余存储确保数据的可靠性和可用性。理解HDFS的基本架构和工作原理,对于维护和优化大数据平台的存储层至关重要。接下来的章节我们将深入探讨HDFS文件系统的完整性问题,以及如何通过实践操作和高级应用来保证数据的可靠性。

# 2. HDFS文件完整性的重要性

### 2.1 数据完整性问题及其影响

数据完整性指的是数据在存储、传输或处理过程中保持准确性和一致性的程度。对于HDFS这样的大规模分布式文件系统而言,保持数据完整性显得尤为重要,因为数据的损坏可能导致无法预料的错误,甚至影响到整个系统的运行。

#### 2.1.1 数据损坏的常见原因

在HDFS的运行环境中,数据损坏可能由多种因素引起。首先,硬件故障是导致数据损坏的常见原因,比如硬盘故障、内存损坏或网络中断。其次,软件缺陷也可能导致数据损坏,例如Hadoop自身代码的bug,或是操作系统层面的漏洞。最后,外部环境因素,如自然灾害、电力波动或恶意攻击,都有可能引起数据损坏。

#### 2.1.2 数据完整性对系统可靠性的影响

数据的不完整性对系统的可靠性影响巨大。一方面,数据损坏可能导致计算结果错误,影响分析结果的准确性,进而影响业务决策。另一方面,数据损坏还可能导致系统运行异常,如服务中断或性能下降。在分布式系统中,数据的损坏还可能影响到数据的一致性和可用性,特别是在数据副本的不一致情况发生时。

### 2.2 HDFS中文件损坏的检测机制

为了确保数据的完整性,HDFS提供了多种机制来检测和处理数据损坏问题。

#### 2.2.1 HDFS的错误检测和报告机制

HDFS通过校验和(checksum)机制来检测数据文件的完整性。每当数据写入HDFS时,系统会计算数据块的校验和并将其存储在NameNode中。在数据读取时,HDFS会重新计算读取数据块的校验和,并与存储在NameNode中的值进行比较,以检测数据在存储或传输过程中是否发生损坏。

```

# 计算数据块校验和的伪代码示例

# 计算数据块校验和

def calculate_checksum(data_block):

# 假设使用MD5作为校验算法

import hashlib

m = hashlib.md5()

m.update(data_block)

checksum = m.digest()

return checksum

# 读取数据块时校验

def read_and_verify(data_block, stored_checksum):

calculated_checksum = calculate_checksum(data_block)

return calculated_checksum == stored_checksum

```

通过校验和,HDFS可以有效地识别出被损坏的数据块,并采取措施进行修复或报告错误。

#### 2.2.2 HDFS中数据块的复制策略

HDFS通过数据块的复制来确保数据的高可用性。当创建一个HDFS文件时,系统会自动地在多个DataNode上创建数据块的副本。默认情况下,HDFS会创建三个副本,一个位于写入节点,其他两个位于不同的DataNode上。这样的策略不仅可以提供容错能力,还能在检测到数据损坏时,通过与其他副本的数据对比,来恢复损坏的数据块。

```

# HDFS数据块复制策略示意图

graph LR

subgraph "DataNode A"

block1副本 -->|复制| block1副本1

block2副本 -->|复制| block2副本1

block3副本 -->|复制| block3副本1

end

subgraph "DataNode B"

block1副本 -->|复制| block1副本2

block2副本 -->|复制| block2副本2

block3副本 -->|复制| block3副本2

end

subgraph "DataNode C"

block1副本 -->|复制| block1副本3

block2副本 -->|复制| block2副本3

block3副本 -->|复制| block3副本3

end

```

通过这种方式,HDFS的数据块复制策略有效地提高了数据的冗余度和系统的容错能力,为数据完整性提供了更加坚实的保障。

# 3. HDFS文件完整性检查的理论基础

## 3.1 HDFS的NameNode与DataNode架构

### 3.1.1 NameNode的作用与结构

在Hadoop分布式文件系统(HDFS)中,NameNode是中心节点,负责维

0

0