Gini指数在机器学习中的力量:如何优化你的决策树模型

发布时间: 2024-09-04 20:11:30 阅读量: 112 订阅数: 25

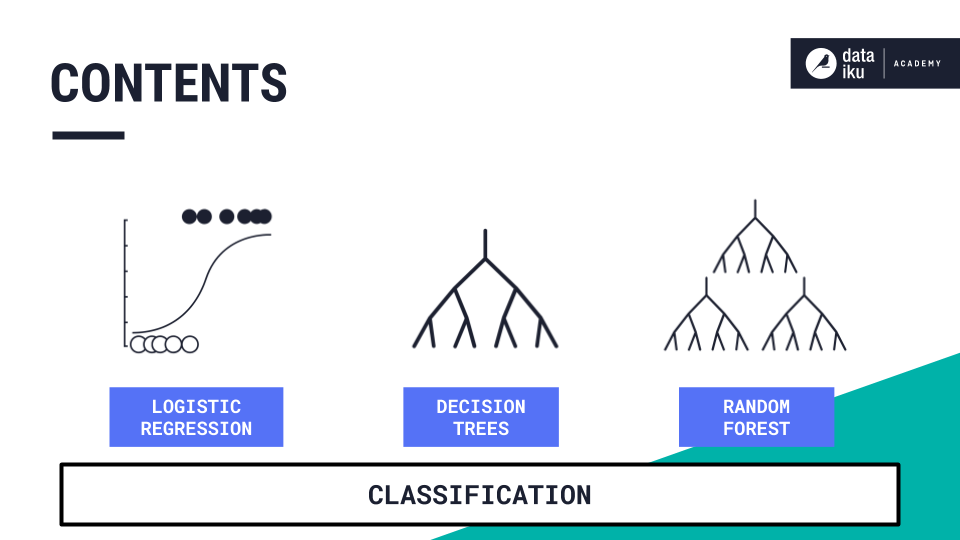

机器学习补充:决策树1

# 1. Gini指数在决策树中的基础概念

在本章中,我们将揭开Gini指数在决策树模型中运用的神秘面纱,了解其基础概念,为之后更深层次的理解和应用打下坚实基础。

## 1.1 Gini指数的定义

Gini指数,又称基尼不纯度,是一个衡量数据集纯度的指标,范围从0到1。当数据集完全纯净,即所有实例都属于同一类时,Gini指数为0;反之,当数据集中各个类别的分布均匀时,Gini指数则趋近于1。通过计算划分前后的Gini指数差异,我们可以评估一次划分是否增加了数据集的纯度。

```python

# Python示例代码来计算Gini指数

def gini_impurity(y):

_, counts = np.unique(y, return_counts=True)

impurity = 1 - np.sum((counts / np.sum(counts))**2)

return impurity

# 假设有两类标签

y = np.array([1, 1, 1, 0, 0, 0])

print("Gini Impurity:", gini_impurity(y))

```

## 1.2 Gini指数在决策树中的角色

在决策树算法中,Gini指数作为选择最优划分特征的标准之一,用于评估对数据集进行分割的效果。划分特征的目的是尽量降低结果集合的Gini指数,从而创建更为纯净的子集。这在构建决策树时是非常关键的步骤,因为决策树的性能在很大程度上取决于这些分割点的选择。

# 2. 决策树模型的构建与Gini指数的理论基础

### 2.1 决策树模型简介

#### 2.1.1 决策树的工作原理

决策树是一种广泛应用的监督学习算法,它模仿人类决策思维过程,以树状结构将数据集按照不同属性分割,直至每个子集只包含单一类别或者达到预设的分割标准。在决策树模型中,内部节点代表了对一个属性的判断,分支代表了属性的可能值,而叶节点则对应了最终的决策结果。每一步分割的目标都是使得生成的子集尽可能的“纯”,这样在叶节点就能高效地进行分类。

#### 2.1.2 决策树的主要优点与应用场景

决策树的主要优点包括其解释性强,模型构建直观且易于理解。它不需要对数据进行预处理,比如标准化或归一化,也能够处理数值型和类别型数据。此外,决策树能够很好地处理特征之间的交互关系。这些优点使得决策树在医疗诊断、信用评分以及市场细分等众多领域有着广泛的应用。

### 2.2 Gini指数的理论解析

#### 2.2.1 Gini指数的定义与计算方法

Gini指数(Gini impurity)是一种衡量数据集纯度的指标,其值越低表示数据集的纯度越高。对于一个分类问题,Gini指数的计算公式如下:

```

Gini = 1 - Σ (pi)^2

```

其中,pi是数据集中属于第i类的概率。在实际计算中,通常使用样本中的类别出现频率来代替概率。Gini指数通过衡量从数据集中随机选取两个样本,其类别标记不一致的概率来度量不纯度。Gini指数取值范围为0到1之间,其中0代表所有样本都属于同一个类别,1则表示数据集中的样本完全随机分布。

#### 2.2.2 Gini指数与信息增益的比较

与信息增益(Information Gain)相比,Gini指数计算更为简单快速,因为它避免了对数据集进行概率分布的计算。信息增益基于信息熵的概念,需要计算数据集的熵,然后计算划分后的熵变化。而Gini指数仅需计算类别的概率分布即可。虽然两者在选择属性分割点时经常得到相似的结果,但Gini指数因其计算上的优势更受欢迎。

### 2.3 Gini指数在决策树构建中的作用

#### 2.3.1 最优划分点的选择依据

在决策树的构建过程中,选择最优划分点是提高模型性能的关键步骤。使用Gini指数,我们可以在每个分割点计算各个分支的Gini指数,然后计算整体的加权Gini指数。最优划分点的选择标准是最小化这个加权Gini指数。通过这种方式,决策树能够在每一步都选择最能增加子集纯度的属性和其分割值。

#### 2.3.2 Gini指数对树深度与复杂度的影响

Gini指数的计算和应用也影响了决策树的深度和复杂度。若在建树过程中过度追求节点的纯度,可能会导致生成过于复杂、深度过大的决策树,容易过拟合。而若限制树的深度或进行剪枝,虽然有助于防止过拟合,但可能会牺牲一部分模型的准确性。因此,Gini指数在决策树的优化过程中起着调节树复杂度的重要作用。

接下来,我们将深入探讨Gini指数在决策树优化技术中的应用,以及实际机器学习项目中的应用情况,包括如何在实际案例中评估Gini指数的效果。

# 3. 基于Gini指数的决策树优化技术

### 3.1 剪枝技术与Gini指数

在构建决策树时,由于数据集的复杂性和噪声,模型可能会过于复杂,导致对训练数据过度拟合,此时剪枝技术就显得尤为重要。剪枝可以分为预剪枝和后剪枝两种。

#### 3.1.1 过拟合与剪枝的必要性

过拟合是指模型过于复杂,学习到了训练数据中的噪声和不重要的特征,使得模型在训练集上的表现很好,但在独立的测试集上表现却大打折扣。剪枝技术的目的就是通过删除部分树节点来简化模型结构,以此来减少模型复杂度,从而防止过拟合,提高模型的泛化能力。

#### 3.1.2 剪枝策略与Gini指数的结合应用

后剪枝是更为常用的剪枝策略,它在树构建完成后进行,根据Gini指数来确定哪些节点是不必要的。其基本思想是:对于每一个内部节点,计算剪枝后的分类效果与未剪枝效果的Gini指数差异。如果剪枝后的Gini指数差异很小,表明剪枝带来的分类性能损失不大,此时就可以考虑对该节点进行剪枝。

### 3.2 特征选择与Gini指数

特征选择是数据预处理中的一个关键步骤,它能显著影响决策树模型的性能。

#### 3.2.1 特征选择的重要性

在机器学习模型中,不是所有的特征都对预测目标变量同等重要,有些特征甚至会引入噪声,导致模型性能下降。因此,通过特征选择减少特征的数量,可以简化模型,提高训练速度,并且可能提升模型的准确度。

#### 3.2.2 Gini指数在特征选择中的作用

利用Gini指数进行特征选择时,可以通过计算每个特征划分数据集前后Gini指数的变化量来评估特征的重要性。Gini指数变化越大,表示该特征划分能力越强,因此该特征的重要性越高。在实践中,可以设置一个阈值,剔除Gini指数变化量小于该阈值的特征,从而达到减少特征数量的目的。

### 3.3 多变量

0

0