郑大钟矩阵变换课:从理论到应用的全面剖析

发布时间: 2025-01-04 15:03:08 阅读量: 9 订阅数: 14

# 摘要

矩阵变换作为数学和计算机图形学中的核心概念,广泛应用于图形渲染、物理模拟以及机器学习等领域。本文从矩阵变换的数学基础入手,详细探讨了矩阵的定义、性质以及线性变换与矩阵之间的关系,并着重分析了对角矩阵、旋转矩阵等特殊矩阵的变换特性。在图形学领域,本文阐述了2D和3D图形中的矩阵变换应用,优化技巧及硬件加速策略。物理模拟方面,本文介绍了运动方程和动力学系统中矩阵的应用,以及碰撞检测与反应的数学方法。在机器学习部分,本文探讨了线性代数在数据处理中的作用,神经网络中矩阵变换的应用,以及矩阵运算优化算法。最后,本文通过矩阵变换编程实践,展示了如何搭建开发环境、应用矩阵变换库,以及进行性能优化和调试。本文全面覆盖了矩阵变换的理论和实际应用,为相关领域的研究和开发提供了宝贵的参考。

# 关键字

矩阵变换;图形学;物理模拟;机器学习;线性代数;性能优化

参考资源链接:[线性系统理论解析 - 郑大钟课件精华](https://wenku.csdn.net/doc/ci77qisbar?spm=1055.2635.3001.10343)

# 1. 矩阵变换的数学基础

数学是理解矩阵变换不可逾越的基础。矩阵不仅仅是一个数值构成的矩形阵列,它还是对空间中线性变换的数学表达。本章将探讨矩阵的定义、性质,以及它们如何通过线性代数描述线性变换。我们将解析矩阵运算规则,以及特殊矩阵在变换中的特殊作用。对这些基本概念的深刻理解是深入掌握后续各章应用领域的前提。

## 1.1 矩阵的定义与性质

### 1.1.1 矩阵的基本概念

矩阵是由m行n列的数字或表达式排成的矩形阵列,例如:

```plaintext

| a11 a12 ... a1n |

| a21 a22 ... a2n |

| ... ... ... ... |

| am1 am2 ... amn |

```

其中,`aij` 表示矩阵中的第i行第j列的元素。矩阵可以用来表示线性方程组,向量空间中的变换,以及数据结构的组织形式。

### 1.1.2 矩阵的运算规则

矩阵运算包括加法、数乘和乘法。加法和数乘运算涉及相同大小矩阵的元素对应操作。矩阵乘法则更加复杂,涉及到内积的概念,且仅在满足相应维度时可执行。矩阵乘法的一个典型例子是:

```plaintext

C = AB

```

其中,矩阵A的列数必须等于矩阵B的行数。

## 1.2 线性变换与矩阵

### 1.2.1 线性变换的定义

线性变换是一种保持向量加法和数乘操作的变换。它可以通过矩阵和向量的乘法来表示。线性变换的一个关键特性是它保住了空间的线性结构。

### 1.2.2 矩阵与线性变换的关系

任何一个线性变换都可以用一个矩阵来表示。当我们将一个矩阵与一个向量相乘时,实际上是将这个向量通过一个线性变换转换到了另一个位置。

## 1.3 特殊矩阵与变换

### 1.3.1 对角矩阵和缩放变换

对角矩阵是一类主对角线以外的元素都为零的矩阵。它在图形学中表示缩放变换,因为对角线上的元素直接对应于各个轴的缩放因子。

### 1.3.2 旋转矩阵的推导与性质

旋转矩阵是一个特殊的正交矩阵,用于表示二维或三维空间中的旋转。二维旋转矩阵通常形式如下:

```plaintext

| cosθ -sinθ |

| sinθ cosθ |

```

其中θ是旋转角度。旋转矩阵保持向量长度不变,是实现旋转变换的关键工具。

通过本章的学习,我们将建立起对矩阵变换数学本质的理解,为后续章节中矩阵在各个领域的应用奠定扎实的理论基础。

# 2. 矩阵变换在图形学中的应用

### 2.1 矩阵变换在2D图形中的应用

2D图形变换是图形学中最为基本的操作,它涉及到图形的平移、缩放、旋转和倾斜等操作。在计算机图形学中,这些变换通常通过矩阵乘法来实现。

#### 2.1.1 二维仿射变换

在二维空间中,仿射变换可以实现图形的各种线性变换,并保持图形的“平直性”和“平行性”。数学上,仿射变换可以表示为2x3矩阵乘以一个齐次坐标向量,即`Ax = [x', y', 1]`。

```c++

// C++ 代码示例: 使用GLM库进行2D仿射变换

#include <glm/glm.hpp>

#include <glm/gtc/matrix_transform.hpp>

glm::mat3 affineTransform = glm::translate(glm::mat3(1.0f), glm::vec2(tx, ty)) *

glm::scale(glm::mat3(1.0f), glm::vec2(sx, sy)) *

glm::rotate(glm::mat3(1.0f), glm::radians(angle), glm::vec2(0.0f, 0.0f));

```

在这段代码中,我们使用了GLM库进行矩阵运算。`translate`、`scale`和`rotate`函数分别用于计算平移、缩放和旋转的仿射变换矩阵,并将它们相乘以形成最终的变换矩阵。`tx`和`ty`代表平移的X和Y分量,`sx`和`sy`代表缩放的X和Y分量,`angle`代表旋转的角度(以度为单位)。

#### 2.1.2 矩阵在2D渲染管线中的作用

在2D渲染管线中,变换矩阵用于将对象坐标转换到屏幕坐标。这个过程涉及视图、模型和投影矩阵的组合。

```mermaid

graph TD;

A[Object Coordinates] -->|Model Matrix| B[World Coordinates]

B -->|View Matrix| C[View Coordinates]

C -->|Projection Matrix| D[Clip Coordinates]

D -->|Viewport Transform| E[Screen Coordinates]

```

在上述流程图中,我们描述了从对象坐标到屏幕坐标的整个转换过程。每个步骤对应一个变换矩阵,它们被组合起来完成从模型空间到屏幕空间的全部转换。

### 2.2 矩阵变换在3D图形中的应用

#### 2.2.1 三维空间中的变换矩阵

在三维空间中,变换矩阵同样遵循仿射变换的概念,但需要一个3x4矩阵来处理三维空间中的点。

```c++

// C++ 代码示例: 使用GLM库进行3D仿射变换

glm::mat4 transform = glm::translate(glm::mat4(1.0f), glm::vec3(tx, ty, tz)) *

glm::scale(glm::mat4(1.0f), glm::vec3(sx, sy, sz)) *

glm::rotate(glm::mat4(1.0f), glm::radians(angle), glm::vec3(rx, ry, rz));

```

这段代码中,`translate`、`scale`和`rotate`函数被应用来构建一个三维变换矩阵。其中,`tx`、`ty`、`tz`为平移向量的X、Y、Z分量,`sx`、`sy`、`sz`为缩放向量的X、Y、Z分量,而`rotate`函数接收一个旋转轴和旋转角度。

#### 2.2.2 视图变换与投影变换的原理

视图变换将物体从世界坐标系转换到相机坐标系,而投影变换则将三维坐标投影到二维屏幕上。这通常涉及到视角矩阵和透视矩阵的构建。

```mermaid

graph TD;

A[World Coordinates] -->|View Matrix| B[Camera Coordinates]

B -->|Projection Matrix| C[NDC Coordinates]

C -->|Perspective Division| D[Screen Coordinates]

```

如上所述,视图变换和投影变换共同完成从世界坐标到屏幕坐标的转换。视图矩阵模拟了相机位置和方向的变化,而投影矩阵负责模拟真实世界中的透视效果。

### 2.3 矩阵变换的优化与技巧

#### 2.3.1 变换矩阵的组合优化

在计算机图形学中,变换矩阵的计算成本较高,因此需要通过矩阵乘法的结合律和分配律来进行优化。

```c++

// 矩阵组合的优化示例

glm::mat4 modelViewProjection = projection * view * model;

```

这个例子展示了模型矩阵(model)、视图矩阵(view)和投影矩阵(projection)的组合优化。通过先进行矩阵乘法的组合再传递给图形管线,可以减少GPU上变换的次数,提高渲染效率。

#### 2.3.2 硬件加速和GPU变换流水线

现代GPU具有专门的硬件加速器,用于处理矩阵变换等数学运算,使得这些变换可以在图形管线中高效执行。

```c

// GLSL(OpenGL Shading Language)中的顶点着色器代码

#version 330 core

layout (location = 0) in vec3 aPos; // 顶点位置输入

uniform mat4 transform; // 变换矩阵

void main()

{

gl_Position = transform * vec4(aPos, 1.0);

}

```

在这段顶点着色器代码中,通过一个统一变量(uniform)传递变换矩阵,并在着色器中执行矩阵乘法操作,这是GPU硬件加速的一个典型应用。GLSL代码直接在GPU上执行,使得图形变换可以高度并行化,极大提升了效率。

通过上述各节的详细介绍,我们可以看到,矩阵变换在图形学中的应用是多样的,并且在性能优化方面有着独特的方法和技巧。在后续的章节中,我们将进一步探讨矩阵变换在物理模拟和机器学习中的其他重要应用。

# 3. 矩阵变换在物理模拟中的应用

## 3.1 物理模拟中的运动方程

### 3.1.1 物体运动的线性方程

在物理模拟中,描述物体运动的基本方程是牛顿第二定律,它表达了力与加速度之间的关系。对于一个质量为 \(m\) 的物体,加速度 \(a\) 与其所受外力 \(F\) 成正比,与质量 \(m\) 成反比。通过引入向量的概念,这一关系可以表示为一个线性方程组:

\[ F = ma \]

\[ m\frac{d^2\vec{x}}{dt^2} = \vec{F} \]

这里的 \(\vec{x}\) 是物体的位置向量,\(\vec{F}\) 是作用在物体上的外力向量。在计算过程中,通常需要使用数值方法求解这个二阶微分方程组,如欧拉法、龙格-库塔法等。引入矩阵变换能够更方便地表示和求解这类方程。

### 3.1.2 刚体运动学与矩阵

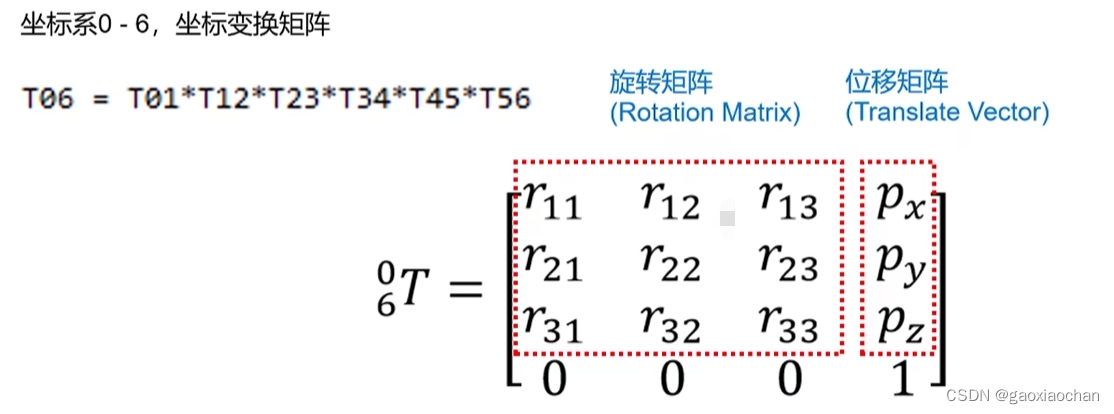

对于刚体,其运动包括平动和旋转两部分。平动可以使用线性变换矩阵表示,而旋转则需要使用旋转矩阵。一个刚体的总变换矩阵 \(T\) 是一个四阶矩阵,包含了旋转和平移信息:

\[ T = \begin{bmatrix} R & \vec{t} \\ 0 & 1 \end{bmatrix} \]

其中 \(R\) 是3x3的旋转矩阵,\(\vec{t}\) 是3x1的平移向量,而额外的1保证了变换矩阵在齐次坐标下的有效性。在模拟中,刚体的变换矩阵需要连续更新以反映其动态变化。

## 3.2 动力学系统中的矩阵应用

### 3.2.1 牛顿第二定律与矩阵表示

牛顿第二定律可以推广到多个物体组成的系统。如果系统中有一个物体集合 \(i = 1, 2, ..., n\),每一个物体都有质量 \(m_i\) 和位置向量 \(\vec{x}_i\),那么系统的运动方程组可以表示为:

\[ M\vec{a} = \vec{F} \]

这里的 \(M\) 是一个对角矩阵,其对角线上的元素是各个物体的质量 \(m_i\),而 \(\vec{a}\) 和 \(\vec{F}\) 分别是系统所有物体的加速度和外力向量。如果系统内力平衡,上式将简化为:

\[ M\vec{a} = \vec{F}_\text{ext} \]

其中 \(\vec{F}_\text{ext}\) 是作用在系统上的所有外力。在矩阵运算中,使用矩阵乘法和求逆等操作能够快速求解这类方程组。

### 3.2.2 动力学方程的数值解法

针对动力学方程的求解,通常采用数值积分方法,比如四阶龙格-库塔法。这种方法能够近似地计算出物体在下一个时间步的位置和速度。通过递归应用这一方法,可以模拟出整个系统随时间演化的动态行为。

这一数值解法的过程可以利用矩阵运算进行优化,通过矩阵操作如转置、乘法和求逆,可以高效地处理大规模的动力学系统。矩阵的这些运算在数值计算库如NumPy中是高度优化的,因此能够加速整个模拟过程。

## 3.3 碰撞检测与反应

### 3.3.1 碰撞检测的数学基础

碰撞检测是物理模拟中不可或缺的一环,它决定了模拟中的对象何时以及如何相互作用。在基础层次上,碰撞可以通过比较两个物体的位置和形状信息来进行检测。对于简单的形状如球体或立方体,碰撞检测可以通过计算它们之间的距离来实现。

在更复杂的情况下,如检测多个复杂多面体之间的碰撞,就需要借助线性代数的工具。最常见的是使用最小距离计算和射线投射技术,这可以使用向量运算和矩阵运算来表达和求解。例如,两个凸多面体之间的碰撞可以通过解决一系列线性规划问题来检测。

### 3.3.2 碰撞响应的矩阵方法

当碰撞发生时,如何计算碰撞后的物理反应是另一个挑战。在简单的弹性碰撞情况下,可以使用动量守恒和能量守恒定律来计算碰撞后的速度。这些计算涉及到了向量和矩阵的运算。

使用矩阵表达碰撞响应涉及到了碰撞对象的速度矩阵和动量矩阵。通过求解这些矩阵的线性方程组,可以得到碰撞后的速度和动量。在实际实现中,会使用到矩阵的乘法和逆运算,这些运算可以通过诸如NumPy这样的矩阵库来执行。

```python

import numpy as np

# 示例:使用矩阵运算解决碰撞后速度的问题

# 假设两个物体的碰撞前速度矩阵为 V1 和 V2

V1 = np.array([[v1x1, v1y1, v1z1], [v1x2, v1y2, v1z2]])

V2 = np.array([[v2x1, v2y1, v2z1], [v2x2, v2y2, v2z2]])

# 定义质量矩阵 M

M = np.array([[m1, 0, 0], [0, m1, 0], [0, 0, m2]])

# 碰撞后速度矩阵为 V

V = np.linalg.solve(M, V1 + V2)

print("碰撞后物体1和物体2的速度为:", V)

```

在上述代码示例中,我们使用了NumPy库来模拟碰撞后速度的计算过程。通过矩阵求逆,我们得到了新的速度矩阵,这些步骤在处理物理模拟的矩阵运算中非常典型。在实践中,还需要考虑摩擦力、非弹性碰撞等因素,这时候的矩阵运算会更加复杂,但原理是类似的。

# 4. ```

# 第四章:矩阵变换在机器学习中的应用

## 4.1 线性代数在机器学习中的作用

### 4.1.1 数据表示与特征提取

在机器学习中,数据通常以高维向量的形式表示,而矩阵则用来存储多个数据实例。这些矩阵可以用于特征提取,即将原始数据转换为一组新的、更易于模型处理的特征。通过矩阵运算,如矩阵乘法,可以实现数据的线性组合,这是许多机器学习算法的基础。

线性代数为机器学习提供了强大的工具,特别是在特征提取方面。例如,主成分分析(PCA)就是一种常用的降维技术,它通过矩阵操作来识别数据中的主要变化方向。PCA通过计算数据的协方差矩阵并对其进行特征分解,从而得到可以解释数据方差的主要成分。

在实际应用中,PCA不仅可以用于数据的可视化,还可以用于降维以减少计算复杂度,同时尽可能保留数据的主要特征。

### 4.1.2 主成分分析(PCA)与矩阵

主成分分析(PCA)是机器学习中一个重要的算法,它可以帮助我们理解和可视化高维数据集。PCA通过矩阵运算来实现数据的降维。首先,它需要计算数据的协方差矩阵,然后对这个矩阵进行特征值分解。

在PCA过程中,数据点首先通过中心化(减去均值),使得数据集的中心位于原点。然后计算中心化后的数据的协方差矩阵,这个矩阵是描述数据各维度之间相关性的矩阵。接下来,对协方差矩阵进行特征值分解,得到一系列的特征向量和对应的特征值。这些特征向量定义了数据的新坐标系,并按照对应的特征值的重要性进行排序,最大的特征值对应的特征向量被认为是主成分。

通过选择前几个最重要的主成分,我们能够以较少的维度来近似原始数据,同时保留了数据集中的主要方差。这一过程实质上是通过矩阵运算来实现的,其中涉及到的数据中心化和特征值分解等操作都需要利用矩阵运算来完成。

## 4.2 神经网络中的矩阵变换

### 4.2.1 权重矩阵的初始化与调整

神经网络是由大量简单的单元(神经元)组成的,这些神经元通过层与层之间的连接(权重)相互作用。权重通常存储在矩阵中,而训练神经网络的过程实际上是对这些矩阵进行更新的过程。初始化这些权重矩阵对于训练过程的收敛速度和最终性能至关重要。

权重矩阵的初始化有多种方法,如随机初始化、Xavier初始化和He初始化。这些方法试图在训练开始时设置合适的权重值,以使网络中的激活能够传播并且梯度流不会消失或爆炸。

在训练过程中,权重矩阵会通过反向传播算法进行调整。反向传播算法包括两个主要步骤:前向传播计算损失函数的值,然后反向通过网络传播梯度。在梯度计算阶段,链式法则被用来计算损失函数对每个权重的梯度,这涉及到大量的矩阵运算。

权重矩阵的更新通常使用梯度下降的方法,结合特定的学习率,来减少损失函数的值。这一更新过程确保了神经网络学习到从输入到输出的复杂映射关系。

### 4.2.2 反向传播算法中的矩阵运算

反向传播算法是训练神经网络的核心,它利用了链式法则来计算损失函数关于每个权重的梯度。这个过程涉及到多次矩阵乘法和矩阵转置操作。

在反向传播中,梯度计算的第一步是通过前向传播得到网络的输出,并计算损失函数。然后,根据损失函数,我们从输出层开始,逐层向前计算梯度。具体来说,对于每一层,我们需要计算损失函数关于该层权重矩阵的梯度,这需要利用当前层的激活值和下一层的梯度信息。

矩阵运算在这个过程中扮演着核心角色。例如,当我们计算下一层的梯度时,通常需要对激活矩阵和该层的权重矩阵进行转置操作并相乘。接着,这一梯度会被传递到上一层,再次进行矩阵运算来更新梯度。

代码示例:

```python

import numpy as np

# 假设 W 是权重矩阵,a 是激活值,delta 是下一层的梯度

delta = ... # 下一层的梯度

W = ... # 当前层的权重矩阵

a = ... # 当前层的激活值

# 计算当前层的梯度

dW = np.dot(delta, a.T) # dW 是损失函数关于权重矩阵的梯度

```

## 4.3 矩阵运算的优化算法

### 4.3.1 矩阵分解技术

在机器学习中,矩阵分解是一种常用的优化技术,它可以用于减少计算复杂度和避免过拟合。矩阵分解技术最著名的应用之一是奇异值分解(SVD)。SVD通过将大型矩阵分解为三个较小矩阵的乘积,可以用于特征提取、降维和数据压缩。

在SVD中,一个矩阵被分解为三个矩阵U、Σ和V的乘积,其中U和V是正交矩阵,Σ是对角矩阵且对角线上的元素是奇异值。SVD可以用于去除噪声,因为在Σ矩阵中,较大的奇异值通常代表了数据的主要结构,而较小的奇异值则代表噪声。

除了SVD,还有其他的矩阵分解技术,如QR分解和LU分解等。在不同的机器学习问题中,这些分解技术可以帮助我们更好地理解和处理数据。

代码示例:

```python

from scipy.linalg import svd

# 假设 M 是一个需要分解的矩阵

U, s, V = svd(M)

# 现在 U 和 V 是正交矩阵,s 是包含奇异值的对角矩阵

```

### 4.3.2 高效矩阵操作的GPU实现

在现代机器学习应用中,高性能的矩阵运算至关重要,特别是在训练复杂的神经网络时。图形处理单元(GPU)由于其并行处理能力,已经成为进行高效矩阵运算的关键硬件。

GPU提供了专门的并行计算平台和编程模型,能够显著加速矩阵运算。NVIDIA的CUDA和OpenCL是目前最常用的GPU编程接口。在深度学习框架如TensorFlow和PyTorch中,已经实现了对GPU的支持,使得开发者能够轻松利用GPU加速矩阵运算。

代码示例:

```python

import torch

# 创建一个张量并将其移动到GPU上

tensor = torch.tensor([1, 2, 3], device='cuda')

# 对张量进行矩阵运算

result = tensor @ tensor.T # 等同于 tensor.matmul(tensor.T)

```

在GPU实现的矩阵运算中,内存管理和数据传输是需要注意的两个关键点。正确的内存管理可以避免不必要的数据复制,从而提高性能。此外,有效的数据传输策略可以减少主机和设备之间的通信开销。

```

# 5. 矩阵变换编程实践

在前几章中,我们深入探讨了矩阵变换的理论基础和在不同领域的应用。现在,让我们将这些理论付诸实践,通过具体的编程示例来了解矩阵变换在现实世界中的应用。

## 5.1 编程环境的搭建

### 5.1.1 选择合适的编程语言与库

在矩阵变换编程实践中,选择合适的编程语言和相关的数学库是至关重要的第一步。对于那些需要处理高度数学计算的场景,如机器学习、物理模拟或图形学应用,通常推荐使用以下几种组合:

- **Python**: 结合NumPy库,非常适合快速原型开发和科学计算。

- **C++**: 结合Eigen或Armadillo库,提供高效的矩阵运算,适用于性能敏感型应用。

- **MATLAB**: 直接内置了强大的矩阵计算能力,适合做矩阵变换的算法研究。

### 5.1.2 环境配置与依赖管理

在确定编程语言和库之后,下一步是配置开发环境和管理项目依赖。例如,如果您选择了Python和NumPy,可以使用pip来安装NumPy库:

```bash

pip install numpy

```

对于C++项目,如果您使用的是Eigen库,通常只需要将库文件包含在项目中即可,因为Eigen是一个只包含头文件的库。

## 5.2 矩阵变换库的实际应用

### 5.2.1 矩阵库的基本操作与函数

以NumPy为例,矩阵变换的基本操作是通过其核心数据结构“数组”完成的。以下是一些常用的NumPy操作示例:

```python

import numpy as np

# 创建一个3x3的二维数组(矩阵)

matrix = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 提取矩阵的子集

sub_matrix = matrix[:2, 1:]

# 计算矩阵的逆(如果存在)

inverse_matrix = np.linalg.inv(matrix)

# 执行矩阵乘法

result_matrix = np.dot(matrix, sub_matrix)

```

在上述代码中,我们创建了一个矩阵,提取了它的子集,并计算了它的逆矩阵和与其他矩阵的乘积。

### 5.2.2 项目中的矩阵变换实现案例

在实际项目中,矩阵变换的代码会更加复杂,并且涉及到多个矩阵库的协同工作。以3D图形渲染为例,我们可能需要进行如下的矩阵变换操作:

```python

import numpy as np

# 定义3D空间中的一个点

point = np.array([1, 0, 0])

# 创建一个旋转矩阵

theta = np.pi / 4 # 45度角

rotation_matrix = np.array([

[np.cos(theta), -np.sin(theta), 0],

[np.sin(theta), np.cos(theta), 0],

[0, 0, 1]

])

# 应用旋转矩阵到点上

transformed_point = rotation_matrix.dot(point)

print(transformed_point)

```

在这段代码中,我们定义了一个三维点,并创建了一个45度的旋转矩阵,然后将这个旋转矩阵应用到该点上,得到了变换后的新坐标。

## 5.3 性能优化与调试

### 5.3.1 性能分析工具的使用

性能优化是矩阵变换编程实践的重要环节。为了有效地识别和优化性能瓶颈,我们可以使用性能分析工具。以Python为例,可以使用`cProfile`模块来分析代码性能:

```bash

python -m cProfile -s time your_script.py

```

该命令会运行指定的Python脚本,并根据执行时间对函数调用进行排序,从而帮助我们发现性能热点。

### 5.3.2 常见错误与调试技巧

在矩阵变换编程实践中,常见的问题包括但不限于:维度不匹配、矩阵求逆失败和数值稳定性问题。对于这些问题,以下是一些调试技巧:

- 确保矩阵操作的维度匹配。例如,当使用NumPy的矩阵乘法时,确保左侧矩阵的列数与右侧矩阵的行数相同。

- 当矩阵求逆失败时,检查矩阵是否为奇异矩阵(即不可逆矩阵)。可以使用`np.linalg.det()`函数检查矩阵的行列式是否接近于零。

- 对于数值稳定性问题,可以通过添加适当的正则化项或使用更稳定的数值方法来解决。

在进行矩阵变换编程实践时,细心和耐心是必不可少的。通过不断的实践和学习,我们可以更有效地将矩阵变换应用于实际问题中。

0

0