【高维数据处理】:线性代数视角下的多维世界

发布时间: 2024-12-24 19:06:16 阅读量: 12 订阅数: 9

ABS-ER-MLA01-LinearSpaceAndTensorProduct.pdf

# 摘要

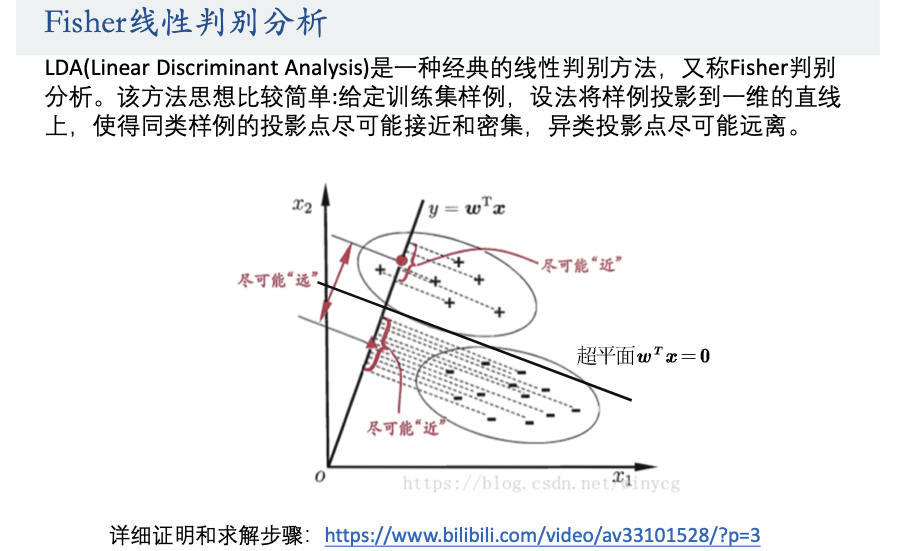

随着数据科学的发展,高维数据处理成为研究热点,其理论基础和应用技术的探索是当前大数据分析的核心挑战之一。本文从线性代数的基础知识出发,深入探讨了特征值、特征向量以及线性变换和数据投影的应用。进一步,本文实践性地介绍了主成分分析(PCA)、线性判别分析(LDA)和t-分布随机邻域嵌入(t-SNE)等多维数据分析技术,并分析了它们在基因表达数据、图像和视频处理、金融分析等现实案例中的应用。文章还针对高维数据处理的优化策略,包括正则化技术、稀疏表示方法和高效算法的实现进行了讨论,以提高处理效率,避免过拟合并优化大规模数据集的分析。

# 关键字

高维数据处理;线性代数;特征值;主成分分析;t-SNE;稀疏表示方法

参考资源链接:[《Linear Algebra Done Wrong》:为高阶学生打造的严谨入门指南](https://wenku.csdn.net/doc/2rjw6dha81?spm=1055.2635.3001.10343)

# 1. 高维数据处理的理论基础

在现代数据分析中,高维数据处理是核心议题之一。随着数据采集技术的飞速发展,我们每天都在处理比以往任何时候都多的高维数据集。本章将介绍高维数据处理的理论基础,为深入理解和应用后续章节中的技术和算法打下坚实的基础。

## 1.1 高维数据的挑战

高维数据指的是具有大量特征或变量的数据集合。这些数据在表现形式上可能非常丰富,但它们也带来了一系列挑战。在高维空间中,数据的分布变得更加稀疏,这使得传统的数据处理技术变得不再适用。比如,在高维空间中两点之间的距离可能会显得异常接近,这违反了我们的直觉,并对距离度量、聚类和分类等操作产生负面影响。因此,理解和处理高维数据需要新的理论和方法。

## 1.2 维度的诅咒

"维度的诅咒"是指随着数据维度的增加,数据的复杂性急剧上升,以至于传统的分析方法不再有效。在实际应用中,这意味着即使数据集的样本数量很大,也可能因为维度过多而导致模型的性能下降。对于高维数据处理来说,学会如何避免或减轻这种"诅咒"的影响至关重要。

通过理解高维数据处理的理论基础,我们能够更好地识别和解决在处理高维数据时遇到的困难,为后续章节中介绍的线性代数在数据处理中的应用、多维数据分析技术实践以及优化策略提供支持。

# 2. 线性代数在数据处理中的应用

### 2.1 向量和矩阵的基础

#### 2.1.1 向量的定义和性质

向量是数学和物理中一种基础的量,它有大小和方向,可以用来表示具有线性属性的数据。在线性代数中,一个向量通常由一组有序的数表示,并在几何上对应于空间中的一个点或一条线段。对于数据处理而言,一个向量往往用来表示一个数据点,其中每个元素对应于一个特征或属性。

向量的几个基本性质包括:

- **线性**: 向量的加法遵循平行四边形法则,也可以进行数乘操作,即每个分量乘以一个标量。

- **长度**: 向量的长度(或称为模)表示了向量的大小,可以通过向量的各分量的平方和的平方根计算得出。

- **方向**: 向量的方向由其与坐标轴的夹角决定。

在数据科学中,向量的线性操作经常用于特征的缩放、平移等操作。例如,数据的标准化处理就涉及到了向量长度的调整。

```mathematica

(* Mathematica 示例代码 *)

(* 创建两个向量 *)

v1 = {1, 2, 3};

v2 = {4, 5, 6};

(* 向量加法 *)

v3 = v1 + v2;

(* 向量数乘 *)

v4 = 2 * v1;

(* 输出结果 *)

v3

v4

```

上面的代码示例中,展示了两个向量的加法和数乘操作。理解这些基本操作对于深入理解更高阶的线性代数概念至关重要。

#### 2.1.2 矩阵的运算规则

矩阵是由行和列组成的矩形数组,可以看作是由多个向量按列或行排列组成的。矩阵在线性代数中扮演着核心角色,用于表示线性变换、系统方程组等复杂数据结构。

矩阵的基本运算规则包括:

- **加法和减法**: 同维矩阵可以直接进行对应位置的加减。

- **数乘**: 矩阵的每个元素都可以乘以一个标量。

- **乘法**: 矩阵乘法较为特殊,通常表示为一个矩阵的行与另一个矩阵的列的对应元素乘积之和。

- **转置**: 矩阵的转置是将矩阵的行换成列,或者列换成行。

矩阵运算在数据分析中极为重要,尤其是在多变量统计分析、机器学习等领域。矩阵不仅用于数据的整合,还用于算法的实现,如线性回归、支持向量机等。

### 2.2 特征值与特征向量

#### 2.2.1 特征值的求解方法

特征值和特征向量是线性代数中的重要概念,它们在线性变换中扮演了关键角色。对于一个方阵来说,如果存在一个非零向量和一个标量λ,使得矩阵与向量的乘积等于向量本身乘以标量λ,那么λ就是这个矩阵的一个特征值,对应的向量称为对应于λ的特征向量。

求解特征值的方法通常包括:

- **定义法**: 通过解特征方程 |A - λI| = 0 来求得特征值。

- **幂法**: 通过迭代的方式逼近最大的特征值和对应的特征向量。

- **QR算法**: 将矩阵分解为正交矩阵Q和上三角矩阵R的乘积,然后迭代求解。

```python

# Python 示例代码,使用numpy求解特征值和特征向量

import numpy as np

# 定义一个方阵

A = np.array([[1, 2], [2, 3]])

# 计算特征值和特征向量

eigenvalues, eigenvectors = np.linalg.eig(A)

# 输出结果

print("特征值:", eigenvalues)

print("特征向量:", eigenvectors)

```

在Python中,使用NumPy库可以轻松求解一个矩阵的特征值和特征向量。这在数据降维、网络分析等领域是非常有用的。

#### 2.2.2 特征向量的应用场景

特征向量的概念在线性代数以及数据科学领域中应用广泛。尤其是在数据压缩、特征提取以及理解数据结构等方面。以下是特征向量的几个常见应用场景:

- **主成分分析(PCA)**: 在PCA中,特征向量用于数据的降维,选取贡献度最大的特征向量对应的维度进行数据展示。

- **搜索算法**: 在文档检索和互联网搜索引擎中,特征向量用于表示查询和网页的相关性。

- **图像识别**: 在图像处理中,特征向量帮助识别和分类图像的特征。

### 2.3 线性变换与数据投影

#### 2.3.1 线性变换的概念和作用

线性变换是作用在向量空间上的操作,它将空间中的一个向量转换为另一个向量,并保持向量加法和数乘操作的结构。在数据处理中,线性变换可以用矩阵乘法来表示,即向量经过矩阵变换后得到新的向量。

线性变换的主要作用包括:

- **旋转和反射**: 可以表示二维或三维空间中的旋转和反射等几何变换。

- **缩放**: 可以用于特征的缩放,改变数据的尺度。

- **投影**: 可以将数据投影到低维空间,这一过程对于数据可视化和降维分析非常重要。

线性变换是数据处理的核心工具,尤其是在机器学习和模式识别中有着广泛的应用。理解线

0

0