评估聚类结果:hclust包聚类质量的精确分析方法

发布时间: 2024-11-03 10:29:01 阅读量: 39 订阅数: 37

R语言中的聚类分析:方法、实现与应用案例

# 1. 聚类分析基础

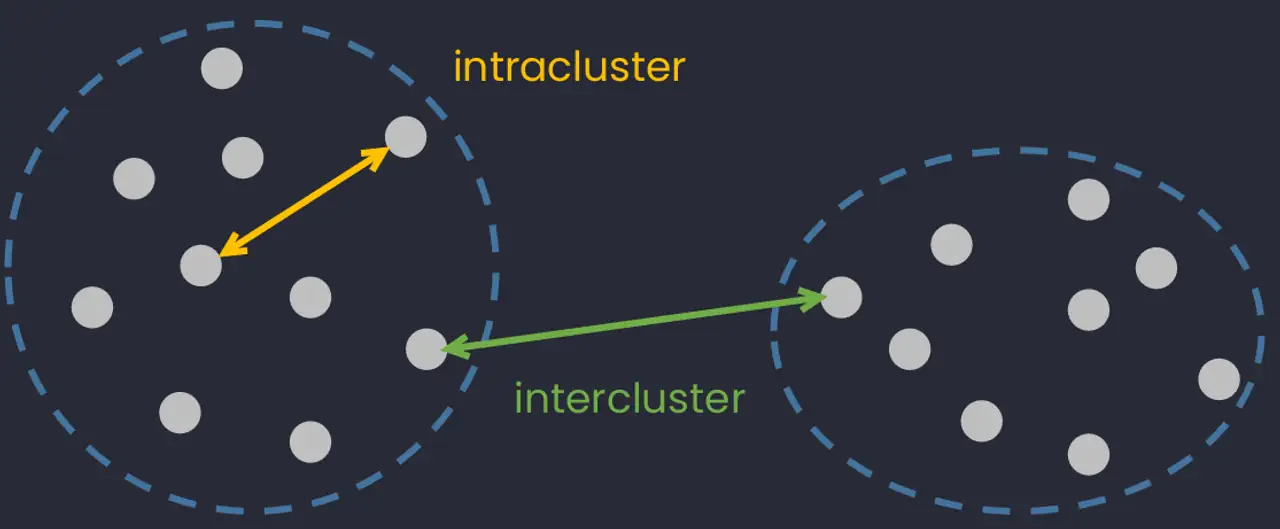

聚类分析作为数据挖掘领域中的重要分支,主要用于发现数据中的隐藏模式。它将数据集中的样本点按照相似性原则分成若干组或“簇”,使得同一簇内的数据点具有较高的相似性,而不同簇间的数据点差异较大。简单来说,聚类的过程可以看作是在没有先验信息的情况下,自动为数据划分分类。

聚类技术的种类繁多,包括划分方法、层次方法、密度方法、网格方法等。它们各自针对不同的数据特性,解决了诸如数据分布、噪声数据和聚类个数等多方面的问题。

在实际应用中,聚类分析已经成为很多领域分析数据的首选方法。如市场研究中根据消费习惯对客户进行细分,生物学中根据基因表达模式对细胞进行分类等。掌握聚类分析的基础知识对于数据科学工作者来说至关重要。

# 2. hclust包及其聚类原理

## 2.1 hclust包概述

hclust包是R语言中用于执行层次聚类分析的一个重要工具包。层次聚类是一种基本的聚类方法,它通过构建一个聚类树(dendrogram)来展示数据之间的相似性。hclust包提供了一系列函数,通过这些函数可以方便地完成从数据输入到聚类树构建的整个过程。

在层次聚类中,数据点最初被看作是单独的个体,然后根据数据点之间的距离或相似度,逐步合并成更大的聚类,直到所有的点被合并成一个整体。在这个过程中,聚类树的每一个节点代表一个聚类,树的分支长度代表了聚类之间合并的相似度或距离。

## 2.2 聚类原理深度解析

层次聚类的核心在于选择合并策略,hclust包提供了多种合并策略,例如最短距离法(single linkage)、最长距离法(complete linkage)、平均距离法(average linkage)、以及重心法(centroid method)等。这些方法的差异主要体现在如何度量两个聚类之间的距离。

- **最短距离法**:选择两个聚类中距离最近的数据点作为代表,计算其距离作为聚类间的距离。这种方法易于实现,但容易受到异常值的影响,从而产生“链状”的聚类树。

- **最长距离法**:选择两个聚类中最远的数据点作为代表,计算其距离作为聚类间的距离。这种方法对异常值的鲁棒性较好,但可能过分放大了聚类间的差异。

- **平均距离法**:计算两个聚类中所有数据点对之间的平均距离作为聚类间的距离。这种方法平衡了不同点对之间的距离,使聚类结果相对稳定。

- **重心法**:计算两个聚类重心之间的距离作为聚类间的距离。重心是聚类中所有点的均值,这种方法对聚类的形状不太敏感。

为了说明这些合并策略的差异,我们可以通过一个简单的例子来进行说明。考虑一个包含三个点A、B、C的一维数据集,其中A和B的距离较近,C点较远。使用不同的合并策略,我们可以观察到在合并顺序和最终聚类结果上的差异:

```R

# 假设数据

data <- matrix(c(1, 3, 5), nrow = 3)

rownames(data) <- c("A", "B", "C")

# 最短距离法

hc_single <- hclust(dist(data), method="single")

plot(hc_single)

# 最长距离法

hc_complete <- hclust(dist(data), method="complete")

plot(hc_complete)

# 平均距离法

hc_average <- hclust(dist(data), method="average")

plot(hc_average)

# 重心法

hc_centroid <- hclust(dist(data), method="centroid")

plot(hc_centroid)

```

以上代码块将分别绘制出使用不同合并策略得到的聚类树。通过比较这些树,我们可以清楚地看到不同的合并策略如何影响聚类的结构。

## 2.3 聚类算法的应用步骤

层次聚类算法的应用可以分为几个明确的步骤:

1. 数据准备:首先,需要准备待聚类的数据集,通常这个数据集包含多个特征变量,并且数据已经被清洗和预处理。

2. 距离计算:接着,计算数据点之间的距离,通常是欧氏距离或其他距离度量方法。

3. 聚类树构建:然后,使用距离信息构建聚类树。在构建过程中选择适当的合并策略。

4. 树剪枝与聚类划分:最后,通过剪枝来确定最终的聚类数量和聚类成员。剪枝是根据一定的标准(如树高、距离等)来判断何时停止合并,以得到实际的聚类结果。

## 2.4 hclust包的使用技巧

hclust包提供了一系列函数来执行层次聚类,其中最重要的函数是`hclust()`。这个函数的基本用法如下:

```R

hc <- hclust(distance_matrix, method)

```

- `distance_matrix`是输入的距离矩阵,表示数据点之间的距离。

- `method`指定了合并策略,可以选择的参数包括`"single"`, `"complete"`, `"average"`, `"centroid"`等。

构建了聚类树之后,可以通过`cutree()`函数来提取具体的聚类结果:

```R

clusters <- cutree(hc, k)

```

- `hc`是之前构建的聚类树对象。

- `k`是需要划分的聚类数量。

## 2.5 hclust包与其他包的整合使用

在实践中,hclust包常与R语言中的其他包结合使用,以便于进行更复杂的数据分析。例如,使用`ggplot2`包进行聚类结果的可视化:

```R

# 首先,需要安装并加载 ggplot2 包

install.packages("ggplot2")

library(ggplot2)

# 使用ggplot2绘制聚类树

ggdendrogram(hc, rotate=TRUE)

```

`ggplot2`提供了`ggdendrogram()`函数,可以将hclust包产生的聚类树对象转换为`ggplot`图形对象,方便进行定制化的图形调整和展示。

通过这些步骤,我们可以看到hclust包在层次聚类分析中的应用方法。下一章将介绍如何评估聚类质量的指标,这将帮助我们确认聚类结果的有效性和可靠性。

# 3. 聚类质量的评估指标

在聚类分析中,正确评估聚类质量是至关重要的一步。它不仅有助于确认聚类结果的有效性,还可以指导我们调整算法参数,以获得更优的聚类结果。评估指标从不同角度反映了聚类结果的质量,主要分为内部评价指标、外部评价指标以及稳定性评价。

## 3.1 内部评价指标

内部评价指标主要基于聚类结果本身来评估其优劣,不需要外部的先验信息。因此,这些指标通常用

0

0