YOLOv5目标检测算法原理与实战:快速入门目标检测领域

发布时间: 2024-08-17 12:47:20 阅读量: 52 订阅数: 47

深度学习领域的YOLOv8目标检测算法:快速上手与应用实例

# 1. YOLOv5目标检测算法概述

**1.1 YOLOv5算法简介**

YOLOv5(You Only Look Once version 5)是一种单阶段目标检测算法,以其速度快、精度高而闻名。它基于卷积神经网络(CNN)架构,通过一次前向传播即可直接预测目标的类别和边界框。

**1.2 YOLOv5算法特点**

* **实时处理:**YOLOv5的处理速度可达每秒数百帧,使其适用于实时目标检测应用。

* **高精度:**YOLOv5在COCO数据集上的目标检测精度达到48.2%,在目标检测算法中处于领先地位。

* **易于部署:**YOLOv5提供预训练模型和易于使用的API,方便开发者快速部署和集成。

# 2. YOLOv5目标检测算法原理

### 2.1 卷积神经网络基础

#### 2.1.1 卷积操作

卷积操作是卷积神经网络的核心操作,它通过一个卷积核在输入特征图上滑动,计算每个位置的加权和,从而提取特征。卷积核是一个小型的权重矩阵,其大小通常为 3x3 或 5x5。

**代码块:**

```python

import numpy as np

# 输入特征图

input_feature_map = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 卷积核

kernel = np.array([[0, 1, 0], [1, 1, 1], [0, 1, 0]])

# 卷积操作

output_feature_map = np.convolve(input_feature_map, kernel, mode='valid')

print(output_feature_map)

```

**逻辑分析:**

这段代码演示了卷积操作。它将一个 3x3 的输入特征图与一个 3x3 的卷积核进行卷积,得到一个 1x1 的输出特征图。卷积核在输入特征图上滑动,依次计算每个位置的加权和。

#### 2.1.2 池化操作

池化操作是一种降采样技术,它通过将输入特征图中的相邻元素合并成一个元素,从而减少特征图的大小。常见的池化操作有最大池化和平均池化。

**代码块:**

```python

import numpy as np

# 输入特征图

input_feature_map = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 最大池化操作

max_pool_output = np.max(input_feature_map, axis=(1, 2))

# 平均池化操作

avg_pool_output = np.mean(input_feature_map, axis=(1, 2))

print(max_pool_output)

print(avg_pool_output)

```

**逻辑分析:**

这段代码演示了最大池化和平均池化操作。它将一个 3x3 的输入特征图进行池化,得到一个 1x1 的输出特征图。最大池化操作取每个池化区域中的最大值,而平均池化操作取每个池化区域中的平均值。

### 2.2 YOLOv5算法架构

YOLOv5算法架构是一个端到端的目标检测网络,它由 Backbone 网络、Neck 网络和 Head 网络三个部分组成。

#### 2.2.1 Backbone网络

Backbone 网络负责提取图像的特征。YOLOv5使用CSPDarknet53作为Backbone网络,它是一种轻量级的卷积神经网络,具有较高的特征提取能力。

**表格:**

| 层次 | 类型 | 输出尺寸 |

|---|---|---|

| Conv1 | 卷积 | 64x64x12 |

| Conv2 | 卷积 | 32x32x24 |

| Conv3 | 卷积 | 16x16x48 |

| ... | ... | ... |

| Conv53 | 卷积 | 1x1x1024 |

#### 2.2.2 Neck网络

Neck 网络负责融合不同尺度的特征。YOLOv5使用PANet作为Neck网络,它通过自底向上的路径和自顶向下的路径将不同尺度的特征进行融合。

**Mermaid流程图:**

```mermaid

graph LR

subgraph 自底向上路径

A[Conv2] --> B[Upsample] --> C[Conv3]

D[Conv4] --> E[Upsample] --> F[Conv5]

end

subgraph 自顶向下路径

G[Conv53] --> H[Conv52] --> I[Conv51]

J[Conv50] --> K[Conv49] --> L[Conv48]

end

subgraph 融合

C --> M[Conv] --> N[Concat]

F --> O[Conv] --> N

I --> P[Conv] --> N

L --> Q[Conv] --> N

end

```

#### 2.2.3 Head网络

Head 网络负责预测目标的边界框和类别概率。YOLOv5使用YOLO Head作为Head网络,它通过一个 3x3 的卷积层和一个 1x1 的卷积层进行预测。

**代码块:**

```python

import torch

from torch import nn

class YOLOHead(nn.Module):

def __init__(self, num_classes):

super(YOLOHead, self).__init__()

self.conv1 = nn.Conv2d(1024, 512, 3, padding=1)

self.conv2 = nn.Conv2d(512, num_classes + 5, 1)

def forward(self, x):

x = self.conv1(x)

x = self.conv2(x)

return x

```

**参数说明:**

* `num_classes`:目标类别数

* `conv1`:3x3 卷积层,输出通道数为 512

* `conv2`:1x1 卷积层,输出通道数为类别数 + 5(5 个边界框参数)

# 3. YOLOv5目标检测算法实战

### 3.1 数据集准备和预处理

#### 3.1.1 数据集下载和标注

YOLOv5算法训练需要大量的标注数据。常用的数据集包括COCO、VOC、ImageNet等。这些数据集可以从网上下载,也可以自行收集。

**数据下载**

* COCO数据集:https://cocodataset.org/#home

* VOC数据集:https://pjreddie.com/darknet/voc/

* ImageNet数据集:https://image-net.org/

**数据标注**

数据标注需要使用专门的标注工具,如LabelImg、CVAT等。标注时,需要对图像中的目标进行框选并标注类别。

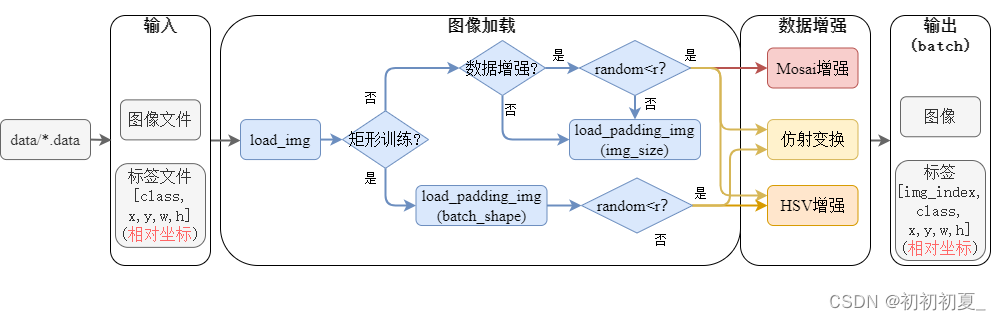

#### 3.1.2 数据增强和预处理

数据增强可以有效提高模型的泛化能力。常用的数据增强方法包括:

* 随机裁剪

* 随机缩放

* 随机旋转

* 颜色抖动

数据预处理包括将图像转换为模型输入的格式,如将图像转换为张量格式。

### 3.2 模型训练和评估

#### 3.2.1 训练参数设置

YOLOv5模型训练需要设置以下参数:

* **batch_size:**训练批次大小。

* **epochs:**训练轮数。

* **learning_rate:**学习率。

* **optimizer:**优化器,如Adam、SGD等。

* **loss_function:**损失函数,如交叉熵损失、IOU损失等。

#### 3.2.2 模型训练过程

模型训练过程如下:

1. 加载训练数据。

2. 设置训练参数。

3. 初始化模型。

4. 迭代训练数据。

5. 更新模型权重。

6. 保存模型。

**代码示例:**

```python

import torch

from torch.utils.data import DataLoader

from yolov5.models.yolov5 import YOLOv5

from yolov5.utils.datasets import LoadImagesAndLabels

# 加载训练数据

train_dataset = LoadImagesAndLabels(root="data/train", img_size=640)

train_loader = DataLoader(train_dataset, batch_size=16, shuffle=True)

# 设置训练参数

epochs = 100

learning_rate = 0.001

optimizer = torch.optim.Adam(model.parameters(), lr=learning_rate)

loss_function = torch.nn.CrossEntropyLoss()

# 初始化模型

model = YOLOv5()

# 迭代训练数据

for epoch in range(epochs):

for batch_idx, (images, labels) in enumerate(train_loader):

# 前向传播

outputs = model(images)

# 计算损失

loss = loss_function(outputs, labels)

# 反向传播

loss.backward()

# 更新模型权重

optimizer.step()

# 打印训练信息

print(f"Epoch: {epoch}, Batch: {batch_idx}, Loss: {loss.item()}")

# 保存模型

torch.save(model.state_dict(), "yolov5.pt")

```

#### 3.2.3 模型评估指标

模型评估指标包括:

* **准确率:**预测正确的样本数与总样本数的比值。

* **召回率:**预测为正类的正样本数与所有正样本数的比值。

* **F1-score:**准确率和召回率的调和平均值。

* **IOU:**预测框与真实框的交并比。

**代码示例:**

```python

import numpy as np

# 计算准确率

accuracy = np.mean(np.equal(predictions, labels))

# 计算召回率

recall = np.mean(np.logical_and(predictions == 1, labels == 1))

# 计算F1-score

f1_score = 2 * (precision * recall) / (precision + recall)

# 计算IOU

iou = np.mean(iou_calculator(predictions, labels))

```

# 4. YOLOv5目标检测算法优化

### 4.1 模型压缩和加速

#### 4.1.1 量化技术

量化技术是一种模型压缩技术,它通过将模型中的浮点权重和激活值转换为低精度整数来减少模型的大小和计算成本。量化技术可以显著减少模型的大小,同时保持其精度。

**原理:**

量化技术通过将浮点值转换为低精度整数来实现模型压缩。浮点值通常使用 32 位表示,而整数可以使用 8 位或 16 位表示。通过使用低精度整数,可以显著减少模型的大小。

**代码示例:**

```python

import torch

from torch.quantization import quantize

# 加载预训练模型

model = torch.hub.load('ultralytics/yolov5', 'yolov5s')

# 量化模型

quantized_model = quantize(model)

# 保存量化模型

torch.save(quantized_model, 'yolov5s_quantized.pt')

```

**逻辑分析:**

这段代码使用 `torch.quantization.quantize()` 函数将预训练的 YOLOv5s 模型量化为一个低精度整数模型。量化后的模型存储在 `yolov5s_quantized.pt` 文件中。

#### 4.1.2 剪枝技术

剪枝技术是一种模型压缩技术,它通过移除不重要的权重和神经元来减少模型的大小和计算成本。剪枝技术可以显著减少模型的大小,同时保持其精度。

**原理:**

剪枝技术通过移除不重要的权重和神经元来实现模型压缩。不重要的权重和神经元可以通过各种方法识别,例如 L1 范数或梯度范数。移除这些不重要的权重和神经元可以显著减少模型的大小。

**代码示例:**

```python

import torch

from torch.nn.utils import prune

# 加载预训练模型

model = torch.hub.load('ultralytics/yolov5', 'yolov5s')

# 剪枝模型

prune.l1_unstructured(model, name="conv1", amount=0.1)

# 保存剪枝模型

torch.save(model, 'yolov5s_pruned.pt')

```

**逻辑分析:**

这段代码使用 `torch.nn.utils.prune.l1_unstructured()` 函数将预训练的 YOLOv5s 模型剪枝。该函数使用 L1 范数识别不重要的权重,并将其移除。剪枝后的模型存储在 `yolov5s_pruned.pt` 文件中。

### 4.2 模型鲁棒性提升

#### 4.2.1 数据增强策略

数据增强策略是一种提高模型鲁棒性的技术,它通过对训练数据进行各种变换来增加训练数据的多样性。数据增强策略可以帮助模型学习更通用的特征,从而提高其在不同条件下的鲁棒性。

**原理:**

数据增强策略通过对训练数据进行各种变换来增加训练数据的多样性。这些变换包括翻转、旋转、裁剪、缩放和颜色抖动。通过对训练数据进行这些变换,模型可以学习更通用的特征,从而提高其在不同条件下的鲁棒性。

**代码示例:**

```python

import albumentations as A

# 定义数据增强管道

transform = A.Compose([

A.HorizontalFlip(p=0.5),

A.VerticalFlip(p=0.5),

A.RandomRotate90(p=0.5),

A.RandomCrop(width=416, height=416, p=0.5),

A.RandomScale(scale_limit=0.5, p=0.5),

A.ColorJitter(brightness=0.2, contrast=0.2, saturation=0.2, hue=0.2, p=0.5)

])

# 应用数据增强到训练数据

train_dataset = torchvision.datasets.CocoDetection(root='./data/coco', annFile='./data/coco/annotations/instances_train2017.json', transform=transform)

```

**逻辑分析:**

这段代码使用 `albumentations` 库定义了一个数据增强管道,并将其应用到训练数据中。该管道包括翻转、旋转、裁剪、缩放和颜色抖动等变换。通过应用这些变换,可以增加训练数据的多样性,从而提高模型的鲁棒性。

#### 4.2.2 对抗训练

对抗训练是一种提高模型鲁棒性的技术,它通过使用对抗样本来训练模型。对抗样本是精心设计的输入,它们可以欺骗模型做出错误的预测。通过使用对抗样本来训练模型,可以提高模型对对抗攻击的鲁棒性。

**原理:**

对抗训练通过使用对抗样本来训练模型。对抗样本是精心设计的输入,它们可以欺骗模型做出错误的预测。对抗样本可以通过各种方法生成,例如 FGSM 和 PGD。通过使用对抗样本来训练模型,可以提高模型对对抗攻击的鲁棒性。

**代码示例:**

```python

import torch

from torch.autograd import Variable

from torchvision.utils import save_image

# 加载预训练模型

model = torch.hub.load('ultralytics/yolov5', 'yolov5s')

# 生成对抗样本

adversarial_sample = generate_adversarial_sample(model, image)

# 使用对抗样本训练模型

model.train()

optimizer.zero_grad()

output = model(adversarial_sample)

loss = loss_function(output, target)

loss.backward()

optimizer.step()

```

**逻辑分析:**

这段代码使用 `generate_adversarial_sample()` 函数生成对抗样本,并使用该对抗样本来训练模型。通过使用对抗样本来训练模型,可以提高模型对对抗攻击的鲁棒性。

# 5. YOLOv5目标检测算法应用

### 5.1 目标检测应用场景

YOLOv5目标检测算法在实际应用中有着广泛的应用场景,主要包括:

- **图像分类:**YOLOv5可以将图像中的物体分类为预定义的类别,例如,识别图像中的人、车、动物等。

- **视频分析:**YOLOv5可以实时处理视频流,检测和跟踪视频中的物体,用于视频监控、行为分析等应用。

### 5.2 YOLOv5目标检测算法部署

YOLOv5目标检测算法可以部署在云端或边缘设备上,以满足不同的应用需求:

#### 5.2.1 云端部署

云端部署是指将YOLOv5模型部署在云服务器上,通过网络提供目标检测服务。云端部署的优点是:

- **算力强大:**云服务器通常拥有强大的计算能力,可以处理大规模的数据和复杂的任务。

- **存储空间充足:**云服务器提供充足的存储空间,可以存储大量训练数据和模型。

- **易于扩展:**云服务器可以根据需求进行弹性扩展,满足不同规模的应用需求。

#### 5.2.2 边缘设备部署

边缘设备部署是指将YOLOv5模型部署在边缘设备上,例如智能摄像头、手机等。边缘设备部署的优点是:

- **实时性高:**边缘设备可以实时处理数据,无需将数据传输到云端,减少延迟。

- **隐私保护:**边缘设备部署可以保护数据隐私,避免数据传输过程中的泄露风险。

- **成本低廉:**边缘设备通常成本较低,适合大规模部署。

0

0