【树形结构算法详解】:研究生期末试题中的决策树构建与剪枝策略

发布时间: 2025-01-06 03:37:03 阅读量: 9 订阅数: 9

决策树剪枝算法的python实现方法详解

# 摘要

决策树算法是一种流行的机器学习技术,广泛应用于数据分类和预测。本文从决策树算法的概念出发,详细探讨了其构建原理,包括熵和信息增益的基本概念、决策树的学习算法以及停止准则。进一步地,本文深入分析了决策树剪枝技术,阐述了剪枝的必要性、不同剪枝策略以及实践中常见的剪枝方法。接着,本文介绍了决策树算法的实现与优化方法,包括编程实现、优化技巧和模型评估。最后,本文展示了决策树算法在实际问题中的应用,从数据分类、数据预测到机器学习竞赛中的案例分析。本文旨在为读者提供决策树算法全面的理论知识和实践指南。

# 关键字

决策树;熵;信息增益;剪枝技术;模型优化;数据分类

参考资源链接:[北京交通大学硕士研究生《机器学习》试题及参考答案](https://wenku.csdn.net/doc/6401ad3dcce7214c316eecf6?spm=1055.2635.3001.10343)

# 1. 决策树算法概述

在机器学习领域,决策树算法是众多算法中的经典之作,它以树状图形的方式进行决策过程的可视化,便于理解和解释。决策树算法是一种有监督的学习方法,能够处理数值型和分类型数据,并且在分类和回归问题中都有广泛应用。它的核心思想是通过一系列的规则将数据集进行划分,直到每个子数据集仅包含一个类别或分布均匀,从而实现对新数据的预测和分类。

让我们从决策树的基本概念和构建流程开始探索,逐步深入到算法的细节、剪枝技术以及在实际问题中的应用。这一章节将为读者提供一个坚实的决策树算法概念基础,并为进一步的学习和探索铺平道路。接下来的章节,我们将详细讨论决策树的构建原理,包括如何通过熵和信息增益来选择最佳分裂属性,以及决策树学习算法的不同类型。

# 2. 决策树的构建原理

决策树算法是一种基本的分类与回归方法。它的核心是通过一系列的规则将数据集划分成子集,这些规则以树状结构表达出来,因此被称为决策树。构建决策树的目的是找到能够最好地对数据集进行分类的规则。理解决策树的构建原理对于掌握决策树算法以及后续的优化至关重要。

## 2.1 熵和信息增益

### 2.1.1 熵的概念和计算方法

在信息论中,熵是衡量信息量的一个重要指标,它的本质反映了信息的混乱度。在决策树中,熵被用于衡量数据集的纯度。如果一个数据集完全属于同一类别,则熵值为0,意味着信息熵最小,不确定性最小。相反,如果数据集中类别分布均匀,则熵值最大。

计算一个数据集的熵值的公式如下:

\[ H(S) = -\sum_{i=1}^{n} p_i \log_2 p_i \]

其中,\( H(S) \) 表示数据集 \( S \) 的熵,\( p_i \) 表示数据集中属于第 \( i \) 类的概率,\( n \) 是类别总数。

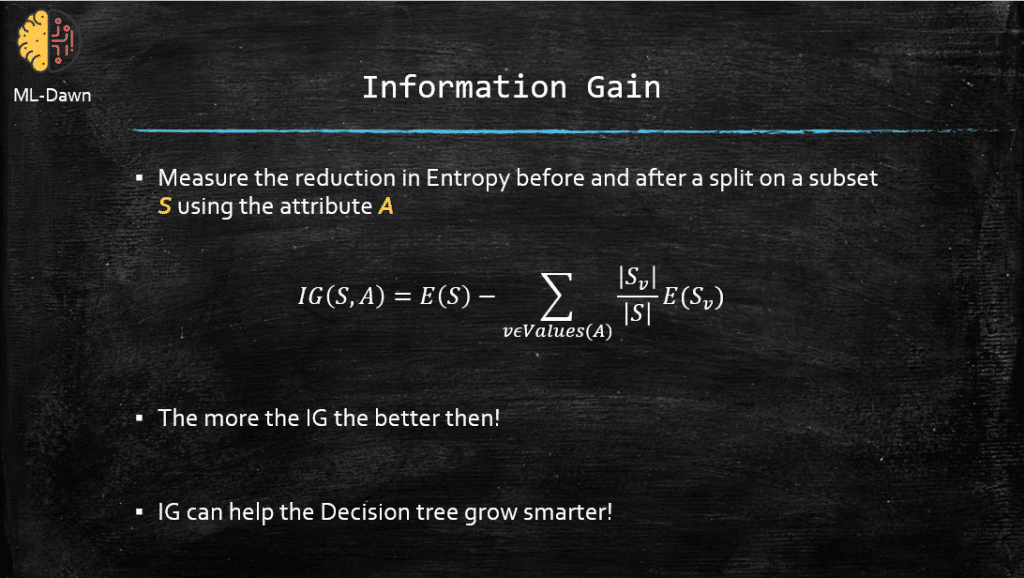

### 2.1.2 信息增益的定义及计算

信息增益是决策树算法中一个核心概念,它是划分前后数据集纯度差异的度量。信息增益越大,意味着使用当前特征进行数据集划分后得到的信息越多,即纯度提升越高。信息增益的计算公式如下:

\[ IG(S, A) = H(S) - \sum_{t \in T} \frac{|S_t|}{|S|} H(S_t) \]

其中,\( IG(S, A) \) 表示用特征 \( A \) 划分数据集 \( S \) 后的信息增益,\( H(S) \) 和 \( H(S_t) \) 分别表示划分前后的熵,\( T \) 是划分后的数据集集合。

## 2.2 决策树的学习算法

### 2.2.1 ID3算法的工作流程

ID3(Iterative Dichotomiser 3)是最初的决策树学习算法,它使用信息增益作为划分数据集的标准。ID3算法的工作流程如下:

1. 计算数据集 \( S \) 中所有特征的信息增益,并选择信息增益最大的特征作为当前节点的划分特征。

2. 根据选定的特征划分数据集,为每个划分创建一个分支,并成为下个节点。

3. 递归地对每个分支的数据集应用相同的过程,直到满足停止准则(例如,所有实例都属于同一类,或者没有更多特征可用)。

### 2.2.2 C4.5算法的改进和优化

C4.5是ID3算法的一个改进版本,由Ross Quinlan提出。C4.5算法使用信息增益比作为特征选择的标准,以减少对具有更多取值的特征的偏好。其工作流程与ID3类似,但在处理连续特征和缺失值时表现出更好的性能。

### 2.2.3 CART算法的树构建

CART(Classification and Regression Trees)算法既适用于分类问题也适用于回归问题。它使用基尼不纯度作为衡量标准,通过递归二分法(每次分裂为两个子节点)构建决策树。CART算法工作流程如下:

1. 对于每个特征 \( A \),找到最佳分裂点 \( s \),使得按照 \( A \) 的 \( s \) 分裂的两个数据子集的基尼不纯度最小。

2. 在所有特征和分裂点中,选择最佳的特征和分裂点进行分裂。

3. 递归地对得到的两个子节点应用上述过程,直到满足停止准则。

## 2.3 决策树的停止准则

### 2.3.1 叶节点的纯度判断

叶节点的纯度是指节点中的实例是否都属于同一类别。通常,我们通过设置一个阈值来判断是否达到纯度要求。如果一个节点中的实例纯度超过这个阈值,那么可以认为该节点已经足够“纯”,则停止进一步分裂。

### 2.3.2 最小样本分割和树的最大深度

为了避免过拟合,需要设定一些停止准则:

- **最小样本分割**:当一个节点中的样本数量小于一个预设值时,停止分裂。

- **树的最大深度**:当树的深度达到一个预设值时,停止分裂。

这些准则有助于限制

0

0