【打造Python高效环境】:Anaconda新手入门必学技巧

21天学通Python 简单易懂 适合新手

1. Anaconda简介与安装

Anaconda是一个开源的Python发行版本,它使得数据科学家可以方便地安装和管理Python包,以及它们的依赖关系。Anaconda的特色之一是它预装了如NumPy、Pandas、SciPy等数据科学领域常用的数据处理、科学计算、机器学习库。此外,Anaconda还包含Conda——一个开源的包、依赖和环境管理器,可以快捷地创建、保存、加载和切换不同环境,极大地简化了多版本Python共存和多项目管理的复杂性。

1.1 Anaconda的安装

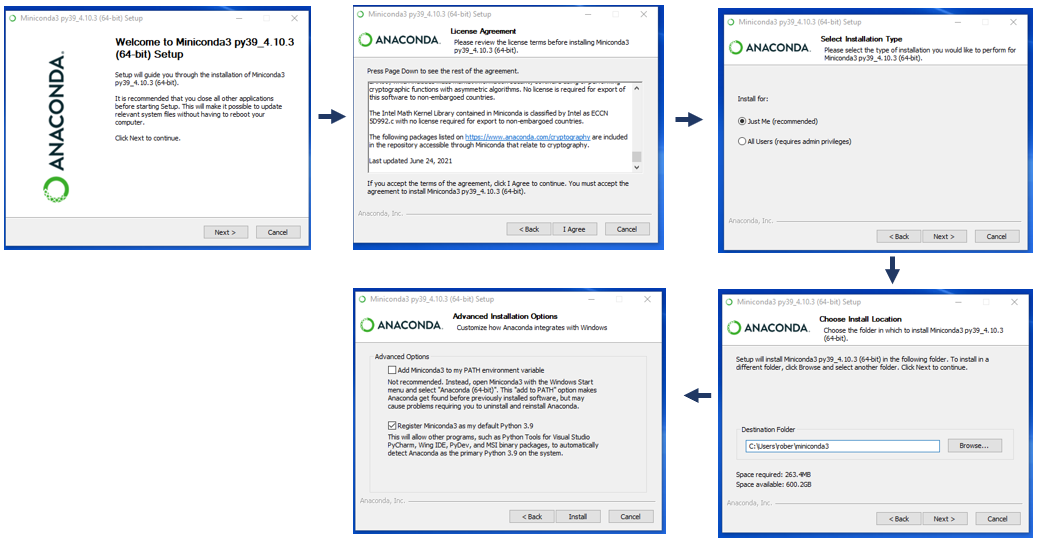

Anaconda的安装过程简单快捷,用户只需要遵循以下步骤:

- 访问Anaconda官网下载适合操作系统(Windows、macOS、Linux)的安装程序。

- 运行下载的安装包并遵循安装向导提示,完成安装。

- 安装完成后,打开命令行或终端,输入

conda --version,如果出现版本信息,则表示安装成功。

安装过程中可选的配置项有环境路径、高级选项等。推荐将Anaconda路径添加到系统的环境变量中,以便在任何路径下使用Anaconda命令。

- # Windows系统

- set PATH=%PATH%;C:\path\to\anaconda\bin

- # macOS/Linux系统

- export PATH=/path/to/anaconda/bin:$PATH

安装成功后,接下来可以通过conda update conda命令检查并更新Conda到最新版本,确保系统稳定性和功能完整性。

2. Anaconda环境管理

2.1 环境的创建与配置

2.1.1 创建虚拟环境

在进行多项目开发时,每个项目都可能依赖于不同版本的库。为了避免版本冲突和保护系统环境,创建虚拟环境是最佳实践。在Anaconda中创建一个新的虚拟环境可以通过conda create命令完成。

- conda create -n myenv python=3.8

上面的命令创建了一个名为myenv的新环境,并指定了Python版本为3.8。创建环境后,使用conda activate myenv命令激活环境,之后在这个环境中安装的包将只影响到myenv,而不会影响到系统的其他部分。

2.1.2 环境变量的配置与管理

环境变量是操作系统用来指定操作系统运行环境的一些参数,如临时文件夹位置、系统文件夹位置、程序搜索路径等。在Anaconda环境中,环境变量的管理同样非常重要,尤其是在涉及多个环境和多个项目依赖时。

环境变量可以通过conda env config vars set命令进行设置:

- conda env config vars set SOME_VAR=/path/to/some/value

要查看当前环境变量的设置,可以使用以下命令:

- conda env config vars list

2.2 包管理基础

2.2.1 包的安装与更新

Anaconda利用conda命令来管理包。安装一个新包的命令如下:

- conda install numpy

此命令会安装NumPy包及其依赖。如果要安装特定版本的包,可以指定版本号:

- conda install numpy=1.20.1

更新包时,可以使用conda update命令:

- conda update numpy

这将会把NumPy更新到最新版本。如果要更新所有包,可以使用:

- conda update --all

2.2.2 包的卸载与查询

卸载不需要的包,可以使用:

- conda remove numpy

如果需要查询已安装的包,可以使用:

- conda list

或者,如果想查找特定的包,可以使用搜索:

- conda search pandas

2.3 环境的导出与导入

2.3.1 导出环境配置文件

有时需要在新的机器上复制相同的环境或共享环境给他人。可以使用conda env export命令导出环境的配置文件:

- conda env export -n myenv > environment.yml

这个命令会把myenv环境的所有配置导出到一个名为environment.yml的文件中。

2.3.2 导入环境到新系统

在新的机器或新环境中导入环境,可以使用conda env create命令:

- conda env create -f environment.yml

这个命令会从environment.yml文件中读取配置,并创建相同的环境。

2.4 高级环境管理技巧

2.4.1 环境隔离技术

为了避免不同项目之间环境互相干扰,可以创建隔离的环境。这可以通过使用不同的前缀来实现,例如:

- conda create -p /path/to/new/prefix

此外,虚拟环境可以帮助隔离项目依赖,避免系统级的安装冲突。

2.4.2 环境复用与版本控制

环境复用是通过导出和导入环境配置文件来实现的。这样可以确保在不同的机器或开发人员之间,项目可以具有完全一致的依赖环境。环境配置文件同时也是一种环境的版本控制方式,你可以保存并跟踪不同时间点的环境配置状态。

2.5 环境管理常见问题与解答

2.5.1 如何解决环境中的包冲突问题?

包冲突是常见的问题,特别是当多个包依赖于不同版本的同一个包时。为了避免这种情况,可以创建多个专门针对不同需求的环境,并使用conda install命令精确安装需要的包版本。

- conda create -n py36 python=3.6

- conda activate py36

- conda install -c conda-forge version-specific-package

2.5.2 如何自动化环境管理?

为了自动化环境管理,可以将环境配置文件放入版本控制系统,并编写脚本来自动化环境的创建和销毁。例如:

- # 创建环境

- conda env create -f environment.yml

- # 销毁环境

- conda env remove -n myenv

2.5.3 如何确保环境的一致性?

确保环境的一致性可以通过持续集成(CI)系统来实现。每次项目构建时,CI工具可以自动创建一个新的环境,并根据定义的配置文件安装所有必要的依赖项。这样可以确保在不同机器上的项目运行环境一致。

2.6 小结

在本章节中,我们介绍了Anaconda环境管理的基本概念和操作。通过创建、配置、导出与导入虚拟环境,我们能够灵活地管理项目依赖,并在多个项目和团队成员之间共享一致的环境。同时,我们也探讨了一些高级技巧,比如环境隔离和版本控制,以及如何解决常见问题和自动化环境管理。这些技巧将帮助开发者更高效地进行项目开发和部署。

3. Anaconda中的Jupyter Notebook

3.1 Jupyter Notebook的启动与使用

3.1.1 启动Notebook服务器

Jupyter Notebook是一个强大的交互式计算环境,它允许用户以文档的形式编写代码和文本,非常适合数据分析和科学计算。启动Jupyter Notebook服务器非常简单,您只需要在命令行中输入以下指令:

- jupyter notebook

执行完毕后,系统会自动打开默认的网页浏览器,并导航到Jupyter Notebook的主界面。如果您的系统没有自动打开浏览器,您也可以手动复制浏览器中提供的URL地址,通常是http://localhost:8888/tree。

服务器启动后,界面会显示当前目录下的所有文件和文件夹。此时,您可以点击右上角的New按钮,选择Python 3来创建一个新的Notebook文档。Notebook是一个以.ipynb为后缀的文件,可以保存代码、公式、可视化和文本等多种格式。

3.1.2 Notebooks的基本操作

创建一个新的Notebook后,您会看到一个空白的单元格。您可以在此单元格中输入Python代码,然后按Shift + Enter执行。代码执行的结果会显示在单元格下方。

单元格中还可以包含文本和Markdown格式的内容,您只需在单元格类型中选择Markdown,然后输入Markdown语法编写的文本。完成编辑后,同样按Shift + Enter,文本会被渲染出来。

此外,Jupyter Notebook还提供了丰富的快捷键,用于提高您的工作效率。例如,您可以使用Esc键切换到命令模式,在命令模式下,使用A或B可以在当前单元格的上方或下方插入新的单元格。使用M可以将单元格类型切换为Markdown。

3.1.3 其他常用操作

- 保存和导出:Jupyter Notebook会自动保存您的工作,但您也可以手动点击工具栏中的

Save按钮来保存当前的状态。您可以导出Notebook为不同的格式,包括HTML、PDF和Python脚本(.py)。 - 重置内核:在

Kernel菜单下,您可以看到重置内核(Restart)和重启并清除输出(Restart & Clear Output)的选项。这在处理内核挂起或需要重置环境变量时非常有用。 - 关闭Notebook:完成工作后,您可以在浏览器中关闭Notebook的标签页,然后在Jupyter服务器界面中也关闭对应的Notebook。

Jupyter Notebook是一个非常灵活的工具,它支持多种编程语言,并且可以轻松地通过扩展来增强其功能。接下来,让我们深入探讨一些Notebook的高级功能。

3.2 Notebook的高级功能

3.2.1 代码和文本单元格的编辑

在Notebook中,代码单元格用于执行Python代码,而文本单元格则用于添加Markdown格式的说明性内容。您可以轻松地在两者之间切换,并利用Markdown语法来格式化文本内容,比如:

- # 标题

- ## 小标题

- - 列表项1

- - 列表项2

- **粗体文本**

- `内联代码`

在代码单元格中,您不仅能输入Python代码,还可以使用%%符号来指定该单元格使用的内核类型,例如:

- %%bash

- echo "这是在bash内核下执行的脚本"

或者使用%%HTML来让单元格输出HTML代码。

3.2.2 内核管理和交互式小部件

内核(Kernel)是Notebook的后台运行环境,它负责执行代码单元格中的代码,并返回输出结果。在某些情况下,内核可能会挂起或者不再响应。此时,您可以在Kernel菜单下选择Interrupt或Restart来中断或重启内核。

在Notebook的高级应用中,交互式小部件(widgets)提供了丰富的用户界面元素,如滑块、下拉菜单和文本输入框等,能够用来创建动态的交互式应用程序。例如,可以使用ipywidgets库来添加一个简单的滑块:

- import ipywidgets as widgets

- widgets.IntSlider(

- value=7,

- min=0,

- max=10,

- step=1,

- description='Test:',

- disabled=False,

- continuous_update=False,

- orientation='horizontal',

- readout=True,

- readout_format='d'

- )

在执行上述代码后,您将看到一个水平滑块,可以用来调整值并观察输出结果。这为数据分析和可视化带来了更多的可能性。

3.3 Notebook的扩展与优化

3.3.1 安装和管理扩展

Notebook的可扩展性是其一大优势。通过安装nbextensions,我们可以添加各种扩展功能来增强Notebook的用户体验。您可以使用以下命令来安装nbextensions:

- jupyter contrib nbextension install --user

安装完成后,您可以通过Jupyter Notebook的界面进入nbextensions配置页面。在这里,您可以启用或禁用不同的扩展,比如:

Collapsible Headings: 提供可折叠的头部,方便管理长文档。ExecuteTime: 显示每个单元格执行所需的时间。Hinterland: 自动补全代码。

3.3.2 性能调优和资源管理

Notebook的性能调优包括内核管理、内存和CPU资源的合理使用。在多内核或大规模数据集操作时,合理地管理内核资源至关重要。可以使用nbdime来比较不同Notebook之间的变更,并监控内核的使用情况。

另一方面,优化代码以减少资源消耗也是一个重要方面。例如,对于大规模数据处理,可以利用Pandas的优化技巧,比如使用chunksize参数进行分块读取数据,或者使用更高效的函数和方法。

最后,Jupyter的服务器配置也可以进行优化,比如通过设置超时时间、限制并发用户数等方式来提高服务的稳定性和性能。

以上便是对Jupyter Notebook在Anaconda环境中使用的详细介绍。从基础的启动与使用,到高级功能的探索,再到性能的扩展和优化,Jupyter Notebook为数据科学的实践者提供了一个高效而强大的平台。在接下来的章节中,我们将探讨Python数据科学的核心库以及如何在Anaconda环境下实践项目。

4. Python数据科学核心库介绍

在第四章中,我们将探索几个数据科学的核心库。Python的强大之处在于其丰富的库,它们为数据处理、科学计算、机器学习、数据可视化提供了丰富的支持。我们将重点关注NumPy和SciPy、Pandas以及Matplotlib和Seaborn。

4.1 NumPy和SciPy的使用

NumPy库是Python科学计算的基础包,它提供了高性能的多维数组对象和这些数组的操作工具。SciPy是基于NumPy构建的,它提供了许多用于科学和技术计算的高级操作。

4.1.1 数组操作和矩阵计算

NumPy核心数据结构是多维数组对象,通常称为ndarray,它在计算上非常高效。以下是一些基础操作的示例代码块:

在这段代码中,我们展示了如何创建不同维度的数组,并执行了点乘、加法和平方根计算。使用NumPy进行这些操作,比纯Python循环要快得多,因为NumPy内部实现了优化。

4.1.2 科学计算与数值分析

SciPy库在NumPy基础上提供了许多用于科学计算的额外功能。其内部集合了多个子模块,每个模块都提供了不同的功能。

- from scipy import linalg, optimize

- # 使用SciPy进行矩阵求逆

- A = np.array([[3, 2], [1, 0]])

- inv_A = linalg.inv(A)

- print("矩阵A的逆:\n", inv_A)

- # 使用SciPy寻找方程的根

- result = optimize.root(lambda x: x**2 - x - 1, [0, 1])

- print("方程x^2 - x - 1 = 0的根为:", result.x)

这段代码展示了SciPy的线性代数子模块linalg用于求矩阵的逆,以及优化子模块optimize用于解决方程。SciPy库使得数值分析变得简单方便。

4.2 Pandas的数据处理

Pandas是一个强大的数据分析和操作库,它提供了DataFrame和Series两种主要的数据结构。这些结构使得数据处理变得快速和直观。

4.2.1 数据清洗与预处理

Pandas为数据预处理提供了丰富的方法。接下来的代码展示了如何使用Pandas处理缺失值、数据合并和数据过滤。

通过这段代码,我们可以看到Pandas处理数据的灵活性和便利性。Pandas能够轻松处理大量数据,并为数据清洗提供了多种方法。

4.2.2 数据分析与操作

Pandas不仅限于数据预处理,它还提供了一系列工具,用于进行复杂的数据分析和操作。

- # 统计描述

- desc = df.describe()

- print("数据的描述性统计:\n", desc)

- # 分组聚合

- grouped = df.groupby('A').sum()

- print("根据A列分组求和后的结果:\n", grouped)

- # 时间序列分析

- df['Date'] = pd.date_range('20210101', periods=len(df))

- df.set_index('Date', inplace=True)

- df_resampled = df.resample('M').mean()

- print("按月重采样后的数据:\n", df_resampled)

在这段代码中,我们进行了描述性统计分析、分组聚合以及时间序列分析。这些操作是数据分析工作中常见的任务,Pandas库让这些操作变得高效和简便。

4.3 Matplotlib和Seaborn的可视化

数据可视化是数据科学的核心部分之一,Matplotlib和Seaborn是Python中两个最重要的可视化库。

4.3.1 数据可视化基础

Matplotlib是一个2D绘图库,用于创建高质量的图形。以下是使用Matplotlib绘制基础图形的示例:

这段代码演示了如何使用Matplotlib绘制基础的折线图和条形图。Matplotlib提供了广泛的接口,可以精细控制图形的各个方面。

4.3.2 高级绘图技巧和应用实例

Seaborn是基于Matplotlib的高级绘图库,提供了更高级的接口和更加吸引人的默认设置。接下来,我们使用Seaborn绘制热力图:

- import seaborn as sns

- # 创建一个用于绘图的数据集

- data = pd.DataFrame({

- 'X': [1, 2, 3, 4],

- 'Y': [4, 3, 2, 1],

- 'Z': [10, 20, 30, 40]

- })

- # 绘制热力图

- plt.figure(figsize=(8, 6))

- sns.heatmap(data.pivot("X", "Y", "Z"), annot=True, fmt="d", cmap="YlGnBu")

- plt.title('数据的热力图')

- plt.show()

这段代码使用了Seaborn的heatmap函数,创建了一个基于pivot表数据的热力图。Seaborn的高级功能极大地简化了复杂数据可视化的创建过程。

Seaborn还支持更为复杂和美观的绘图类型,如分布图、分类图、回归图等。这使得Seaborn成为数据科学可视化不可或缺的工具。

以上便是对Python数据科学核心库的介绍。接下来,我们将深入探讨如何在Anaconda环境下进行实际项目实践,并分享进阶技巧和最佳实践。

5. Anaconda环境下的项目实践

5.1 数据科学项目的开发流程

5.1.1 环境搭建与库依赖管理

在开始数据科学项目之前,搭建一个合适的工作环境是至关重要的。Anaconda 提供了一个便捷的方式,通过其环境管理工具来管理不同项目所需的依赖库版本。这对于避免版本冲突和重复安装同版本的库,都是一个极大的优化。

使用 conda 命令可以创建一个新的环境,这里我们以创建一个包含 scikit-learn 和 pandas 的数据科学环境为例:

- conda create -n my_project_env scikit-learn pandas

该命令将会创建一个新的环境,名为 my_project_env,并安装所需的数据科学库。接下来,我们需要激活这个环境:

- conda activate my_project_env

环境激活后,所有安装在此环境下的包都将被隔离,你可以在该环境下自由安装、更新和卸载包,而不会影响到其他环境或全局Python环境。

管理库依赖的另一种方式是使用 pip 工具直接在环境中安装包,或者是使用 requirements.txt 文件来跟踪和安装项目所需的所有依赖。例如,可以创建一个包含所有依赖的 requirements.txt 文件:

- scikit-learn==0.22.1

- pandas==1.0.3

- matplotlib==3.1.3

然后,可以使用以下命令在激活的环境中安装所有依赖:

- pip install -r requirements.txt

5.1.2 数据集的获取与处理

数据是数据科学项目的核心。获取数据后,通常需要进行一系列的数据清洗和预处理步骤,以便使用它进行进一步的分析或模型训练。Anaconda中的 pandas 库提供了丰富的数据处理功能,可以从不同的数据源读取数据,并进行处理。

以下是一个简单的示例,说明如何使用 pandas 来处理数据集:

处理完数据后,我们可以利用Anaconda的其他库(如NumPy、SciPy)来进行数值计算和统计分析,或者使用Matplotlib和Seaborn进行数据可视化。

5.2 实际案例分析

5.2.1 机器学习项目入门

机器学习项目通常包括数据探索、特征工程、模型选择、训练和评估几个主要阶段。以一个简单的分类问题为例,我们可以使用Anaconda环境中的 scikit-learn 库来进行机器学习实验。

首先,导入必要的库并加载数据集:

- from sklearn.datasets import load_iris

- from sklearn.model_selection import train_test_split

- from sklearn.preprocessing import StandardScaler

- from sklearn.svm import SVC

- from sklearn.metrics import classification_report

- # 加载iris数据集

- data = load_iris()

- X, y = data.data, data.target

接着,我们将数据集分为训练集和测试集:

- # 划分数据集

- X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

在训练模型之前,通常需要对数据进行标准化处理:

- # 标准化特征

- scaler = StandardScaler()

- X_train = scaler.fit_transform(X_train)

- X_test = scaler.transform(X_test)

然后,创建支持向量机(SVM)分类器,并进行训练:

- # 创建SVM分类器

- clf = SVC(kernel='linear')

- clf.fit(X_train, y_train)

训练完成后,我们对测试集数据进行预测,并评估模型性能:

- # 预测并输出性能报告

- y_pred = clf.predict(X_test)

- print(classification_report(y_test, y_pred))

以上代码展示了从数据加载到模型训练的完整流程。这只是机器学习项目入门的一个简单例子,实际项目中可能涉及更复杂的特征工程、模型调参以及交叉验证等步骤。

5.2.2 数据可视化项目实施

数据可视化是数据科学中不可或缺的一部分,它可以直观地展示数据分析结果,帮助我们更好地理解数据和解释模型结果。

假设我们有一个超市销售数据集,我们需要对商品销售额进行可视化,来分析不同时间段的销售趋势。以下是使用 matplotlib 库来生成销售趋势图的代码示例:

- import matplotlib.pyplot as plt

- # 假设我们有以下月销售额数据

- sales = [10000, 13000, 14000, 15000, 16000, 18000, 20000]

- months = ['Jan', 'Feb', 'Mar', 'Apr', 'May', 'Jun', 'Jul']

- # 创建条形图

- plt.bar(months, sales, color='skyblue')

- # 添加标题和标签

- plt.title('Monthly Sales')

- plt.xlabel('Month')

- plt.ylabel('Sales in USD')

- # 显示图表

- plt.show()

数据可视化并不仅限于简单的条形图或折线图。更高级的可视化技巧,如热力图、散点图矩阵和交互式可视化,可以帮助我们探索数据集的更深层次信息。

在Anaconda环境中,可以利用 Seaborn 库来创建更为复杂和美观的图表。例如,下面的代码展示了如何用 Seaborn 绘制一个点图矩阵来分析多个数值变量之间的关系:

- import seaborn as sns

- # 假设iris数据集中的特征数据

- iris = sns.load_dataset('iris')

- # 创建点图矩阵

- sns.pairplot(iris, hue='species')

- plt.show()

通过数据可视化,我们不仅能够更容易地发现数据中的模式,还能够以直观的形式向他人展示分析结果。这在数据科学项目中是一个非常重要的沟通工具。

6. Anaconda进阶技巧与最佳实践

6.1 多环境管理技巧

6.1.1 高级环境隔离技术

在进行复杂的数据科学项目或机器学习实验时,可能需要同时使用多个不同版本的库,这时就需要利用Anaconda的高级环境隔离技术来避免版本冲突。Anaconda允许用户创建多个环境,并在每个环境中安装不同版本的包。

具体操作如下:

-

创建新环境:

- conda create --name myenv python=3.8

这条命令会创建一个名为

myenv的新环境,并在其中安装Python 3.8版本。 -

激活环境:

- conda activate myenv

激活后,你的命令行提示符会显示当前激活的环境名称,此时在此环境中安装的任何包都不会影响其他环境。

-

环境间切换:

- conda activate anotherenv

可以通过

conda activate命令快速切换到其他环境。 -

环境的复制:

- conda create --name newenv --clone myenv

这条命令将

myenv环境中的所有包和配置复制到一个新的名为newenv的环境中。

6.1.2 环境复用与版本控制

在多项目管理时,环境复用可以节省硬盘空间并减少重复配置环境的时间。Anaconda提供了多种方法来复用环境:

-

导出环境到文件:

- conda env export > environment.yml

这会将当前环境的状态导出到一个

environment.yml文件中,包括所有包和版本信息。 -

使用YAML文件创建环境:

- conda env create -f environment.yml

在新系统或新项目中,可以使用这个

environment.yml文件快速重建相同的环境。 -

环境版本控制:

- 通过版本号精确控制库版本。

- 使用Git对

environment.yml文件进行版本控制,确保每次更改都可追踪。

6.2 性能优化与故障排查

6.2.1 性能监控工具的应用

对于数据科学工作来说,性能至关重要。Anaconda提供了性能监控工具conda-pack和conda-profiler来帮助用户诊断环境性能瓶颈。

-

使用

conda-pack打包环境:- conda install conda-pack

- conda-pack -n myenv -o myenv.tar.gz

这会将

myenv环境打包成压缩文件,以供其他没有网络访问的环境复用。 -

使用

conda-profiler监控性能:- conda install conda-profiler

- conda profile start

运行你的应用程序,然后使用

conda profile stop停止监控。最后,使用conda profile report生成性能报告。

6.2.2 常见问题的诊断与解决

面对常见问题时,Anaconda社区提供了一系列诊断与解决指南:

-

检查是否有依赖冲突:

- conda list --revisions

查看环境更改历史,查找可能的冲突。

-

更新conda和包:

- conda update conda

- conda update --all

确保所有包和conda本身都是最新版本,这可以解决很多兼容性问题。

-

恢复到前一个状态:

- conda install --revision=2

如果升级后出现错误,使用

--revision选项恢复到之前的状态。

6.3 社区资源与学习路径

6.3.1 探索Anaconda社区资源

Anaconda社区是庞大的资源宝库,包含各种资源和帮助文档:

-

Anaconda官方文档:

- Anaconda Documentation

- 包含安装、使用、故障排除等详细指南。

-

社区论坛:

- Anaconda Discussion

- 分享经验、提问和获取帮助的好地方。

-

教程与案例:

- Anaconda Examples

- 提供了丰富的教程和案例代码,适合实践学习。

6.3.2 规划Python学习路线图

对于希望深入Python和数据科学领域的学习者,以下是一个基础到进阶的学习路线图:

-

Python基础:

- 学习Python基础语法和编程概念。

- 推荐资源:Python官方文档。

-

数据科学核心库:

- 学习NumPy、Pandas、Matplotlib等库。

- 实践数据清洗、分析、可视化的项目。

-

机器学习与深度学习:

- 学习Scikit-learn、TensorFlow、PyTorch等框架。

- 完成一些小的机器学习和深度学习项目。

-

项目实战:

- 利用所学知识完成数据科学或机器学习项目。

- 参加在线Kaggle竞赛或开源项目贡献。

通过这个路线图,可以系统性地逐步提升Python编程及数据科学的实战能力。