Python数据质量控制:确保数据准确性的专业技巧

发布时间: 2024-12-06 19:51:51 阅读量: 26 订阅数: 12

如何确保数据集的质量和准确性:策略、工具与Python代码实践

# 1. Python数据质量控制基础

数据质量控制是数据分析和处理中不可或缺的一环,而Python作为一门强大的编程语言,在数据质量控制领域有着广泛的应用。本章我们将从基础出发,探讨数据质量控制的基本概念和重要性,为后续章节中深入探讨数据清洗技术和高级应用打下基础。

## 1.1 数据质量的重要性

数据质量直接影响数据的有效性和可靠性,是数据分析结果准确性的前提。高质量数据能够减少错误、提高处理效率,并且在商业决策、科学研究等领域发挥关键作用。掌握数据质量控制的方法和技巧,有助于我们更好地理解数据,进而做出更明智的决策。

## 1.2 数据质量控制的定义

数据质量控制是一个系统的过程,旨在确保数据在采集、存储、处理和分析的各个环节都保持准确无误。通过一系列的技术手段和管理措施,从源头上预防和纠正数据错误,保证数据的质量。

## 1.3 数据质量控制与Python

Python由于其简洁的语法和强大的数据处理库(如pandas、NumPy等),在数据质量控制领域获得了广泛应用。它不仅提高了数据处理的效率,还降低了实现复杂数据清洗策略的难度。通过Python,我们能够自动化地执行数据清洗、校验和监控任务,有效地提升数据质量。

以上内容从数据质量控制的基础概念出发,介绍了其在数据分析中的重要性,并简要阐述了Python在该领域的作用。随着学习的深入,我们将一步步探索如何利用Python来提升数据质量。

# 2. 数据清洗技术

## 2.1 数据预处理和清洗概述

### 2.1.1 数据预处理的重要性

数据预处理是数据质量控制中不可或缺的一环。在数据科学领域,原始数据往往包含大量噪声、不一致性、错误和冗余。未经处理的数据可能导致分析和建模过程中的偏差,从而影响决策质量。数据预处理主要包含数据清洗、数据集成、数据变换和数据归约等步骤。

数据清洗是整个数据预处理过程中最为核心的一环,它旨在消除或减少数据中的噪声和不一致性。数据预处理的重要性可以通过以下几个方面体现:

- **准确性**:通过数据清洗提高数据准确性,确保分析结果的可靠性。

- **完整性**:数据清洗有助于提高数据的完整性,减少数据缺失对分析结果的影响。

- **一致性**:确保数据在各个系统和平台中保持一致,便于数据的使用和交换。

- **有效性**:数据清洗可以增强数据的可用性,确保数据能够满足特定的业务规则和需求。

### 2.1.2 数据清洗的常见方法

数据清洗涉及多种技术,包括但不限于:

- **缺失值处理**:通过填充、删除或估算方法处理数据中的空值。

- **异常值检测**:识别数据中的异常值,并决定是否保留或替换这些值。

- **数据格式化**:对数据进行标准化,使其符合特定格式要求,如日期和时间格式。

- **数据标准化和规范化**:将数据统一到相同的尺度或范围内,便于比较和分析。

- **重复数据处理**:识别并合并重复记录,保证数据的唯一性。

这些方法通常会结合使用,以实现最佳的清洗效果。

## 2.2 缺失值处理策略

### 2.2.1 识别和处理缺失值

识别缺失值是数据清洗的首要步骤。Python中pandas库提供了多种方法来识别和处理缺失值。常用的函数包括`isnull()`和`notnull()`,可以分别用来检测数据中的缺失值和非缺失值。

处理缺失值的方法多样,常见的包括:

- **删除**:如果数据集足够大,并且缺失值分布不均,可删除包含缺失值的行或列。

- **填充**:用合理的值替换缺失值。这些值可以是全局常数、中位数、众数或基于其他变量计算得出的值。

### 2.2.2 缺失值插补技术

缺失值的插补技术可以进一步细分为简单插补和高级插补。简单插补方法包括使用均值、中位数或众数。而高级插补方法则包括基于模型的插补技术,例如使用线性回归、K-最近邻(KNN)或随机森林等算法预测缺失值。

```python

import pandas as pd

from sklearn.impute import SimpleImputer

# 创建一个含有缺失值的DataFrame

data = pd.DataFrame({

'A': [1, 2, None, 4],

'B': [5, None, None, 8]

})

# 初始化插补器,使用均值进行插补

imputer = SimpleImputer(missing_values=np.nan, strategy='mean')

# 对数据进行插补

data_imputed = imputer.fit_transform(data)

print(data_imputed)

```

在上述代码中,`SimpleImputer` 是一个简单的插补器,使用数据列的均值来填充缺失值。参数 `missing_values=np.nan` 指定了需要被插补的是NaN值,`strategy='mean'` 指定了使用均值作为填充值。执行这段代码后,将输出一个插补后的数据集,其中缺失值已被相应列的均值所替换。

## 2.3 异常值检测与处理

### 2.3.1 异常值的识别方法

异常值是指那些与数据集中的其他数据显著不同的值。识别异常值通常基于统计方法,例如:

- **标准差法**:基于数据的均值和标准差,识别超出一定范围的值。

- **箱型图法**:使用箱型图分析异常值,该方法会根据四分位数定义异常值的范围。

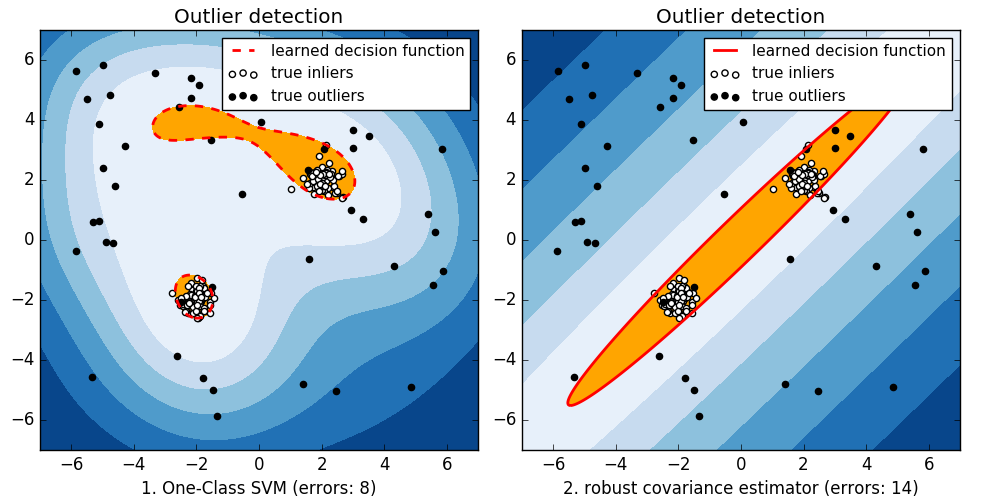

- **基于模型的方法**:构建模型识别数据中与模型预测偏差较大的值。

### 2.3.2 异常值的处理策略

处理异常值的方法包括:

- **删除**:如果确定某些值是由于测量错误或异常事件产生的,可以考虑直接删除这些值。

- **修改**:可以手动或使用统计方法将异常值替换为更合理的值。

- **保留**:如果异常值是由特殊事件导致,并且对分析目标有意义,则应予以保留。

## 2.4 数据格式化和标准化

### 2.4.1 数据格式化技巧

数据格式化是指将数据转换为更合适的数据类型和格式,以便于后续处理。例如,日期和时间数据往往需要转换为标准格式,以利于分析和比较。

```python

import pandas as pd

# 假设有一个日期时间列

data = pd.DataFrame({

'date_time': ['2023-01-01 12:00', '2023-01-02 13:15', '2023-01-03 14:30']

})

# 转换日期时间格式

data['date_time'] = pd.to_datetime(data['date_time'])

print(data)

```

上述代码中,`to_datetime` 函数用于将字符串转换为pandas的日期时间类型,从而便于后续的时间序列分析。

### 2.4.2 数据标准化的应用

数据标准化是为了消除不同量纲带来的影响,使数据能够在一个统一的尺度下比较。常见的数据标准化方法有:

- **最小-最大标准化**:将数据按比例缩放至特定范围(通常是0到1)。

- **Z-score标准化**:将数据标准化为具有0均值和标准差为1的分布。

```python

from sklearn.preprocessing import MinMaxScaler

# 假设有一个数值列

data = pd.DataFrame({

'numeric': [10, 20, 30, 40, 50]

})

# 初始化标准化器

scaler = MinMaxScaler()

# 执行标准化操作

data_scaled = scaler.fit_transform(data[['numeric']])

print(data_scaled)

```

在上述代码中,`MinMaxScaler` 是用于最小-最大标准化的工具。`fit_transform` 方法对数据进行标准化处理,输出的数据将缩放到0和1之间。

通过以上章节,我们已经了解了数据清洗技术的基本概念和常用方法。在后续的章节中,将深入探讨异常值处理、数据格式化和标准化的具体实现,以及如何通过Python来执行这些操作。这将为数据质量控制奠定坚实的基础。

# 3. 数据一致性与完整性

在现代数据处理中,数据的一致性和完整性是确保数据准确性和可靠性的重要因素。一致性通常涉及数据是否符合预定义的业务规则或标准,而完整性则关系到数据的完整性和准确性,以确保在数据集中没有遗漏重要的信息。本章节将深入探讨数据一致性校验、数据完整性约束以及数据校验工具和应用的各个方面。

## 3.1 数据一致性校验

### 3.1.1 数据类型一致性校验

数据类型一致性是

0

0