Python数据清洗实战:合并、重塑数据集的终极技巧

发布时间: 2024-12-07 05:39:37 阅读量: 32 订阅数: 16

掌握Python数据可视化:技巧、工具与实战

# 1. 数据清洗与预处理的重要性

在当今大数据时代,数据无处不在。然而,原始数据往往包含许多不规则、不一致或不完整的问题,这些问题如果不处理,可能会导致分析结果出现偏差,甚至产生误导性的结论。数据清洗与预处理是数据分析和机器学习工作中不可或缺的环节,其重要性体现在以下几个方面:

## 数据质量对分析结果的影响

高质量的数据是得出准确分析结果的前提。数据清洗能够确保数据的质量,包括处理重复记录、纠正错误、填补缺失值等,从而提高数据的准确性和可信度。

## 预处理数据为分析做准备

预处理涉及将数据转换为适合分析的形式,比如将分类数据转换为数值形式、标准化或归一化数据、以及处理文本数据。这些预处理步骤为后续的统计分析和模型训练打下了坚实的基础。

## 提高模型性能和准确性

数据预处理还能显著提升机器学习模型的性能。通过合适的预处理,可以减少模型训练过程中的噪声,提高模型的泛化能力,进而增强模型的准确性和稳定性。

在后续章节中,我们将深入探讨如何高效地进行数据清洗与预处理,使用Pandas、SQL等工具和方法优化数据的质量,为数据分析和机器学习的深入应用提供坚实的数据基础。

# 2. 数据合并的艺术

在数据分析和处理中,数据合并是构建复杂数据模型的关键步骤之一。数据集的合并能够将来自不同来源的信息汇总到一起,为后续的数据分析提供更全面的视角。本章将深入探讨数据合并的概念、技巧和高级实践,以及如何利用Python中的Pandas库高效地执行合并操作。

## 2.1 数据集合并的基本理论

数据集合并是将两个或多个数据集基于一定的键值关联起来,生成一个新的数据集。其主要目的是为了整合数据,增加分析的维度或深度。

### 2.1.1 合并数据集的概念和目的

合并数据集的概念可以追溯到数据库领域中的JOIN操作,而在Pandas中这一操作被广泛应用于数据分析。合并数据集的目的通常包括:

- **整合信息**:通过合并,可以将不同数据源中的相关数据整合到一起,方便进行综合分析。

- **增加维度**:当需要分析的数据点跨越多个数据集时,合并能够增加分析的维度。

- **准备数据**:在进行机器学习等复杂分析之前,常常需要将数据从不同的表格和数据集整合到一个单一的、结构化的数据集中。

### 2.1.2 内连接、外连接和交叉连接的区别

在进行数据集合并时,我们经常面临三种基本的连接类型:内连接(INNER JOIN)、外连接(OUTER JOIN)和交叉连接(CROSS JOIN)。这些连接类型的选择会直接影响合并后的数据集内容和结构:

- **内连接**:只返回两个数据集中都存在的键值对应的行。这种连接方式适用于只对匹配的数据感兴趣的情况。

- **外连接**:返回至少在一个数据集中匹配的键值的行。外连接分为左外连接(LEFT OUTER JOIN)、右外连接(RIGHT OUTER JOIN)和全外连接(FULL OUTER JOIN),它们分别保证左侧数据集、右侧数据集或两者的所有数据都被包含。

- **交叉连接**:返回两个数据集中所有可能的行组合。这种连接方式适用于需要生成所有可能组合的场景。

## 2.2 Pandas中的数据合并技术

Pandas库提供了强大的数据合并功能,支持多种不同的合并方式,并允许用户指定合并的键值,以及合并的逻辑。

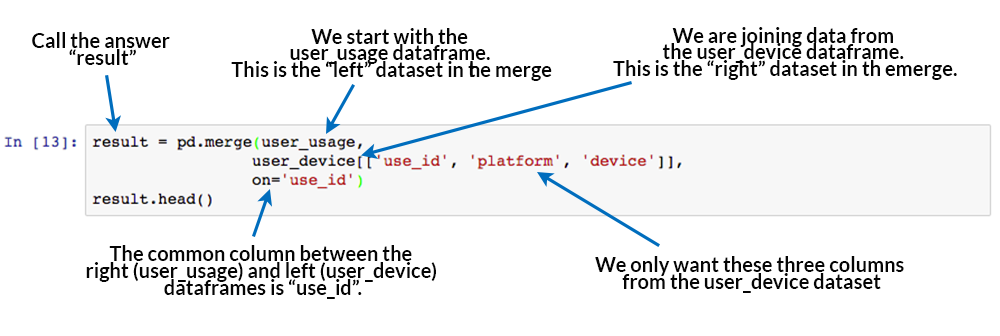

### 2.2.1 使用merge函数进行数据合并

Pandas中的`merge`函数是执行数据合并操作的主要工具。它可以执行上述提到的内连接、外连接和交叉连接。下面是一个基本的`merge`函数用法示例:

```python

import pandas as pd

# 创建两个简单的数据集作为示例

data1 = pd.DataFrame({'key': ['K0', 'K1', 'K2', 'K3'],

'A': ['A0', 'A1', 'A2', 'A3'],

'B': ['B0', 'B1', 'B2', 'B3']})

data2 = pd.DataFrame({'key': ['K0', 'K1', 'K2', 'K3'],

'C': ['C0', 'C1', 'C2', 'C3'],

'D': ['D0', 'D1', 'D2', 'D3']})

# 使用内连接合并两个数据集

merged_inner = pd.merge(data1, data2, on='key', how='inner')

print(merged_inner)

```

### 2.2.2 使用concat函数进行数据拼接

除了`merge`函数外,Pandas的`concat`函数也可以用于数据合并,特别是当数据集具有相同的列时,`concat`可以沿指定轴将数据集进行垂直或水平拼接。

```python

# 使用concat函数将数据集垂直拼接

concatened_vertical = pd.concat([data1, data2], axis=0)

print(concatened_vertical)

```

`concat`函数通过`axis`参数控制拼接的方向,当`axis=0`时为垂直拼接,而`axis=1`时为水平拼接。

### 2.2.3 合并大型数据集的性能考量

当处理大型数据集时,数据合并操作可能变得耗时且资源密集。为了提高性能,可以通过减少合并前数据集的大小、选择合适的索引和优化合并操作来解决。

#### 减少数据集大小

在合并操作之前,尽可能删除不需要的列和行,从而降低数据集的内存占用。

#### 选择合适的索引

确保合并键值在每个数据集中都是索引或者有合适的索引,这样可以显著加快合并速度。

#### 优化合并操作

使用`merge`函数时,可以利用`indicator=True`参数跟踪每行数据的来源,这样在进行后续的数据清洗和处理时更加高效。

```python

merged_with_indicator = pd.merge(data1, data2, on='key', how='outer', indicator=True)

print(merged_with_indicator)

```

## 2.3 合并数据的高级技巧与实践

在实际操作中,数据合并往往伴随着复杂的场景和高级技巧的应用。本小节将探讨多表合并和处理合并后数据的去重和验证。

### 2.3.1 多表合并和复杂场景处理

在实际数据处理过程中,我们经常需要合并多个数据集。在多个数据集合并的情况下,合理的合并顺序和合并逻辑显得至关重要。

#### 合并顺序

通常根据数据集间的关系和合并的目的来确定合并顺序。可以先进行内连接以缩小数据规模,再进行外连接以确保包含所有数据。

#### 合并逻辑

合并逻辑通常涉及多个键值的匹配,这时需要考虑多个键值共同构成的唯一标识,或者是构建分层合并的逻辑。

### 2.3.2 合并后数据去重和验证

合并后的数据集可能会包含重复的行,这时需要进行去重操作。同时,对合并的数据集进行验证,确保数据的准确性和完整性,是数据分析前的重要步骤。

#### 数据去重

可以使用Pandas的`drop_duplicates`函数来去除重复的数据行。

```python

# 去除合并后数据集中的重复行

merged_unique = merged_with_indicator.drop_duplicates()

print(merged_unique)

```

#### 数据验证

验证合并后的数据集是否正确,可以通过检查行数、列名和数据类型等基本属性来进行。同时,也可以进行一致性检查,比如确保相同键值的行在各数据集中是一致的。

```python

# 检查合并后的数据集的行数是否正确

assert merged_unique.shape[0] == len(data1) + len(data2)

```

通过上述的讲解,我们对数据合并有了一个全面的了解。从基础理论到实际操作,再到高级技巧,Pandas提供了一整套工具来支持数据合并的各种需求。在接下来的章节中,我们将进一步探索数据重塑的高效方法,进一步提升数据处理的技能。

# 3. 数据重塑的高效方法

## 3.1 数据重塑的理论基础

### 3.1.1 从宽格式到长格式的转换

数据重塑是数据科学中的一个常见任务,它涉及将数据从一种格式转换为另一种格式以满足特定的分析需求。宽格式与长格式是两种常见的数据表示方式。宽格式数据中,每个观测值或实体通常占据一行,而每个特征或变量则分布在多个列中。相反,长格式数据将每个观测值分散到多行,但通常每个行只包含单一时间点或条件的记录。

例如,考虑一个销售数据集,宽格式可能包含一列标识每个地区,然后是该地区每个季度的销售额。而长格式则可能将地区、季度和销售额分别放置在三列中。

从宽格式到长格式的转换在很多分析中是必须的,特别是在准备数据以进行时间序列分析或堆叠数据以用于绘图时。Pandas 库提供了非常实用的函数 `melt`,可以方便地完成这一转换。

### 3.1.2 长格式数据的优势与应用场景

长格式数据的优点包括:

- **易于分析**:对于使用像R和Python这样的语言进行分析,长格式数据通常更容易操作和分析。

- **灵活性高**:在长格式数据中,记录通常是独立的,这使得处理重复的测量或事件变得简单。

- **符合数据分析最佳实践**:在数据科学中,长格式数据更接近所谓的“整洁数据”概念,它是一种更加标准和通用的数据表示方式。

长格式数据特别适用于时间序列分析、动态绘图和多变量分析

0

0