Python数据清洗与分析:从清洗到洞察的高效工作流

发布时间: 2024-12-07 05:58:10 阅读量: 9 订阅数: 11

Python 数据分析与可视化实用指南"

# 1. Python数据清洗与分析概述

在这个信息爆炸的时代,数据已成为现代企业的核心资产之一。企业通过对数据的清洗与分析,能够洞察市场动向、优化产品设计,甚至预测未来趋势。Python作为一种功能强大的编程语言,在数据清洗与分析领域中扮演了关键角色。它的简洁语法和丰富的数据处理库,如Pandas、NumPy、Matplotlib等,使得从数据获取到处理再到分析的过程变得更加高效和直观。掌握Python数据清洗与分析的技巧,不仅能提高工作效率,更能为决策提供数据支持。接下来,我们将深入了解数据清洗的重要性,数据预处理的理论基础,以及如何应用Python进行数据清洗与分析的实践。

# 2. 数据预处理理论基础

数据预处理是数据分析的重要步骤,涉及对原始数据进行清洗、转换、整合和规约,以达到适合分析的状态。此过程确保分析结果的准确性和可靠性,是数据科学实践中不可或缺的环节。

### 2.1 数据清洗的重要性

数据清洗是数据预处理的核心任务之一,其目的是确保数据的质量,使得分析能够基于正确的数据进行,从而提供可信的洞察和决策支持。

#### 2.1.1 数据质量问题的来源

数据质量问题可能来源于多个方面,包括但不限于数据收集过程中的错误、数据存储中的损坏、数据录入时的人为失误以及数据集成时的不一致性等。了解这些问题的根源,有助于采取针对性的清洗措施。

```python

# 示例代码:检测数据集中的重复行,重复行是数据质量问题的常见来源

import pandas as pd

# 加载数据集

data = pd.read_csv('data.csv')

# 检查重复行

duplicates = data.duplicated()

print(duplicates.sum()) # 输出重复行的数量

```

在上述代码中,我们使用了Pandas库中的 `duplicated()` 方法来识别并计数数据集中的重复行。这些重复行若不进行清洗,可能会对分析结果造成偏误。

#### 2.1.2 清洗数据的业务价值

通过有效的数据清洗,可以显著提高分析的准确性和结果的可靠性。高质量的数据使得模型训练更加精准,有助于预测和分类任务的执行。同时,清洗后的数据能够减少复杂性和提高分析效率。

### 2.2 数据预处理的常用方法

在数据预处理中,有几种常用的方法可以用来确保数据的质量和一致性。

#### 2.2.1 缺失值处理

缺失值是数据集中常见的问题,通常有多种策略来处理,包括删除、填充或预测缺失值。

```python

# 示例代码:用均值填充缺失值

# 假设'mean_value'是我们已经计算好的列均值

data['column_to_fill'] = data['column_to_fill'].fillna(mean_value)

```

在处理缺失值时,选择哪种策略依赖于数据本身的特性和分析需求。填充缺失值时可能需要考虑数据的分布特性,以避免引入偏差。

#### 2.2.2 异常值检测与处理

异常值可能会扭曲数据分析的结果,需要被适当识别和处理。常用的检测方法包括Z-Score、IQR(四分位数范围)等。

```python

# 示例代码:使用IQR方法识别和处理异常值

Q1 = data['column'].quantile(0.25)

Q3 = data['column'].quantile(0.75)

IQR = Q3 - Q1

# 计算上下界

lower_bound = Q1 - 1.5 * IQR

upper_bound = Q3 + 1.5 * IQR

# 筛选异常值

outliers = data[(data['column'] < lower_bound) | (data['column'] > upper_bound)]

filtered_data = data[~data['column'].isin(outliers)]

```

异常值处理需要特别小心,因为有些异常值可能是真正的“金子”,代表了重要的洞察和机会。在删除之前,必须经过仔细的分析和理解。

#### 2.2.3 数据标准化与归一化

数据标准化和归一化是将数据的尺度调整到统一的范围内,这有助于消除不同特征量纲的影响,使分析结果更加可靠。

```python

from sklearn.preprocessing import StandardScaler

# 标准化数据

scaler = StandardScaler()

data_scaled = scaler.fit_transform(data[['column1', 'column2']])

```

通过上述方法,数据特征的尺度被标准化,有助于后续的分析工作,比如机器学习模型的训练。

### 2.3 数据预处理的策略选择

正确选择预处理策略对于保证数据质量至关重要,应根据不同的数据类型和业务需求来制定。

#### 2.3.1 针对不同数据类型的处理策略

数据类型可以大致分为数值型、分类型和时间序列型。不同数据类型应采用不同的预处理方法。例如,数值型数据可能需要标准化处理,而分类型数据可能需要进行编码转换。

#### 2.3.2 处理数据集中的重复信息

重复信息可能导致分析的偏差,需要通过适当的去重操作来处理。有时候重复信息反映了数据收集的重复性,需要根据上下文来决定是否保留。

#### 2.3.3 数据维度的简化与特征提取

数据维度的简化和特征提取是预处理的关键步骤。通过主成分分析(PCA)等方法可以降低数据的维度,从而减少计算复杂度并提高分析效率。

```python

from sklearn.decomposition import PCA

# 创建PCA对象

pca = PCA(n_components=2) # 降维到2个主成分

# 对数据进行PCA转换

transformed_data = pca.fit_transform(data)

```

在上面的代码示例中,我们将数据集降维到2个主成分,这有助于去除噪声和冗余特征,提取最具代表性的信息。

通过本章节的介绍,我们了解了数据预处理的重要性、常用方法以及策略选择。下一章将深入Python实践操作,展示如何运用这些理论知识来清洗和分析真实的数据集。

# 3. Python数据清洗实践操作

## 3.1 Python数据结构与数据清洗工具介绍

### 3.1.1 Python基础数据结构

Python提供了几种基础数据结构,包括列表、元组、字典和集合,这些结构为数据清洗提供了丰富的功能和灵活性。

- **列表(List)**:一种有序的集合,可以随时添加和删除其中的元素。

- **元组(Tuple)**:与列表类似,但元组一旦创建就不能修改(即它是不可变的),常用于保护数据集。

- **字典(Dictionary)**:一种通过键来存储值的映射类型数据结构,适合处理键值对数据,如JSON格式。

- **集合(Set)**:一个无序的不重复元素集,可以用来进行成员关系测试和消除重复元素。

在数据清洗中,我们主要使用列表和字典。列表可以方便地存储数据序列,字典则适合于键值对的数据存储,比如日期和数值的映射关系。

```python

# 列表示例

fruits = ['apple', 'banana', 'cherry']

fruits.append('orange') # 添加元素

print(fruits[0]) # 输出: apple

fruits.remove('banana') # 删除元素

# 字典示例

person = {'name': 'John', 'age': 25, 'city': 'New York'}

print(person['name']) # 输出: John

person['age'] = 26 # 更新值

```

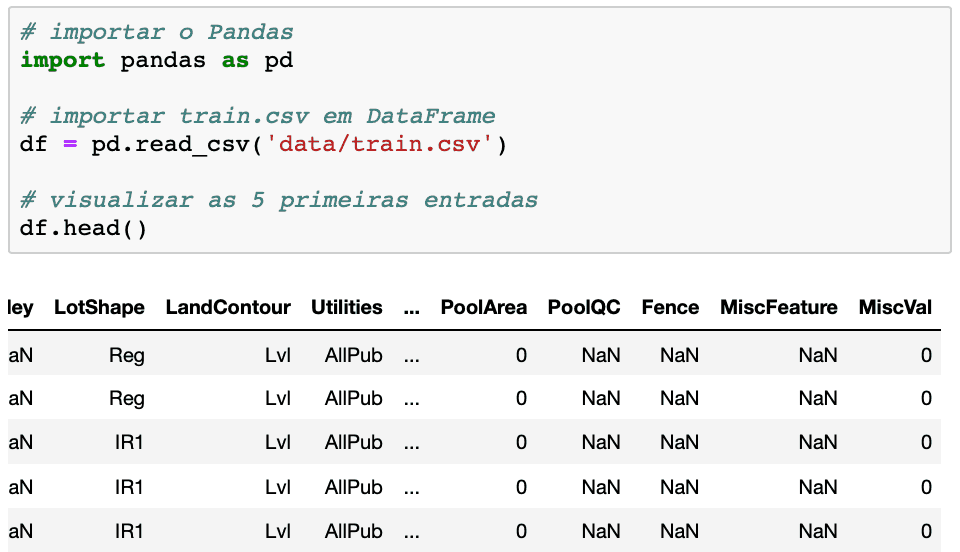

### 3.1.2 Pandas库简介与优势

Pandas是一个强大的Python数据分析库,它提供了快速、灵活和表达式丰富的数据结构,旨在使“关系”或“标签”数据的处理变得简单。Pandas在数据清洗中的优势包括:

- **数据结构**:Pandas中的`DataFrame`是一个二维的标签化数据结构,非常适合处理表格数据。

- **数据操作**:Pandas提供了大量便捷的数据操作函数,如筛选、排序、聚合等。

- **数据合并**:Pandas支持多种方式合并数据集,包括连接(join)、合并(merge)和连接(concat)。

- **时间序列**:Pandas是处理时间序列数据的利器,支持日期范围生成、频率转换、移动窗口统计等功能。

```python

import pandas as pd

# 创建DataFrame

data = {'A': [1, 2, 3], 'B': [4, 5, 6]}

df = pd.DataF

```

0

0