Python数据清洗与分析:打造数据管道的高效策略

发布时间: 2024-12-07 05:51:00 阅读量: 17 订阅数: 16

S变换+Sockwell R G , Mansinha L , Lowe R P . Localization of the complex spectrum: the S transformJ

# 1. 数据清洗与分析概述

## 1.1 数据清洗与分析的重要性

在当今信息爆炸的时代,数据已成为企业决策的重要基石。然而,数据在收集和存储的过程中,往往伴随着噪声、错误和不一致性,这严重影响了数据的可用性和分析结果的准确性。因此,数据清洗与分析成为数据科学和数据分析领域不可忽视的前置步骤,其核心目的是提升数据质量,为后续的数据挖掘、机器学习和商业智能提供高质量的输入数据。

## 1.2 数据清洗与分析的目标

数据清洗的目标是发现并修复数据集中的错误,从而提高数据的准确性、完整性和一致性。而数据分析则是通过探索性方法和统计技术,从数据中提取有用的信息和见解,用以支持决策制定。有效的数据清洗与分析能够为业务增长提供数据支持,发现隐藏的模式和趋势,以及提供洞察力,助力企业在竞争中获得优势。

## 1.3 数据清洗与分析的应用范围

数据清洗与分析的应用范围十分广泛,包括但不限于金融分析、市场营销、医疗健康、零售电商和公共管理等各个领域。无论是在提高运营效率、优化市场策略、制定医疗政策还是提升用户体验方面,数据清洗与分析都起着至关重要的作用。掌握这些技能,对于IT和相关行业的专业人士来说,不仅是技术能力的提升,更是职业发展和行业竞争力的增强。

在这一章节中,我们对数据清洗与分析的概念、重要性和应用范围进行了概述,为读者接下来深入了解和学习数据清洗的理论基础和实践技术奠定了基础。随着数据分析技术的日益成熟和应用范围的不断拓展,掌握数据清洗与分析的能力对于现代数据专业人员来说至关重要。

# 2. 数据清洗的理论基础

## 2.1 数据质量问题与清洗的必要性

数据清洗是数据预处理过程中不可或缺的一环。在当今的大数据时代,数据质量直接关系到分析结果的准确性和可靠性。因此,理解数据质量问题及其清洗的必要性,对于从事数据分析和数据科学相关工作的专业人士来说至关重要。

### 2.1.1 数据质量问题分析

数据质量问题通常源自数据收集、存储、传输和处理的各个环节。这些质量问题包括但不限于缺失值、异常值、重复记录以及不一致的数据。例如,在使用网络爬虫抓取数据时,网络连接不稳定可能会导致数据抓取不完整,产生缺失值;而在数据录入过程中,由于人为疏忽或错误,也常会出现数据格式不统一、数据类型错误等问题。这些问题如果不及时处理,不仅影响数据分析的准确性,甚至可能导致错误的结论。

### 2.1.2 数据清洗的目的和意义

数据清洗的目标是识别并纠正或删除数据集中的不准确、不完整或不一致的部分,以提高数据的质量。一个高质量的数据集应当满足以下条件:

- **准确性**:数据反映了真实情况,无明显误差。

- **完整性**:数据集中没有缺失值,每个观测值都是完整的。

- **一致性**:数据在不同的数据集或不同的时间点保持一致。

- **有效性**:数据符合业务规则和约束。

进行数据清洗对于确保数据质量,进而对决策支持系统提供可靠数据,具有极其重要的意义。清洗后的数据可以提高数据分析的准确度和效率,降低运营风险,并为数据驱动的决策提供有力支撑。

## 2.2 数据清洗的基本步骤与方法

数据清洗流程通常包含几个基本步骤,而每一步都有其相对应的方法来处理数据质量问题。

### 2.2.1 缺失值处理

缺失值是数据集中最常见的问题之一。处理缺失值的方法有很多,包括:

- **删除含有缺失值的记录**:简单粗暴,但可能会导致数据丢失过多。

- **填充缺失值**:使用均值、中位数、众数或者基于模型的预测值填充。

- **插值法**:针对时间序列数据,使用前后数据进行插值。

- **使用算法保留信息**:例如使用随机森林或K近邻算法预测缺失值。

### 2.2.2 异常值检测与处理

异常值指的是那些与数据集中的其他值明显不同的数据点,它们可能是数据错误,也可能是真实反映现实情况的特殊值。

- **统计方法**:如箱线图、Z-score和IQR(四分位距)等。

- **图形化方法**:绘制箱线图、散点图等可以帮助直观识别异常值。

- **基于模型的方法**:如孤立森林、DBSCAN等聚类算法,可以识别出数据中的异常点。

处理异常值的方法有:

- **删除**:如果确定是噪声,则可以删除这些数据点。

- **修正**:将异常值替换为更合理的值,例如使用中位数或均值。

- **保留**:如果异常值表示真实信息,则应保留。

### 2.2.3 数据一致性与重复数据处理

数据集中的重复记录会导致分析结果的偏差。

- **识别重复**:通过比较记录的唯一标识符,或者计算特征值的相似度。

- **删除重复记录**:一旦识别出重复数据,应当将其删除。

处理数据一致性的问题,可以使用如下方法:

- **数据标准化**:将数据转换为统一的格式或单位。

- **数据映射**:为不同来源的相同概念的数据创建一个映射表。

- **合并规则**:设定优先级,合并数据源中的冲突数据。

## 2.3 数据清洗工具和技术

数据清洗的过程可以通过多种工具和技术来实现。下面我们将介绍几种常用的数据清洗工具和它们的应用实践。

### 2.3.1 常用的数据清洗工具介绍

目前市场上有许多数据清洗工具,它们各有特点,适用于不同的场景和需求。

- **Excel**:对于小型数据集,使用Excel内置的数据处理功能可以快速清洗数据。

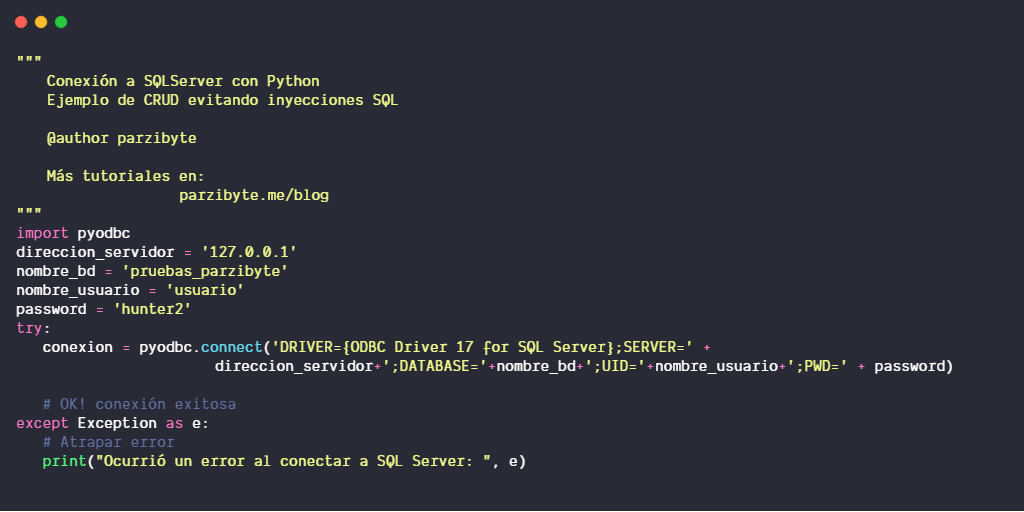

- **SQL**:对于存储在数据库中的数据,使用SQL查询语言可以方便地进行清洗和转换。

- **Python**:使用Pandas、NumPy等库进行复杂的数据清洗和预处理。

### 2.3.2 数据清洗技术的实践应用

在实际工作中,数据清洗技术的应用是多样化的。以Python为例,可以展示如何使用Pandas库进行数据清洗。

```python

import pandas as pd

# 加载数据集

data = pd.read_csv('data.csv')

# 缺失值处理

data.fillna(data.mean(), inplace=True)

# 异常值检测与处理

data = data[(data['feature'] > data['feature'].quantile(0.01)) & (data['feature'] < data['feature'].quantile(0.99))]

# 删除重复记录

data.drop_duplicates(inplace=True)

# 数据标准化

data['normalized_data'] = (data['feature'] - data['feature'].mean()) / data['feature'].std()

# 保存清洗后的数据

data.to_csv('cleaned_data.csv', index=False)

```

以上代码块展示了如何加载数据,处理缺失值,检测并删除异常值,删除重复记录以及进行数据标准化的基本操作。每一行代码后面都有注释,解释了执行的逻辑和参数的意义,帮助读者更好地理解代码的功能。数据清洗是一个迭代的过程,可能需要根据数据的特点多次调整清洗策略。

通过这个例子,我们可以看到数据清洗工具和技术在实践中的应用,以及如何根据具体问题选择合适的数据清洗方法。通过精心设计的数据清洗流程,可以显著提升数据的质量,为后续的数据分析和决策支持打下坚实的基础。

# 3. ```markdown

# 第三章:Python数据清洗实践

Python作为一种广受欢迎的编程语言,尤其在数据科学领域中,因其强大的数据处理库而被广泛使用。本章节将深入探讨如何利用Python进行数据清洗,以及一些高级技巧。

## 3.1 使用Pandas进行数据预处理

### 3.1.1 Pandas库基础与数据结构

Pandas库是Python中进行数据处理和分析的核心库之一。它提供了两个主要的数据结构:Series和DataFrame。Series是一维的标签数组,可以存储任何数据类型,而DataFrame则是二维标签数据结构,可以被看作一个表格或者说是Series对象的容器。

```python

import pandas as pd

# 创建一个Series

series = pd.Series([1, 2, 3, 4])

# 创建一个DataFrame

data = {'Name': ['Tom', 'Nick', 'Krish', 'Jack'],

'Age': [20, 21, 19, 18]}

df = pd.DataFrame(data)

```

在上述代码中,我们创建了一个简单的Series和DataFrame。了解这两种数据结构的基本操作是进行数据清洗和分析的基础。

### 3.1.2 数据筛选与分组聚合

数据筛选和分组聚合是数据清洗的重要步骤,Pandas库提供了强大的方法来完成这些任务。

```python

# 筛选年龄大于19的记录

df_filtered = df[df['Age'] > 19]

# 使用groupby进行分组聚合

grouped = df.groupby('Name').mean(

0

0