【平滑扩展Hadoop集群】:实现扩展性的分析与策略

发布时间: 2024-10-25 14:44:24 阅读量: 39 订阅数: 41

大数据的炼金术:Hadoop数据分析全攻略

# 1. Hadoop集群扩展性的重要性与挑战

随着数据量的指数级增长,Hadoop集群的扩展性成为其核心能力之一。Hadoop集群扩展性的重要性体现在其能否随着业务需求的增长而增加计算资源和存储能力。一个高度可扩展的集群不仅保证了处理大数据的高效性,也为企业节省了长期的IT成本。然而,扩展Hadoop集群面临着挑战,比如硬件升级的限制、数据迁移的风险、系统兼容性以及扩展过程中的服务中断问题。

## 1.1 面临的挑战

- **硬件与物理限制**:扩展物理服务器的性能存在极限,而增加更多的物理节点会增加管理的复杂性。

- **数据迁移的风险**:在扩展过程中,数据需要重新分配到新的或升级后的节点上,这个过程中可能会出现数据丢失或损坏的风险。

- **系统兼容性问题**:随着集群的不断扩展,不同年代的硬件和软件可能需要协同工作,这需要兼容性保障措施。

## 1.2 扩展的重要性

- **保持业务连续性**:有效的扩展策略可以确保在系统扩展期间业务运行的连续性。

- **优化成本效益**:随着数据量的增加,通过合理扩展能够避免过度投资于资源。

- **应对数据增长**:数据的持续增长要求系统具备平滑扩展的能力,以应对未来的数据量。

在接下来的章节中,我们将探讨Hadoop的理论基础,了解其架构和扩展性理论模型,以及扩展策略,为理解如何实践Hadoop集群的扩展提供坚实的基础。

# 2. Hadoop集群扩展性的理论基础

### 2.1 Hadoop架构概述

Hadoop架构是为了解决大数据处理问题而设计的一个开源框架,它由两个核心组件构成:Hadoop分布式文件系统(HDFS)和MapReduce编程模型。Hadoop采用master-slave(主从)架构,其中,NameNode(主节点)负责管理文件系统的命名空间和客户端对文件的访问,而DataNode(从节点)则存储实际的数据。

#### 2.1.1 Hadoop的主要组件介绍

Hadoop的主要组件包括以下部分:

- **NameNode**:负责管理文件系统的元数据,并维护文件系统树及整个HDFS的目录树。它是系统中的关键节点,但它并不存储实际数据。

- **DataNode**:在各个节点上实际存储数据,响应客户的读写请求。每个DataNode节点负责管理其存储的数据块的存储。

- **ResourceManager**:YARN架构中的主节点,负责资源的管理和任务调度。

- **NodeManager**:YARN架构中的从节点,管理单个节点上的资源使用情况。

#### 2.1.2 HDFS和MapReduce的工作原理

**HDFS**:它把大文件分割成固定大小的数据块,并在集群中的多个DataNode上进行存储。NameNode负责数据块的索引和命名空间,而实际的数据存储在DataNode上。这种设计允许Hadoop存储和处理PB级别的数据。

**MapReduce**:是一种编程模型,用于处理和生成大数据集。用户编写Map函数和Reduce函数,Map函数处理输入数据生成中间键值对,而Reduce函数则对中间结果进行汇总处理。

### 2.2 扩展性理论模型

#### 2.2.1 水平扩展与垂直扩展的区别

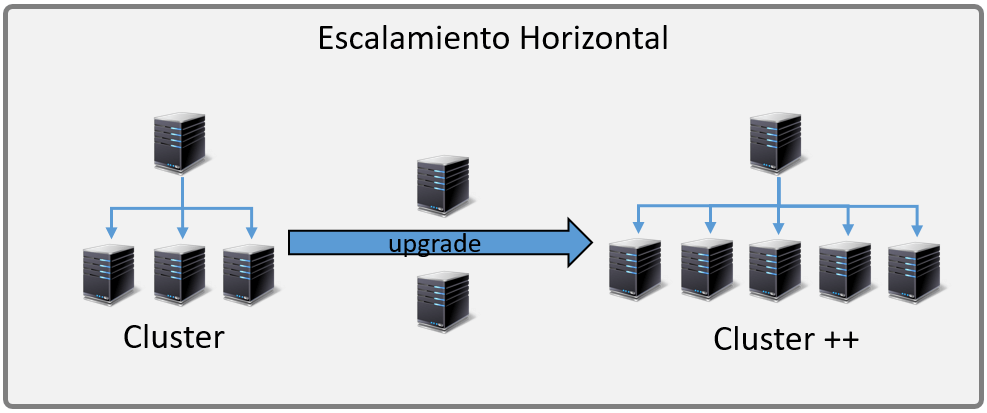

**水平扩展(Scale-out)**:通过增加更多的机器到系统中来提升整体系统的性能和容量。这种方式是Hadoop的强项,因为它允许系统无缝地增加新的节点,而不会影响现有的工作负载。

**垂直扩展(Scale-up)**:通过升级现有机器的硬件(如CPU、RAM或存储设备)来提升性能。这种扩展方式有物理限制,并且随着硬件的升级成本显著增加。

#### 2.2.2 扩展性的关键性能指标

在衡量扩展性时,一些关键的性能指标包括:

- **吞吐量**:单位时间内完成的作业数量。

- **响应时间**:从作业提交到作业完成的时间。

- **资源利用率**:集群中各个资源的使用效率。

- **可伸缩性**:系统扩展后的性能与扩展之前的性能之比。

### 2.3 扩展策略的理论分析

#### 2.3.1 预测性扩展与反应性扩展

**预测性扩展**:基于历史数据和负载趋势对系统未来的资源需求进行预测,然后提前进行扩展。这种策略可以预防潜在的性能瓶颈,但可能造成资源的浪费。

**反应性扩展**:根据实时监控系统当前的负载情况,在性能下降或资源耗尽时才进行扩展。这种方式资源利用率较高,但可能引入短暂的延迟或性能不稳定。

#### 2.3.2 扩展决策的经济模型

扩展决策涉及的经济模型考虑了扩展带来的成本与收益的权衡。需要计算扩展带来的性能提升所带来的价值是否超过了扩展成本。决策模型可能会用到的参数包括:

- **硬件成本**:新设备的购置费用。

- **运营成本**:能源消耗、冷却、系统维护等。

- **性能收益**:增加资源带来的处理能力提升。

- **业务增长预期**:业务扩展带来的收益增长。

扩展决策应基于实际需求和经济模型进行细致的分析,以确保扩展带来的是正向的投资回报。

以上提供了第二章的理论基础内容概览,接下来我们深入探讨具体的Hadoop集群扩展方法。

# 3. Hadoop集群的实践扩展方法

在理解了Hadoop集群扩展性的理论基础之后,本章节将探讨如何在实际环境中扩展Hadoop集群。我们将着重于讨论具体的技术实践,涵盖硬件资源、软件资源的扩展方法以及云环境下的集群扩展策略。

## 3.1 扩展集群硬件资源

硬件资源的扩展是提高Hadoop集群处理能力最直接的方法之一。在这一部分,我们将介绍如何通过添加新的DataNode节点和升级现有节点的硬件配置来实现集群的扩展。

### 3.1.1 添加新的DataNode节点

DataNode是Hadoop分布式文件系统(HDFS)中负责存储数据的部分,添加新的DataNode节点可以有效增加集群的存储容量和数据处理能力。

#### 扩展步骤

1. **准备硬件**:首先,需要准备新的服务器硬件,包括CPU、内存、存储设备等。

2. **安装DataNode**:在新硬件上安装DataNode,并确保其与集群中的NameNode保持通信。

3. **配置DataNode**:修改DataNode的配置文件`hdfs-site.xml`,设置合适的块大小等参数。

4. **重启DataNode服务**:完成配置后重启DataNode服务,使其生效。

5. **监控DataNode**:通过Hadoop管理界面监控新节点的状态,确保其正常工作。

#### 注意事项

- **数据均衡**:增加节点后,数据块会在集群中重新分布,以利用新的存储容量。

- **网络配置**:确保新节点的网络配置正确,能够被其他节点访问。

- **兼容性检查**:新硬件的规格要与现有集群兼容,避免硬件不匹配问题。

### 3.1.2 升级现有节点的硬件配置

除了增加新的节点,升级现有节点的硬件配置也是扩展集群的常见方法。这可能涉及增加内存、升级CPU或更换更大容量的存储设备。

#### 扩展步骤

1. **评估升级需求**:根据集群当前的工作负载,评估需要升级的硬件组件。

2. **计划停机时间**:规划合适的停机时间进行硬件升级,以减少对业务的影响。

3. **执行硬件更换**:在停机期间更换或升级硬件组件。

4. **重新配置操作系统**:根据硬件升级后的变化,重新配置操作系统和Hadoop的安装。

5. **重启服务并测试**:重启Hadoop集群服务,并进行测试以确保新配置的稳定性。

#### 注意事项

- **数据备份**:在硬件升级之前,务必对数据进行备份,以防意外发生。

- **兼容性检查**:新硬件必须与现有的

0

0