【Oozie工作流管理】:Hadoop流程控制与案例分析

发布时间: 2024-10-25 14:22:34 阅读量: 5 订阅数: 6

# 1. Oozie工作流概述与安装部署

## 1.1 Oozie工作流简介

Oozie是一个用于管理Hadoop作业的工作流调度系统。它主要用于定义、调度、执行和监控Hadoop任务。Oozie工作流提供了一种简单的方法来协调在Hadoop集群上运行的多个作业,并确保作业的正确执行顺序。

## 1.2 Oozie工作流的特点

Oozie工作流的主要特点包括:

- 支持多种任务类型,包括MapReduce、Pig、Hive、Sqoop、Distcp等。

- 可以通过控制流定义作业依赖性,实现作业的顺序或条件执行。

- 支持作业调度,允许定时启动工作流任务。

- 提供了丰富的监控和日志功能,方便跟踪和调试工作流执行情况。

## 1.3 Oozie工作流的安装部署

Oozie可以通过Maven或源码安装,安装过程包括配置数据库、Web服务器以及集群环境。以下是基于源码的安装部署步骤:

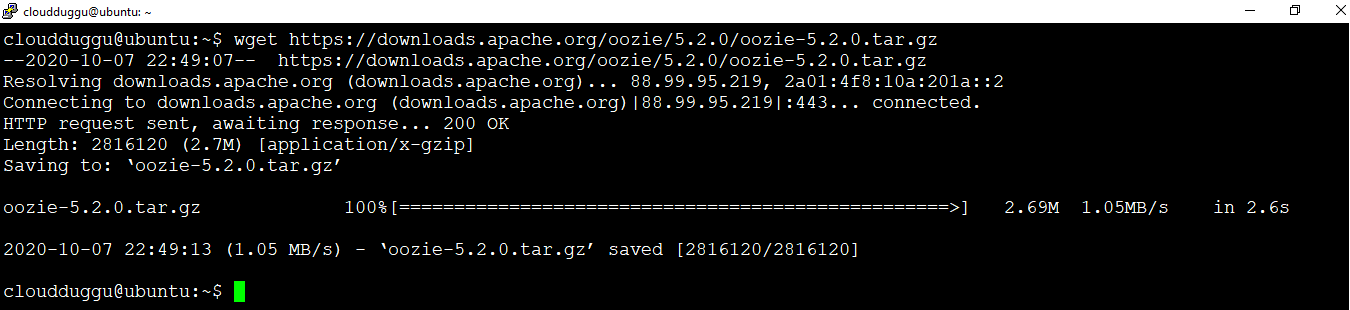

1. 下载并解压Oozie源码包:

```bash

wget ***

***

***

```

2. 安装数据库驱动到本地Maven仓库:

```bash

mvn install:install-file -DgroupId=org.postgresql -DartifactId=postgresql -Dversion=42.2.5 -Dpackaging=jar -Dfile=postgresql-X.Y.Z.jar

```

3. 使用Maven编译Oozie:

```bash

mvn clean install -Pdist -DskipTests -Dcheckstyle.skip

```

4. 配置Oozie服务器和数据库连接,通常需要编辑`oozie-server/src/main/webapp/WEB-INF/conf/oozie-site.xml`文件。

5. 部署Oozie Web应用到Tomcat或Jetty等Web服务器上。

通过以上步骤,您将完成Oozie的基本安装部署,可以进一步配置并开始创建和调度工作流作业。

# 2. Oozie工作流的基础理论

在本章,我们将深入探讨Oozie工作流的基础理论,它是理解和利用Oozie进行高效任务调度和处理的关键。我们将从Oozie工作流的组件与架构开始,继而分析任务的调度与触发机制,最后讨论工作流的依赖管理。

## 2.1 Oozie工作流的组件与架构

### 2.1.1 Oozie的基本组件

Oozie工作流是由一系列组件构成的,这些组件共同工作以实现复杂的大数据处理工作流。核心组件包括:

- **JobTracker**: 该组件负责跟踪和管理整个Oozie工作流的执行状态。

- **Workflow Coordinator**: 它是工作流的中心控制器,负责解析XML格式的工作流定义,并协调各个任务的执行。

- **Action Nodes**: 表示工作流中的具体任务,比如Hadoop作业、Pig任务、Shell脚本等。

- **Coordination Action**: 如ControlFlow用于控制工作流中的决策点,Fork和Join用于并行执行和合并任务。

每个组件都扮演着不可替代的角色,其相互协作保证了工作流的顺利执行。

### 2.1.2 工作流架构的内部机制

Oozie工作流的架构是分层的,最顶层是**工作流引擎**,它处理工作流定义并触发Action的执行。下一层是**工作流执行引擎**,它管理整个工作流的生命周期,如启动、恢复、终止和暂停。在这一层下,是与各个计算框架的集成层,如Hadoop、Pig、Hive等。这些组件的交互形成了工作流架构的内部机制。

工作流定义文件通常使用XML语言,其中包含了工作流的结构信息、任务信息以及任务之间的依赖关系。Oozie使用这些信息来执行工作流任务。

## 2.2 工作流任务的调度与触发

### 2.2.1 时间调度策略

Oozie可以通过时间调度策略来周期性地执行工作流任务。Oozie支持多种时间调度策略,如cron表达式,这些表达式定义了任务执行的时间和频率。例如,一个简单的cron表达式`0 ***`表示任务每小时执行一次。

在定义时间调度策略时,我们可以使用以下步骤来配置Oozie的定时工作流:

1. 在Oozie的配置文件中指定调度器的配置。

2. 创建工作流定义,并在其中包含时间调度信息。

3. 提交调度的工作流作业。

```xml

<workflow-app xmlns="uri:oozie:workflow:0.4" name="cron-workflow">

...

<start to="action-node" />

<action name="action-node">

...

</action>

...

<kill name="kill">

<message>Workflow killed</message>

</kill>

</workflow-app>

```

在上面的XML代码中,我们没有指定时间调度信息,这是因为调度信息通常在Oozie的工作流作业配置中单独指定。

### 2.2.2 外部触发机制

除了内置的时间调度机制外,Oozie还支持外部触发机制,这允许我们根据外部事件或请求来启动工作流。比如,可以使用HTTP请求或命令行指令来启动工作流。

为了实现外部触发,我们需要配置工作流作业的`start`参数,它定义了作业启动的方式。当设置为`coord`时,可以通过Oozie的Web服务API启动工作流。

```shell

oozie job -start <workflow-job-id> -config <property-file>

```

通过以上命令,我们可以启动一个指定的工作流作业。

## 2.3 工作流的依赖管理

### 2.3.1 任务依赖的定义

任务依赖是工作流设计中重要的组成部分,它确保任务按照预定的顺序执行。在Oozie中,任务依赖是通过XML工作流定义中的依赖属性来定义的。

例如,我们定义了一个简单的工作流,其中任务B依赖于任务A的完成:

```xml

<workflow-app xmlns="uri:oozie:workflow:0.4" name="dependency-workflow">

<start to="actionA" />

<action name="actionA">

<map-reduce>

<job-tracker>${jobtracker}</job-tracker>

<name-node>${namenode}</name-node>

<prepare>

<set>

<name>mapreduce.job.jar</name>

<value>${resourcePath}/myjob.jar</value>

</set>

</prepare>

<configuration>

<!-- job configuration -->

</configuration>

</map-reduce>

</action>

<action name="actionB">

<java>

<main-class>com.example.MyMainClass</main-class>

<arg>-param</arg>

<resource>file:${resourcePath}/myjar.jar</resource>

</java>

</action>

<decision name="join">

<switch>

<case to="actionB">OK</case>

<default to="kill">NOK</default>

</switch>

</decision>

<kill name="kill">

<message>Workflow killed</message>

</kill>

</workflow-app>

```

在这个工作流定义中,`actionB`依赖于`actionA`的执行结果,只有`actionA`成功执行,`actionB`才会被执行。

### 2.3.2 数据和控制流依赖的处理

Oozie不仅支持任务之间的控制流依赖,还支持数据流依赖。数据流依赖确保工作流中数据的正确传递和处理,这对于复杂的数据处理工作流尤其重要。

为了处理数据流依赖,Oozie引入了`<data>`元素,该元素可以嵌入在工作流定义中的不同`<action>`之间。以下是一个使用数据流依赖的工作流示例:

```xml

<action name="actionA">

...

<output>

<data>output_dir</data>

</output>

</action>

<action name="actionB">

<java>

<main-class>com.example.MyMainClass</main-class>

<arg>-input</arg>

<arg>${nameNode}/output_dir</arg>

<arg>-output</arg>

<arg>${nameNode}/actionB_output</arg>

</java>

<input>

<data>output_dir</data>

</input>

</action>

```

在这个例子中,`actionB`依赖于`actionA`的输出目录作为输入参数,确保了数据的连贯性和依赖性。

以上章节介绍了Oozie工作流的基础理论,涵盖了工作流组件、任务调度与触发机制,以及依赖管理。在下一章,我们将深入到Oozie工作流的实践应用中,通过具体案例分析如何将这些理论应用到实际的大数据处理任务中去。

# 3. Oozie工作流的实践应用

## 3.1 Hadoop作业的整合与控制

### 3.1.1 Hadoop作业的封装

在大数据处理中,Oozie工作流可以被用来整合和控制Hadoop作业。首先,我们需要对单个Hadoop作业进行封装。这涉及到创建一个可执行的jar文件,这个jar文件通常包含了处理数据所需的MapReduce作业。这个过程可以通过Maven或Ant等构建工具来完成。

封装MapReduce作业的流程包括:

- **编写Mapper和Reducer类**:定义Map和Reduce逻辑。

- **创建Driver类**:配置Job运行参数,并提交作业。

- **编写pom.xml或build.xml**:设定项目依赖和构建逻辑。

- **构建Jar文件**:使用构建工具打包项目。

下面的代码展示了如何使用Maven创建一个简单的MapReduce作业,并打包成一个jar文件。

```xml

<!-- pom.xml示例 -->

<project>

<modelVersion>4.0.0</modelVersion>

<groupId>com.example</groupId>

<artifactId>mapreduce-demo</artifactId>

<version>1.0-SNAPSHOT</version>

<dependencies>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-mapreduce-client-core</artifactId>

<version>YOUR_HADOOP_VERSION</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<artifactId>maven-assembly-plugin</artifactId>

<configuration>

<archive>

<manifest>

<mainClass>com.example.MapReduceDriver</mainClass>

</manifest>

</archive>

<descriptorRefs>

<descriptorRef>jar-with-dependencies</descriptorRef>

</descriptorRefs>

</configuration>

<executions>

<execution>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>

</project>

```

在上面的`pom.xml

0

0