大数据处理框架深度比较:Hadoop、Spark、Flink谁主沉浮

发布时间: 2025-01-09 17:43:44 阅读量: 4 订阅数: 5

# 摘要

随着大数据时代的到来,选择合适的处理框架对于数据分析和处理的效率至关重要。本文全面介绍了大数据处理中广泛使用的Hadoop、Spark和Flink框架,包括它们的核心组件、工作原理、扩展技术以及实践应用案例。通过对Hadoop生态系统、Spark的革命性进步以及Flink作为流处理新星的深入解析,文章阐述了这些框架在批处理、流处理和高级数据处理方面的能力。最后,本文提供了框架性能、适用场景、社区活跃度和生态系统等方面的比较分析,并展望了大数据处理技术的未来发展趋势,帮助技术人员在不同应用场景下作出明智的技术选择。

# 关键字

大数据处理框架;Hadoop生态系统;Spark;Flink;批处理;流处理;数据处理能力;框架比较;技术展望

参考资源链接:[新视野大学英语视听说教程4:听力与答案解析](https://wenku.csdn.net/doc/8bytd37bkx?spm=1055.2635.3001.10343)

# 1. 大数据处理框架概述

随着信息技术的飞速发展,大数据处理已经成为了信息技术领域中的一个关键话题。本章主要介绍大数据处理的框架,这些框架成为了企业构建数据分析和处理能力的基础设施。

首先,我们将解释什么是大数据处理框架以及它的重要性。接着,深入分析大数据框架在存储、处理和分析海量数据时所采用的核心技术和方法。我们会讨论如何通过这些框架来优化数据处理流程,并且提高数据处理的速度和效率。

最后,本章还会通过对比各种大数据框架,帮助读者了解不同框架的适用场景和优劣点。为那些在多个框架之间进行选择的企业提供决策支持,并概述大数据处理框架在未来技术发展中的潜在趋势。

为了加深理解,本章将结合案例分析,展示这些框架在实际应用中的效果和优势。通过这些案例,我们旨在为读者提供一个全面而深入的视角,理解大数据框架在现代数据密集型应用中的核心作用。

# 2. Hadoop生态系统详解

大数据的出现催生了众多处理框架,而Hadoop则是其中的佼佼者,它的生态系统非常庞大,为大数据处理提供了全面的解决方案。本章将深入探讨Hadoop生态系统中的核心组件及其扩展技术,并通过实践应用案例来展示其强大的生命力。

## 2.1 Hadoop的核心组件

Hadoop的核心组件包括HDFS和MapReduce,它们是构建大规模数据存储和处理的基础。通过了解其工作原理与优化,我们可以进一步掌握其在大数据处理中的核心作用。

### 2.1.1 HDFS的工作原理与优化

Hadoop分布式文件系统(HDFS)是为存储大数据而设计的文件系统,它通过将数据拆分成块,并将这些块分布存储在多个节点上来实现高容错性和可扩展性。

#### HDFS的工作原理

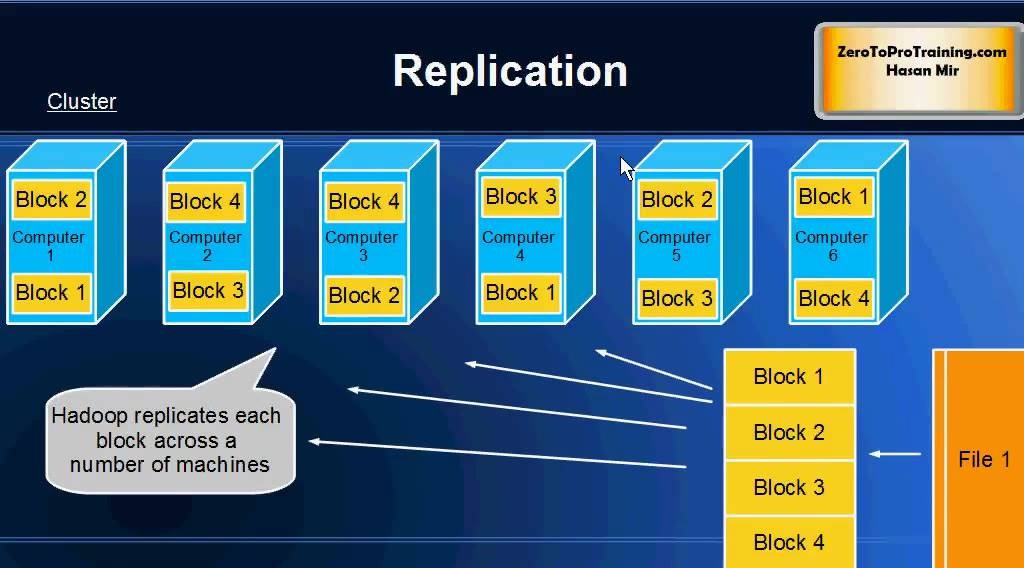

- **块的分布式存储**:HDFS将文件分割成块(默认大小为128MB),这些块被复制到多个数据节点上,每个数据节点可以存储多个块。

- **数据冗余**:为了保证数据的可靠性,每个块会被复制多个副本(默认为3个),分别存储在不同的节点上。

- **NameNode和DataNode**:HDFS具有一个主节点NameNode和多个工作节点DataNode。NameNode负责管理文件系统的元数据,而DataNode则负责处理文件系统客户端的读写请求。

#### HDFS的优化策略

- **负载均衡**:通过设置`dfs.balance-bandwidth-per-sec`参数,可以控制HDFS进行数据重新分布的带宽限制,以此来优化数据节点之间的负载均衡。

- **副本放置策略**:优化副本放置策略可以通过设置`dfs.replication.place`属性,提高数据的冗余性和读取性能。

```xml

<!-- HDFS配置示例 -->

<configuration>

<property>

<name>dfs.balance-bandwidth-per-sec</name>

<value>1048576</value> <!-- 1MB/s -->

</property>

<property>

<name>dfs.replication.place</name>

<value>rack-aware</value> <!-- 副本放置策略 -->

</property>

</configuration>

```

- **读写缓存**:对DataNode进行读写缓存的优化可以显著提高处理速度。可以通过调整`io.file.bufffer.size`参数来控制缓存大小。

```shell

# 设置DataNode读写缓存大小的命令示例

hdfs dfsadmin -setSpaceConfig -write -size 104857600

```

### 2.1.2 MapReduce的编程模型

MapReduce是一种编程模型,用于在大量计算节点上并行处理大数据集。它由两个关键阶段组成:Map阶段和Reduce阶段。

#### MapReduce的工作流程

- **Map阶段**:输入数据被Map函数处理,生成键值对(key-value pairs)。

- **Shuffle过程**:Map阶段的输出通过Shuffle过程被分发到相应的Reduce任务。

- **Reduce阶段**:Reduce函数对分发来的数据进行合并处理,产生最终结果。

#### MapReduce的性能优化

- **Combiner的使用**:Combiner是在Map任务结束后和Shuffle开始前,在Map节点上进行的局部数据合并操作,可以减少网络传输的数据量。

- **自定义分区器**:通过实现自定义分区器,可以更精确地控制数据如何分配到Reduce任务中,从而优化数据处理效率。

- **优化Map和Reduce任务**:合理设置Map和Reduce任务的并行度,可以有效提升整体处理速度。

```java

// 自定义分区器示例

public class CustomPartitioner extends Partitioner<Text, IntWritable> {

@Override

public int getPartition(Text key, IntWritable value, int numPartitions) {

// 自定义分区逻辑

return (key.hashCode() & Integer.MAX_VALUE) % numPartitions;

}

}

```

## 2.2 Hadoop的扩展技术

Hadoop的扩展技术进一步增强了其处理能力,其中YARN是最主要的资源管理与调度平台,Hive和Pig则为高级数据处理提供了便捷的工具。

### 2.2.1 YARN的资源管理与调度

YARN(Yet Another Resource Negotiator)是一种资源管理平台,它将资源管理和作业调度/监控分离开来,极大地提升了Hadoop的扩展性和资源利用率。

#### YARN的工作原理

- **资源管理器(ResourceManager)**:负责整个系统的资源管理和分配。

- **节点管理器(NodeManager)**:管理每个节点上的资源使用情况。

- **应用程序历史服务器(ApplicationHistoryServer)**:记录和跟踪应用程序的执行历史。

#### YARN的关键组件

- **资源调度器**:YARN中的调度器负责在资源可用时将资源分配给应用程序。常用的调度器有容量调度器(Capacity Scheduler)和公平调度器(Fair Scheduler)。

- **应用程序(ApplicationMaster)**:每个应用程序都有一个ApplicationMaster来监控任务执行情况,并与ResourceManager协调资源。

#### YARN的性能优化

- **资源队列设置**:合理配置资源队列,可以保证高优先级作业获得所需资源,同时避免低优先级作业占用过多资源。

- **内存和CPU资源优化**:通过调整`yarn.scheduler.capacity.maximum-applications`和`yarn.scheduler.capacity.resource-calculator`等参数来优化内存和CPU资源分配。

### 2.2.2 Hive和Pig的高级数据处理

Hive和Pig提供了对复杂SQL查询和数据流处理的高级抽象,使得用户可以使用类SQL语言进行大数据分析,而不必深入底层的MapReduce编程。

#### Hive的高级数据处理

- **数据仓库工具**:Hive提供了类SQL查询语

0

0