【HDFS数据迁移优化深度探讨】:算法、技术与最佳实践

发布时间: 2024-10-29 10:55:17 阅读量: 49 订阅数: 33

大数据开发:HDFS数据节点与名称节点的通信机制.docx

# 1. HDFS数据迁移的背景与挑战

随着大数据技术的不断发展,Hadoop分布式文件系统(HDFS)已成为处理大规模数据集的事实标准。数据迁移作为HDFS维护和扩展的关键环节,承担着优化集群性能、保证数据可靠性和灵活性的任务。然而,在实际操作中,HDFS数据迁移面临着数据一致性、系统稳定性和迁移效率的多重挑战。

数据迁移的背景涵盖了大数据环境下的数据增长、分布式计算的负载均衡、硬件升级换代、容灾备份等多个方面。数据迁移的挑战主要在于确保迁移过程中的数据不丢失、不损坏,且不影响业务系统的正常运行。此外,对于拥有海量数据的系统来说,迁移效率的优化至关重要,因为它直接关系到系统停机时间的长短以及迁移期间资源的使用效率。

HDFS数据迁移的实施,需要深思熟虑的规划和精心设计的策略,以确保数据迁移过程中的高可靠性与高效率。在本章中,我们将进一步探讨这些挑战,并在后续章节中深入分析解决这些挑战的核心算法和技术实践。

# 2. HDFS数据迁移的核心算法分析

在本章中,我们将深入探讨HDFS数据迁移中的核心算法,分析其基本原理和关键技术创新。我们将从数据迁移算法的设计目标、性能评估标准,以及关键算法技术的深入剖析,最终展望算法的未来创新与发展方向。

## 2.1 数据迁移算法的基本原理

数据迁移算法是确保HDFS数据在不同存储设备或集群之间高效、稳定迁移的关键。我们需要理解其设计目标和约束,同时确立性能评估的标准。

### 2.1.1 算法设计的目标与约束

在设计数据迁移算法时,首要目标是实现数据的无缝迁移,保持数据的完整性和一致性。算法必须高效地处理大量数据,同时最小化对现有系统性能的影响。此外,算法需要能够适应网络波动和硬件故障,保证数据迁移的鲁棒性。约束条件包括有限的网络带宽、存储设备的I/O限制和内存容量等。

### 2.1.2 算法的性能评估标准

评估HDFS数据迁移算法性能的标准包括迁移速度、CPU和内存的使用率、网络带宽的占用情况和数据完整性校验。此外,还需要考量算法是否能够平滑处理并行数据流、是否具有良好的负载均衡特性以及是否支持高效的故障恢复机制。

## 2.2 关键算法技术的深入剖析

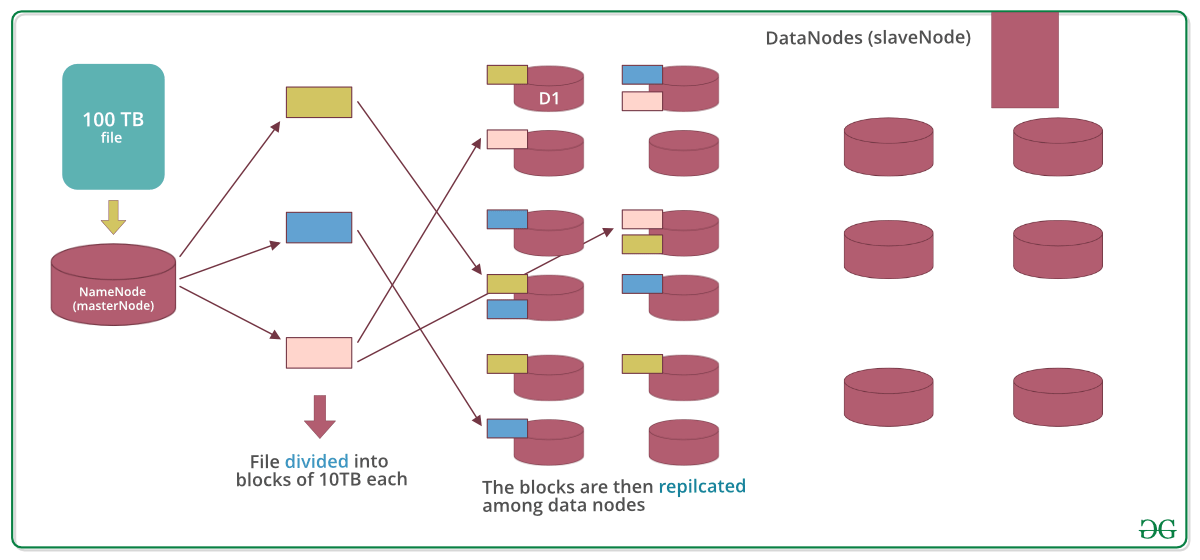

### 2.2.1 数据分块与校验机制

数据分块是将大文件分割成小块进行并行处理,从而提高数据迁移效率。校验机制用于确保数据在迁移过程中未被损坏。分块与校验机制结合使用,可以极大地提高迁移的效率和可靠性。

```python

def chunk_file(file_path, chunk_size):

chunks = []

with open(file_path, 'rb') as ***

***

***

***

***

***

***

* 示例:使用MD5算法计算数据块的校验码

import hashlib

return hashlib.md5(chunk).hexdigest()

```

在上述代码中,我们定义了`chunk_file`函数用于将文件分块,并通过`checksum`函数计算每个数据块的校验码。这样的处理确保数据的完整性。

### 2.2.2 并行传输与负载均衡策略

并行传输可以显著提高数据迁移的速度。HDFS通常采用多线程或多进程的方法来实现数据的并行传输。负载均衡策略保证数据流在网络中的均匀分布,避免因某些节点过载而降低整个迁移过程的效率。

mermaid流程图如下,展示了并行传输与负载均衡的简单示例:

```mermaid

graph LR

A[开始数据迁移] --> B[创建多个传输线程]

B --> C[分配任务到各线程]

C --> D[每个线程处理指定数据块]

D --> E[监控传输状态]

E -->|负载不均| F[调整任务分配]

E -->|完成| G[结束数据迁移]

F --> C

```

### 2.2.3 算法优化的实践案例

优化策略包括利用缓存减少磁盘I/O操作,使用压缩技术降低数据传输量,以及采用多路径传输提升网络使用效率。优化过程通常需要结合具体的硬件环境和数据特点进行细致调优。

## 2.3 算法创新与未来展望

### 2.3.1 当前算法的局限性

当前HDFS数据迁移算法尽管已经较为成熟,但仍然存在一些局限性,如在网络条件差的情况下,数据迁移速度受限;对于大规模集群的数据迁移,算法效率仍有提升空间。

### 2.3.2 新兴技术对算法的影响

云计算、容器化技术以及人工智能的发展,正在影响和推动HDFS数据迁移算法的创新。例如,基于AI的预测模型可以优化数据迁移计划,减少迁移时间,提高成功率。

在下一章节,我们将具体探讨HDFS数据迁移的技术实践,包括工具与平台选择、过程技巧以及优化案例分析。

# 3. HDFS数据迁移的技术实践

## 3.1 数据迁移工具与平台的选择

### 3.1.1 开源工具的比较与评估

在选择合适的HDFS数据迁移工具时,开源社区提供了多种选项,它们各有优劣。选择时需要考虑多个因素,包括但不限于功能特性、社区支持、易用性、文档完善度以及在特定场景下的表现。

以下是目前市场上比较流行的几个开源数据迁移工具:

- **DistCp**:Hadoop自带的分布式拷贝工具,可以用于HDFS之间或者HDFS与本地文件系统之间的数据迁移。DistCp支持并行拷贝和容错处理,但它并不支持数据校验和增量迁移。

- **Sqoop**:主要用于在Hadoop和关系型数据库之间导入导出数据,虽然主要用于数据迁移场景,但在大规模数据迁移方面可能效率不够高。

- **Apache NiFi**:是一个易于使用、功能强大且可扩展的数据流处理和分布式数据路由系统。它提供了一个基于Web的用户界面,以图形化方式构建数据流。NiFi支持多种数据源,提供了丰富的处理组件,适合复杂的数据迁移流程。

评估这些工具时,可以从以下方面考虑:

- **迁移性能**:各工具在不同规模数据集和硬件配置下的性能对比。

- **功能完整性**:工具支持的功能范围和其在特定场景下的表现。

- **社区活跃度**:社区活跃度代表了一个工具的持续改进和问题解决速度。

- **兼容性**:工具与不同版本的Hadoop、操作系统、以及其他相关系统(比如安全认证系统)的兼容性。

**表格 3-1**:数据迁移工具比较表

| 特性 | DistCp | Sqoop | Apache NiFi |

|------------|--------|-------|-------------|

| 并行处理能力 | 高 | 中 | 高 |

| 数据校验机制 | 无 | 有 | 有 |

| 增量迁移支持 | 无

0

0