【并行计算课程设计】:理论与实践完美结合指南

发布时间: 2024-12-17 11:20:05 阅读量: 3 订阅数: 10

Matlab 并行计算指南:高效编程与实践

参考资源链接:[并行计算课程设计(报告+代码+可执行文件)](https://wenku.csdn.net/doc/6412b725be7fbd1778d49413?spm=1055.2635.3001.10343)

# 1. 并行计算的基础理论

## 1.1 并行计算概述

在信息技术迅速发展的今天,数据量的增长速度远远超过了单处理器性能的提升速度。并行计算作为一种通过多个处理单元同时执行计算任务的方法,有效地解决了这一问题。它通过将大型问题分解为可以并行解决的小问题,以提高计算效率和处理速度。

## 1.2 并行计算的关键特性

并行计算的关键特性包括并发性(Concurrence)、同步性(Synchronization)、局部性(Locality)和可伸缩性(Scalability)。并发性是指多个计算过程同时执行的状态;同步性指协调不同计算进程的操作顺序;局部性关注数据访问模式以减少延迟;可伸缩性是衡量并行系统处理能力随资源增加而提升的程度。

## 1.3 并行计算的优势与挑战

并行计算相比传统串行计算,能够在更短的时间内解决复杂问题,尤其是在科学计算、大数据分析、机器学习等领域显示出巨大优势。然而,它也面临着编程模型复杂、负载平衡困难、通信开销大等诸多挑战。理解这些基础理论,是深入探讨并行计算的前提。

# 2. 并行计算模型与算法设计

## 2.1 并行计算模型概述

### 2.1.1 分布式与共享内存模型

在并行计算中,数据共享与同步是核心问题。分布式内存模型和共享内存模型是两种最广泛使用的计算模型,各自有其特点和应用场景。

在分布式内存模型中,每个处理单元(PE)拥有自己的本地内存,并通过消息传递与其他处理器通信。这种模型适合于大规模并行处理(MPP)和网络化的多处理器系统。由于物理内存不共享,程序设计时需要考虑数据分布和全局数据同步问题。常见的分布式内存编程模型包括MPI(Message Passing Interface),它提供了一套库函数,支持不同进程间的数据传递和同步。

共享内存模型则让多个处理器可以访问同一块内存空间。这种模型通过内存访问来实现进程间通信,程序员无需显式处理数据传输,编写并行程序相对简单。然而,对共享内存的访问需要精细的控制来避免竞态条件和死锁。OpenMP是一种流行的共享内存编程接口,它通过编译器指令、运行时库以及环境变量来实现多线程并行计算。

**Mermaid 流程图示例:**

```mermaid

graph TD

A[开始] --> B{选择计算模型}

B -->|分布式内存| C[分布式内存模型]

B -->|共享内存| D[共享内存模型]

C --> E[适合MPP系统和网络化多处理器]

D --> F[适合多核处理器和共享内存系统]

E --> G[消息传递接口MPI]

F --> H[OpenMP多线程并行]

```

### 2.1.2 消息传递接口(MPI)模型

消息传递接口(MPI)是并行计算中最广泛采用的模型之一。MPI提供了一套丰富的函数库,用于实现进程间的数据通信和同步。尽管MPI可以用于分布式内存和共享内存系统,但更常见于后者,因为它需要程序员手动管理数据传输。

MPI中的通信模式分为点对点和集体通信两种。点对点通信指的是两个进程间的直接数据交换,而集体通信涉及多个进程之间的数据交换。MPI提供了各种集体操作,例如广播、缩减、分发和收集等,这些操作使得在进程间同步和数据共享变得更加高效。

**代码示例:**

```c

#include <mpi.h>

#include <stdio.h>

int main(int argc, char** argv) {

// 初始化MPI环境

MPI_Init(&argc, &argv);

int world_size;

MPI_Comm_size(MPI_COMM_WORLD, &world_size); // 获取总的进程数

int world_rank;

MPI_Comm_rank(MPI_COMM_WORLD, &world_rank); // 获取当前进程的编号

// 打印当前进程信息

printf("Hello world! Proc %d of %d\n", world_rank, world_size);

// 结束MPI环境

MPI_Finalize();

return 0;

}

```

在上述代码中,我们使用了MPI来初始化环境,获取全局进程数以及当前进程的编号,最后完成环境的清理工作。每个进程会打印出自己的编号以及总进程数,以验证MPI程序的正确运行。

在使用MPI进行并行计算时,需要注意以下几点:

- 确保所有进程都在使用相同版本的MPI库,否则可能出现兼容性问题。

- 在使用点对点通信时,需要考虑数据接收和发送的匹配,包括缓冲区大小和数据类型等。

- 对于集体操作,要确保所有进程同时调用同一个集体通信函数,否则可能会导致程序挂起或者死锁。

## 2.2 并行算法设计原则

### 2.2.1 并行算法的效率分析

并行算法的效率分析是衡量算法性能的关键步骤。一般而言,我们关注以下几个方面的性能指标:

1. **加速比(Speedup)**:加速比是指在使用N个处理单元并行执行时,相比于单个处理单元,完成同一任务所需时间的减少比例。理想情况下,加速比应该接近N。

2. **效率(Efficiency)**:效率是指算法并行执行时相对于理想情况下的性能利用率。如果效率低,意味着并行化带来的性能提升不如预期,可能是因为负载分配不均或者通信开销大。

3. **扩展性(Scalability)**:扩展性表示算法在不同规模的并行系统上运行的性能变化。高扩展性的算法能够在增加处理单元时,仍然保持良好的性能表现。

并行算法设计的目标是最大化上述三个指标。为了提高加速比和效率,需要合理设计负载平衡和通信模式。而为了保证扩展性,算法应避免全局同步和过大的通信开销。

### 2.2.2 算法的负载平衡与通信优化

在并行算法设计中,负载平衡和通信优化是提升性能的关键环节。负载平衡是指将计算任务平均分配给各个处理单元,以充分利用所有资源,避免一些处理单元空闲而其他单元过载。

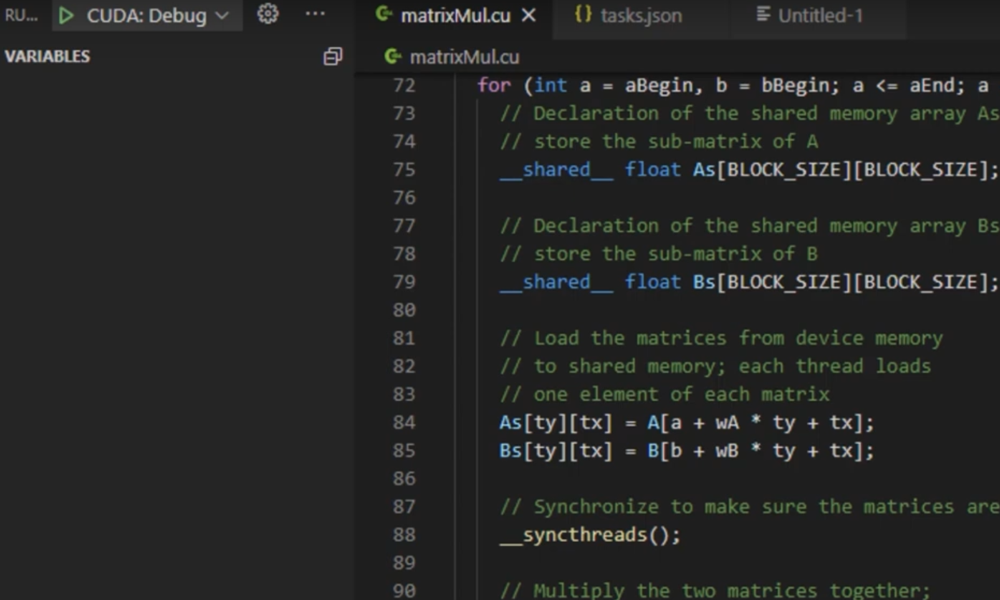

通信优化则是指减少处理器间数据传输的次数和量。这通常涉及算法的结构和数据的布局优化。例如,在矩阵乘法中,可以通过数据划分策略,减少远程内存访问和数据传输。

**代码示例:**

```c

// 简化的并行矩阵乘法示例

void parallel_matrix_multiply(int** a, int** b, int** c, int n) {

for (int i = 0; i < n; i++) {

#pragma omp parallel for

for (int j = 0; j < n; j++) {

c[i][j] = 0;

for (int k = 0; k < n; k++) {

c[i][j] += a[i][k] * b[k][j];

}

}

}

}

```

在上述代码中,使用了OpenMP的`parallel for`指令来并行化矩阵乘法的内层循环。通过合理划分任务,每个线程会处理一部分行的乘法操作。此处的负载平衡依赖于数据的自然划分,并且由于矩阵乘法的计算密集型特性,通信开销相对较小。

在设计并行算法时,我们还需要注意以下几点:

- 避免不必要的数据依赖和同步,这可以减少等待时间和不必要的开销。

- 尽可能使用局部数据来降低通信需求。

- 利用数据预取和缓存优化技术,减少数据访问延迟。

## 2.3 并行程序的性能评价

### 2.3.1 性能指标:加速比、效率、扩展性

在并行程序开发中,性能评价是至关重要的一环,它可以帮助开发者识别瓶颈,并对程序进行优化。加速比、效率和扩展性是三个核心性能指标。

加速比是指并行程序相比于等效串行程序完成任务的快慢。理想的加速比应随着处理单元数量线性增长,但在实际应用中,加速比通常会因为通信开销和负载不平衡而小于理想值。

效率则是加速比与处理器数量的比率,它反映了并行程序的性能

0

0