模式识别习题精讲:第四版掌握关键问题的步骤

发布时间: 2024-12-20 06:47:25 阅读量: 1 订阅数: 2

# 摘要

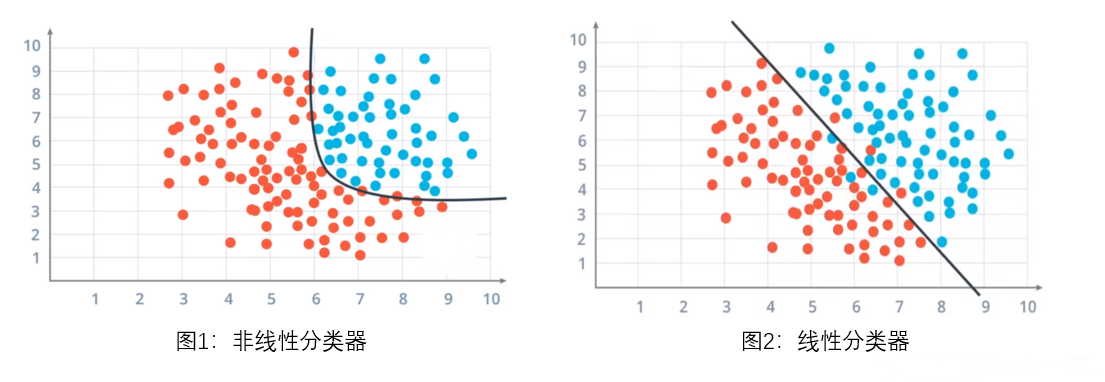

模式识别作为数据分析和人工智能领域的重要分支,涵盖了从基础概念到高级算法的广泛内容。本文首先介绍模式识别的基本概念和统计决策理论,然后深入探讨概率模型、风险函数和分类器性能评估。接下来,重点分析特征选择与提取方法,包括特征选择技术及降维技术如主成分分析(PCA)和线性判别分析(LDA)。在监督学习部分,本文详细解析线性分类器、支持向量机(SVM)以及决策树和集成学习方法。最后,本文探索无监督学习中聚类算法的原理和应用,包括K均值算法及高级聚类方法。通过对各类算法的分析和讨论,本文旨在为读者提供模式识别技术的全面了解,并指导其在实际问题中的应用。

# 关键字

模式识别;统计决策;概率模型;特征选择;监督学习;无监督学习

参考资源链接:[模式识别第四版答案(pattern recognition fourth edition solution)](https://wenku.csdn.net/doc/6412b56bbe7fbd1778d43178?spm=1055.2635.3001.10343)

# 1. 模式识别导论与基础概念

在今天这个信息爆炸的时代,模式识别作为人工智能领域的一个重要分支,已经成为技术发展的必经之路。本章节将为读者介绍模式识别的导论和基础概念,为理解后续章节的统计决策理论、特征选择方法以及监督和无监督学习算法打下坚实的基础。

模式识别是指让计算机通过算法分析并识别数据中的模式、趋势或者规则。这些数据可以是图像、声音、文本或任何其他形式的输入信息。识别的模式可以帮助我们解决分类、回归、聚类等复杂问题。模式识别的核心在于从复杂的数据中提取有效特征,并依据这些特征做出决策。

本章的主要内容包括模式识别的定义、主要任务,以及一些基本概念如特征、样本、类别等。我们将探讨模式识别技术在日常生活中如何应用,以及它如何通过机器学习的方法实现自动化识别。通过对这些基础概念的深入理解,读者将能够更好地抓住后续章节内容的脉络。

# 2. 统计决策理论与模式识别

## 2.1 统计决策理论基础

### 2.1.1 决策理论的基本概念

在统计决策理论中,一个决策问题通常涉及以下几个要素:

- **状态空间**:所有可能的系统状态的集合。

- **行动空间**:所有可能采取的行动的集合。

- **损失函数**:衡量每个行动在每种状态下产生的损失。

- **决策规则**:在给定观测信息下决定采取何种行动的规则。

基于状态和观测信息的不同,决策理论分为完全信息和不完全信息两种情况。在模式识别领域,我们通常面临的是不完全信息情况,因为我们的目的是从有限的观测数据中推断出系统的真实状态。

### 2.1.2 最优分类器的设计原则

最优分类器的目标是使期望损失最小化。这通常涉及以下步骤:

1. 定义损失函数,它描述了对不同分类错误的惩罚程度。

2. 估计类别的先验概率和条件概率密度函数。

3. 应用贝叶斯定理,计算后验概率。

4. 选择使得期望损失最小的行动,即选择后验概率最高的类别作为最终分类结果。

## 2.2 概率模型与贝叶斯决策

### 2.2.1 概率模型的构建

构建概率模型通常涉及以下步骤:

1. 数据收集:收集用于构建模型的数据集。

2. 特征提取:从原始数据中提取有助于分类的特征。

3. 参数估计:使用统计方法来估计模型参数,如最大似然估计(MLE)或贝叶斯估计。

4. 模型选择:选择最合适的概率模型来描述数据,这可以是高斯分布、多项式分布或其他分布类型。

### 2.2.2 贝叶斯决策过程详解

贝叶斯决策过程是一种在不确定条件下作出最优决策的方法。过程包括:

1. 根据贝叶斯定理,计算给定观测数据下每个类别的后验概率。

2. 利用损失函数评估每个行动的期望损失。

3. 选择使期望损失最小化的行动。

贝叶斯决策的关键在于先验概率和似然函数的正确估计。通过这种方式,我们能够将不完整的信息转化为对未知参数的最优估计。

## 2.3 风险函数与分类器性能评估

### 2.3.1 风险函数的定义和性质

风险函数是衡量分类器性能的一个重要概念,它代表了长期的平均损失。对于分类器来说,风险函数通常是误分类概率和损失函数的乘积的期望值。风险函数的性质包括:

- 风险函数与决策规则有关,不同的决策规则会导致不同的风险。

- 在一定的条件下,贝叶斯风险(基于贝叶斯决策的风险)是可达到的最优风险。

- 风险函数提供了一种量化方法来比较不同分类器的性能。

### 2.3.2 分类器性能的评估指标

分类器性能评估主要依赖于以下几个指标:

- **准确率(Accuracy)**:正确分类的样本占总样本的比例。

- **精确率(Precision)**:被正确识别为正类的样本占所有识别为正类样本的比例。

- **召回率(Recall)**:被正确识别为正类的样本占所有实际为正类样本的比例。

- **F1分数(F1-Score)**:精确率和召回率的调和平均数,用于平衡二者的影响。

这些指标可以结合使用,提供一个全面的性能评估,帮助我们识别分类器的优缺点。例如,如果精确率高但召回率低,可能意味着分类器过于保守,拒绝了很多实际为正类的样本。

# 3. ```

# 第三章:特征选择与提取方法

特征选择和特征提取是模式识别中至关重要的步骤。它们有助于减少数据的维度,去除冗余特征,提高学习算法的效率和性能。

## 3.1 特征选择的重要性与方法

特征选择旨在从原始特征集中选出最重要的特征子集,以减少模型的复杂度,提高预测精度和降低计算成本。

### 3.1.1 特征选择的理论基础

特征选择的理论基础涉及数据预处理、降噪、模型复杂度控制等多个方面。选取合适的特征子集可以减少模型的过拟合风险,提升模型泛化能力。传统的特征选择方法包括过滤法、包裹法和嵌入法。

### 3.1.2 实用的特征选择技术

过滤法依赖于统计测试来评估特征与目标变量之间的关系,例如卡方检验、互信息和相关系数。包裹法则将特征选择视为搜索问题,通过学习算法进行多次迭代,选择对模型最有利的特征组合。嵌入法在学习模型的过程中集成特征选择,如L1正则化的线性模型。

## 3.2 主成分分析与降维技术

主成分分析(PCA)是一种常用的数据降维技术,它能够将数据映射到较低维度的空间,同时尽可能保留原始数据的特征信息。

### 3.2.1 主成分分析(PCA)原理

PCA的核心思想是通过正交变换将一组可能相关的变量转换为一组线性不相关的变量,这组新的变量称为主成分。主成分按照解释的方差多少进行排列,通常只选择前几个主成分以达到降维的目的。

``

```

0

0