模式识别判别函数优化:第四版原理与实用方法

发布时间: 2024-12-20 07:26:52 阅读量: 2 订阅数: 2

基于Web前端技术期末大作业源码+文档+高分项目+全部资料.zip

# 摘要

模式识别是数据处理和人工智能领域中的核心内容,其中判别函数在分类和决策过程中扮演着关键角色。本文首先概述了模式识别判别函数的基本概念和作用,随后深入探讨了构建和优化判别函数的理论框架和数学模型,包括统计决策理论和聚类分析的应用。接着,文章详细介绍了判别函数的构建步骤、性能评估和优化策略,并通过图像识别、语音识别及生物信息学中的案例分析,展示了判别函数的实际应用。最后,本文展望了高级优化技术和未来模式识别技术的发展方向,涵盖了深度学习、多目标优化和集成学习等前沿技术的应用前景。

# 关键字

模式识别;判别函数;统计决策理论;聚类分析;性能评估;优化算法

参考资源链接:[模式识别第四版答案(pattern recognition fourth edition solution)](https://wenku.csdn.net/doc/6412b56bbe7fbd1778d43178?spm=1055.2635.3001.10343)

# 1. 模式识别判别函数概述

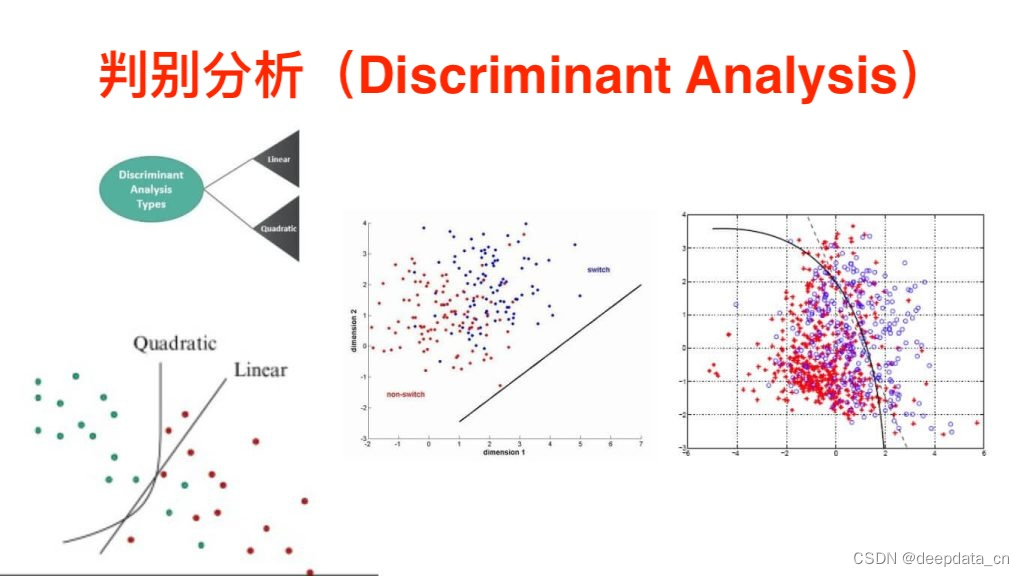

在这一章节中,我们将对模式识别的核心——判别函数进行概述。我们将从一个直观的层面了解判别函数是什么,以及它在整个模式识别系统中扮演的角色。判别函数是用来区分不同模式或类别的一种函数,在很多领域,比如图像识别、语音处理、生物信息学等,都有着不可替代的作用。

接下来我们会简单介绍判别函数的类型,包括线性、非线性和基于概率的判别函数等。通过这些基础知识,读者将能够对判别函数有初步的认识,并为进一步深入学习打下基础。

## 1.1 模式识别判别函数的基础概念

模式识别是一门研究如何让计算机理解世界的技术,它包含了从数据中识别模式、分析规律、做出决策等一系列过程。判别函数,在模式识别中,是一个尤为关键的元素,它通过对数据特征的处理,形成可决策的数值,从而实现对模式的识别。

## 1.2 判别函数的作用与类型

判别函数的作用主要体现在将原始数据特征映射到分类标签上。其核心目的是将不同的模式或类别进行区分。在这个基础上,判别函数可以分为线性判别函数、非线性判别函数以及基于概率的判别函数等。线性判别函数适用于特征空间是线性可分的情况;非线性判别函数则能够处理更复杂的模式识别问题;而基于概率的判别函数则考虑了数据的概率分布,为模式识别提供了更加精细和准确的决策依据。

接下来的章节中,我们将深入讨论模式识别的理论框架、统计决策理论、以及聚类分析等概念,并探讨它们如何与判别函数相互作用。这将为我们理解判别函数在更广泛的应用场景中如何运作提供理论基础。

# 2. 基础理论与数学模型

### 2.1 模式识别的理论框架

#### 2.1.1 模式识别的基本概念

模式识别是通过计算机算法将输入的数据转换成有意义的信息。这通常涉及分类、聚类、回归、异常检测等过程。模式识别的目的是构建一个系统,它能够学习如何识别一个数据中的模式或者规律,通常用于图像、声音或文本等非结构化数据的处理。

在模式识别中,我们面对的是从现实世界中收集的数据。这些数据往往是多维的,包含着丰富的信息,但同时也充满了噪声和不相关的信息。判别函数在模式识别中的作用是提供一个决策边界,这个边界能够帮助我们区分或识别不同的类别。常见的判别函数类型有线性判别函数、二次判别函数、高斯判别函数等。

#### 2.1.2 判别函数的作用与类型

判别函数可以看作是数据空间中的一条线或一个面,用于区分不同类别的数据点。在二维空间中,它可以是一条直线;在三维空间中,它可以是一个平面;在更高维的空间中,它可以是一个超平面。它的作用是将数据分类,按照特征将数据点划分到不同的类别中。

判别函数的类型根据其数学特性可以分为以下几种:

- **线性判别函数**:当决策边界是线性的,即数据点被一个或多个直线或平面分开时,使用线性判别函数。常见的线性判别函数有感知器和线性回归模型。

- **二次判别函数**:当决策边界是二次的,即数据点被一个二次曲面所分隔时,采用二次判别函数。这种方法的表达能力比线性判别函数更强。

- **高斯判别函数**:当数据点符合高斯分布时,高斯判别函数(或称贝叶斯判别)能够有效地进行分类。

### 2.2 统计决策理论基础

#### 2.2.1 概率论与统计学在模式识别中的应用

概率论与统计学在模式识别中扮演着至关重要的角色。它们提供了量化的工具,使我们能够描述数据的不确定性,评估模式识别系统的性能。在统计决策理论中,我们假设数据是按照某种概率分布生成的,因此我们可以计算某个数据点属于某一类的概率,并根据这些概率进行分类。

在实际应用中,我们通常对样本进行采样,并用这些样本来估计概率分布。比如,我们可以使用最大似然估计(MLE)或贝叶斯估计等方法来估计模型的参数。然后,我们会利用这些参数来预测新数据的分类。

#### 2.2.2 最小错误率分类器的设计原理

最小错误率分类器的目标是设计出一个分类器,使得在给定的数据集上能够实现最小的分类错误率。为了达到这一目标,我们需要知道不同类别出现的概率以及给定观测数据属于不同类别的概率。

在设计最小错误率分类器时,我们通常采用贝叶斯决策理论。通过计算给定观测数据属于每一类别的后验概率,并选择具有最高后验概率的类别作为分类结果,可以达到最小错误率的目标。

### 2.3 聚类分析与判别函数

#### 2.3.1 聚类分析的基本方法

聚类分析的目标是将数据集中的样本点根据某种相似度准则分成若干个类别,使得同一个类别内的样本点尽可能相似,而不同类别间的样本点尽可能不同。聚类分析不依赖于事先标记好的类别信息,因此它是一种无监督的学习方法。

常见的聚类分析方法包括K均值(K-means)、层次聚类、DBSCAN等。每种方法有其独特的原理和应用场景,例如K均值通过迭代的方式,找到使得类内距离之和最小的聚类中心,而层次聚类则通过构建一个层次的树状结构来表示数据点间的相似度。

#### 2.3.2 聚类算法与判别函数的结合应用

在实际应用中,聚类算法和判别函数可以相互结合,以达到更好的分类效果。一种常见的方式是先使用聚类算法对数据进行初步的分组,然后再应用判别函数对聚类结果进行微调和优化。

具体步骤如下:

1. **数据预处理**:包括数据清洗、归一化等步骤。

2. **聚类分析**:应用一种聚类算法对数据进行初步分组。

3. **特征提取**:对每个簇内的数据点提取特征,以形成判别函数的输入特征。

4. **判别函数应用**:使用判别函数对每个簇进行分析,进一步优化和细化分类结果。

通过这种方式,我们不仅能够获得更精细的分类效果,而且还可以发现数据中潜在的结构信息。

以上是第二章的内容概要,接下来将详细探讨判别函数构建和优化的各个方面。

# 3. 判别函数的构建与优化

## 3.1 构建判别函数的基本步骤

### 3.1.1 特征选择与提取

在构建判别函数之前,首先需要识别并提取与识别任务最为相关的特征。这一过程对于提高判别函数的分类性能至关重要。特征选择是指从原始数据中选出最有代表性的特征子集,以降低数据维度,提高识别效率。而特征提取则是通过变换原始数据,将数据转换到另一个特征空间中,使得在这个新的特征空间内,同类样本间的相似性更高,而不同类样本间的相似性更低。

例如,在图像处理任务中,可以使用主成分分析(PCA)来提取图像的主要特征。PCA通过降维技术减少了数据的维度,同时尽可能保留了原始数据的结构信息。代码示例如下:

```python

import numpy as np

from sklearn.decomposition import PCA

from sklearn.preprocessing import StandardScaler

# 假设 X 是已加载的图像特征矩阵,每一行是一个样本特征向量

X_std = StandardScaler().fit_transform(X) # 数据标准化

pca = PCA(n_components=100) # 保留100个主成分

X_pca = pca.fit_transform(X_std) # 执行PCA降维

# X_pca即为提取后的特征

```

在此代码块中,我们使用`StandardScaler`对数据进行标准化处理,以消除不同特征间量纲的影响。随后,通过`PCA`对象的`fit_transform`方法对数据进行降维处理,其中`n_components`参数表示我们希望保留的主成分个数。

### 3.1.2 模型的训练与参数估计

在特征选择或提取之后,下一步是使用这些特征来训练模型,即估计判别函数的参数。对于线性分类器,如线性回归、逻辑回归和感知机等,需要估计参数权重向量;而对于非线性分类器,如支持向量机(SVM)、随机森林等,需要估计模型参数,如核函数的参数、树的数量等。

以逻辑回归为例,其目标是找到一组权重向量`w`和偏置项`b`,使得对于每个样本点`(x_i, y_i)`,满足:

```

y_i * (w^T * x_i + b) > 0

```

下面是一个简单的逻辑回归模型参数估计的Python代码示例:

```python

from sklearn.linear_model import LogisticRegression

# 假设 X 是特征矩阵,y 是标签向量

log_reg = LogisticRegression(max_iter=1000, solver='lbfgs')

log_reg.fit(X_train, y_train) # 训练模型

# 模型参数可以通过log_reg.coef_和log_re

```

0

0