MATLAB求导数在机器学习中的价值:优化模型,提升预测准确度

发布时间: 2024-06-08 15:15:51 阅读量: 77 订阅数: 34

# 1. MATLAB求导数的理论基础**

求导数是微积分中的一项基本操作,它表示函数在给定点处的变化率。在MATLAB中,求导数可以通过使用内置函数`gradient`或`diff`来实现。

`gradient`函数计算多变量函数的梯度,而`diff`函数计算一维函数的差分。这些函数可以应用于各种MATLAB数据类型,包括标量、向量和矩阵。通过求导数,我们可以分析函数的行为,确定其极值点和拐点,并了解函数在不同输入值下的变化趋势。

# 2. MATLAB求导数在机器学习中的应用

### 2.1 模型优化的基础

机器学习模型的优化是机器学习中的核心任务之一。模型优化是指通过调整模型的参数,使模型在给定数据集上的性能达到最优。求导数在模型优化中扮演着至关重要的角色,因为它提供了模型性能相对于参数变化的梯度信息。

梯度信息可以指导优化算法沿着性能提升的方向调整模型参数。常用的优化算法包括梯度下降法、共轭梯度法和拟牛顿法等。这些算法都需要计算模型性能相对于参数的梯度,而求导数正是计算梯度的方法。

### 2.2 梯度下降法的原理和实现

梯度下降法是最常用的模型优化算法之一。其原理是沿着模型性能梯度的负方向迭代更新模型参数,直到性能达到最优或满足一定的停止条件。

在MATLAB中,可以使用`gradient`函数计算模型性能相对于参数的梯度。`gradient`函数的语法如下:

```

[grad,fval] = gradient(fun,x)

```

其中:

* `fun`:待求导的函数,可以是匿名函数、函数句柄或字符串。

* `x`:函数的自变量,可以是标量、向量或矩阵。

* `grad`:函数的梯度,与自变量`x`同维。

* `fval`:函数在`x`处的函数值。

下面是一个使用梯度下降法优化线性回归模型的示例代码:

```

% 生成数据

X = randn(100,2);

y = X*[1;2] + randn(100,1);

% 定义模型

model = @(w) sum((X*w - y).^2);

% 定义梯度

gradient_model = @(w) 2*X'*(X*w - y);

% 设置初始参数

w0 = [0;0];

% 设置学习率

alpha = 0.01;

% 迭代优化

for i = 1:1000

w0 = w0 - alpha * gradient_model(w0);

end

% 输出优化后的参数

disp(w0);

```

### 2.3 反向传播算法在神经网络中的应用

反向传播算法是神经网络训练中常用的求导方法。它通过链式法则逐层计算神经网络中每个参数相对于损失函数的梯度。

在MATLAB中,可以使用`backprop`函数进行反向传播。`backprop`函数的语法如下:

```

[grad,act] = backprop(net,X,y)

```

其中:

* `net`:神经网络结构。

* `X`:输入数据。

* `y`:目标输出。

* `grad`:神经网络中每个参数相对于损失函数的梯度。

* `act`:神经网络中每个节点的激活值。

下面是一个使用反向传播算法训练神经网络的示例代码:

```

% 生成数据

X = randn(100,2);

y = X*[1;2] + randn(100,1);

% 定义神经网络

net = feedforwardnet([10,10]);

% 训练神经网络

[net,tr] = train(net,X,y);

% 获取神经网络中每个参数相对于损失函数的梯度

grad = backprop(net,X,y);

% 输出神经网络中每个参数相对于损失函数的梯度

disp(grad);

```

# 3.1 线性回归模型的求导和优化

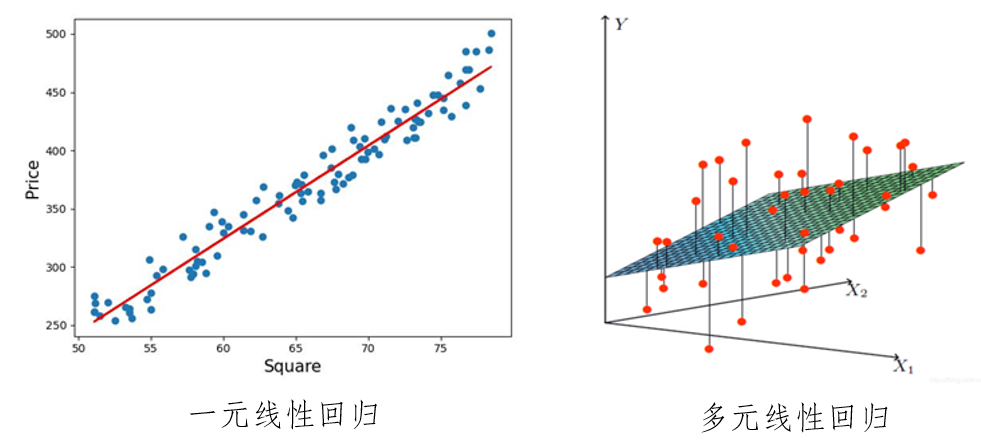

**3.1.1 线性回归模型简介**

线性回归模型是一种用于预测连续变量(因变量)与一个或多个自变量(自变量)之间线性关系的统计模型。其方程形式为:

```

y = β0 + β1x1 + β2x2 + ... + βnxn

```

其中:

* y 是因变量

* x1, x2, ..., xn 是自变量

* β0, β1, ..., βn 是模型参数

**3.1.2 线性回归模型的求导**

线性回归模型的求导可以帮助我们求解模型参数 β0, β1, ..., βn。对于给定的训练数据集,我们可以定义损失函数(又称平方误差函数):

```

L(β0, β1, ..., βn) = 1/2 * Σ(yi - y)^2

```

其中:

* yi 是训练数据中因变量的真实值

* y 是模型预测的因变量值

0

0