【MATLAB深度学习数据预处理全攻略】:20种技巧优化数据标准化与增强

发布时间: 2024-08-30 12:18:47 阅读量: 193 订阅数: 47

java计算器源码.zip

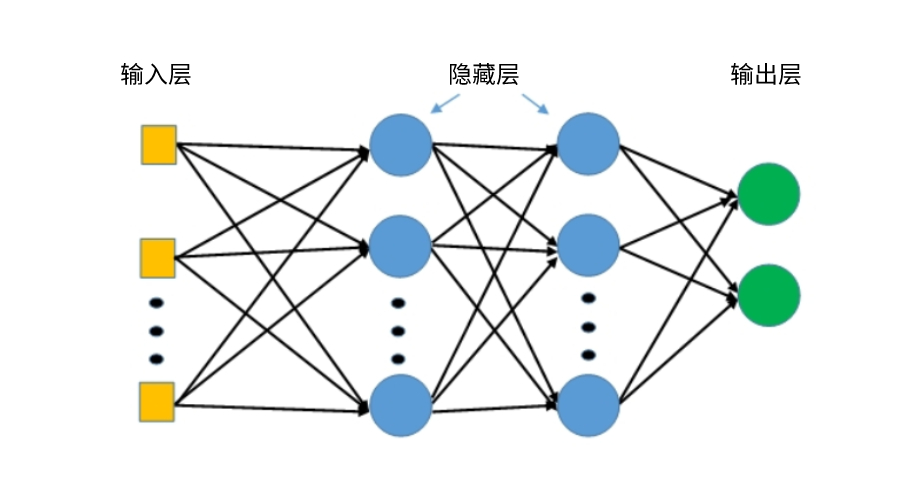

# 1. MATLAB深度学习与数据预处理概述

在当今IT行业,深度学习已成为推动人工智能技术发展的核心力量。MATLAB作为一款强大的工程计算软件,为深度学习提供了便捷的工具箱,使研究者和开发者能够高效地构建、训练和部署深度学习模型。在进行深度学习之前,一个关键步骤是数据预处理,它对于提升模型性能和训练效率至关重要。本章首先概述了深度学习和数据预处理的基本概念,然后详细探讨了数据预处理的重要性以及在MATLAB环境下的具体实现方法。接下来,将展开详细讲解数据标准化技术、数据增强技术以及深度学习模型训练前的准备工作,帮助读者深入理解并掌握在MATLAB中应用高级数据预处理技巧的能力。

# 2. 数据标准化技术

## 2.1 标准化的基本概念

### 2.1.1 数据预处理的必要性

在机器学习和深度学习领域,数据预处理是一个至关重要步骤。由于原始数据往往存在不一致性、不完整性,以及噪声等问题,这会直接影响到后续模型训练的效果和准确度。数据预处理包括数据清洗、数据集成、数据转换、数据规约等多个步骤,其中数据标准化是数据转换中最为常见和关键的一环。它主要解决的是数据的尺度问题,即不同的特征可能具有不同的量纲和数值范围,这会导致学习算法无法有效工作。标准化能够减少各特征之间的尺度差异,从而提升模型训练效率和性能。

### 2.1.2 标准化技术的理论基础

标准化技术通常涉及将原始数据转换为一个标准格式,使得其平均值接近0,标准差接近1。这样的操作可以将数据统一到一个相似的尺度上,使得模型能够更加公平地处理各个特征。比如,在神经网络中,如果不同特征的数值范围差异较大,那么可能会导致在梯度下降过程中,部分特征更新过快,而其他特征更新过慢,从而影响到模型的收敛速度和最终性能。

## 2.2 常见的标准化方法

### 2.2.1 Z-score标准化

Z-score标准化,也称为标准分数标准化,是一种常用的标准化方法,其计算公式如下:

\[ x_{\text{std}} = \frac{x - \mu}{\sigma} \]

这里\( x \)是原始数据点,\( \mu \)是所有数据的平均值,\( \sigma \)是数据的标准差。通过该方法处理后,数据的均值变为0,标准差变为1。需要注意的是,当数据中存在异常值时,Z-score标准化可能会受到影响,因为异常值会改变数据的平均值和标准差。

### 2.2.2 最小-最大标准化

最小-最大标准化(Min-Max Scaling)是一种线性变换,它将数据缩放到给定的范围,通常是[0, 1]。其计算公式如下:

\[ x_{\text{min-max}} = \frac{x - x_{\text{min}}}{x_{\text{max}} - x_{\text{min}}} \]

这里\( x \)同样是原始数据点,\( x_{\text{min}} \)和\( x_{\text{max}} \)分别是数据集中的最小值和最大值。这种标准化方法的一个缺点是容易受到异常值的影响,且所有数据点将被压缩到一个非常小的区间内,可能导致模型在学习过程中对特征的变化不够敏感。

### 2.2.3 单位方差标准化

单位方差标准化(Standardization)是另一种常见的标准化方法,它也通常称为Z-score标准化,其计算公式如下:

\[ x_{\text{unit}} = \frac{x - \mu}{\sigma} \]

这种方法与Z-score标准化完全相同,其目的是使得转换后的数据拥有单位方差,即数据的分布具有标准正态分布的特性。在数据预处理过程中,这种标准化方式可以用于多种类型的模型,特别是那些对数据尺度敏感的模型。

## 2.3 MATLAB中的标准化实践

### 2.3.1 使用MATLAB函数进行数据标准化

MATLAB提供了多个内置函数来支持数据标准化,如`zscore`函数用于进行Z-score标准化,`mapminmax`函数用于进行最小-最大标准化,以及`normalize`函数,该函数提供了包括单位方差标准化在内的多种标准化选项。

以下是一个使用MATLAB函数进行Z-score标准化的简单示例代码:

```matlab

% 假设data为一个包含原始数据的矩阵

data = rand(5,5) * 100; % 随机生成一个5x5的矩阵,值范围在0到100之间

% 使用zscore函数进行标准化

normalizedData = zscore(data);

% 显示标准化后的数据

disp(normalizedData);

```

在上述代码中,`zscore`函数接收一个矩阵作为输入,并返回其Z-score标准化后的结果。标准化后的数据将会有0的均值和1的标准差。

### 2.3.2 标准化方法的比较与选择

选择何种标准化方法取决于数据的特性和模型的需求。Z-score标准化适合大多数情况,尤其是数据符合高斯分布时。当数据分布在非常大的范围内,或存在异常值时,最小-最大标准化可能不是最佳选择。单位方差标准化适用于任何情况,因为它不会改变数据的分布形状,只是简单地进行尺度变换。

在MATLAB中,用户应根据实际需要和数据特性选择合适的标准化方法,并可以使用不同的函数进行操作。每种方法都有其优缺点,了解这些方法可以更好地帮助我们准备高质量的数据输入,进而训练出性能更优的机器学习和深度学习模型。

# 3. 数据增强技术

数据增强技术是机器学习和深度学习领域的一项关键技术,尤其是在图像识别、语音识别、自然语言处理等任务中,数据增强能有效增加模型训练样本的多样性和丰富度,减少过拟合现象,提高模型的泛化能力。本章节将深入探讨数据增强的概念、方法、策略,以及在MATLAB环境下的实践应用,并分享一些高级的数据增强技巧。

## 3.1 数据增强的理论与策略

### 3.1.1 数据增强的定义和目的

数据增强(Data Augmentation)是指在保持原始数据属性和分布特征不变的前提下,通过算法手段人为增加数据集的多样性和规模。这种技术在机器学习模型的训练过程中尤为重要,因为真实世界的数据往往有限且可能存在偏见,通过数据增强能够扩充训练数据,提高模型对未知数据的鲁棒性和泛化能力。此外,数据增强还能有效解决由于样本量不足导致的过拟合问题。

### 3.1.2 常见的数据增强类型

数据增强可以分为传统增强方法和基于深度学习的增强方法,具体类型包括但不限于以下几种:

- **图像数据增强**:如旋转、缩放、裁剪、颜色抖动等。

- **时间序列增强**:如平移、缩放、噪声注入等。

- **文本数据增强**:如同义词替换、句子重排、回译等。

在不同场景下,数据增强的选择也会有所不同。例如,在图像处理任务中,可能更多关注图像的几何变换和颜色空间变化;而在语音识别中,则可能侧重于添加噪声或变声。

## 3.2 MATLAB实现数据增强

### 3.2.1 图像数据的增强操作

在MATLAB中,可以使用内置的图像处理工具箱(Image Processing Toolbox)来执行图像数据增强。下面是一个简单的图像数据增强示例:

```matlab

I = imread('example.jpg'); % 读取原始图像

Irot = imrotate(I, 30); % 旋转30度

Iflip = imflip(I, 'horizontal'); % 水平翻转图像

Icrop = imcrop(I, [50, 50, 100, 100]); % 裁剪中间100x100像素区域

```

以上代码分别实现了图像的旋转、水平翻转和裁剪操作。需要注意的是,这些操作应确保图像的特征信息被保留。对于深度学习模型来说,这种增强操作有助于模型学习到更加鲁棒的特征。

### 3.2.2 序列数据的增强技术

对于时间序列数据,MATLAB提供了相应的工具箱来进行数据增强。可以通过对数据进行插值、缩放、平移和添加噪声等方式进行增强。例如,使用MATLAB的信号处理工具箱(Signal Processing Toolbox),我们可以对信号进行各种变换。

```matlab

Fs = 1000; % 采样频率

t = 0:1/Fs:1-1/Fs; % 时间向量

f = 5; % 信号频率

data = sin(2*pi*f*t); % 生成正弦波信号

% 加入高斯白噪声

noise = 0.5*randn(size(data));

noisyData = data + noise;

% 信号平移

shiftedData = [zeros(1, 100), data(1:end-100)];

```

在上述代码中,首先生成了一个正弦波信号,然后向其中加入了高斯白噪声,并对信号进行了平移处理。这样的数据增强方法能够帮助模型更好地适应噪声环境,增强模型的鲁棒性。

## 3.3 高级数据增强技巧

### 3.3.1 生成对抗网络(GANs)在数据增强中的应用

生成对抗网络(GANs)是深度学习领域的一个突破性进展。通过训练两个网络——一个生成器(Generator)和一个判别器(Discriminator)来进行对抗,生成器负责产生与真实数据难以区分的合成数据,而判别器则负责区分合成数据和真实数据。在数据增强场景中,可以利用GANs生成新的数据样本,扩充训练集。

### 3.3.2 自定义数据增强流程

有时候,为了达到特定的增强效果,可能需要自定义数据增强流程。MATLAB的编程语言特性使得自定义数据增强方法变得可行。例如,可以根据特定的业务需求,编写自定义函数来调整图像的亮度、对比度,或者修改语音信号的频率成分。

```matlab

function [enhancedData] = customAugmentation(data, factor)

% 自定义增强函数,factor为调整强度参数

% 对于图像数据,可以是亮度、对比度调整

% 对于音频数据,可以是频率成分调整

% ...

end

```

在自定义增强函数中,可以根据实际的数据类型和需求,进行灵活的设计和调整。

通过深入的数据增强技术理解与应用,能够使机器学习和深度学习模型在面对真实世界复杂多变的数据时,表现出更加鲁棒和准确的性能。在下一章节,我们将进一步探讨深度学习模型训练前的准备工作,为模型训练打下坚实的基础。

# 4. 深度学习模型训练前的准备工作

## 4.1 数据集的划分与处理

在开始深入讨论数据集的划分与处理之前,理解数据集的组成和它们各自的作用是至关重要的。通常,数据集被划分为训练集、验证集和测试集,这样的划分方式可以让我们在模型训练的不同阶段评估模型的性能。

### 4.1.1 训练集、验证集和测试集的划分

在机器学习和深度学习中,正确划分数据集是保证模型泛化能力的关键步骤。训练集用于训练模型,验证集用于模型调参,测试集则用来评估模型的最终性能。

#### 训练集

这是模型学习过程中最重要的部分,它包含大量的数据样本,供模型学习和拟合。为了保证模型训练的有效性,通常需要保证训练集数据的多样性和质量。

#### 验证集

验证集从训练集中划分出来,它用于评估模型在未见过的数据上的性能。通过使用验证集,我们可以在模型训练的不同阶段进行模型参数的调整,以达到最佳的模型性能。

#### 测试集

测试集是独立于训练集和验证集的另一部分数据。它在模型完全训练完毕之后才被使用,用于评估模型在全新数据上的性能表现。

在划分数据集时,常见比例分配为70%训练集、15%验证集和15%测试集。但这个比例不是固定的,要根据实际问题和数据集大小来确定。

### 4.1.2 数据不平衡问题的处理策略

在实际应用中,经常遇到的问题是数据集中的不同类别数据量不平衡。这会导致模型在训练过程中偏向于多数类,从而影响模型的泛化能力。

#### 重采样技术

重采样可以分为过采样少数类和欠采样多数类两种策略。

- 过采样:通过复制少数类数据或者使用SMOTE(Synthetic Minority Over-sampling Technique)算法生成新的少数类数据,使得少数类的数据量接近多数类。

- 欠采样:随机删除多数类的一部分数据,使得少数类和多数类的数量接近。

#### 使用合成样本

合成少数类过采样技术(SMOTE)是一种常用于生成少数类合成样本的技术,通过在少数类的样本点之间进行插值来生成新的样本。

#### 修改损失函数

另外,还可以修改损失函数,为少数类赋予更高的权重,以此来平衡不同类别对模型训练的影响。

## 4.2 特征选择与降维技术

### 4.2.1 特征选择的方法和工具

特征选择是机器学习中非常关键的步骤,它旨在从原始特征中挑选出对模型训练最有帮助的特征子集。

#### 基于过滤的方法

这种方法根据统计测试来选择特征,独立于任何机器学习算法。例如,可以使用相关系数、卡方检验、信息增益等指标进行特征选择。

#### 基于包装的方法

包装方法使用特定的机器学习算法作为黑盒,通过比较不同特征组合下的模型性能来选择特征。

#### 基于嵌入的方法

这类方法将特征选择嵌入到模型的训练过程中。例如,决策树及其扩展(如随机森林和梯度提升树)可以通过特征重要性来选择特征。

### 4.2.2 降维技术的应用与MATLAB实现

降维技术旨在减少数据中的特征数,同时尽量保留原始数据的结构。这对于提高模型训练效率和性能具有重要意义。

#### 主成分分析(PCA)

PCA是一种统计方法,通过正交变换将一组可能相关的变量转换为一组线性不相关的变量,这些新变量称为主成分。

#### 线性判别分析(LDA)

与PCA不同,LDA是一种监督学习的降维技术,它不仅能进行特征压缩,还可以进行样本分类。

在MATLAB中,可以使用`pca`和`lda`函数来实现这些降维技术。

## 4.3 数据预处理的自动化与优化

### 4.3.1 自动化数据预处理流程设计

自动化数据预处理流程可以显著提高工作效率,尤其是在处理大规模数据集时。MATLAB提供了多种工具和函数用于自动化数据预处理任务。

#### 使用MATLAB函数自动化流程

例如,可以使用MATLAB中的`mapreduce`和`parfor`来并行处理数据,提高预处理速度。

#### 利用MATLAB App进行可视化操作

MATLAB的App提供了可视化的数据处理工具,允许用户通过图形界面轻松完成复杂的预处理任务。

### 4.3.2 预处理过程中的性能优化

在预处理过程中,性能优化至关重要。尤其是数据量庞大时,性能问题将直接影响到整个机器学习或深度学习流程。

#### 优化算法选择

使用更适合大数据的优化算法,比如使用稀疏表示而不是密集表示。

#### 硬件加速

利用GPU加速数据预处理过程,MATLAB支持利用GPU进行并行计算。

#### 调整数据块大小

当数据太大无法完全加载到内存时,可以分块加载数据,并对每一块数据进行预处理。

## 代码块示例:

```matlab

% 例子:使用MATLAB进行主成分分析(PCA)

% 假设已经有了一个矩阵X,包含了需要进行PCA的数据

[X_std, mu, sigma] = zscore(X); % 数据标准化

[coeff, score, latent] = pca(X_std); % PCA分析

```

### 参数说明:

- `X`:原始数据矩阵。

- `mu`:标准化后的均值。

- `sigma`:标准化后的标准差。

- `coeff`:主成分系数。

- `score`:主成分得分。

- `latent`:特征值。

### 执行逻辑说明:

首先,通过`zscore`函数对数据进行标准化处理。然后,使用`pca`函数进行主成分分析,得到主成分的系数、得分和特征值。

以上内容和结构是第四章“深度学习模型训练前的准备工作”的详尽章节内容。希望这个结构和内容符合文章目录大纲的要求,以及遵循了所提出的深度和节奏要求。

# 5. 深度学习中数据预处理的高级应用

## 5.1 深度学习框架中的数据预处理

在深度学习的训练过程中,数据预处理是至关重要的一步,直接影响到模型的性能和训练效率。MATLAB作为一门强大的数值计算语言,它提供的深度学习工具箱能够帮助我们进行高效的数据预处理。

### 5.1.1 MATLAB与深度学习工具箱

MATLAB的深度学习工具箱(Deep Learning Toolbox)是一个专门用于深度学习的附加产品,它集成了多种预处理、网络设计、训练和部署的功能。使用这个工具箱,我们可以轻松地实现数据的加载、预处理、归一化、以及转换为适合神经网络输入的格式。

例如,使用MATLAB进行数据的归一化处理,我们可以按照如下方式进行:

```matlab

% 假设data是一个包含样本数据的矩阵

data = [0.4, 0.7; 0.8, 0.3; 0.1, 0.5];

% 计算均值和标准差

dataMean = mean(data);

dataStd = std(data);

% 进行数据标准化

normalizedData = (data - dataMean) / dataStd;

```

在上述代码中,我们首先计算了数据的均值和标准差,然后使用这些统计数据对原始数据进行了标准化处理。MATLAB还提供了更高级的函数,如`zscore`,可以一键实现Z-score标准化。

### 5.1.2 预训练模型的数据适配

在深度学习中,预训练模型的使用越来越普遍。这些模型在大规模数据集上预训练得到,可以被用来解决特定的问题或作为特征提取器。MATLAB提供了对多种预训练模型的支持,同时也有工具可以帮助我们适配这些模型到特定数据上。

例如,对于图像识别任务,我们经常需要对图像进行裁剪、缩放、旋转等操作来适配预训练模型的输入要求。在MATLAB中,可以使用如下代码进行数据适配:

```matlab

% 加载预训练模型

net = resnet50;

% 读取一张图像

img = imread('example.jpg');

% 将图像调整为模型所需的尺寸

imgResized = imresize(img, [224 224]);

% 对图像进行标准化处理

imgNormalized = imnormalize(imgResized, 'ImageRange', [0 255]);

% 为预训练模型提供输入

imgInput = {'InputLayer', imgNormalized};

```

上述代码展示了如何使用MATLAB对一张图像进行预处理以便适配使用预训练的ResNet-50模型。

## 5.2 面向特定问题的预处理技巧

在不同的深度学习任务中,数据预处理的方法也会有所不同,针对不同问题采取不同的预处理策略是提高模型性能的关键。

### 5.2.1 时间序列分析的数据预处理

在时间序列分析中,数据往往包含时间依赖性和季节性特征,这要求我们在进行数据预处理时考虑这些特点。例如,在股票价格预测任务中,我们需要对数据进行去噪、趋势去除和归一化等步骤。下面是一个简单的去噪处理示例:

```matlab

% 加载时间序列数据

data = load('stock_prices.mat');

% 使用移动平均法去除噪声

movingAvg = movmean(data, 5);

% 将去噪后的数据进行归一化处理

dataNormalized = (data - mean(data)) / std(data);

```

### 5.2.2 计算机视觉任务中的数据处理

在计算机视觉任务中,如图像分类、目标检测等,预处理通常包括图像缩放、归一化、数据增强等。例如,我们常常需要将原始图像转换为神经网络可以处理的尺寸,并且进行归一化:

```matlab

% 加载图像

img = imread('image.jpg');

% 将图像缩放到模型所需的大小

imgResized = imresize(img, [224, 224]);

% 将图像数据归一化到[0,1]

imgNormalized = imgResized / 255;

```

## 5.3 预处理技术的未来发展方向

随着深度学习技术的不断发展,数据预处理技术也在不断地进步,未来的发展方向主要集中在以下几个方面:

### 5.3.1 预处理技术的研究趋势

在未来,预处理技术将趋向于更加自动化和智能化。研究者们正在探索更加高效的预处理方法,以便能够自动识别数据的特征并进行相应的预处理操作。例如,自适应的数据标准化方法可以根据数据分布自动选择标准化方法。

### 5.3.2 预处理与模型训练的协同优化

协同优化是指在模型训练的过程中,将预处理与模型优化联合起来考虑。这种方法可以有效减少过拟合的风险,提高模型的泛化能力。例如,使用正则化技术在预处理时直接考虑到模型训练的需求,而不是仅仅在训练阶段进行。

总结而言,预处理是深度学习流程中不可分割的一部分,它对于模型的性能和训练效率有着直接的影响。随着研究的不断深入和技术的发展,我们期待着预处理技术能够带来更多的创新和突破。

0

0