【MATLAB深度学习模型压缩与加速】:减少模型大小与提升推理速度

发布时间: 2024-08-30 13:10:48 阅读量: 77 订阅数: 35

# 1. 深度学习模型压缩与加速概述

随着人工智能技术的快速发展,深度学习模型在图像识别、自然语言处理等领域取得了显著成果。然而,高复杂度的模型往往伴随着庞大的计算开销,导致推理速度慢、资源消耗大。这就需要模型压缩与加速技术来优化这些性能瓶颈,以适应移动设备、边缘计算等资源受限的应用场景。模型压缩旨在减少模型大小而不显著影响模型性能,而模型加速则侧重于提升模型运行效率。本章将概览深度学习模型压缩与加速的概念、目标和挑战,并为后续章节的详细探讨打下基础。

# 2. 理论基础和压缩技术

## 2.1 深度学习模型压缩的理论基础

### 2.1.1 模型冗余性的理解

在深度学习领域中,模型冗余性通常指的是模型在训练过程中或者训练完成后,存在一些对最终任务贡献不大的参数或者结构。这些冗余部分,包括但不限于:冗余的权重、冗余的特征通道、冗余的神经元,以及冗余的层结构。

从信息论的角度看,冗余信息有助于提高系统的鲁棒性,然而在深度学习模型中,冗余部分过多会带来以下问题:

- **计算资源的浪费**:模型中无用的参数依然占用内存和计算资源。

- **过拟合风险的增加**:复杂的模型结构更容易在训练数据上过拟合,而无法推广到新的数据集上。

- **推理速度的降低**:模型的大小直接关系到推理时的内存占用和计算时间。

理解模型冗余性的关键在于,能够在不显著降低模型性能的前提下,找到并去除这些冗余部分,以达到模型压缩和加速的目的。

### 2.1.2 压缩与加速的理论限制

虽然模型压缩与加速的目标是为了减少模型的复杂度,但压缩过程是存在理论限制的。例如:

- **精度与复杂度的权衡**:通常模型压缩会导致精度下降,因此需要找到精度和压缩率之间的最优平衡点。

- **模型架构的影响**:不同的网络结构对压缩的敏感程度不同,这影响了压缩技术的适用性。

- **硬件资源的约束**:硬件的计算能力、内存大小和带宽等都会限制压缩技术的实施。

理论上,当模型的复杂度逼近任务所需信息的最小表示时,压缩的边际效应会迅速下降,此时进一步的压缩会显著影响模型性能。因此,有效的压缩技术应当在保证模型性能的前提下进行,尽量接近理论上的最优压缩率。

## 2.2 模型压缩技术

### 2.2.1 权重剪枝技术

权重剪枝技术是最早期的深度学习模型压缩方法之一。该方法的中心思想是识别并剔除那些对于模型输出影响较小的权重。具体实施过程中,可以采用不同的权重剪枝标准,如权重的绝对值大小,或者权重对模型输出影响的敏感度。

剪枝可以分为结构化剪枝和非结构化剪枝两种类型:

- **结构化剪枝**:裁剪权重时,保持模型结构的规则性,例如,每次剪枝都剔除掉整个卷积核或神经元,这样可以简化计算过程,更容易利用硬件加速器。

- **非结构化剪枝**:随机地剪枝权重,对模型结构没有特殊要求,但非结构化剪枝通常不利于硬件加速。

### 2.2.2 量化技术

量化技术通过减少模型参数和激活值的表示精度来实现模型压缩。深度学习模型的权重和激活值通常以浮点数表示,例如32位的float类型,通过量化,可以将其减少到8位或更少位数的整数表示。

量化可以分为训练后量化和训练时量化:

- **训练后量化**:首先使用完整的精度训练模型,然后对训练好的模型权重和激活值进行量化。

- **训练时量化**:在模型训练过程中就使用低精度的数值,加速模型训练,并且在一定程度上避免了训练后量化带来的精度损失。

量化技术在硬件层面上能够显著提升运算效率,因为低精度数据类型在硬件上往往有更高效的处理方式。

### 2.2.3 知识蒸馏技术

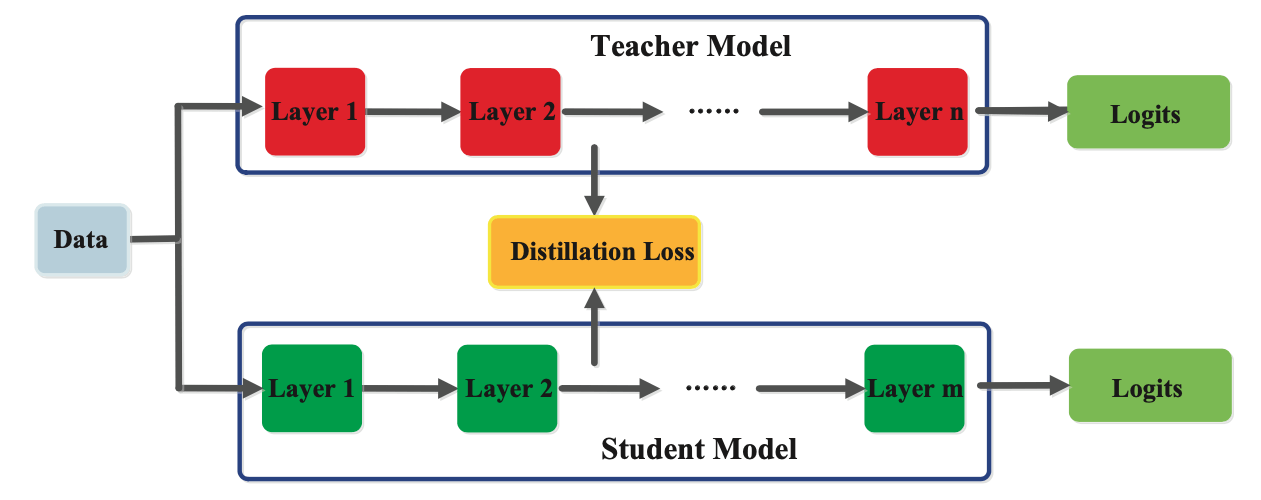

知识蒸馏是一种转移知识的技术,它源自于模型之间的知识迁移。在这种方法中,一个大的、复杂的模型(教师模型)被用来训练一个小的、简单的模型(学生模型),目的是让学生模型学习到教师模型的输出分布。

知识蒸馏的关键在于损失函数的设计,它通常由两部分组成:

1. **硬损失**:衡量学生模型和教师模型输出之间的差异。

2. **软损失**:通过教师模型的输出概率分布来指导学生模型,增强学生模型的预测能力。

知识蒸馏可以使学生模型在较小的模型大小和更快的运行速度下,仍能保持较高的准确率。

## 2.3 模型加速技术

### 2.3.1 稀疏矩阵和稀疏计算

稀疏矩阵是指大部分元素为零的矩阵,稀疏计算就是利用了稀疏矩阵的这种特性,对矩阵中的零值进行高效的计算处理。在深度学习模型中,尤其是在卷积神经网络中,大量的权重是零或者接近零,这为稀疏计算提供了良好的应用场景。

稀疏矩阵的存储和计算可以大幅度减少计算资源的消耗,提升模型的推理速度,尤其是对于稀疏度高的大型模型,效果尤为明显。

### 2.3.2 硬件加速原理与技术

硬件加速是指使用特定设计的硬件来提高计算速度的过程,常见的硬件加速器包括GPU、TPU、FPGA和ASIC等。

硬件加速原理基于两点:

1. **并行计算**:硬件加速器通常能并行执行大量计算任务,相比CPU更加高效。

2. **专有架构**:特定的硬件设计能够更有效地处理深度学习中的特定操作,如卷积操作、矩阵乘法等。

利用硬件加速技术,可以大幅度提升深度学习模型的运行速度和能效比,尤其在处理大规模数据时,性能提升更为显著。

### 2.3.3 软件优化方法

软件优化通常指的是在不改变硬件平台的基础上,通过算法优化、代码优化等方式,提高程序运行效率。在深度学习领域,软件优化可以从以下方面着手:

- **算法优化**:选择更高效的算法来减少模型复杂度,比如使用轻量级网络架构。

- **代码优化**:优化程序代码,减少不必要的计算,利用更高效的库函数和数据结构。

- **异构计算**:使用CPU、GPU等多种计算资源共同参与模型计算,实现负载均衡和性能最大化。

通过这些软件层面的优化,可以在不依赖特定硬件的情况下,实现深度学习模型的加速。

## 2.2.1 权重剪枝技术的代码实践

权重剪枝技术在MATLAB中的实践可以通过以下步骤进行:

```matlab

% 假设有一个训练好的模型net

% 确定剪枝比例,例如,我们希望剪枝掉50%的参数

prunePercentage = 50;

% 获取模型的层信息

layers = net.Layers;

% 对每一层进行剪枝操作

for i = 1:length(layers)

if layers(i).ClassName == '***n.layer.Convolution2DLayer' || ...

layers(i).ClassName == '***n.layer.FullyConnectedLayer'

% 计算当前层的权重数量

numWeights = numel(layers(i).Weights);

% 确定需要剪枝的权重数量

numPrune = floor(numWeights * prunePercentage / 100);

% 找到权重绝对值最小的numPrune个权重

[~, sortIndex] = sort(abs(layers(i).Weights(:)), 'descend');

pruneIndex = sortIndex(1:numPrune);

% 设置这些权重为零

layers(i).Weights(pruneIndex) = 0;

end

end

% 重新组装模型

newNet = LayerGraph(layers);

```

在上述代码中,我们首先确定了剪枝比例并获取了模型的所有层。然后对每一层进行了权重剪枝操作,这里特别关注了卷积层和全连接层。通过计算权重的绝对值,找到了需要剪枝的权重,并将它们设置为零。最后,重新组装模型以应用剪枝效果。

需要注意的是,权重剪枝操作可能会引起模型性能的下降,因此在实际操作中需要对模型进行微调以恢复性能。此外,为了保证剪枝操作能够顺利进行,需要确保模型保存了权重参数,并且在剪枝后需要对模型进行重新训练或微调。

```mermaid

flowchart LR

A[开始] --> B[获取模型net]

B --> C[确定剪枝比例]

C --> D[获取模型层信息]

D --> E[对每一层进行剪枝操作]

E --> F[组装新模型newNet]

F --> G[结束]

```

在剪枝过程中,我们使用了一个流程图来描述权重剪枝的整体流程,从开始到结束,包括了确定剪枝比例、获取层信息、对每一层进行剪枝、重新组装模型等关键步骤。该流程图有助于我们更好地理解剪枝操作的逻辑顺序。

权重剪枝在提升模型推理速度的同时,需要权衡精度损失,因此在实际应用中,剪枝比例的设定、剪枝策略的选择以及后续的模型训练或微调都需要谨慎进行。MATLAB作为一个集成度很高的开发环境,提供了丰富的工具和接口来支

0

0