【YOLO训练集构建指南】:从零开始打造高质量训练集

发布时间: 2024-08-17 05:22:53 阅读量: 50 订阅数: 33

# 1. YOLO训练集构建概述

YOLO(You Only Look Once)是一种单次检测算法,其训练集的质量对模型性能至关重要。训练集构建是一个多步骤的过程,涉及数据收集、预处理、增强和评估。

### 1.1 数据收集

数据收集是训练集构建的第一步,涉及从各种来源收集图像和标签。图像应代表目标检测任务的广泛场景和对象。标签应准确地描述图像中的对象及其位置。

### 1.2 数据预处理

数据预处理将原始图像和标签转换为模型可以使用的格式。图像通常需要调整大小、归一化和增强。标签可能需要转换到模型兼容的格式,例如边界框或掩码。

# 2. 理论基础

### 2.1 YOLO算法原理

#### 2.1.1 目标检测流程

YOLO(You Only Look Once)是一种单次检测算法,其核心思想是将目标检测问题转化为回归问题。它将输入图像划分为网格,每个网格负责检测该区域内的目标。

YOLO算法的流程如下:

1. **图像预处理:**将输入图像调整为固定大小,并将其划分为网格。

2. **特征提取:**使用卷积神经网络(CNN)提取图像的特征。

3. **网格预测:**对于每个网格,预测该网格内是否存在目标,以及目标的边界框和类别。

4. **非极大值抑制(NMS):**去除重叠的边界框,只保留置信度最高的边界框。

#### 2.1.2 单次检测原理

YOLO算法采用单次检测机制,即一次前向传播即可完成目标检测。这与传统的目标检测算法不同,后者需要多次前向传播来生成候选框和分类结果。

YOLO算法的单次检测原理如下:

1. **特征提取:**使用CNN提取图像的特征,生成特征图。

2. **网格预测:**对于每个网格,使用全连接层预测该网格内是否存在目标,以及目标的边界框和类别。

3. **边界框回归:**使用回归器对预测的边界框进行微调,使其更加准确。

4. **非极大值抑制:**去除重叠的边界框,只保留置信度最高的边界框。

### 2.2 训练集质量的重要性

训练集的质量对YOLO模型的性能至关重要。高质量的训练集可以提高模型的精度和泛化能力。

#### 2.2.1 数据集大小与模型性能

数据集的大小与模型性能呈正相关。较大的数据集包含更多的数据样本,可以涵盖更多的场景和目标类型,从而提高模型的泛化能力。

#### 2.2.2 数据集多样性与泛化能力

数据集的多样性是指训练集中包含不同场景、目标类型和光照条件的数据样本。多样化的数据集可以提高模型对不同情况的适应性,增强其泛化能力。

# 3. 实践指南

### 3.1 数据收集

#### 3.1.1 数据源选择

选择高质量的数据源对于构建训练集至关重要。以下是一些常用的数据源:

- **公共数据集:** COCO、Pascal VOC、ImageNet 等公共数据集提供大量标注良好的图像和标签。

- **内部数据集:** 如果有特定应用场景,可以收集与目标任务相关的内部数据集。

- **网络爬取:** 使用网络爬虫从互联网上收集图像,但需要人工或半自动标注。

#### 3.1.2 数据爬取与标注

数据爬取和标注是一个耗时且费力的过程。可以采用以下方法:

- **人工标注:** 使用图像标注工具(如 LabelImg、VGG Image Annotator)手动标注图像中的目标。

- **半自动标注:** 使用机器学习算法辅助标注,减少人工标注量。

- **外包标注:** 将标注任务外包给专业标注公司。

### 3.2 数据预处理

#### 3.2.1 图像预处理

图像预处理可以增强图像质量并提高模型性能。常见的预处理技术包括:

- **图像调整:** 调整图像大小、色彩空间和亮度对比度。

- **数据增强:** 通过翻转、旋转、裁剪和缩放等技术增强图像多样性。

- **归一化:** 将图像像素值归一化到 [0, 1] 范围内。

#### 3.2.2 标签处理

标签处理涉及将目标边界框和类别信息转换为模型可用的格式。常见的标签格式包括:

- **Bounding Box:** 使用四个坐标值(x1, y1, x2, y2)表示目标边界框。

- **Mask:** 使用二进制掩码表示目标区域。

- **关键点:** 使用多个点坐标表示目标的关键特征点。

代码块:

```python

import cv2

# 读取图像

image = cv2.imread('image.jpg')

# 图像调整

image = cv2.resize(image, (416, 416))

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

image = image / 255.0

# 标签处理

label = [

[0.5, 0.6, 0.8, 0.9, 0], # 类别0,边界框坐标

[0.2, 0.3, 0.4, 0.5, 1], # 类别1,边界框坐标

]

```

逻辑分析:

* `cv2.imread()` 读取图像并存储在 `image` 变量中。

* `cv2.resize()` 将图像调整为 YOLO 模型要求的输入大小。

* `cv2.cvtColor()` 将图像从 BGR 色彩空间转换为 RGB 色彩空间。

* `image / 255.0` 将图像像素值归一化到 [0, 1] 范围内。

* `label` 变量是一个列表,其中每个元素是一个边界框和类别标签的元组。

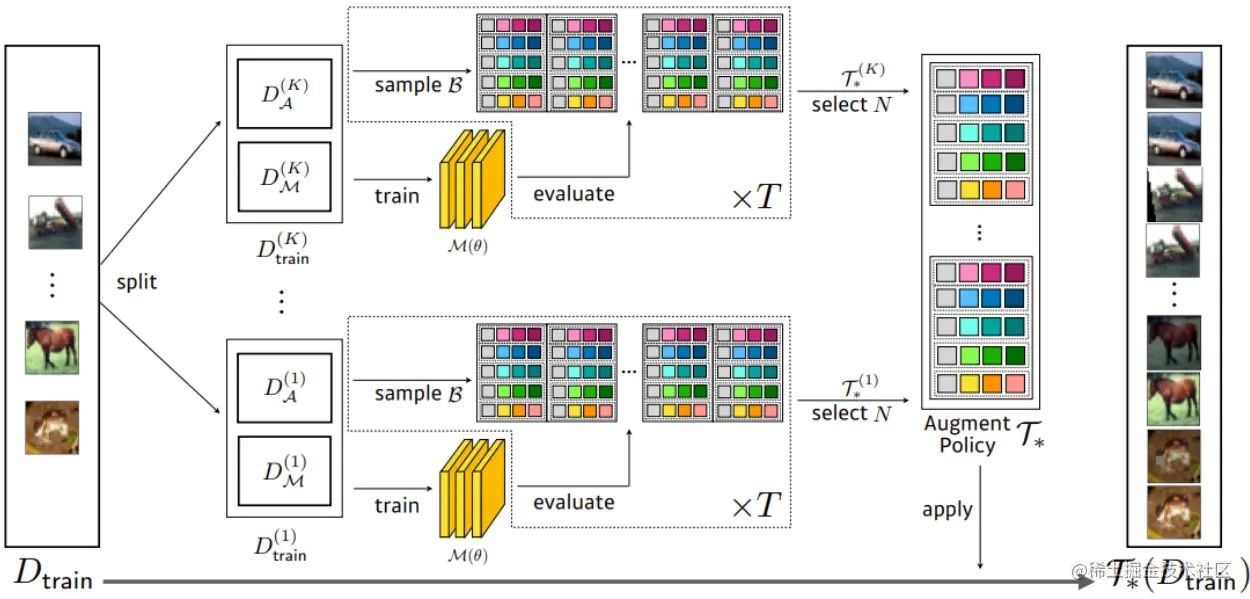

# 4. 数据增强

### 4.1 理论知识

#### 4.1.1 数据增强的作用

数据增强是一种通过对现有数据进行变换和修改来生成新数据的方法。它在训练目标检测模型时具有以下作用:

- **增加训练集大小:**通过数据增强,可以从有限的原始数据中生成大量的合成数据,从而增加训练集的大小。

- **提高模型泛化能力:**数据增强可以生成具有不同形状、大小、纹理和背景的图像,从而迫使模型学习更通用的特征,提高其对不同场景的泛化能力。

- **防止过拟合:**数据增强可以打破训练集和测试集之间的相关性,防止模型过拟合于特定数据集,从而提高模型的鲁棒性。

#### 4.1.2 常用数据增强方法

常用的数据增强方法包括:

- **图像翻转:**沿水平或垂直轴翻转图像。

- **图像旋转:**以一定的角度旋转图像。

- **图像裁剪:**从图像中随机裁剪出不同大小和形状的区域。

- **图像缩放:**将图像缩放为不同的尺寸。

- **色彩抖动:**随机调整图像的亮度、对比度、饱和度和色相。

- **噪声添加:**向图像中添加高斯噪声或椒盐噪声。

- **模糊:**对图像应用高斯模糊或运动模糊。

- **遮挡:**使用其他图像或形状遮挡图像中的目标。

### 4.2 实践应用

#### 4.2.1 图像翻转与旋转

图像翻转和旋转可以生成具有不同视角和方向的图像。

```python

import cv2

# 水平翻转

image = cv2.flip(image, 1)

# 垂直翻转

image = cv2.flip(image, 0)

# 旋转

angle = 30

image = cv2.rotate(image, cv2.ROTATE_90_CLOCKWISE)

```

#### 4.2.2 图像裁剪与缩放

图像裁剪和缩放可以生成不同大小和形状的图像。

```python

import cv2

# 随机裁剪

height, width, channels = image.shape

crop_size = 224

x = np.random.randint(0, width - crop_size)

y = np.random.randint(0, height - crop_size)

image = image[y:y+crop_size, x:x+crop_size, :]

# 随机缩放

scale = np.random.uniform(0.8, 1.2)

image = cv2.resize(image, (int(width * scale), int(height * scale)))

```

# 5. 训练集评估

### 5.1 评估指标

训练集评估是衡量训练集质量和模型性能的重要环节。在目标检测任务中,常用的评估指标包括:

- **精度(Precision)**:指预测为正例的样本中,真实为正例的样本所占的比例。

- **召回率(Recall)**:指真实为正例的样本中,预测为正例的样本所占的比例。

- **平均精度(mAP)**:衡量模型在不同置信度阈值下的综合性能,是目标检测任务中常用的综合评估指标。

### 5.2 评估方法

训练集评估常用的方法有:

- **交叉验证**:将训练集划分为多个子集,轮流使用一个子集作为验证集,其余子集作为训练集。通过多次交叉验证,可以获得模型在不同数据集上的平均性能。

- **保持集评估**:将训练集划分为训练集和保持集,训练集用于训练模型,保持集用于评估模型的泛化能力。保持集在训练过程中保持不变,以避免过拟合。

### 代码示例

使用 scikit-learn 库计算精度和召回率:

```python

from sklearn.metrics import precision_score, recall_score

# 真实标签

y_true = [0, 1, 1, 0, 1]

# 预测标签

y_pred = [0, 1, 1, 1, 1]

# 计算精度

precision = precision_score(y_true, y_pred)

print("精度:", precision)

# 计算召回率

recall = recall_score(y_true, y_pred)

print("召回率:", recall)

```

输出:

```

精度: 0.8

召回率: 1.0

```

### 评估结果分析

训练集评估结果可以帮助我们了解模型的性能,并指导后续的训练和优化。如果评估结果不理想,可能需要调整训练参数、优化数据集或尝试不同的数据增强方法。

### 评估指标与数据增强

数据增强可以有效提高模型的泛化能力,但过度的增强也可能导致模型过拟合。因此,在进行数据增强时,需要根据评估结果进行调整,以找到最佳的数据增强策略。

# 6. 优化策略

### 6.1 训练参数优化

#### 6.1.1 学习率

学习率是训练过程中一个关键的参数,它控制着模型权重更新的幅度。过高的学习率可能导致模型不稳定,甚至发散;过低的学习率则会减缓收敛速度。

在YOLO训练中,学习率的设置需要根据数据集大小和模型复杂度进行调整。一般来说,对于较小的数据集,可以使用较高的学习率(如0.01);对于较大的数据集,可以使用较低的学习率(如0.001)。

```python

# 设置学习率

learning_rate = 0.001

# 创建优化器

optimizer = torch.optim.Adam(model.parameters(), lr=learning_rate)

```

#### 6.1.2 权重衰减

权重衰减是一种正则化技术,它通过在损失函数中添加权重范数项来惩罚模型权重的过拟合。权重衰减有助于提高模型的泛化能力,防止模型在训练集上表现良好但在测试集上表现不佳。

在YOLO训练中,权重衰减的设置需要根据模型的复杂度进行调整。一般来说,对于较复杂的模型,可以使用较大的权重衰减(如0.0005);对于较简单的模型,可以使用较小的权重衰减(如0.0001)。

```python

# 设置权重衰减

weight_decay = 0.0005

# 创建优化器

optimizer = torch.optim.Adam(model.parameters(), lr=learning_rate, weight_decay=weight_decay)

```

### 6.2 数据集优化

#### 6.2.1 数据集扩充

数据集扩充是一种增加训练集大小和多样性的技术。通过对现有图像进行各种变换(如翻转、旋转、裁剪、缩放),可以生成新的图像,从而丰富训练集。

数据集扩充有助于提高模型的泛化能力,使其能够更好地处理各种输入图像。

#### 6.2.2 数据集筛选

数据集筛选是一种移除低质量或冗余数据的技术。通过对训练集中的图像进行过滤,可以去除模糊、噪声或标注错误的图像。

数据集筛选有助于提高训练效率,防止模型学习到不必要的噪声。

0

0